Tecnología Visual

|

sábado, abril 20, 2013

|

El año pasado escribí un editorial titulado "Hora de hacer la Realidad Virtual, real...", y por lo que veo, alguien escuchó... El año pasado escribí un editorial titulado "Hora de hacer la Realidad Virtual, real...", y por lo que veo, alguien escuchó...El video que les presento a continuación es el resultado de combinar las gafas de Realidad Virtual del Oculus Rift, con un nuevo accesorio llamado el Omni de la empresa Virtuix (una empresa que se especializa en el mercado de la Realidad Virtual), y como podrán ver, el resultado es fenomenal. En esencia, el Omni es una caminadora estacionaria pero que permite que camines en cualquier dirección, los 360 grados a tu alrededor, mientras te mantiene en el mismo lugar (el video hará evidente lo que estoy diciendo), y que al combinar con el Oculus Rift nos ofrece una de las mejores experiencias de Realidad Virtual que un consumidor promedio podría obtener hoy día. Noten que este concepto ha existido por años en laboratorios y parques de atracciones especializados (yo los he probado casi todos, pues incluso en mi universidad teníamos un departamento de Realidad Virtual), pero esta es la primera vez que (1) el hardware es lo suficientemente potente, (2) el hardware es lo suficiente barato, y (3) tenemos software que toma ventaja de ese hardware. Noten que así como se financió el Oculus Rift en Kickstarter, que así mismo planea la empresa Virtuix financiar el Omni próximamente (posiblemente en Mayo 2013). Solo imaginen ahora combinando el poder de la próxima generación del PlayStation o Xbox con esto y ya entenderán por qué muchos de nosotros tendremos que ir al baño a hacer la número uno después de ver este video... página oficial de Virtuix página oficial del Oculus Rift Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

jueves, abril 18, 2013

|

|

NOTA: Este es un artículo invitado en eliax.com

Han leído bien, lo siguiente es un vídeo de una burbuja (pompa de jabón) reventando en un vídeo hecho a 18,000 fps (diez y ocho mil cuadros por segundo). Han leído bien, lo siguiente es un vídeo de una burbuja (pompa de jabón) reventando en un vídeo hecho a 18,000 fps (diez y ocho mil cuadros por segundo). El resultado, como verán en el vídeo, es una secuencia casi hipnótica, se ve como si fuera hecha de otro material bastante diferente o sacada de algún software simulador tridimensional con una renderización basante realista. Los realizadores han sido un grupo de personas que se autodenominan "the slow mo guys" (que más o menos se puede traducir: los chicos del movimiento lento) y utilizaron una cámara Phantom v1610 que puede hacer también imágenes a 1,000,000 por segundo (no es un error tipográfico, leyeron un millón), aunque como ya han de imaginar, cuesta tanto como todo lo que se puede lograr con ella. A partir de ahora ya no podré ver las burbujas que tanto le gustan a mi hijo de manera igual, pensaré en este vídeo e intentaré ver el movimiento que veo aquí, aunque mis ojos no se comparan ni de cerca a la configuración usada. Video a continuación (enlace YouTube)... autor: emmanuel bretón |

|

|

|

|

|

miércoles, abril 17, 2013

|

|

NOTA: Este es un artículo invitado en eliax.com

Varias universidades de California y de Canadá, se han unido para ejecutar una idea: Van a construir en Hawaii el telescopio óptico más grande del mundo, luego de recibir la aprobación por los organismos estatales correspondiente, con inversión de aproximadamente mil millones de dólares. Varias universidades de California y de Canadá, se han unido para ejecutar una idea: Van a construir en Hawaii el telescopio óptico más grande del mundo, luego de recibir la aprobación por los organismos estatales correspondiente, con inversión de aproximadamente mil millones de dólares. El equipo del proyecto llamado “Thirty Meter Telescope” (en español “El Telescopio de 30 metros”), será construido en Mauna Kea, un volcán que es el punto más alto de Hawaii, con aproximadamente 4,025 metros de altura. El nombre de “30 Metros” proviene de que el espejo primario reflector del telescopio medirá 30 metros de largo, y abarcará un área visualización 9 veces más grande que la del Gran Telescopio de las Canarias, que es actualmente el telescopio más grande del mundo. Además, las imágenes serán 3 veces más nítidas/claras. Y a pesar de que el volcán Mauna Kea acoge más de 11 telescopios actualmente, la aprobación del 30 Metros ha sido un proceso largo y de muchos estudios y consensos, ya que según las tradiciones de los nativos de Hawaii, las tierras altas son sagradas y deben ser respetadas. Por estos motivos, Hawaii dio luz verde, pero impusieron un sinnúmero de condiciones entre las cuales se destacan el hecho de que todo el personal que laborará tanto en la construcción del telescopio como en los procesos de investigación, deberán recibir entrenamientos intensivos sobre la protección del medio ambiente, la biodiversidad de Hawaii y la cultura de los nativos. Leer el resto de este artículo... autor: idrialis castillo |

|

|

|

|

|

martes, abril 16, 2013

|

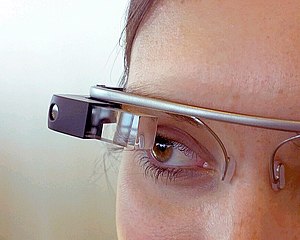

Google acaba de revelar las especificaciones técnicas de sus gafas inteligentes a las que llama Google Glass, y sin duda que serán de interés para los que seguimos a estas gafas de cerca desde su primera aparición... Google acaba de revelar las especificaciones técnicas de sus gafas inteligentes a las que llama Google Glass, y sin duda que serán de interés para los que seguimos a estas gafas de cerca desde su primera aparición...Según Google, estas son las especificaciones: - Proyector de video ocular que da la impresión de uno ver una pantalla de 25" a una distancia de 2.44 metros (8 pies). - Gafas totalmente ajustables en tamaño, que sirven a caras/cabezas de cualquier tamaño. - Cámara capaza de captar fotos de 5 Megapixeles, y video en resolución 720p (1280 x 720 pixeles). - Sonido con tecnología que transmite el sonido directamente por vibraciones de hueso de tu cráneo hasta el oído (Bone Conduction Transducer). Esto es similar a algunos audífonos hoy día en el mercado. - WiFi - 802.11b/g y Bluetooth. - 16GB de almacenamiento, de los cuales 12GB están disponibles al usuario y son sincronizados a la nube de Google. - La batería supuestamente dura "un día entero con uso típico", pero especifican que el grabar videos y hacer video-conferencias reduce el tiempo típico de uso. - En cuanto a funcionalidades de GPS (posicionamiento geográfico) y SMS (mini-mensajes), se necesita conectar el Glass a un celular Android versión 4.0.3 o superior. Noten que por el momento Google no planea hacer a Glass disponible al público en general, sino que solamente a desarrolladores de aplicaciones a un precio de US$1,500 dólares por unidad (obviamente, de Google sacar esto al mercado, el precio sería considerablemente menor, estimo que alrededor de US$500). En cuanto a mi opinión al Glass, es una idea que sabemos tarde o temprano despegará, pero aun estamos buscando lo que en inglés llaman un "Killer App" (una aplicación que verdaderamente demuestre la utilidad del Glass, y la cual no se podría utilizar de otra manera efectivamente sin las gafas), razón por la cual Google ha hecho disponible estas gafas a desarrolladores externos con la esperanza de que estos desarrollen tal aplicación. Sin embargo, la idea es que con estas gafas en un futuro podamos prescindir de los celulares inteligentes de hoy día, y hacer todo y más de lo que hacen estos celulares, pudiendo nosotros ver información "flotando" sobre nuestro campo visual, y elegir opciones con solo hacer gestos (o quizás, con solo pensar en hacer cosas, en un futuro no lejano). Aunque una cosa que me gustaría modificar del Glass es que tuviera doble pantallas, para así poder crear un efecto estereoscópico (3D) y ofrecer información en un formato más interesante (como por ejemplo, señalizaciones sobre personas y objetos en el mundo real con Realidad Aumentada). Y a propósito, si quieren ver hacia donde vamos con esto, no dejen de leer este artículo, este otro, y este otro acá mismo en eliax... fuente oficial de las especificaciones autor: josé elías |

|

|

|

|

|

miércoles, abril 10, 2013

|

|

NOTA: Este es un artículo invitado en eliax.com

Paul Friedlander es un físico y escultor artístico, que logró combinar profesión y pasión para crear un hermoso y colorido arte con ayuda de la física. Paul Friedlander es un físico y escultor artístico, que logró combinar profesión y pasión para crear un hermoso y colorido arte con ayuda de la física. Se trata de patrones de colores, que se esculpen con el movimiento a través de vibraciones de cuerdas delgadas iluminadas. La ilusión se logra mediante el movimiento de esas cuerdas a alta velocidad con alta frecuencia de la luz proyectada, obteniendo como resultado hermosas esculturas y magnos espectáculos. ¡Gracias a J. Morrison que compartió las fotos en Google+! enlace a la Galería de imágenes (y videos) de Friendlander autor: idrialis castillo |

|

|

|

|

|

lunes, abril 8, 2013

|

|

NOTA: Este es un artículo invitado en eliax.com

El siguiente vídeo nos muestra a varios animales de tipo mamíferos y su reacción cuando les cae agua y deciden sacudirse, algo que hemos visto en muchos animales, pero creo que no así en cámara lenta...

Los autores del programa de la BBC Earth Unplugged han tomado un erizo (erinacino), un ratón, un perro y un ser humano, los han empapado de agua y han filmado sus sacudidas mientras se sacuden el agua de sus cuerpos. Es curioso ver cómo un erizo logra hacer más de 20 sacudidas por segundo mientras un perro sólo logra entre 4 y 6 sacudidas por segundo. Igualmente los seres humanos calculan que hacemos más o menos 4 sacudidas, en lo que los ratones logran 15.2 sacudidas de promedio. No dejen de ver el vídeo, no es lo mismo decirlo en números que viendo el movimiento en cámara lenta, es impresionante ver cómo las gotas salen y cómo en perfecta coordinación los músculos actúan ante cada sacudida. Esto me pone a pensar que en definitiva, el ser humano ha perdido la capacidad de liberarse de la cantidad extra de agua, aunque me imagino que por eso inventamos las toallas... :) Video a continuación (enlace YouTube)... autor: emmanuel bretón |

|

|

|

|

|

|

|

NOTA: Este es un artículo invitado en eliax.com

El endoscopio es un instrumento médico flexible o rígido y muy delgado, en forma de tubo con una pequeña luz y una diminuta cámara para poder visualizar el interior del cuerpo humano y sus órganos durante cirugías y/o procedimientos médicos. Es el más utilizado en cirugías de todo tipo, incluyendo las más delicadas como las del corazón y el cerebro. El endoscopio es un instrumento médico flexible o rígido y muy delgado, en forma de tubo con una pequeña luz y una diminuta cámara para poder visualizar el interior del cuerpo humano y sus órganos durante cirugías y/o procedimientos médicos. Es el más utilizado en cirugías de todo tipo, incluyendo las más delicadas como las del corazón y el cerebro. Por ser elementos médicos imprescindibles, ingenieros de la Universidad de Stanford han desarrollado un endoscopio de muy alta resolución e igual de delgado que una hebra de cabello humano común. Este nuevo dispositivo tiene 4 veces mayor alcance que dispositivos similares. Así que imaginen lo revolucionario que será este aparato al momento de hacer exámenes médicos menos invasivos, pero con mayor visión y precisión. Leer el resto de este artículo... autor: idrialis castillo |

|

|

|

|

|

|

|

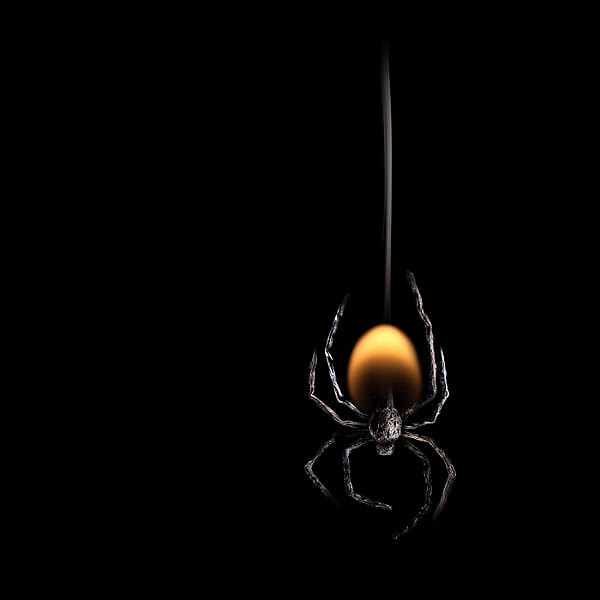

NOTA: Este es un artículo invitado en eliax.com

Esto me ha maravillado, quién diría que con cerillas (fósforos) se podría lograr algo como lo que muestran estas imágenes... Esto me ha maravillado, quién diría que con cerillas (fósforos) se podría lograr algo como lo que muestran estas imágenes... El artista se llama Stanislav Aristov, y ha creado estas imágenes sólo con fuego y cerillas quemadas, y la verdad es impresionante el resultado, pues toma las cerillas como estructura principal y luego completa con fuego o humo el resto de la forma; así tiene mariposas, gatos, perros, arañas, cisnes, como también tiene una guitarra, manzanas, barco, y hasta la misma Torre Eiffel. Ciertamente una caja de cerillas, mucho tiempo, mucha imaginación, y un verdadero talento, es una combinación perfecta para lograr algo impresionante. enlace 1 enlace 2 autor: emmanuel bretón |

|

|

|

|

|

domingo, abril 7, 2013

|

En este par de días pasados una noticia ha estado rondando el Internet, y ha sido malinterpretada y exagerada por muchos medios que obviamente no tienen idea de lo que están escribiendo. Hoy les explico lo que realmente está sucediendo. En este par de días pasados una noticia ha estado rondando el Internet, y ha sido malinterpretada y exagerada por muchos medios que obviamente no tienen idea de lo que están escribiendo. Hoy les explico lo que realmente está sucediendo.Pero antes de continuar noten que aunque esta noticia ha explotado en estos últimos tres días, que esta noticia en sí en realidad es de Octubre del año pasado, como reportado acá mismo en eliax en ese entonces (y con datos incluso más actualizados). Se trata de un adelanto en donde científicos japoneses han logrado predecir ciertos elementos de los sueños con un factor de éxito de un 60%. Sin embargo, la noticia está siendo reportada en muchos medios como que ya es posible "predecir lo que te vas a soñar con un 60% de probabilidad de acertar" o que ya es posible "saber lo que te estás soñando". Esto es falso, y honestamente me gustaría que los que escriben noticias científicas en portales bastante populares tanto en español como en inglés al menos leyeran o buscaran a un experto antes de difundir este tipo de noticias. Lo que sucede es mucho más simple, aunque en mi opinión bastante interesante de todas formas: Lo que estos científicos han logrado hacer es asociar nombres de oraciones (como "mesa", "silla", "persona", "cielo", "mariposa", "cigarro", "celular", etc), y para ese limitado vocabulario han logrado hacer un mapa de correlaciones de esos nombres a actividad cerebral mientras las personas sueñan. La idea entonces es monitorear a las personas mientras sueñan, con el objetivo de ver cuáles de los patrones correspondientes a esos nombres surgen como actividad cerebral en las personas durmiendo. Tan sencillo como eso. Así que por ejemplo, si sueñas con un celular y un cielo y una silla, eso generará patrones que podrán ser detectados por los científicos mientras duermes dentro de una máquina con tecnología de fRMI (resonancia magnética funcional), y lo pueden detectar con hasta un 60% de aciertos. Pero ojo, esto es solo para patrones que existan en el muy limitado vocabulario de estos experimentos. Sin embargo, aun así es un tremendo adelanto. Por otro lado, por más tremendo adelanto que esto sea, les recuerdo que ya existe una técnica aun mucho más poderosa y avanzada que esta, y de la cual les hablé hace un par de años, que permite que los científicos literalmente graben un video de lo que estás soñando. autor: josé elías |

|

|

|

|

|

sábado, abril 6, 2013

|

¿Saben cuál es la primera señal de que un video fue grabado por un amateur en vez de un profesional? La estabilización. Y estabilización es una de las cosas más difíciles de lograr en video, y para lo cual existen literalmente decenas de soluciones (ver esto, esto o esto por ejemplo). Sin embargo, a la fecha ninguna como esta llamada MōVI de la empresa FreeFly. ¿Saben cuál es la primera señal de que un video fue grabado por un amateur en vez de un profesional? La estabilización. Y estabilización es una de las cosas más difíciles de lograr en video, y para lo cual existen literalmente decenas de soluciones (ver esto, esto o esto por ejemplo). Sin embargo, a la fecha ninguna como esta llamada MōVI de la empresa FreeFly.Noten que entre las maneras más populares de estabilizar video se encuentran los jib (en esencia, gruas de distintos tamaños con contrapeso) y los sliders y dollys (en esencia, cámaras montadas sobre rieles ultra-suaves), pero otra categoría es el estilo handheld ("a mano") en donde el operador de la cámara camina y carga literalmente la cámara en sus manos, y es en esta última categoría de estabilizadores a lo que apunta el MōVI... A la fecha, el líder indiscutible de ese mercado había sido SteadyCam, un sistema muy copiado pero venerado en Hollywood y en donde sea que se filmen videos y películas, pero este sistema tiene algunos inconvenientes: Es por lo general pesado (ya que funciona contra-balanceando la cámara con pesas), difícil de controlar (se necesita entrenamiento para poder operarlo efectivamente), y caro. Por caro hablamos que si quieres utilizar los sistemas originales de la empresa, que esta en realidad los renta, y los renta junto con un operador especializado (sí, el sistema SteadyCam original viene con una persona como parte del paquete). Así que ahora, de la nada, surge MōVI. La empresa FreeFly que desarrolló este milagro de la cinematografía en realidad ya tenía una vasta experiencia en el desarrollo de cámaras estabilizadas, siendo reconocida particularmente en cámaras aéreas (para tomas desde helicópteros principalmente), y la empresa decidió tomar todo lo aprendido en el aire, y traerlo a tierra, en un dispositivo que pesa alrededor de 1.58 Kg (3.5 Lbs) y soporta cámaras de 4.5 Kg (10 Lbs) más accesorios... ¿Pero, cómo funciona el MōVI? Pues no funciona con pesados contrapesos, sino que con tecnología digital moderna que incluye un conjunto de sensores, giroscopios, una computadora especializada, y un conjunto de servo-motores silenciosos, y lo que el MōVI hace es descifrar los datos de todos esos sensores a un ritmo de miles de veces por segundo para hacer que los actuadores/motores contrarresten el movimiento natural de la cámara. Es decir, este sistema en esencia nota que si la cámara se está desestabilizando hacia la izquierda, que entonces debe decirle a los motores que manejan ese eje que ejerzan una fuerza en la dirección opuesta, en esencia contrarrestando el movimiento original, y hace esto en todos los ejes posibles. Y como si fuera poco, el sistema puede controlarse remotamente por una segunda persona y una palanca de mando (un joystick), para así lograr movimientos y tomas bastante complejas. Como verán en el video a continuación, los resultados son verdaderamente increíbles, y en mi opinión este dispositivo no solo se venderá como pan caliente, sino que incluso representará un hito en toda la industria cinematográfica. Inicialmente el MōVI M10 se venderá por US$15,000 dólares, pero la empresa ya está diseñando un modelo más módico, el M5 (y que asumo será diseñado para cámaras DSLR más ligeras) que costará unos US$7,500. También veremos un M20 en un futuro para equipos más pesados. Sin embargo, algo me dice que no tardaremos en ver copias de este sistema a precios menores, y dentro de 3 a 5 años quizás podamos encontrar sistemas similares en el rango de precio de los US$2,000 dólares. y no dejen de ver este increíble video (que lamentablemente, no está en YouTube, solo en Vimeo por el momento) página oficial del MōVI M10 fuente (en Vincent Laforet, con más videos) Otro video a continuación (enlace YouTube)... Actualización de Septiembre 2013: El MoVI ya tiene competencia. La empresa Perspective Aerials está ofreciendo un modelo que ofrece supuestamente los mismos resultados que el MoVI, pero a una tercera parte del precio (US$4,500 vs US$15,000). Más detalles en este enlace. Actualización Septiembre 2014: Los precios bajaron a casi la mitad, y ahora son los siguientes para los distintos modelos: MōVI M5: US$4,000 MōVI M10: US$8,000 MōVI M15: US$12,000 autor: josé elías |

|

|

|

|

|

jueves, abril 4, 2013

|

|

NOTA: Este es un artículo invitado en eliax.com

Google ha dado un paso más en su servicio de recorridos virtuales Google Maps, ahora llevándonos a lugares como el Monte Everest, o el Monte Kilimanjaro en Tanzania. Imagínense visitar ahora mismo el Aconcagua (América del sur), Monte Elbrus (Europa) y la base de campo del ya mencionado Everest (Asia) todos al 'alcance de tu mano'. Google ha dado un paso más en su servicio de recorridos virtuales Google Maps, ahora llevándonos a lugares como el Monte Everest, o el Monte Kilimanjaro en Tanzania. Imagínense visitar ahora mismo el Aconcagua (América del sur), Monte Elbrus (Europa) y la base de campo del ya mencionado Everest (Asia) todos al 'alcance de tu mano'. La gran G ha llevado a parte del equipo de Google maps a lugares donde no todos lograremos llegar en nuestras vidas, dándonos una oportunidad de recorrer virtualmente el sendero de llegar a esos sitios, desde donde sea que estemos usando la mundialmente famosa herramienta de sus mapas. Esto sin pagar los miles que cuesta ir a un viaje de esos, las horas de entrenamiento, y el valor cosechado para uno poder realizar esa hazaña. Esto, claro, nos sirve de motivación para ir personalmente a esos lugares, y quedar impresionados por uno mismo de las maravillas de este mundo; es una gran ventaja para aquellos que siempre hemos querido ver lugares así. Ya había conocido la casa de una de mis mejores amigas en México, gracias al Street View, o me había entrado a ver ciertas ciudades por simple curiosidad, pero este es un 'viaje' imperdible donde puedo notar el esfuerzo que significa subir hasta esos lugares y animarme a preparar un viaje así, cámara en mano y mente fresca para adquirir recuerdos nuevos, de esos, inolvidables. enlace autor: emmanuel bretón |

|

|

|

|

|

miércoles, abril 3, 2013

|

|

NOTA: Este es un artículo invitado en eliax.com

Hace un tiempo se podía ver en muchos sitios la foto que acompaña este artículo, el autor es Scott Dickson, ya muchos conocíamos su impresionante trabajo y siempre nos quedábamos curiosos de saber cómo lo hacía. Hace un tiempo se podía ver en muchos sitios la foto que acompaña este artículo, el autor es Scott Dickson, ya muchos conocíamos su impresionante trabajo y siempre nos quedábamos curiosos de saber cómo lo hacía. En el enlace más abajo podrán ver cómo Dickson logra estas impresionantes imágenes, con detalles y fotos del set donde realizaba su trabajo, en el cual no necesitó realmente de un equipo sofisticado, más bien de las herramientas adecuadas y una gran inversión en imaginación. Yo como fotógrafo siempre he querido hacer fotos así, cosa que es más fácil con un buen equipo, pero no imposible con uno 'hecho en casa' como lo llegó a hacer Dickson. Este es la configuración y equipo que usó en cada foto:

fuente enlace a la galería de fotos en Flickr autor: emmanuel bretón |

|

|

|

|

|

domingo, marzo 31, 2013

|

|

Y ahora tenemos un video "filtrado" (más otro del PlayStation 4) de lo que será posible hacer en tiempo real con la próxima versión, el Unreal Engine 4, de lo cual les dejo un video acá abajo, y lo que nos da una pista de lo que será posible en la próxima generación cercana de videojuegos (tanto en consolas actuales, como en las de próxima generación y PCs). Así mismo, les dejo otro video de lo que ha logrado la gente de Epic Games (los desarrolladores del Unreal Engine) al asociarse con los ingenieros de Firefox, para portar la versión actual 3 del Unreal Engine al motor altamente optimizado de Javascript de las versiones beta de Firefox (que serán parte de la versión 20 final próximamente). Este port del Unreal Engine 3 a Firefox fue posible gracias a la herramienta emscripten, que es en esencia un compilador de bajo nivel que transforma código LLVM de los lenguajes de programación C o C++ directamente código super-optimizado de Javascript, y en este caso combinando el resultado con WebGL. Noten que aunque esto por el momento está optimizado para Firefox, que no hay razón para que veamos esta tecnología próximamente en otros navegadores como Chrome, Safari e Internet Explorer. Esto les dará una pista del tipo de juegos que podremos jugar directamente desde cualquier página web en un futuro no lejano... página oficial del Unreal Engine 4 página oficial de emscripten información sobre LLVM Video 1 a continuación del Unreal Engine 4 en PC (enlace YouTube)... Video 2 a continuación del Unreal Engine 4 en el PS4 (enlace YouTube)... Video 3 a continuación del Unreal Engine 3 en Firefox (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, marzo 29, 2013

|

En estos días pasados se inauguró en Chile el telescopio de su tipo más grande jamás creado por el ser humano, y bautizado como el ALMA (Atacama Large Millimeter Array), y estuve pensando que no pudieron haber elegido un nombre más apto para este instrumento, pues realmente su propósito desde un punto de vista poético es darnos a entender un poco más del alma de nuestro universo (en paralelo al LHC)... En estos días pasados se inauguró en Chile el telescopio de su tipo más grande jamás creado por el ser humano, y bautizado como el ALMA (Atacama Large Millimeter Array), y estuve pensando que no pudieron haber elegido un nombre más apto para este instrumento, pues realmente su propósito desde un punto de vista poético es darnos a entender un poco más del alma de nuestro universo (en paralelo al LHC)...El ALMA se encuentra localizado a 5000 metros de altura en el desierto de Atacama, conocido como quizás el lugar más perfecto sobre la Tierra para colocar un telescopio. Este radiotelescopio fue creado gracias a la contribución y fondos de la Unión Europea (que aportó el 40% del capital), EEUU y Canadá (entre ambos, un 40% más), y Japón (el restante 20%), y en realidad entró en operación en el 2011 en un período de pruebas, pero fue apenas en días pasados que fue inaugurado oficialmente. Algo curioso sobre este aparato es que no es una entidad monolítica, sino que en realidade es un conjunto de 57 reflectores (66 para finales de año) que en conjunto forman el equivalente a un "reflector virtual". Al final ALMA será compuesto de 54 antenas de 12 metros cada una, y 12 antenas de 7 metros cada una. En esencia, todos los reflectores trabajan en conjunto, y gracias a una técnica llamada interferometría es posible combinar los datos de cada uno de los relativamente pequeños reflectores en una señal compuesta mucho más grande, dotando a este radiotelescopio de un poder hasta ahora inimaginable. Otra cosa curiosa sobre el ALMA es que las antenas son movibles (están situadas sobre plataformas rodantes) por lo que es posible "abrir" y "cerrar" la apertura del radiotelescopio con solo mover las antenas de lugar, las cuales se situarán (dependiendo de la observación que se esté haciendo) a distancias que van de entre 150 metros una de la otra, a unos increíbles 16km de distancia. Con este telescopio, que puede ver ondas indetectables al ojo humano, podremos obtener una vista detallada sin precedentes al origen del las estrellas, así como medir la distribución de las moléculas que existen en torno a estrellas por toda la galaxia (y el resto de nuestro universo)., muchas de las cuales sabemos son esenciales para la vida. Y todo esto nos lleva de regreso al propósito de construir estos grandes dispositivos en primer lugar: Queremos saber de dónde provenimos. Y cuando me refiero a "de donde provenimos" eso se puede interpretar como "de donde provino el universo" o "de donde provenimos nosotros", pero en realidad son la misma pregunta pues como les expliqué en un artículo anterior el universo y nosotros somos la misma cosa. Por lo que al activar esta máquina y mejorar nuestro entendimiento del universo, en realidad nos estamos entendiendo más a nosotros mismos, y mientras más conozcamos de nosotros mismos más podremos entender nuestro rol en el gran orden de las cosas, y lo importante que es pensar que todos nosotros, átomo por átomo y desde una piedra hasta cualquier ser humano, somos literalmente hermanos, y que todos en realidad somos uno. ALMA en Wikipedia en español ALMA en Wikipedia en inglés una galería de 6 imágenes captadas por el ALMA un artículo muy interesante sobre ALMA en space.com autor: josé elías |

|

|

|

|

|

martes, marzo 26, 2013

|

Hoy los dejo con el asombroso resultado de una colaboración entre el Cambridge Research Lab de Toshiba y la University of Cambridge, en donde han perfeccionado un software de cara sintética que imita al ser humano de una forma verdaderamente asombrosa... Hoy los dejo con el asombroso resultado de una colaboración entre el Cambridge Research Lab de Toshiba y la University of Cambridge, en donde han perfeccionado un software de cara sintética que imita al ser humano de una forma verdaderamente asombrosa...A este software que verán en el video (en donde también escucharán a los diseñadores explicar lo que verán) lo han llamado Zoe, y lo crearon de una forma bastante especial: En vez de crear "a mano" animaciones faciles, estos científicos en esencia le mostraron a un software de inteligencia artificial miles de videos y voces de la actriz británica Zoe Lister, para que el software aprendiera los más mínimos detalles asociados con músculos faciales en combinación con sonidos fonéticos. El resultado como verán es impresionante. Noten que tanto la renderización como la voz digital que verán es hecho en tiempo real, y no es descabellado imaginarnos un futuro cercano en donde todos tengamos un asistente artificial similar a este video. Esta es una pieza más del rompecabezas para un futuro similar a este. fuente original Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, febrero 27, 2013

|

|

El siguiente video es uno que ya lleva unos días en Internet, pero lo cierto es que no quise dejar de compartirlo para aquellos que aun no lo hayan visto.

Se trata de un video promocional por parte de Google mostrando los usos que se le pueden dar a sus gafas inteligentes que ha bautizado como Google Glass. Noten que esto es solo una pequeña parte del potencial de estas gafas, en donde se explora la parte de gestionar, documentar y compartir nuestras vidas de forma audio-visual (lo que en mi opinión sería genial para una futura generación de redes sociales). Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

"Jose, este artículo me ha sacado las lágrimas y me ha puesto los pelos de punta... sin duda uno de loa más grandes visionarioa de toda la historia. Este mundo no sería igual si el no hubiera existido..."

en camino a la singularidad...

©2005-2024 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax