|

lunes, abril 22, 2013

|

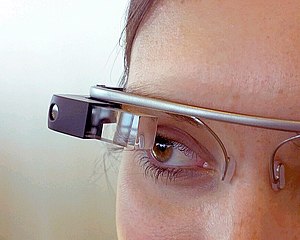

Como muchos lectores de eliax saben, soy uno de los que espera con ansias la Era de las Gafas Inteligentes (hoy día ejemplificado por el Google Glass), o Lentes de Contactos Biónicos (lo que vendrá después, como el IrixPhone), y he expresado en varios artículos (como esta Reflexión, o esta otra, o esta otra, o esta otra) el tremendo potencial que tiene esta tecnología. Sin embargo, tampoco me ciego al hecho de que existen serias barreras para que esta tecnología se masifique, y de eso quiero hablar hoy... Como muchos lectores de eliax saben, soy uno de los que espera con ansias la Era de las Gafas Inteligentes (hoy día ejemplificado por el Google Glass), o Lentes de Contactos Biónicos (lo que vendrá después, como el IrixPhone), y he expresado en varios artículos (como esta Reflexión, o esta otra, o esta otra, o esta otra) el tremendo potencial que tiene esta tecnología. Sin embargo, tampoco me ciego al hecho de que existen serias barreras para que esta tecnología se masifique, y de eso quiero hablar hoy...En mi opinión, la barrera más grande que tienen las gafas inteligentes es el interfaz de usuario para manipular la información que estas presentan. Otras barreras como el costo, tamaño, duración de la batería, resolución de la pantalla, visualización estereoscópica, y recepción de sonido, se resolverán al corto plazo, pero el tema del interfaz será el verdadero dolor de cabeza. Hoy día, la gran mayoría de analistas asumen que todo esto se resolverá con el tema de reconocimiento de voz, pero veo un serio problema con eso... Lo primero es, que incluso un sistema que reconozca el 96% de nuestros comandos de voz es un problema grande de percepción, ya que nuestra forma natural de comunicarnos es con la voz y sonidos, y hemos evolucionado a través de millones de años para ser altamente perceptivos del arte de hablar, y de que nos escuchen. Sistemas como el excelente Dragon Naturally Speaking o el Siri de Apple, son un buen ejemplo de esto: Ciertamente entienden la vasta mayoría de palabras que les dictas, pero esas pocas palabras que no entienden son las que nos hacen querer decir todo tipo de malas palabras, ya que nuestras mentes tienen poca paciencia para el lenguaje hablado y que no nos entiendan. Pero más allá de eso, incluso cuando se creen sistemas que nos entenderán en el 99.99% de los casos, queda otra barrera aun mayor: Privacidad. Sencillamente nadie quiere estar en la calle, en medio de un autobús, o incluso en nuestros propios hogares, diciendo en voz alta comandos que puedan dar pistas a los que están a nuestros alrededores sobre nuestras acciones. En unos casos por motivos de confidencialidad empresarial, en otros por motivos de seguridad familiar, y en otros porque sencillamente no queremos que personas en nuestro alrededor sepan que estamos viendo los Simpsons en nuestras gafas en horario laboral, o que estamos viendo material "para adultos", o que estamos comprando algo que no queremos que nadie sepa, o que estamos jugando un juego, etc. Es sencillamente algo psicológico y cultural, que no tiene nada que ver con tecnología. Eso por tanto nos deja con dos alternativas: Gestos, o interfaces neuronales. El tema de gestos es algo que se está explorando bastante hoy día, y conlleva que hagamos gestos con nuestros dedos, manos, o incluso ojos, que sirvan como control de lo que estamos viendo. Así que por ejemplo si en nuestras gafas inteligentes estamos viendo un menú de opciones de algo, quizás con tan solo apuntar con el ojo a la opción que queremos y juntar dos dedos, podemos seleccionar lo que deseamos. Esto podría funcionar como una parada intermedia al futuro, aunque hay que admitir que en cierto sentido resultaría algo incómodo, pues dependeríamos de estar haciendo gestos físicos constantemente para hacer incluso las cosas más básicas. Aunque por otro lado, gestos es lo que vivimos haciendo cuando escribimos en teclados, manipulamos un ratón, o tocamos las pantallas táctiles de nuestros celulares y tabletas, por lo que quizás esta será la primera forma de comunicarnos con estas gafas inteligentes... Sin embargo, en donde veo mayor futuro es en interfaces neuronales no-invasivos. Me refiero a interfaces que se coloquen alrededor de nuestra cabeza (o posiblemente los sostenedores de las gafas al lado de nuestras cabezas harían esa función) y que detecten desde la superficie del cráneo los patrones eléctricos generados por nuestros cerebros al pensar. Esto es algo que por años se ha investigado (e incluso la semana pasada les hablé de un adelanto al respecto por parte de Samsung), y aunque es el camino más difícil, es en mi opinión el más prometedor de todos los interfaces. Y la razón es bastante simple: Naturalidad. Con un interfaz de este tipo, sería literalmente un trabajo de "pensar" en hacer las cosas para que estas ocurran. Cosas como "ver video", "visitar a eliax.com", "buscar que es un IrixPhone" o "reservar un restaurante para dos personas para mañana cerca de mi casa con comida vegetariana" son cosas que vienen mucho más natural a un usuario, que el tener que memorizar gestos, y peor aun, expresarlos en público. Y lo mejor de todo, es que esto no es ciencia ficción. Como reportado en incontables artículos previos en eliax, ya existe mucha investigación y prototipos de tecnologías que pueden leer palabras literalmente de nuestro pensamiento, o incluso de nuestros patrones musculares en la garganta al pensar en palabras, así como ya existe mucha tecnología para leer los patrones neuronales sin necesidad de insertar electrodos en el cerebro, por lo que poco a poco todas las piezas están encajando en su lugar, y tarde o temprano estas gafas inteligentes serán parte de nuestra cotidianidad... autor: josé elías |

|

|

|

|

|

Comentarios

Añadir Comentario |

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax

Soy el Primero!!