Hardware

|

lunes, noviembre 24, 2008

|

|

Esta noticia es un avance para que sepan que hoy en algún momento en eliax anunciaremos un alucinante concurso navideño patrocinado por la empresa HP en donde regalaremos unos US$6,000 dólares en premios a algunos afortunados lectores de eliax.

Los premios incluirán PCs de escritorio con tecnología multi-toque, laptops, netbooks, películas y otros premios. Así que estén atentos el resto del día para mas información!!! autor: josé elías |

|

|

|

|

|

viernes, noviembre 21, 2008

|

La gente que nos trajo el Internet (DARPA, la Agencia de Proyectos de Investigaciones Avanzadas de Defensa de los EEUU), junto a IBM y 5 otras universidades, acaban de anunciar un proyecto en donde DARPA contribuirá con un monto inicial de US$4.9 Millones de dólares para patrocinar la investigación de la construcción de la primera super-computadora del mundo que imite a un cerebro biológico, en este caso el cerebro equivalente a un gato. La gente que nos trajo el Internet (DARPA, la Agencia de Proyectos de Investigaciones Avanzadas de Defensa de los EEUU), junto a IBM y 5 otras universidades, acaban de anunciar un proyecto en donde DARPA contribuirá con un monto inicial de US$4.9 Millones de dólares para patrocinar la investigación de la construcción de la primera super-computadora del mundo que imite a un cerebro biológico, en este caso el cerebro equivalente a un gato.El campo de investigación a donde irán estos primeros fondos se llama "Computación Cognitiva", y como dicen en el artículo, traerá bajo una misma sombrilla a neurobiólogos, científicos de materiales, científicos en computación y psicólogos. Por ahora la idea es utilizar el sistema que se construya en el proceso de análisis de datos a gran escala, toma de decisiones y reconocimiento de imágenes. Según Dharmendra Modha, el científico de IBM que lidera este proyecto, "La mente tiene una habilidad sorprendente de integrar información ambigua distribuida por los sentidos, y puede con poco esfuerzo crear categorías de tiempo, espacio, objetos e interrelaciones de datos sensoriales." La idea entonces es utilizar computación cognitiva para crear máquinas con inteligencias similares a la de la mente, logrando esto haciendo ingeniería inversa en la estructura, dinámica, funcionamiento y comportamiento del cerebro. Por ahora, una de las tareas mas difíciles será lograr la ingeniería necesaria para integrar los resultados de este proyecto en algo tangible, pero como dicen, ya hemos llegado a una etapa en donde la tecnología puede acercarse al nivel de miniaturización a gran escala necesaria como para acercarse a la escala de las neuronas, que tienen una densidad de 10,000 millones por centímetro cuadrado, esto gracias a los avances recientes en Nanotecnología. Noten que IBM ya ha podido simular previamente al menos el potencial crudo de computación de parte del cerebro de un ratón, al emular 55 millones de neuronas conectadas a medio millón de millones de sinapsis. Algo interesante es que como dice uno de los colaboradores del proyecto, esta es la primera vez que ha gran escala se intentará crear un sistema que no tenga un final u objetivo específico, sino que será algo totalmente genérico que se podrá adaptar a cualquier situación a la mano. Nota interesante: Es una gran coincidencia que en mi charla en el ITLA de hace apenas 3 días titulada "Hacia la Humanidad 2.0 y mas allá..." este fue justo uno de los temas que expuse, en donde expliqué que actualmente hay 3 principales maneras de lograr una Inteligencia Artificial (IA). La primera es IA a Fuerza Bruta. Esto implica tratar de lograr algoritmos que puedan pensar o imitar la inteligencia. Esto es extremadamente difícil de lograr (aunque bastante efectivo en video-juegos si se aplica a un fin en específico, como manejar un auto o ser el enemigo en un juego de combate). La segunda es IA Emergente, en donde uno empieza al igual que la evolución con algo extremadamente sencillo y después por medio de procesos evolutivos uno hace que la mente artificial vaya cobrando inteligencia y consciencia poco a poco. Esto es lo mas sencillo pero al final es el mas complejo de entender. Y la última manera es lo que llamé "IA Trasplantada", que es lo que este proyecto piensa hacer, lo que es copiar la estructura del cerebro (sin entender completamente cómo esta funciona) con el objetivo de que la versión artificial posea el mismo nivel cognitivo que el cerebro biológico emulado. Fuente de la noticia autor: josé elías |

|

|

|

|

|

domingo, noviembre 16, 2008

|

Hace mas de un año Intel propuso la especificación técnica para el sucesor del extremadamente exitoso estándar de USB 2.0, el USB 3.0, y por fin mañana Lunes será anunciado oficialmente por el USB Implementers ForumUSB Implementers Forum. Hace mas de un año Intel propuso la especificación técnica para el sucesor del extremadamente exitoso estándar de USB 2.0, el USB 3.0, y por fin mañana Lunes será anunciado oficialmente por el USB Implementers ForumUSB Implementers Forum.Esta versión ofrecerá una velocidad cruda de transferencia de datos de 4.8 Gigabits por segundo (Gbps), lo que es 10 veces mas rápido que el actual USB 2.0 de 480 Mbps, y 400 veces mas rápido que USB 1.0 de 12Mbps. Esta nueva versión será conocida tanto como "USB 3.0" así como "SuperSpeed USB" ("USB de SuperVelocidad"). Aparte del gran aumento en velocidad, el nuevo estándar además defina una manera mucho mas eficiente de manejar la energía eléctrica de los dispositivos conectados, permitiendo no solo la conexión de dispositivos externos a laptops de una manera mas eficiente, sino que además permitir recargar estos dispositivos externos de una manera mejor. Esto se debe a que la nueva especificación no vive constantemente preguntándole a los dispositivos conectados si necesitan hacer algo (cosa que consume energía, y que es un problema con laptops), sino que utiliza una arquitectura de "interruptores" en donde el dispositivo externo es quien le avisaría a tu laptop que tiene trabajo por hacer. Así mismo, USB 3.0 soporta ahora hasta 900 miliamperios, en vez de los 100 de USb 2.0, lo que significa que tendrás la opción no solo de conectar dispositivos que requieran de mayor poder energético (sin recurrir a una fuente externa de energía), sino que además puedes conectar mas de tales dispositivos a la vez, y recargarlos mucho mas rápidamente. Los conectores que serán anunciados para el USB 3.0 serán compatibles con el USB 2.0, pero obviamente si conectas un dispositivo de USB 3.0 en una máquina con 2.0 (o viceversa), solo podrás transferir información a la velocidad antigua del USB 2.0. Y hablando de conectores, no podemos dejar de mencionar el estándar FireWire (también conocido como IEEE1394, o i.Link por Sony), el cual ahora con la salida del USB 3.0 se ve cada vez mas en aprietos, y eso aun ante la superioridad técnica de FireWire, quien aun con su nuevo estándar que saldrá a 3.2GBps será posiblemente mas eficiente que USB3.0 a 4.8Gbps (somo lo es hoy a 400Mbps versus USB 2.0 a 480Mbps). Sin embargo, FireWire es otro ejemplo mas de cómo una superioridad técnica no garantiza superioridad en el mercado, debido a muchos otros factores como precios, licencias, adopción, etc. Finalmente noten que equipos y dispositivos con USB 3.0 no aparecerán en el mercado posiblemente hasta finales del 2009 como mínimo. Página oficial del USB Implementers ForumUSB Implementers Forum autor: josé elías |

|

|

|

|

|

miércoles, noviembre 12, 2008

|

Cray, la clásica empresa sinónimo de supercomputadora acaba de recuperar su reinado al crear la supercomputadora mas potente del mundo, la Cray XT Jaguar, una bestia que procesa información al ritmo de hasta 1.64 PetaFLOPS, gracias a sus 45,000 procesadores AMD Opteron de 4 núcleos cada uno, 362TB de memoria, y 10 PetaBytes (10 PB, o 10,240 TeraBytes) de almacenamiento en disco. Cray, la clásica empresa sinónimo de supercomputadora acaba de recuperar su reinado al crear la supercomputadora mas potente del mundo, la Cray XT Jaguar, una bestia que procesa información al ritmo de hasta 1.64 PetaFLOPS, gracias a sus 45,000 procesadores AMD Opteron de 4 núcleos cada uno, 362TB de memoria, y 10 PetaBytes (10 PB, o 10,240 TeraBytes) de almacenamiento en disco.Noten que 1.64 PetaFLOPS significa 1,640,000,000,000,000 de operaciones flotantes por segundo. Noten además que aunque 1.64 PetaFLOPS es el rendimiento pico, que la XT Jaguar puede ejecutar cálculos de manera sostenida a 1.3 PetaFLOPS. Esto hace a la XT Jaguar hata un poco mas de 50% mas rápido que la anterior sostenedora del récord, la IBM Roadrunner con 1,026 PetaFLOPS. La Cray XT Jaguar fue diseñada para el Departamento de Energía de los EEUU. Similar a la analogía que hice la vez que la Roadrunner se develó al mundo, y para que tengan una idea del poder de esta máquina, si tomáramos a todos y cada uno de los mas de 6,000 millones de humanos en el planeta a calcular con una calculadora de bolsillo, las 24 horas al día, todos los días del año, les tomaría a todas estas personas 69 años hacer lo que la Cray XT Jaguar hace en un solo día. Algo interesante para los que les guste la historia de la informática es que esta empresa (Cray) durante mucho tiempo (en particular los 1980s) fue el líder indiscutible en el mundo de las supercomputadoras. Fuente de la noticia Página oficial de Cray Actualización del 17 de Noviembre del 2008: Según IBM, su Roadrunner continúa siendo la más rápida del mundo, ya que los números de esta de Cray son teóricos y no de pruebas reales, por lo que la entidad que mantiene la lista de las supercomputadoras mas potentes del mundo acaba de ponerse de lado de IBM, y la Roadrunner continúa en primer lugar, con 1.105 petaflop/s según esta nota de prensa. autor: josé elías |

|

|

|

|

|

martes, noviembre 4, 2008

|

A los adictos al estilo estético del "steampunk" les aseguro que se les aguará la boca cuando vean las fotos de este asombroso teclado. A los adictos al estilo estético del "steampunk" les aseguro que se les aguará la boca cuando vean las fotos de este asombroso teclado.No se ustedes, pero estos diseños al estilo steampunk están avanzando a un grado tal, que creo pronto los veremos en museos de arte moderno en todas partes del mundo... Enlace al teclado autor: josé elías |

|

|

|

|

|

lunes, noviembre 3, 2008

|

ASUS acaba de lanzar una serie de cases (cajones que contienen todo el interior de tu PC) que tienen la particularidad de que son plegables, lo que significa que es fácil transportarlos de un lugar a otro, en particular por aeropuertos, cosa que siempre ha sido un problema para los amantes a los LAN Parties. ASUS acaba de lanzar una serie de cases (cajones que contienen todo el interior de tu PC) que tienen la particularidad de que son plegables, lo que significa que es fácil transportarlos de un lugar a otro, en particular por aeropuertos, cosa que siempre ha sido un problema para los amantes a los LAN Parties.Aun no sabemos los precios, pero desde ya puedes empezar a ver los detalles técnicos en el enlace a continuación. Fuente de la noticia autor: josé elías |

|

|

|

|

|

|

Como les anunciamos hace unos meses, Intel por fin lanzó al mercado los primeros procesadores con tecnología Core i7, que son los que reemplazarán de ahora en adelante a los Core Duo y Core Quad, y todos los que lo han probado han quedado impresionados. Como les anunciamos hace unos meses, Intel por fin lanzó al mercado los primeros procesadores con tecnología Core i7, que son los que reemplazarán de ahora en adelante a los Core Duo y Core Quad, y todos los que lo han probado han quedado impresionados.Según reportes de medición de rendimiento, inclusive los Core i7 de menor costo son superiores a los mas caros de la generación previa de Core Quad, esto debido no solo a que ahora estos procesadores contienen el controlador de memoria integrado en el chip, sino que todos los i7 por defecto vienen con 4 núcleos con todos los últimos avances de Intel en años recientes. Los precios de estos nuevos procesadores rondan entre US$284 dólares (con el Core i7-920) hasta US$999 dólares (con el Core i7-965 Extreme Edition). A los interesados en todos los detalles técnicos, podrán encontrar todo lo que buscan en este enlace en HotHardware, o este otro en MaximumPC, o este otro en Computer Shopper, o este otro en TechSpot. Previamente en eliax: Core i7, los nuevos procesadores de Intel (Agosto 2008) autor: josé elías |

|

|

|

|

|

jueves, octubre 30, 2008

|

Hoy los envío a que lean un muy interesante artículo que resume la historia de la transición del Mac OS X desde un sistema operativo de 32 bits a uno de 64 bits, ya que tiene muchas lecciones para Microsoft Windows, así como un ejemplo a seguir por la comunidad del Software Libre con Linux. Hoy los envío a que lean un muy interesante artículo que resume la historia de la transición del Mac OS X desde un sistema operativo de 32 bits a uno de 64 bits, ya que tiene muchas lecciones para Microsoft Windows, así como un ejemplo a seguir por la comunidad del Software Libre con Linux.Antes de empezar, muchos se preguntarán ¿y cuál es la ventaja de 64 bits? Pues inmediatamente no es obvia para aplicaciones actuales, pero aplicaciones que tomen ventaja de 64 bits podrán obtener al menos dos beneficios importantes inmediatamente. El primero y mas obvio es acceso total a memoria de muchos mas de 4GB (en teoría a mas de 2 millones de TeraBytes), lo que significa mucho mas espacio para trabajar con archivos mas grandes. Y lo segundo es la posibilidad de procesar instrucciones de bajo nivel con el doble del largo, lo que significa que sería posible acelerar considerablemente muchos tipos de aplicaciones, en particular aquellas que dependan de datos multimedia o flujo de datos en modo stream (en cadena), como decodificadores de video y programas paralelizados. Lo primero a entender sobre la transición de OS X desde 32 a 64 bits, es que desde el OS X 10.4 Tiger, Apple ya tenía una fundación base de UNIX en 64 bits, lo que significó que desde hace ya varios años los programadores podían escribir aplicaciones, aun fueran en 32 bits, que funcionaban sobre 64 bits, empezando a alisar el camino para lo vendría. Con esta versión ya se podían crear aplicaciones en 64 bits, pero sin interfaces de usuario (es decir, aplicaciones tipo servidores como Apache, MySQL, etc), ya que las librerías para generar entornos gráficos aun eran 32 bits. Para OS X 10.5 Leopard (la versión actual), Apple creó la versión de 64 bits de Cocoa (su marco de librerías para programar a OS X, incluyendo soporte gráfico), lo que ya permite desde hoy escribir aplicaciones que son totalmente en 64 bits. Algo interesante sin embargo, es que el corazón del sistema operativo (el kernel) así como todos los drivers, son 32 bits, pero Apple esconde todo esto de los programadores, quienes tienen la opción de ver el sistema como uno de 32 o 64 bits. Ahora, para la próxima versión 10.6 Snow Leopard, Apple va a completar la transición a un sistema operativo completamente de 64 bits, pero totalmente compatible con 32 bits. Eso significa un kernel y drivers de 64 bits. Algo interesante aquí es los que saben del diseño de Sistemas Operativos se pregunten cómo Apple se hará para convertir todos sus drivers a 64 bits (ya que un kernel de 64 bits requiere drivers de 64 bits), y la respuesta es bien sencilla: Apple controla todo su hardware, por lo que los únicos drivers que tiene que convertir a 64 bits son aquellos que se utilicen en sus Macs y MacBooks que Apple decida serán compatibles con Snow Leopard. Eso significa relativamente poco trabajo para Apple, ya que solo tendrá que soportar máquinas vendidas en los últimos 4 a 5 años, lo que significa soportar solo unas 4 a 6 tarjetas de video, unas 3 o 4 tarjetas de redes, y así sucesivamente. Algo interesante es que Apple desde hace ya varios años creó el concepto de un Binario Gordo (Fat Binary), que significa que los desarrolladores pueden desarrollar sus aplicaciones, compilarlas tanto para PowerPC como para x86, tanto en entornos de 32 bits y 64 bits, e incluirlas todas en el mismísimo archivo instalador. Esto obviamente incrementa el tamaño de los binarios (aunque son los desarrolladores que deciden hacer esto, ya que es perfectamente factible hacer binarios diferentes para cada arquitectura), pero tiene la gran ventaja de que con el mismo instalador puedes instalar versiones de aplicaciones que funcionan en casi todas las Macs en los últimos años, así como en las que vendrán hacia el futuro cercano. Al final de todo el asunto, la lección principal de todo esto es entender que Apple definió una estrategia que le ha permitido transicionar toda su linea de Macs y MacBooks a un entorno totalmente de 64 bits, sin ningún trauma a sus usuarios, y con el menor trauma a los desarrolladores de software. Contrasten esto con Windows (y similarmente con Linux), en donde debes elegir de antemano si compras e instalas una versión de 32 o 64 bits de Windows, y después estás encerrado en uno o en el otro, problema que ha causado que las versiones de 64 bits de Windows sean adoptadas muy lentamente debido a que muchos programas y drivers no están disponibles para el Windows de 64 bits, y por tanto eso hace que muchas personas prefieran las versiones de 32 bits. enlace al artículo autor: josé elías |

|

|

|

|

|

miércoles, octubre 29, 2008

|

|

Según IDC (International Data Corporation), el mercado de las netbooks se está expandiendo tan vertiginosamente, que estas laptops de bajo costo ya tienen un 10% del mercado de computadoras de Europa (en donde se realizó el estudio).

Según lo publicado por IDC, las ventas de netbooks incrementaron en un 52% en el tercer cuarto (Q3) del 2008, en comparación con el mismo período el año anterior. Mas específicamente, se vendieron mas de 2 millones de netbooks en Q3, de un total de 27.9 millones de PCs y laptops vendidas en el continente. Opinión: Algo interesante es que como reportamos previamente, Apple (que es posiblemente el único de los grandes fabricantes que aun no está en el mercado de las netbooks en algún nivel), dice que no piensa entrar al mercado de las netbooks ya que "ha elegido el segmento del mercado que desea". Con esto Apple se refiere a que prefiere el mercado de los altos márgenes, que es casi inexistente en las netbooks, como se ha dado cuenta ASUS, la empresa que prácticamente inició el mercado de las netbooks con su Eee PC, y que se ha visto obligada a crear otros modelos de mas alto costo, pero que no han vendido como los originales. Hay que ver por cuanto tiempo Apple (y los pocos que aun no han entrado a la fabricación de netbooks) podrá obviar este mercado, que como vemos con estos números es cada vez mas creciente y competitivo. Sin embargo, Apple (o mas bien dicho el mismo Steve Jobs) ya tiró una pista de que tiene algo en etapa de diseño "por si acaso" algunos conceptos de netbooks, por lo que el próximo año será interesante ver qué ocurre con estas mini laptops de bajo costo. Según Steve Jobs, el iPhone ya cubre muchas de las funcionalidades de las netbooks, como el acceso a Internet y a emails, pero es mi opinión que aun hay muchas cosas que simplemente son mejor hacerlas todavía con un teclado y una pantalla de mayor tamaño (como sería editar un documento de texto). Finalmente, a los que no entiendan el fenómeno de estas netbooks, la gran ventaja de tienen no solo es precio, sino que portabilidad. Hasta hace poco comprar una laptop en estos tamaños diminutos significaba una inversión de US$2,000 a US$3,000 dólares, por lo que el poder comprar algo que pese apenas un par de libras (1 kg) y que cuesto US$400 dólares, aunque no sea potente es mas que suficiente para una persona que solo desee tener una herramienta portátil para navegar el Internet, enviar y recibir emails, y de vez en cuando editar unos documentos. Fuente de la noticia autor: josé elías |

|

|

|

|

|

martes, septiembre 30, 2008

|

A continuación los invitamos a que vean estas visionarias imágenes del diseñador industrial Yves Behar, quien articula de manera visual algo que se ha rumoreado por años Apple tiene planeado sacar algún día: Una laptop con dos pantallas, en donde una (o las dos) de ellas se pueda convertir en un teclado virtual o control muti-toque. A continuación los invitamos a que vean estas visionarias imágenes del diseñador industrial Yves Behar, quien articula de manera visual algo que se ha rumoreado por años Apple tiene planeado sacar algún día: Una laptop con dos pantallas, en donde una (o las dos) de ellas se pueda convertir en un teclado virtual o control muti-toque.En este caso estas imágenes son de un diseño conceptual de la OLPC de la cual hemos hablado bastante en eliax, pero como pueden ver, los fanáticos de Macs no pueden dejar de soñar con esto (y hay que admitir, que si implementan la parte del teclado bien, esto sería genial). ¡Gracias al lector Angel Diaz por el interesante enlace! Enlace a la página con mas fotos autor: josé elías |

|

|

|

|

|

lunes, septiembre 22, 2008

|

A los que siguen el incesante incremento del poder de computación, ejemplificado por la Ley de Moore (uno de los fundadores de Intel), que dice que el poder de computación se duplica cada 18 meses, les tenemos el próximo gran paso a la vista, ya que IBM dice que ha resuelto los problemas para fabricar chips en la medida de 22nm. A los que siguen el incesante incremento del poder de computación, ejemplificado por la Ley de Moore (uno de los fundadores de Intel), que dice que el poder de computación se duplica cada 18 meses, les tenemos el próximo gran paso a la vista, ya que IBM dice que ha resuelto los problemas para fabricar chips en la medida de 22nm.Esto es mucho mas lejos que Intel, quien planea para el 2009 fabricar chips con líneas de 32nm de grosor. A los que no están al tanto del tema, sucede que mientras mas pequeño se fabrican los chips, mas difícil se hace poder hacer que estos funcionen de manera fiable, ya que nos estamos aproximando a dibujar lineas eléctricas tan finas, que el grosor de tales lineas está llegando casi al grosor de los mismos átomos, y cuando uno llega a esa escala diminuta, las leyes de la física "clásica" se rompen y entran en vigor las leyes de la Mecánica Cuántica, lo que produce todo tipo de problemas y retos para los diseñadores y fabricantes de chips. Lo importante sin embargo es, que IBM dice haber resuelto el problema de haber llegado a los 22nm, lo que es asombroso. Noten que la importancia de fabricar un chip en 22nm, que por lo general hoy día en sus versiones mas avanzadas se fabrican con 45nm, es que el área (en este ejemplo de 45nm a 22nm) se reduce por 4 (ya que caben 4 chips de 22nm en el mismo espacio que uno de 45nm), lo que permite que el chip sea mucho mas barato fabricarlo, que disipe menos calor, y que funcione mas rápido (ya que las señales eléctricas tienen que recorrer mucho menos distancia entre una parte del chip y otra). En otras palabras, aunque ir de 45nm a 22nm aparenta ser tan solo un salto del "doble" del poder, lo cierto es que cuando se toma en cuenta la reducción en tamaño, la eficiencia energética, y el costo, que hablamos de chips que serán entre 4 y 10 veces mas potentes que los de hoy día, y sin tener que hacer nada mas que cambiar el proceso de fabricación. Fuente de la noticia Previamente en eliax: Logran crear primer componente lógico cuántico en un chip (Junio 2007) autor: josé elías |

|

|

|

|

|

|

Dell acaba de anunciar que lanzará una nueva generación de laptops que contendrán hasta 16GB de memoria, 1GB de memoria de video, 1TB de almacenamiento en disco (en RAID), pantallas de 17" con 100% de la gama de colores de Adobe (excelente para diseñadores gráficos, por lo que asumo que serán pantallas del tipo LED), y procesadores de 4 núcleos. Dell acaba de anunciar que lanzará una nueva generación de laptops que contendrán hasta 16GB de memoria, 1GB de memoria de video, 1TB de almacenamiento en disco (en RAID), pantallas de 17" con 100% de la gama de colores de Adobe (excelente para diseñadores gráficos, por lo que asumo que serán pantallas del tipo LED), y procesadores de 4 núcleos.No dicen la fecha de disponibilidad, ni el precio, pero pueden estar seguros que esto quemará un agujero en la cartera de quien sea que las compre... Fuente autor: josé elías |

|

|

|

|

|

jueves, septiembre 18, 2008

|

He aquí la "computadora personal" mas pequeña del mundo, una maravilla que como pueden apreciar en la foto es apenas un poco mas ancha que el largo de una llave de automóvil. He aquí la "computadora personal" mas pequeña del mundo, una maravilla que como pueden apreciar en la foto es apenas un poco mas ancha que el largo de una llave de automóvil.Es la "Fit-PC Slim" de CompuLab, mide 4.3 x 3.9 x 1.2 pulgadas (110 x 100 x 30mm), pesa apenas 13 onzas (380 gramos), consume apenas entre 4 y 6 watts, contiene un procesador AMD Geode LX800 de 500MHz, y además contiene un puerto de redes Ethernet, VGA para monitores, 2 puertos USB para teclado y ratón u otros dispositivos USB, y opcionalmente conectividad WiFi, y disco duro de 60GB en el formato de 2.5". Sin duda alguna este dispositivo puede encontrar algunos cuantos usos especializados. Ya me lo imagino como una "Car PC" dentro de un vehículo de algún hacker... :) La PC sola cuesta lo siguiente dependiendo de la configuración: - US$220 con 256MB de memoria, sin disco duro ni WiFi - US$245 con 512MB y con WiFi - US$295 con 512MB, WiFi, disco de 60GB y Ubuntu Linux - US$335 con 512MB, WiFi, disco de 60GB y Windows XP Home SP3 Fuente de la noticia (con mas detalles e imágenes) Anuncio oficial del producto autor: josé elías |

|

|

|

|

|

miércoles, septiembre 17, 2008

|

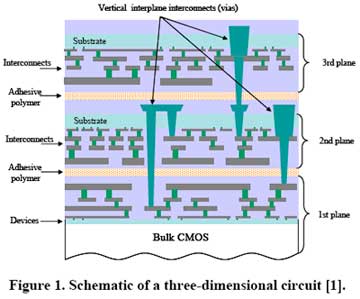

Investigadores de la Universidad de Rochester en los EEUU dicen haber perfeccionado la técnica que por fin permitirá fabricar chips de computadora de manera tridimensional, en vez de la manera "plana" que se utiliza hoy día. Investigadores de la Universidad de Rochester en los EEUU dicen haber perfeccionado la técnica que por fin permitirá fabricar chips de computadora de manera tridimensional, en vez de la manera "plana" que se utiliza hoy día.Desde sus inicios, los chips se fabrican en un entorno 2D, en donde se si ven por un microscopio aparentan ciudades en miniatura, en donde se disciernen grandes bloques y avenidas de información que los interconectan. Hasta el momento, esto nos ha servido bastante bien, pero debido a que estamos llegando a los límites de la miniaturización los científicos han recurrido a una técnica que lo que hace es colocar varios de estos diseños de chips, uno al lado de otro, esencialmente ampliando aun mas la superficie que estas mini-ciudades cubren en una superficie plana. El problema con esto es que eventualmente no vamos a tener espacio hacia los lados hacia donde expandirnos, así que similarmente como hemos hecho con viviendas en la vida real, la solución a este problema es "construir hacia arriba" de manera vertical, es decir, tridimensionalmente. Hasta ahora, algunos grupos como uno de IBM ha logrado crear chips tridimensionales, pero con varias limitaciones, entre ellas el hecho de que la tridimensionalidad solo se utilizaba como interconector de algunos elementos de intercambio de información entre chips. Sin embargo, con la nueva investigación en Rochester, es ahora posible fabricar chips que son verdaderamente trididimensionales, en el sentido de que la dimensión vertical ahora se puede utilizar no solo para comunicación, sino que además para lógica binaria. Esto, aumenta significativamente el poder de un chip, aunque introduciendo otros elementos a tomar en cuenta, como son la disipación del calor, y mas importante aun, la complejidad en diseñar lógica para un entorno 3D, pues casi todas las herramientas actuales de diseño lógico asumen un chip plano en 2D. Pero aun con estas barreras, no hay duda que este es el futuro, ya que hablamos de aumentar el poder de un chip de manera prácticamente exponencial. Algo interesante sobre esta investigación, es que no es solo algo teórico, sino que los científicos de Rochester ya han fabricado un prototipo que implementa estas técnicas, un chip que ejecuta instrucciones a un ritmo de 1.4GHz. Nota curiosa: Esto me acuerda un materia que tomé hace unos 15 años en Boston University en donde nos pidieron que "inventáramos" tres tecnologías para el futuro, y una de ellas fue precisamente esto, un proceso para crear chips en 3D para aumentar su poder considerablemente. Así que ya saben por qué este tipo de noticias me llaman la atención. :) Enlace a la página que habla del desarrollo de la Universidad de Rochester en chips 3D autor: josé elías |

|

|

|

|

|

martes, septiembre 16, 2008

|

Si se acuerdan, en febrero les trajimos la noticia de que Intel lanzaría unos procesadores Intel Xeon con 6 núcleos para finales de año, pero parece que Intel decidió no esperar, pues los acaba de lanzar oficialmente al mercado. Si se acuerdan, en febrero les trajimos la noticia de que Intel lanzaría unos procesadores Intel Xeon con 6 núcleos para finales de año, pero parece que Intel decidió no esperar, pues los acaba de lanzar oficialmente al mercado.Los nuevos chips Intel Xeon 7400 de 6 núcleos funcionan a 2.66GHz, y según Intel son 50% mas rápido que las versiones del Intel Xeon 7300 de 4 núcleos. ¿El único problema con estos procesadores? Un precio de US$2,729 dólares para el modelo de 6 núcleos, aunque el 7400 también vendrá en modelos de 4 núcleos por tan solo US$856... Fuente de la noticia Previamente en eliax: Intel a lanzar procesadores con 6 núcleos (Febrero 2008) autor: josé elías |

|

|

|

|

|

jueves, septiembre 11, 2008

|

|

¿Se acuerdan de la laptop de US$100 de HiVision de la cual les hablamos hace unos días? Pues para el que se quedó con dudas aquí les presentamos ahora un video presentando la máquina.

Sin duda alguna esta máquina, de producirse en grandes cantidades, pudiera tener un gran impacto en la sociedad, ya que permitiría que hasta las personas con mas escasos recursos puedan considerar tener una computadora en sus hogares. Esto es lo que debió ser el proyecto de OLPC, en donde el objetivo era vender laptops a los países subdesarrollados por menos de US$100, pero la OLPC terminó costando al menos el doble de eso cuando salió al mercado. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

"Este libro debería ser de lectura obligatoria en todas las escuelas."

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax