Hardware

|

sábado, noviembre 14, 2020

|

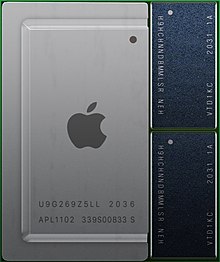

Hola amig@s lectores, Hola amig@s lectores,El día por fin llegó y este martes pasado Apple anunció las primeras Macs con su propio microprocesador integrado (tipo “SoC”, o Sistema-en-un-Chip) al que ha bautizado el M1, un chip derivado de los chips Ax utilizados en iPhones, iPads, AppleTVs y Apple Watches, y para muchos las primeras pruebas de rendimiento los ha tomado por real sorpresa, aunque quizás no tanto para otros que ya hayan leído mis artículos acá en eliax sobre el tema a través de los años (iniciando quizás con este en el 2007, que curiosamente pronosticó desde ese entonces con bastante certeza a la Apple de hoy). Y hablando de artículos técnicos, recomiendo fuertemente leer el artículo que escribí este pasado Julio 2020 titulado “Análisis #eliax: Apple Silicon, todo lo que querías saber (y lo que no sabías que te gustaría saber)” en donde expliqué en lujo de detalle (y en un lenguaje que personas no-técnicas pudiesen entender) qué es lo que hace diferente a estos microprocesadores de Apple. Sin embargo, como se que muchos no leerán el artículo, he aquí la versión ultra-resumida (y obviamente dejando fuera muchos datos interesantes) de uno de los puntos en ese artículo: A diferencia de la mayoría de otras empresas que licencian los chips ya diseñados por la empresa ARM Holdings, Apple lo que hace es que licencia lo que se llama el “ISA” de ARM, es decir, el lenguaje común que deben hablar todos los procesadores ARM, y después Apple toma ese lenguaje de bajo nivel y desde cero ha creado su propia implementación de esta arquitectura. O en otras palabras, lo único que Apple tiene de ARM es la definición de su lenguaje básico, pero el diseño que implementa ese lenguaje en silicio fue creado desde cero por Apple, utilizando algunos de los más legendarios diseñadores de microprocesadores de todos los tiempos. Aparte de eso, es importante destacar que debido a que es Apple quien diseña su propia versión de la arquitectura ARM, que esta puede tomar todo tipo de decisiones para lograr hacer de estos aun mejores microprocesadores, y eso es precisamente lo que ha hecho, integrando en estos unos circuitos adicionales propietarios, diseñados para acelerar los procesos más comunes en sus sistemas operativos, así como los procesos más comunes en las aplicaciones que estos corren. Como ejemplo, una laptop genérica de Windows con un procesador x86 (sea de Intel o AMD), aun corriendo a la misma velocidad que una laptop MacBook Air de Apple con el nuevo chip M1 es casi seguro que con aplicaciones de la vida real esta sea más lenta que la laptop de Apple. ¿Por qué? Pues utilicemos el ejemplo de alguien que vive de editar videos, y digamos que lo que estás haciendo es editando videos en el formato H.265. En el mundo Android/Windows es posible que ese trabajo se pueda hacer “a fuerza bruta” utilizando el gran poder computacional crudo de los chips de última generación en esas plataformas, y es incluso posible que se puedan aceleran algunos cálculos con “motores vectoriales” que existen usualmente en el GPU (el chip dedicado a manipular gráficos), pero en el entorno de Apple Silicon, Apple ha creado circuitos dedicados específicamente para codificar y descodificar video H.265, y en tiempo real. ¿Qué significa eso en la práctica? Que mientras tu PC con Windows está arduamente tratando de codificar y descodificar el “stream” de video H.265 mientras editas tu video, que esta está esencialmente utilizando su CPU y GPU casi al máximo con poco margen para que hagas otras cosas, haciendo que tu PC se sienta pesada y lenta. En el lado de Apple Silicon sin embargo la situación es diferente... Mientras editas tu video, circuitos dedicados están constantemente codificando y descodificando tu stream de H.265 en tiempo real, liberando esencialmente a tu CPU y GPU para que tengan ciclos de sobra para otras labores como manejo de audio, internet, labores de Office, etc, haciendo que tu sistema operativo se sienta ta fluido como la mantequilla. Incluso, ya se hizo público que incluso la nueva Mac Mini anunciada de US$699 dólares puede editar video en resolución 8K en tiempo real, algo inaudito en un equipo de tan bajo costo, de tan pequeño tamaño, y de tan bajo consumo energético (para los que no sepan de estos temas técnicos, noten que una señal 8K está compuesta de 16 señales de video “Full HD” 1080p como lo conocen los consumidores, así que hablamos de una máquinas de US$699 dólares capaz de editar el equivalente a 16 pantallas de video FullHD en tiempo real). Y notar que video es solo un ejemplo. Desde hace años en iOS y recientemente en el mundo de las Macs (con procesadores adicionales en los modelos clásicos con chips Intel, y ya integrado en el chip M1 hoy día), Apple tiene circuitos dedicados para en tiempo real cifrar todos los datos que fluyen en la memoria de la máquina así como la escritura y lectura de almacenamiento (sea a disco duro tradicional o SSD en estado sólido). Eso significa que en los entornos de Apple, la seguridad por medio de cifrado de datos está habilitada por defecto, ocurre en tiempo real, y tiene un impacto casi cero en el rendimiento del resto de la máquina, mientras que en la mayoría de los entornos Android/Windows, esas son funciones que tiene que hacer el CPU en adición a sus funciones cotidianas. Y esos fueron solo dos ejemplos. Apple dedica espacio para circuitos dedicados en sus chips a todo tipo de cosas que van desde sonido 3D hasta imágenes de alto rango dinámico (HDR), y desde reconocimiento facial y de huellas digitales hasta Inteligencia Artificial (por medio de Machines Learning). Así que los chips de Apple Silicon tienen las siguientes razones para ser no solo más eficientes que una máquinas tradicional x86 con Windows, sino para ser mucho más eficientes: 1. Para empezar, no inician con un diseño genérico de ARM, sino que un diseño creado desde cero por Apple mismo optimizado para las necesidades de su ecosistema y de sus usuarios. 2. Utilizan circuitos dedicados para acelerar tareas comunes de un usuario, liberando al resto del chip para otras labores más genéricas y haciendo que todo se sienta más fluido. 3. Aunque un tema un poco más técnico, Apple está liderando también en pruebas de “rendimiento por vatio”. Esto significa que sus chips consumen mucho menos energía haciendo el mismo trabajo que la competencia, lo que se traduce a que o (1) puedan trabajar sin calentarse tanto y sin perder velocidad o (2) tener un rendimiento aún superior bajo calentamiento y enfriamiento activo. Y a propósito, ese último punto es la razón por la cual la nueva MacBook Air M1, aun teniendo un chip con 8 núcleos de CPU y 8 núcleos de GPU, y decenas de otras microceldas de computación integradas, no solo no require abanicos para enfriar el chip, sino que de paso su batería dura fácilmente hasta 20 horas de uso, lo que liberará a muchas personas para que trabajen sin miedo el día entero sin tener que cargar un cargador encima todo el tiempo, que es otro de los beneficios no cuantificables sobre papel que esta arquitectura de Apple ofrece al usuario común. Sin embargo, no tienen que llevarse de todo lo que digo, ya surgieron los primeros benchmarks (medidas de rendimiento) de las primeras MacBook Air M1 que han llegado temprano a los laboratorios que hacen este tipo de mediciones, y los resultados hablan por sí mismos de lo contundente que son. Por ejemplo, el reconocido portal Tom’s Guide ha anunciado en su titular (traducido del inglés) “Revelan los benchmarks de la MacBook Air M1 y destruyen a las laptops con Windows”. Y si buscan en Google encontrarán otros resultados similares que han surgido en los últimos 2 días. Es importante aclarar que la MacBook Air M1 que acaba de salir a un precio de US$999 dólares no es que solo es más rápida que laptops de Windows en su rango de precio, sino que es más rápida que cualquier laptop con Windows que exista en el mercado, sin importar su precio. O En otras palabras, aun si compararas una laptop con Windows en US$3,000 dólares, esta seguiría siendo más lenta que el modelo más básico de Apple (la excepción a esto serían las laptops con GPU separados “discretos” de gama alta para video-juegos y de alto costo, pero noten que los benchmarks indican que el M1 supera hasta en un 30% a una tarjeta NVIDIA GeForce GTX 1050, lo que indica que al menos en el sector de chips integrados en laptops no hay comparación en el mundo de Windows por el momento). O en otras palabras, esto ha cambiado no solo las reglas del juego sino que el terreno de juego en sí. Ahora curiosamente la mesa ha dado vueltas y ahora se tendrán que considerar las laptops de Apple como no solo las más baratas para el rendimiento que ofrecen sino además las más potentes, dos condiciones que generalmente eran mutuamente exclusivas en el mercado, particularmente en el mercado profesional. Y ojo (como si ya no fuera suficiente dolor de cabeza para Intel y AMD), que este es apenas el primer chip M1 de Apple, que en apenas su primera encarnación básica ya es el chip más potente del mundo en el área que compite, y que todavía no hemos visto lo que Apple tiene planeado para la gama alta de su línea “Pro” en los próximos dos años, que pueden apostar será aun más potente, y en el caso de la Mac Pro será muchísimo más potente, posiblemente con decenas de núcleos o quizás configuraciones multi-chip en paralelo. ¿Qué significa todo esto? Que estamos literalmente al inicio de una nueva revolución en el mercado, una revolución que empujará ahora a Intel, AMD y Microsoft a ponerse las pilas y responder. Aquí alguien más que tiene de ganar aparte de Apple es ARM Holdings, quien ya está entrando en el diseño de chips ARM para uso en escritorio y laptops, y hay que ver si Microsoft se lanzará a seguir los pasos de Apple en el 2021 y por fin lanzar una versión de Windows optimizada para ARM. Y ojo, antes de que comenten al respecto: Sí, Microsoft creó una versión de Windows para ARM que sacó con sus tabletas con el llamado “Windows RT”, pero fue un total fracaso. Si Microsoft realmente quiere competir contra macOS con Windows, tendrá que hacerlo saltado de pie a cabeza en el mundo ARM, y de paso por fin dejar atrás a x86 y seguir soportando las aplicaciones tradicionales por medio de herramientas como Rosetta 2 en las nuevas Macs con el chip M1. Y hablando de Rosetta 2, hablemos de qué sucederá con la aplicaciones que ya poseen en sus Macs tradicionales... Para esto Apple ofrece Rosetta 2, que es una herramienta que en tiempo real toma un binario creado para x86 (la arquitectura de Intel y AMD) y lo “transcompila” a Apple Silicon, esencialmente generando un nuevo binario nativo para Apple Silicon. Según Apple (y aparenta ser cierto en la práctica), debido a la alta optimización de la transcompilación y debido al gran poder y eficiencia del M1, curiosamente muchas aplicaciones de Intel correrán mejor en las nuevas Macs con M1. Sin embargo esta transcompilación aunque funcionará para la vasta mayoría de aplicaciones, habrá un pequeño porcentaje de aplicaciones (menos del 1%) que no funcionarán, pero son aplicaciones muy específicas que tienen que ver con virtualización. Así que por ejemplo, aplicaciones como VMWare y Parallels Desktop que te permiten emular a Windows o Linux en Mac, inicialmente no funcionarán en sus versiones tradicionales, pero si lo harán desde que sus desarrolladores creen nuevas versiones específicas para Apple Silicon, y eso nos lleva a otra herramienta que ha traído Apple a la mesa para suavizar la transición entre las Macs tradicionales y las nuevas: Binarios Universales. Un Binario Universal en el mundo de Apple tiene dos sentidos, y ambos han sido utilizados tradicionalmente por Apple a través de los años. En el primer sentido, un Binario Universal puede ser un App para la misma arquitectura pero que funciona en dos plataformas diferentes. El mejor ejemplo de esto son las Apps Universales para iPhone y iPad. Esencialmente el mismo App funciona en ambos entornos, aun estos sean diferentes (pero compartiendo la misma arquitectura de los chips Series A de Apple que comparten los iPhones y iPads). En el segundo sentido, por Binario Universal Apple se refiere a un solo archivo que contiene los binarios para dos arquitecturas totalmente diferentes, como la del x86 y la de Apple Silicon. Y esta es la ruta que durante unos años Apple seguirá. Bajo este modelo, cuando los desarrolladores creen sus Apps utilizando las herramientas de Apple, tras bastidores Apple compilará dos versiones de la aplicación, una optimizada para x86, y otra para su propio Apple Silicon, y las empaquetará ambas en un solo archivo instalador. ¿Qué significa eso? Que al menos por los próximos años cualquier usuario de Mac, sin importar que la Mac sea de la tradicional x86 o Apple Silicon podrán compartir archivos normalmente entre sí y los programas funcionarán transparentemente. Esto significa también que las Macs que hayas comprado recientemente no dejarán de funcionar, y que casi todos los programas que se hagan para las nuevas Macs funcionarán en tu Mac (salvo obviamente aquellos casos que tomen ventaja de cosas nuevas que no existan en las Macs anteriores, como podría ser un sensor de FaceID que espero llegue algún día a las Macs). Según Apple, la empresa planea seguir dando soporte a las Macs tradicionales “por varios años más”. Si nos llevamos de su historial con transiciones pasadas, lo más probable es que el tema de los binarios universales sea la norma por dentro al menos 3 o 4 años más, y quizás por un máximo de 5 o 6. Y noten un par de temas más. El primero es que Apple ya podrá crear aplicaciones mega-universales, que no solo funcionarán en las Macs con x86 y las de Apple Silicon, sino además en iPhone y iPad, cosa que ha anunciado oficialmente. Y esto se hará cada vez más fácil debido a que cada año macOS y iOS y iPadOS comparten cada vez más sus cimientos. Incluso, por si no sabían, una de las nuevas cosas que puedan hacer las nuevas Macs con M1 es ejecutar aplicaciones de iPhone y iPad (aunque son los desarrolladores de cada App los que decidirán si permitirán ejecutar sus Apps de iPhone y iPad en macOS, pues quizás quieran optimizar su interfaz para cada entorno), lo que traerá cientos de miles de Apps de iPhone (y particularmente iPad) a macOS. Yo por ejemplo sueño con una futura iMac cuya pantalla se recline y se convierta en una tableta gigante para utilizar aplicaciones optimizadas para touch, o por ejemplo utilizar a ProCreate para dibujar/pintar con el Apple Pencil (dicen que soñar no cuesta nada). Y el otro tema es que es bueno que sepan que esta no es la primera vez que Apple hace semejante transición, incluso, esta es la tercera vez que lo hace. La primera vez fue cuando transicionó sus Macs de los chips Motorola 68xxx a los PowerPC, la segunda vez fue cuando transicionó a sus Macs con OS X desde PowerPC a x86, y esta vez es la tercera, así que la empresa ya tiene experiencia con estas transiciones, y por sobre todo que no tiene el temor de hacerlas, cosa que siempre he deseado de Microsoft, quien testarudamente al día de hoy quiere seguir soportando aplicaciones de hace décadas atrás, y esa resistencia al cambio es precisamente lo que le costará mercado ahora, pues pueden esperar que al menos en los próximos dos años Apple tomará una ventaja significativa sobre el mercado de Windows, al menos en el sector profesional. Para que tengan una idea a lo que me refiero, herramientas como Pixelmator ya están reportando esta semana que la versión M1 es entre 3 y 15 veces más rápida que la versión x86, y esa ventaja puede dejar atrás aquellas otras aplicaciones profesionales que solo existen en Windows si no se apuran rápidamente a migrar sus apps a macOS. Adobe por ejemplo ha respondido que migrará toda su plataforma creativa a Apple Silicon precisamente para no quedarse atrás, y esperen lo mismo de aplicaciones de otra índole en ramas de la ingeniería, medicina, arquitectura, etc. Habiendo dicho todo eso, y para concluir, quiero decir que es verdad que ahora vendrán las guerras de los Fanboys y los Haters, pero al final de cuentas somos los consumidores los que seremos beneficiados de estos saltos tecnológicos, y debo decir que el mundo de las PCs de escritorio y laptops (de Windows y Macs) necesitaban algo como esto, pues ese mundo se había casi paralizado debido a los grandes avances en el sector móvil. Así que amen u odien a Apple, hay que darle su debido crédito de querer siempre innovar y empujar (o a veces halar) al resto de la industria hacia adelante... Los próximos dos años serán verdaderamente emocionantes. autor: josé elías |

|

|

|

|

|

miércoles, julio 22, 2020

|

Hola amig@s lectores, Hola amig@s lectores,Como ya sabrán, Apple recientemente anunció que sus Macs transicionarán a sus propios procesadores que ha bautizado como "Apple Silicon", y aunque no han proveído información detallada al respecto noten que llevo desde el 2007 prediciendo esta integración (ver los enlaces de "previamente en eliax" al final de este artículo en donde verán los principales artículos históricos que he escrito acá en eliax sobre el tema), y por tanto tengo una muy buena idea de todo lo que ocurre tras bastidores (ayudado también por contactos en ciertas empresas, rumores de fuentes confiables, y dado que mi profesión de carrera universitaria fue precisamente el diseño de microprocesadores, tema que entiendo en profundidad). Habiendo hecho esa breve introducción déjenme aclararles algo de entrada: Apple no está fabricando los típicos chips de arquitectura ARM para sus Macs (ni tampoco para sus otros productos que utilizan Apple Silicon como son el iPhone, iPad, Apple Watch, AirPods, Apple HomePod, o Apple TV), y para entender eso deben entender cómo funciona el ecosistema ARM, que es muy diferente al ecosistema tradicional de Intel (y AMD) con la arquitectura x86 y sus derivados recientes como X86-64. En el mundo de x86, empresas como Intel y AMD diseñan sus chips, los fabrican (sea en sus propias fábricas, como Intel, o de otros, como AMD) y después los venden a clientes (como Dell, HP, Lenovo, etc) que después integran esos chips adentro de sus productos. Bajo este modelo el cliente de x86 por lo general no tiene muchas opciones a la hora de decidir qué va dentro de esos chips (que por lo general son CPUs, o el cerebro principal del sistema) y a veces GPUs (encargado de gráficos, y más recientemente también de temas como Inteligencia Artificial de forma parcial). Sin embargo empresas como Intel lo que hacen es que tienen una gran diversidad de familias (como la i3, i5, i7, i9, Xeon, etc) y modelos (como por ejemplo el Core i9-10980HK), con la esperanza de que algunos de esos modelos le serán de utilidad al mercado dependiendo de las necesidades (como por ejemplo, laptops, o potentes servidores, o PCs para jugar, etc). En el mundo ARM la situación es totalmente distinta. La empresa que mantiene la arquitectura ARM es ARM Holdings, cuyo propietario es actualmente el SoftBank Group de Japón (curiosamente, noten que Apple fue de las 3 empresas que iniciaron a ARM, junto con Acorn Computer y VLSI Technology). En este mundo, la empresa ARM no fabrica sus propios chips, sino que licencia sus diseños en dos modalidades muy particulares. Bajo la primera modalidad, ARM diseña chips y licencia sus planos a empresas que deciden utilizar esos diseños para sus productos. Así que por ejemplo alguien como Samsung puede licenciar los planos de un modelo específico de chips de ARM, y después procede a enviar esos planos a una fábrica para que les fabrique millones de chips con esos planos y después poner el producto en sus celulares. ARM también provee servicios donde bajo ciertos arreglos puede ligeramente modificar algunos aspectos de sus diseños para clientes en particular (Huawei por ejemplo puede solicitar a ARM que le provea planos de un chip que contenga 4 núcleos de CPU de alta potencia y 4 más de bajo consumo energético). Pero lo importante a entender es que bajo este modelo los creadores de productos (como Samsung o Huawei) simplemente licencian los planos de tales chips, y después es labor de ellos buscar un fabricante que se los fabrique. El otro tipo de licencia, que muy pocos tienen, siendo Apple una de esas exclusivas empresas, no es para licenciar los planos genéricos de los chips que implementan la arquitectura ARM, sino para licenciar lo que se llama el "ISA" (Instruction Set Arquitecture). Les explico a continuación ya que esto es extremadamente importante lo entiendan... Cuando alguien habla de "X86" o "ARM" se refiere por lo general al paquete completo, al producto final, al chip ya empacado y listo para utilizarse en un celular o tableta. Sin embargo, en la jerga de la industria esas palabras tienen significados muy diferentes dependiendo de a qué nos estamos refiriendo. Una cosa es un chip que implementa una arquitectura, otra es la arquitectura en sí. En el mundo de los microprocesadores uno generalmente inicia con el ISA, que no es más que el lenguaje que hablaría el microprocesador a bajo nivel. Así que por ejemplo, imaginemos una arquitectura de microprocesador que implementará este ultra-sencillo juego de instrucciones (ISA): - ESCRIBIR (algo en memoria) - MODIFICAR (algo en memoria) - COPIAR (de un lugar en memoria a otro lugar) - BORRAR (algo en memoria) - SUMAR (dos números) - CONDICION (para hacer algo dependiendo de algo) Esa lista de 6 "comandos" sería el ISA, o "La Arquitectura del Juego de Instrucciones". En la realidad, obviamente la cosa es muchisisísimo más compleja, pero para fines didácticos este ejemplo es más que suficiente. Ahora bien, asumamos que ese es el ISA de la arquitectura ARM. ¿Qué sucede ahora? Pues obviamente el ISA no es más que una especificación técnica sobre papel, no hace absolutamente nada hasta que alguien haga un diseño (un "plano") que implemente esa ISA en un plano que después se pueda enviar a una fábrica para crear el chip. Y eso es precisamente una de las cosas que hace ARM: La empresa toma su especificación de ISA y diseña planos de chips que implementan ese ISA para distintos mercados. Es bueno notar que ARM hace distintas familias de diseños de sus chips para diferentes mercados, tal cual lo hace Intel, así que por ejemplo ARM tiene familias como son los Cortex-A, Cortex-M, Ethos-N, Neoverse, etc. Es también bueno entender que aunque los chips son diferentes y para distintos mercados (como puede ser desde un super pequeño chip de bajo consumo energético para ser utilizado en un la computadora de un refrigerador, hasta un super potente chip con 8 núcleos para el más reciente celular de Google) que todos esos chips utilizan exactamente el mismo ISA, lo que significa que un programa que pongas en uno de ellos funcionará hasta cierto punto en otro (aunque obviamente de forma más rápida o lenta dependiendo del caso). Y esa es una de las grandes ventajas de ARM: Un desarrollador de software puede utilizar esencialmente las mismas herramientas para desarrollar para una aplicación que va en un refrigerador, hasta una aplicación que va para una nave espacial, ya que la arquitectura de bajo nivel es la misma. Pero la otra cosa que hace ARM (como es el caso de Apple) es licenciar la ISA en sí, para que sea entonces el cliente de ARM (en este caso Apple) quien diseñe sus propios planos basados en la arquitectura ISA de ARM. Y es por eso que aunque Apple licencia el ISA de ARM, que técnicamente hablando al bajo nivel los chips de Apple son totalmente diferentes a los chips ARM genéricos que utilizan empresas como Samsung, Huawei y Google en sus productos. Y eso es extremadamente importante entenderlo porque muchos se preguntan que cuál es la fórmula mágica que permite que año tras años los chips "ARM" de Apple en sus celulares y tabletas sean considerablemente superiores en rendimiento y consumo energético a los de la competencia, y la razón es que Apple ha invertido miles de millones de dólares en contratar (literalmente) a los mejores diseñadores de microprocesadores del mundo, con la finalidad de tener su propia implementación del ISA de ARM al que llama "Apple Silicon". Pero antes de explicarles qué otras cosas está haciendo Apple para hacer que su Apple Silicon sea mucho más eficiente que los chips genéricos de ARM, es bueno responder también la pregunta "¿Por qué ARM en primer lugar y no x86?" Es decir, qué hizo que empresas como Apple, Samsung y miles de otras decidieran adoptar a ARM para sus productos... Y la respuesta es sorpresivamente sencilla: Eficiencia, costos y simpleza. Sucede que filosóficamente han existido tradicionalmente dos escuelas de pensamiento sobre cómo diseñar microprocesadores. La primera escuela es llamada CISC, y la segunda RISC. Intel es de la vieja escuela de CISC que significa "Complex Instruction Set Computing", y ARM es de la nueva generación de RISC (Reduced Instruction Set Computing). En CISC la idea es diseñar microprocesadores que con una sola instrucción puedan hacer varias operaciones a la vez, mientras que RISC prefiere la filosofía de preferir hacer varias operaciones simples una detrás (o en paralelo, de ser posible) de las otras. Aunque ojo que hoy día ambas arquitecturas han tomado prestado de la otra, pero para fines de este artículo lo que les dije es lo primordial. Como analogía didáctica, imaginen un ejemplo en donde un usuario quiere sumar 4 números que llamaremos A, B, C y D. En el mundo CISC de Intel es posible que exista una instrucción que sume los 4 números de una sola vez, con una instrucción similar a esta: SUMAR 4 NÚMEROS: A + B + C + D = X Pero en el mundo RISC quizás solo tengamos una simple instrucción que sume dos números a la vez, por lo que tendríamos que ejecutar varias instrucciones simples secuenciasmente para llegar al total, similar a esto: SUMAR 2 NÚMEROS: A + B = X SUMAR 2 NÚMEROS: X + C = X SUMAR 2 NÚMEROS: X + D = X Ahora bien, a simple vista se puede perdonar que alguien ingenuamente opine que la primera forma de sumar los números es "la más eficiente", puesto que se hace todo en un solo paso. Sin embargo, y como dice el viejo dicho, el demonio está en los detalles... Sucede que en el primer ejemplo, así como Intel tendría una instrucción especial para sumar 4 números, lo más probable es que también tenga que tener dos instrucciones más adicionales en el chip, una para sumar grupos de 3 números, y otra para sumar grupos de 2 números, como esto: SUMAR 4 NÚMEROS: A + B + C + D = X SUMAR 3 NÚMEROS: A + B + C = X SUMAR 2 NÚMEROS: A + B = X O en otras palabras, mientras que la arquitectura RISC tiene un solo comando que se llama "SUMAR 2 NÚMEROS" y que reutiliza una y otra vez para sumar la cantidad de números que uno desea, la arquitectura CISC tiene comandos específicos para sumar entre 2, 3 o 4 números (y obviamente puede combinarlos igual que RISC para múltiples operaciones). ¿Qué significa eso? Pues significa lo siguiente: 1. Implementar la instrucción de sumar dos números en ambas arquitectura posiblemente tome una cantidad de circuitos (y correspondiente espacio) en el chip muy similar. Pero para implementar la suma de 3 o 4 números la arquitectura CISC va a necesitar de más circuitos y más espacio en el chip (en nuestro ejemplo, entre 3 y 5 veces más espacio debido a que también se necesita espacio para guardar todos los números que se suman a la vez). 2. Debido a que un chip CISC necesita muchísimo más espacio que un chip RISC para poder hacer computación, eso significa también que (1) son más complejos y (2) más grandes ya que ocupan mucho más espacio. 3. Debido a que los chips CISC son más grandes, eso también significa que son mucho más caros para fabricar, ya que los chips se fabrican en wafers (similares a un disco compacto pero sin el agujero del centro), y mientras menos chips quepan en un wafer mayor su costo de fabricación y de paso mayor la posibilidad de que tengan impurezas lo que daña los chips y por tanto sube aun más los costos de fabricación. 4. Pero como si fuera poco, el hecho de que los chips son más grandes, y que de paso las instrucciones del ISA de un chip CISC manipulan más datos a la vez, eso también significa que (1) consumen significativamente más energía y (2) por tanto se calientan mucho más, lo que para ciertas aplicaciones es un grave problema ya que se necesitaría de enfriamiento activo (como son los ventiladores conectados directamente en los chips como es común en las PCs de Intel con Windows). Habiendo dicho todo eso, espero que vayan entendiendo por qué entonces al inicio de la revolución móvil que inició en los días del primer iPhone (y los anteriores líderes como fueron el Palm Pilot o Blackberry) los fabricantes de tales dispositivos decidieron irse mejor con ARM (y su arquitectura RISC) ya que los microprocesadores ARM son (1) más baratos, (2) consumen menos energía, y (3) ocupan menos espacio. Y como pueden ver estos son tres requerimientos esenciales para aplicaciones móviles hoy día. Intel, lamentablemente, no predijo todo esta revolución móvil que se venía llegar tarde o temprano, no se adaptó a tiempo a las nuevas tendencias, decidió seguir pensando en PCs de escritorio y laptops tradicionales con Windows, y cometió de paso su error más monumentalmente nefasto al no solo no decidir crear una arquitectura que compitiera realmente contra ARM, sino que de paso fue tan torpe como para vender una licencia de ISA ARM que poseía (de las muy pocas que existían en el mundo, y que de no haberla vendido, hubiese podido estar fabricando sus propios chips ARM hoy en día). Noten que debido a todo eso, hace 10 años escribí un artículo titulado "Análisis eliax: La arquitectura ARM se convierte en la más grande amenaza al negocio de Intel", pero parece que los ejecutivos de Intel no leían a eliax en ese entonces... Pero las ventajas de ARM no se quedan ahí. A diferencia de los chips x86 cuyos únicos diseñadores son Intel y AMD, en el mundo ARM un cliente de ARM puede solicitar que en el mismo chip se integre también todo tipo de otros diseños y módulos, como por ejemplo integrar un GPU o un procesador de señales dentro del mismo chip, para así hacer todo más eficiente aun y de mucho menor costo. Y es ahí en donde viene el concepto (que encontrarán en donde sea que lean estos temas) de un "SoC". Un SoC (System on-a Chip) no es más que la técnica de poner varios microprocesadores que usualmente estarían empacados en chips diferentes, dentro de un solo chip. En el mundo x86 esto también existe pero de forma muy limitada, como por ejemplo los chips de Intel que vienen con un GPU integrado, pero en el mundo ARM eso se lleva a todo un nuevo nivel ya que ARM le da permiso a cualquier fabricante de integrar cualquier otro circuito personalizado que desee dentro de sus diseños. Y es bueno notar también que cuando empacas varios diseños de microprocesadores en un solo chip que las distancias de comunicación interna se reducen considerablemente mejorando de forma sustancial el rendimiento de interacción entre las partes. Y todo esto nos lleva de regreso a Apple... A diferencia de (por ejemplo) los fabricantes de equipos Android que están a la merced de ARM para diseñar sus propios módulos opcionales para incluir en un SoC, o de tener que contratar a terceros que les provean esos módulos en forma de "IP" (cuando lean "IP" en este contexto no están hablando de "dirección IP de Internet", sino de "Intellectual Property, es decir, planos de circuitos que son propiedad intelectual de sus diseñadores y que te venden o licencian), o en algunos casos de tener que contratar de forma interna o externa a expertos que les diseñen esos componentes adicionales, mientras que Apple por su parte lo que ha hecho es que dentro de su propia empresa ha creado toda una división de diseño de microprocesadores cuyo único cliente es Apple mismo. Y esto, tiene implicaciones profundas... Para empezar, Apple fabrica cientos de millones de productos cada año, y todos utilizan y utilizarán su propio Apple Silicon, lo que le permite lograr una extremadamente eficiente economía de escala, ya que tiene el uso y consumo de tales chips garantizados. Debido a que Apple es el único "cliente" de Apple Silicon, eso significa que los diseñadores de esos chips están diseñando circuitos exclusivamente para las necesidades de Apple y de nadie más. Eso a diferencia de los diseños genéricos de ARM, que por pura necesidad deben ser lo más genéricos posibles ya que deben satisfacer las diversas necesidades que pudieran tener los distintos clientes que licencien esos diseños (es el caso similar con el sistema operativo Android, debe ser lo más genérico posible para poder ser utilizado en equipos de diversos fabricantes y por tanto por motivos lógicos y técnicos jamás podrá ser tan eficiente como lo es iOS por ejemplo en un iPhone). Así que por ejemplo, ARM no tiene el menor incentivo en crear circuitos de alta eficiencia para escáners 3D de reconocimiento facial, ya que solo tendría uno que otro cliente para esa aplicación (grandes como Samsung o Huawei que puedan invertir en eso), y por tanto prefiere mejor que tales fabricantes implementen esas funcionalidades en software en vez de hardware. Eso significa también que los chips genéricos de ARM tienen incluso "circuitos de más" que están ahí para satisfacer al más común denominador, que son diseños que aunque son optimizados para un bajo consumo energético y cierto poder de procesamiento, no están optimizados para las necesidades de un cliente en particular. Un ejemplo sería que la nueva versión de Android soporte escáneres faciales en 3D de forma nativa (sin que un integrador como Samsung o Huawei tenga que hacer su propia implementación sobre el Android base). Sería genial si ARM pudiese implementar los algoritmos ultra-demandante de procesamiento de CPU que este tipo de funcionalidad demanda, en hardware, para que sea más eficiente en términos de velocidad y consumo de memoria y energético, pero ARM no tiene incentivo de hacer tal cosa ya que asume que empresas como Samsung o Huawei utilizarán sus talentos internos para proveer u obtener módulos de IP que puedan integrar con los planos de ARM, y al menos que todo el mercado empiece a demandar tal funcionalidad ARM no levantará un dedo, y para cuando lo haga ya Apple habrá implementado lo mismo par de años antes. Un buen ejemplo de esto fue la movida de chips ARM de 32 bits a 64 bits. Fue Apple (y asombrosamente, no ARM) que lanzó el primer procesador ARM de 64-bits en el 2013, y el mundo Android tuvo que esperar casi 3 años después para poder tener algo similar viniendo de ARM. Y todo esto nos trae de re-regreso a Apple: El único cliente de Apple Silicon es... Apple. Si Apple le dice al equipo de ingenieros de Apple Silicon que en par de años planean lanzar unas gafas de Realidad Aumentada y que necesitan poner circuitos dedicados en sus chips para que los algoritmos que utilizarán esas gafas y los iPhones del momento puedan lidiar de forma eficiente con el flujo de datos que eso genera, eso más que una sugerencia sería una orden, y 12 meses después pueden apostar a que los nuevos iPhones y diseños de Apple Silicon ya contendrán circuitos dedicados para esa tarea. Esa es la razón principal por la cual el iPhone SE que cuesta US$400 ha sido comprobado que es mucho más rápido que el celular más caro de Samsung que cuesta cerca de US$1,500 dólares. Y es la misma razón por la cual un iPhone con 3GB de memoria RAM funciona marcadamente más fluido que un celular Android con 6GB de RAM, ya que en el ecosistema de Apple todo está integrado eficientemente y diseñado como un "todo". Esa es también la razón por la cual las baterías de los celulares iPhone son por lo general de menor capacidad que los celulares genéricos Android y aun así "misteriosamente" duran la misma cantidad de horas funcionando. Tiene que ver con el hecho de que en Android muchas de las funcionalidad básicas ejecutan en software y no en hardware de bajo nivel, lo que aumenta su consumo energético y los hace más lentos de paso. Un buen ejemplo de esto es el módulo de seguridad de Apple, el Digital Enclave. Este es un chip propietario de Apple que en tiempo real cifra todo lo que haces en tu iPhone, iPad o Mac, sin afectar ni en un 0.0001% el rendimiento de lo que hace tu dispositivo ya que todo el cifrado ocurre en circuitos dedicados creados especialmente para tal fin, dejado a tu dispositivo seguir trabajando en otras cosas. Esta es también la razón por la cual quien no entiende de estas cosas no se debe dejar llevar de benchmarks (programas que miden la velocidad de tu dispositivo) cuando comparan cosas muy diferentes como son los iPhones o Android. Aunque en actualidad prácticamente todos los benchmarks indican que los dispositivos de Apple son más potentes que la competencia, lo cierto es que esos programas no son un indicador del rendimiento real del sistema cuando pones en el paquete todas las optimizaciones que hace Apple tras bastidores. Lo que sí tiene más sentido es comparar un benchmark de un celular Android con otro Android, o un modelo de iPhone vs otro modelo de iPhone. Habiendo escrito esta kilométrica explicación, esto nos lleva finalmente al tema de moda hoy día: Apple Silicon en Macs... Muchos se le han reído en la cara a Apple con este anuncio alegando que "Apple planea utilizar un simple chip de celular en una computadora de trabajo serio, ¡nos jodimos!", pero les puedo asegurar que todo el que dice eso no sabe absolutamente nada de microprocesadores, o de lo que ocurre tras bastidores como les he explicado a ustedes en este artículo, o son simples haters que ya tienen nuevo material para hacer sus aburridas vidas menos miserables, o sencillamente son el tipo de personas que repiten como loros todo lo que leen en Internet sin revisar fuentes o investigar de lo que están opinando. Y lo primero que les voy a decir sobre Apple Silicon en Macs es lo siguiente: Prepárense para una gran sorpresa. Una buena sorpresa. Para los que no lo sepan, Apple ya ha entregado decenas de miles de "kits de transición" a desarrolladores de aplicaciones para que vayan adaptando sus aplicaciones a Apple Silicon en Macs, y los resultados no pudieron ser más positivos... Para iniciar, el kit contiene lo que es esencialmente una Mac Mini con el chip A12Z Bionic de Apple utilizando una versión beta de macOS 14 Big Sur. Sucede que ese chip es el utilizado en el iPad Pro de hace dos años atrás, y aún así los benchmarks (para los que les gusta comparar) indicen que esa Mac Mini con un chip no optimizado de hace dos años atrás obtiene una calificación de 4669 puntos en su CPU, comparada con la Surface Pro X de Microsoft que viene con un procesador Intel i5 que sacó una calificación de 2966. Pero eso no es nada: Sucede que el kit de Apple sacó esa calificación de 4669 corriendo en modo de emulación, es decir, el programa de benchmark en la Mac no estaba corriendo código nativo como el que correrá en las Macs reales cuando estas salgan a la venta a fin de año, y de paso estaba utilizando (reitero) un chip (1) de hace dos años atrás, (2) destinado para una iPad, y (3) no optimizado para Macs. ¿Qué significa todo eso? Pues para empezar podremos esperar que lo que sea que Apple tiene pensado para las nuevas Macs será marcadamente más potente que ese chip de iPad, y si nos llevamos de rumores tras bastidores esos nuevos chips vendrán con 12 núcleos (en vea de los tradicionales 2 o 4 núcleos en las Macs con Intel), lo que aumentará aun más su poder. Y lo mejor de todo (y ahora entenderán mejor todo lo escrito hasta ahora) esos chips de Apple Silicon vendrán con circuitos especializados específicamente creados para optimizar las funciones más comunes y/o importantes de macOS (cosa que Apple no le podía solicitar a Intel para sus chips x86-64), lo que aumentará aun más su rendimiento. De paso, esperen que las MacBooks de Apple ahora por fin dejarán de ser tan calientes (quien se haya puesto una MacBook Pro en sus piernas para trabajar sabe exactamente a lo que me refiero) y sus baterías pueden estar seguros que se extenderán considerablemente. Y esto de paso también incrementará los márgenes de ganancias para Apple (que aunque muchos se quejen, es precisamente lo que permite que Apple haga estas innovaciones), lo que al menos le da un colchón de costo a Apple para si la competencia se pone fuerte en un futuro esta pueda bajar sus precios cómodamente. Todo esto de paso significa también que tecnologías que tradicionalmente estaban destinadas a iPhone y iPad llegarán más rápidamente a Macs. Yo por ejemplo espero que las nuevas Macs vengan con FaceID para permitirme dejar trabajar con yo solo estar frente a mi máquina sin nececidad de entrar claves (cosa que ya puedo hacer con mi Apple Watch en combinación con mi Mac, pero sería mejor que no dependa ni de eso para entrar directo a trabajar, como lo hago con mi iPhone y iPad). Habiendo dicho todo eso, tengo que también aclararles algo que para algunos resultarán desagradable: Debido a las obvias diferencias entre el ISA de Intel y ARM, las nuevas Macs ya no podrán ejecutar Windows de forma nativa (con BootCamp), y por otro lado emuladores de Windows en x86 (como VMWare, Parallels Desktop y Virtual Box) tendrán que ser recreados para poder emular las instrucciones x86 en ARM (en actualidad ese paso no era necesario ya que los emuladores simplemente pasaban las instrucciones de Windows directo al CPU de la Mac que ya era x86). ¿Qué significa ese tema con Windows? Pues para empezar a Apple no creo le importe mucho ya que por lo general los que quieren el uso exclusivo de Windows no compran una Mac para tal fin por motivos de costos. Similarmente los gamers (comunidad de video-juegos) tradicionalmente nunca han comprado Macs para tal fin. Eso solo deja a los que compran una Mac como computadora principal y utilizan a Windows para temas de desarrollo de software u otros trabajos, y la realidad es que la gran mayoría de estos (yo incluido) no optan por BootCamp sino por virtualizar a Windows dentro de macOS. Así que la única incógnita que queda es qué tan bien podrán estos virtualizadores emular a Windows cuando tendrán que traducir en tiempo real las instrucciones de x86 a ARM en tiempo real, y para esto hay un par de respuestas potencialmente esperanzadoras... La primera es que Apple también anunció que incluirá un Hypervisor super avanzado en las nuevas Macs, con características que a la fecha solo existían en ambientes de servidores avanzados. El Hypervisor de Apple esencialmente permitirá particionar tu Mac en varias Macs virtuales de forma ultra-eficiente, y en donde cada Mac virtual podrá ejecutar otras versiones de macOS u otros sistemas operativos en paralelo (Apple habló especificamente de Linux como ejemplo), lo que será una mucho mejor manera de virtualizar en macOS que en actualidad. Y la segunda es que Apple muy bien puede crear circuitos especiales en Apple Silicon diseñados para hacer la traducción de x86 a ARM más eficiente (algo que si tuviera que apostar, diría ya está implementado). Así que como pueden ver, esto de Apple Silicon no es algo que Apple hizo a la ligera, sino algo extremadamente bien pensado que Apple ha venido cocinando desde años, y el futuro solo se pondrá mejor... Finalmente, es bueno mencionar mi predicción de enero 2007 en donde escribí (entre otras predicciones): "[...] imagínense que dentro de 5 años el iPhone sea tan poderoso y tenga tanta memoria como las computadoras personales mas potentes de hoy día. Eso significaría que con agregar un teclado, ratón y pantalla externa (todos inalámbricos), que no hay razón para que el iPhone no sea nuestra computadora personal en cualquier lugar." Esa visión, ahora que un iPhone podrá ejecutar macOS (si Apple así lo decide), ya está a la vuelta de la esquina. Similarmente y como he predicho antes, no me sorprendería que ahora que Apple ya tiene todos sus productos bajo una misma arquitectura que ahora decida crear una versión universal de su sistema operativo a la que llamo "appleOS" y que las distintas versiones para iPhone, iPad, Mac etc sean sencillamente variaciones o "Editions" de esta. ¿Y ustedes, qué opinan de todo esto? Si tienen preguntas o quieren que les aclare o expande algo, o tienen algún comentario adicional, escriban abajo y como siempre les contestaré en la brevedad. autor: josé elías |

|

|

|

|

|

lunes, mayo 12, 2014

|

Hace 7 años les hablé acá en eliax de una futura y revolucionaria nuevo tipo de memoria, y de la cual les volví a hablar otras vez hace 3 años en un par de artículos (este y este), que de ser implementada dejaría atrás por mucho a los tradicionales discos duros, al menos en velocidad, y hoy por fin podemos anunciar que tenemos fecha de salida para esa tecnología que ha sido bautizada como PCM (Phase-Change Memory, o "Memoria de Cambio de Fase"). Hace 7 años les hablé acá en eliax de una futura y revolucionaria nuevo tipo de memoria, y de la cual les volví a hablar otras vez hace 3 años en un par de artículos (este y este), que de ser implementada dejaría atrás por mucho a los tradicionales discos duros, al menos en velocidad, y hoy por fin podemos anunciar que tenemos fecha de salida para esa tecnología que ha sido bautizada como PCM (Phase-Change Memory, o "Memoria de Cambio de Fase").La tecnología, desarrollada en conjunto entre científicos de IBM y de la Universidad Patras en Grecia, combina aspectos de memorias tipo NAND (como las utilizadas en memorias USB, SD, o SSD) con memorias tipo DRAM (como las utilizadas en la memoria principal de tu PC, tableta o celular), junto a un nuevo proceso que combina el estado de fase de unos cristales especializados (que me traen recuerdos de los cristales de almacenamiento de La Fortaleza de la Soledad de Superman). Y hablando de Superman, este nuevo tipo de memoria promete crear una nueva generación de almacenamiento SSD (en estado sólido) que funcionarían no 2, o 10, o incluso 100 veces más rápidos que modelos actuales, sino que incluso hasta 275 veces más rápidos según las pruebas con los más recientes prototipos (y ya se está pensando en una versión "2.0" más rápida aun). Este tipo de memoria permitirá toda una nueva generación de aplicaciones que se harán posibles en dispositivos incluso de mano, que contendrán más poder que las más potentes PCs de hoy día. Con esta tecnología por ejemplo, un simple celular con aceleración de video por GPU podría editar varios streams de video UHD/4K en tiempo real sin ningún problema, con velocidad de acceso (escritura y lectura) de sobra. Así mismo, cuando se utilice esto en una nueva generación de servidores de datos, esto aumentará monumentalmente los tiempos de accesos a las bases de datos de aplicaciones distribuidas en Internet, haciendo que incluso los más potentes servidores con múltiples sistemas RAID (sistemas de discos duros redundantes o combinados para aumentar la velocidad) de hoy día sean inmediatamente obsoletos (aunque como siempre, falta ver el precio de las primeras memorias PCM, y el tiempo que tarden estas memorias en bajar a precios más asequibles para todos). Según IBM, empezará a comercializar la tecnología PCM posiblemente en el 2016, lo que es virtualmente a la vuelta de la esquina... fuente autor: josé elías |

|

|

|

|

|

domingo, enero 12, 2014

|

Este fin de semana concluyó el eventual anual (y con duración de casi una semana) CES 2014 (Consumer Electronics Show), un evento en donde asisten miles de empresas para ofrecer lo último en tecnología para consumidores, y en donde se hacen literalmente decenas de miles de anuncios en apenas 5 días, por lo que es un poco difícil distinguir y resaltar entre todo lo mostrado, pero hoy en eliax les hago un super-extracto de lo más notable de CES 2014. Este fin de semana concluyó el eventual anual (y con duración de casi una semana) CES 2014 (Consumer Electronics Show), un evento en donde asisten miles de empresas para ofrecer lo último en tecnología para consumidores, y en donde se hacen literalmente decenas de miles de anuncios en apenas 5 días, por lo que es un poco difícil distinguir y resaltar entre todo lo mostrado, pero hoy en eliax les hago un super-extracto de lo más notable de CES 2014.Así que sin más que decir, entremos a lo interesante: 1. Sony anunció que en el 2013 vendió 4.2 millones de unidades del PlayStation 4, mientras que Microsoft anunció poco tiempo antes que había vendido 3 millones de unidades del Xbox One. Esto va muy alineado a mi predicción #31 para este año 2014... 2. Este fue el año de los anuncios de productos de video con tecnología Ultra-HD 4K (o "UHD", video a 3840 x 2160 pixeles, que es 4 veces superior a HDTV). Se hicieron en CES más de 150 anuncios relacionados a nuevos televisores, grabadores, cámaras, TV por Internet, etc. (leer la predicción #52). 3. Netflix por fin anunció oficialmente, y demostró, Netflix en 4K. 4. De entre las decenas de televisores 4K, el que quizás más impactó por su precio fue el Vizio P-series, un UHD TV de 50" a un precio de US$999 dólares. Así mismo ofrece otros modelos más grandes en la Serie P a distintos precios, llegando hasta el modelo más avanzado y grande de 70" por US$2,600 dólares. 5. Una de las sorpresas del CES 2014 fue que la empresa LG decidió adoptar el difunto sistemas operativo de Palm, Web OS, para utilizarlo en sus televisores, y el trabajo que hicieron desde el punto de vista del interfaz visual fue bastante notable, siendo uno de los mejores de todo el show. Según LG, planea que el 78% de todos sus nuevos televisores vengan con un interfaz basado en Web OS. 6. Tanto LG como Samsung demostraron televisores de gran tamaño con pantallas flexibles. Estas pantallas funcionan tanto en modo "plano" tradicional, como en modo "curvo" via un comando. 7. Dell anunció el monitor para PC/Mac con resolución 4K más barato del mundo, con tamaño de 28" a un precio de US$699 dólares. 8. La empresa estadounidense de TV por cable Comcast anunció que transmitirá parte de los próximos juegos olímpicos en UHD 4K. 9. Se anunciaron varios modelos de impresas 3D, y entre ellas se destacó la CubeJet, que para el sector profesional promete imprimir en varios colores, con calidad de impresoras tridimensionales de un cuarto de millón de dolares, pero a un precio de US$5,000 dólares. 10. En CES 2014 también vimos otra de mis predicciones para el 2014 (la #58) hacerse realidad en forma temprano, al anunciarse la primera impresa 3D disponible comercialmente para consumidores a un precio de menos de US$500 dólares, la Da Vinci 2.0 de la empresa XYZPrinting. 11. Lexar anunció un nuevo tipo de tarjetas de memoria para cámaras digitales en el formato Compact Flash (CF), que utiliza la tecnología CFast 2.0 SATA, permitiendo lecturas de hasta 500MB/s (noten que son 500 MegaBYTES por segundo, o el equivalente a 4000 Megabits por segundo). Sin embargo, todavía no existe una sola cámara en el mercado que pueda funcionar con estas tarjetas (llamadas "3333X"), pero ya veremos soporte posiblemente este mismo año de los grandes fabricantes. Esto será genial para grabar video 4K RAW sin tener que recurrir a almacenamiento SSD o un bajo bitrate de video compromido. 12. Hubo muchos anuncios relacionados con el tema de "Ropa Inteligente" del cual ya llevo unos años hablándoles en eliax. Intel por ejemplo lanzó su Intel Smart Bracelet y su Intel Smart Watch, aunque ofreció pocos detalles de tales productos. Así mismo vimos una nueva versión de popular reloj inteligente Pebble, esta vez bajo el nombre Pebble Steel, que entre todos fue el que más se destacó por ser el más maduro en términos de funcionalidad y estar listo para el mercado. 13. Otra predicción que empezó hacerse realidad fue la #7, en relación a nuevos competidores de gran peso ante el Google Glass. Entre los que anunciaron sistemas similares al Glass se destacaron Intel con su sistema Jarvis (que utiliza audio y reconocimiento de voz por sobre tecnología visual), y Epson con sus gafas inteligentes Moverio. 14. Otra de las grandes sorpresas fue el anuncio de Sony sobre el PlayStation Now, un servicio que se esperaba que permitiría que uno utilice el PlayStation Vita o el PlayStation 4 para jugar juegos del PlayStation 3 de forma remota por Internet, pero la gran sorpresa es que la empresa anunció a PlayStation Now para celulares, tabletas y televisores. El único requerimiento es tener un control de juego/mando DualShock, pero aparte de eso en teoría esto funcionaría con cualquier celular y tableta (o TV) en donde Sony implemente su software de juegos remotos Now. 15. Finalmente, lo que quizás más impactó y nos acercó un poco más al futuro fue la demostración de la nueva versión del visor de realidad virtual Oculus Rift (del cual escribí un editorial reciente acá mismo en eliax), en su modelo "Crystal Cove", que dejó impactado a muchos con sus gráficos más realistas, mejores pantallas estereoscópicas, la eliminación de casi todo el efecto "fantasma" (ghosting) de la imagen, un aun mejor tiempo de respuesta, y un campo de visual ampliado. Esto a propósito va de mano con mi predicción #15 para este año... Y ese es mi extracto personal. Ojo, que como dije, hubo miles de anuncios, muchos de ellos interesantes, y quizás uno que otro de relativa importancia se me haya escapado, pero al menos esto fue lo que más me llamó la atención como relevante a largo plazo... Nota: Si quieren agregar a la lista de sus cosas favoritas que vieron en CES 2014, no duden en utilizar los comentarios acá abajo para compartir sus puntos de vista :) autor: josé elías |

|

|

|

|

|

viernes, enero 3, 2014

|

Dicen que a veces son los pequeños detalles que importan, y si hay una empresa que se especializa en pequeños detalles que posteriormente son copiados por la competencia, es Apple, y uno de sus pequeños detalles que más me gustan son parte de las dos recientes generaciones de sus dispositivos, y es el conector Lightning. Dicen que a veces son los pequeños detalles que importan, y si hay una empresa que se especializa en pequeños detalles que posteriormente son copiados por la competencia, es Apple, y uno de sus pequeños detalles que más me gustan son parte de las dos recientes generaciones de sus dispositivos, y es el conector Lightning.¿Qué tiene de especial este conector? Pues aparte de ser super rápido para transferencia de datos, y de servir como cargador eléctrico (en ambas instancias, de forma similar a lo más reciente de los cables USB 3.1 de próxima generación), una de las cosas más prácticas que tiene este conector/cable Lightning es que es reversible. ¿Qué significa eso? Significa que lo puedes conectar de cualquier forma, y funciona igual. Es decir, no tiene ni una manera "derecha" o "boca abajo", ya que lo insertes de una forma u otra, funciona siempre. Eso no se imaginan lo que nos facilita la vida, ya que por ejemplo cuando es de noche y uno quiere conectar su iPhone o iPad para recargar, uno simplemente tomar en conector en total oscuridad, lo inserta, y listo, eso a diferencia de mi otro celular, un Nexus de Google que utiliza el conector micro-USB, para el cual debo encender la luz o adivinar como si fuera mago para ver si lo conecto en la orientación correcta… Y la buena noticia de hoy es que el consorcio que especifica los conectores y cables USB anunció recientemente que esa misma modalidad de cables reversibles al estilo Lightning, llegará a los mini-conectores y cables USB de próxima generación (basados en la especificación USB 3.1), y será llamado "USB Type-C" (técnicamente al menos, ya veremos si eligen un nombre más amigable a consumidores eventualmente). Se espera que los conectores y cables USB Tipo C lleguen posiblemente este mismo año 2014, pues a inicios de año se espera llegar a acuerdos entre los miembros del consorcio, y se espera tener la especificación final para mediados de año, por lo que es bastante posible que para estas navidades o antes veamos los primeros dispositivos Android con esta utilísima tecnología. nota de prensa oficial (documento PDF) autor: josé elías |

|

|

|

|

|

martes, diciembre 24, 2013

|

Alan Turing está en la lista de las personas que más admiro en la vida, debido a su invaluable contribución a la humanidad. Alan Turing está en la lista de las personas que más admiro en la vida, debido a su invaluable contribución a la humanidad.Para empezar, este es el padre de la arquitectura que utiliza virtualmente el 100% de todas las computadoras digitales modernas, y de paso fue el principal responsable de romper el código de cifrado de las máquinas Enigma de Hitler, que según muchos fue lo que más directamente permitió que los Aliados ganaran la guerra contra los Nazis. Incluso hoy día cuando se habla de una "Máquina Universal Turing" (es decir, una máquina totalmente programable digitalmente), o del "Turing Test" (una prueba con el objetivo de saber si una máquina que alegue ser inteligente realmente lo sea), en realidad se habla de mecanismos delineados por Alan Turing y de ahí que hereden parte de su nombre. Sin embargo, nació homosexual, y cuando se descubrió públicamente el hecho, y aun habiendo contribuido tanto a la humanidad, su propio gobierno del Reino Unido lo condenó a "castración química", lo que conllevó a que se le inyectaran en contra de su voluntad todo tipo de inyecciones y hormonas que al final tuvieron como resultado que quedara sexualmente impotente, entre otros efectos secundarios que modificaron su físico. Fue tanta su humillación, frustración e impotencia psicológica, que finalmente terminó suicidándose, bajo la sombra de lo que en mi opinión fue una de las injusticias más grande del siglo pasado. Y ahora, 59 años después, y después de mucha insistencia de muchos pioneros en computación, miembros de la comunidad gay, y defensores de los derechos humanos, el gobierno inglés ha decidido darle "un perdón de la realeza" (fuente). Lástima que tal perdón para nada sirve hoy más que para recordarnos del hecho vergonzoso y penoso, y del sufrimiento que por lo general ha conllevado a través de la historia a aquellos que no siguen las tendencias sociales de su época... autor: josé elías |

|

|

|

|

|

domingo, diciembre 22, 2013

|

|

Hoy los dejo con una dosis de BREVES en eliax...

El presupuesto de mercadeo y publicidad de Samsung en el 2012  ¿Saben cuánto dinero invirtió Samsung en mercadeo y publicidad en el 2012 a nivel mundial? Pues lo crean o no, US$14 Mil Millones de dólares, lo que es más del doble del presupuesto combinado de Apple y Microsoft para tal fin este mismo año... ¿Saben cuánto dinero invirtió Samsung en mercadeo y publicidad en el 2012 a nivel mundial? Pues lo crean o no, US$14 Mil Millones de dólares, lo que es más del doble del presupuesto combinado de Apple y Microsoft para tal fin este mismo año...fuente La subida y bajada de BlackBerry en una gráfica  ¿Quieren una versión resumida de la historia de BlackBerry en una sola gráfica? Pues visiten el siguiente enlace que les muestra los ingresos de la empresa cada año desde el 2001 hasta el día de hoy... ¿Quieren una versión resumida de la historia de BlackBerry en una sola gráfica? Pues visiten el siguiente enlace que les muestra los ingresos de la empresa cada año desde el 2001 hasta el día de hoy...enlace a la gráfica Y en nota relacionada, Blackberry reportó pérdidas en este cuatrimestre que acaba de pasar de US$4 mil 400 Millones de dólares (US$4400000000), lo que es incluso peor de lo que se esperaba de la empresa (fuente oficial, en PDF). Publicidad en Google  ¿Quieren una gráfica que les muestre cuanto dinero le genera cada usuario en publicidad anualmente a Google, en comparación con LinkedIn, Facebook, YouTube, Line y Twitter? ¿Quieren una gráfica que les muestre cuanto dinero le genera cada usuario en publicidad anualmente a Google, en comparación con LinkedIn, Facebook, YouTube, Line y Twitter?Pues acá está la gráfica Ojo, que eso no representa el total que obtienen estas empresa en publicidad, sino cuanto dinero obtiene por cada usuario. Esto es importante entenderlo ya que aunque en la gráfica LinkedIn obtiene más dinero por usuario que Facebook, Facebook tiene al menos 10 veces más usuarios que LinkedIn, por lo que en la realidad LinkedIn tiene ingresos insignificantes en relación en Facebook. Intel y chips de 18 núcleos  Según reportes, Intel planea mantener el negocio de la PC y Servidores competitivo diferenciándose con el tema del poder de procesamiento crudo, y para tal fin planea lanzar procesadores con hasta 18 núcleos a más tardar en el 2015 (aunque para entonces el negocio de la PC es posible que haya caído un 15% más de lo que ha caído en estos dos últimos años gracias al fenómeno iPad y el mercado que esta creó para tabletas Android y Kindle de Amazon). Según reportes, Intel planea mantener el negocio de la PC y Servidores competitivo diferenciándose con el tema del poder de procesamiento crudo, y para tal fin planea lanzar procesadores con hasta 18 núcleos a más tardar en el 2015 (aunque para entonces el negocio de la PC es posible que haya caído un 15% más de lo que ha caído en estos dos últimos años gracias al fenómeno iPad y el mercado que esta creó para tabletas Android y Kindle de Amazon).Estos procesadores sería construidos con tecnología de 14nm (lean sobre ¨nm" acá mismo en eliax), por lo que no solo serán más rápidos por tema de paralelismo de núcleos, sino por velocidad cruda por núcleo. fuente del reporte Nota: No se sorprendan por esos 18 núcleos. Como ya les había reportado hace más de 7 años acá mismo en eliax, Intel ya había demostrado en el 2006 prototipos de chips con 80 núcleos. autor: josé elías |

|

|

|

|

|

miércoles, diciembre 18, 2013

|

¿Recuerdan la revolucionaria tecnología iBeacons de Apple de la cual les hablé hace un tiempo atrás en eliax? Pues la empresa Qualcomm cree que tiene futuro, y ha decidido lanzar sus propios beacons ("faros") que serán compatibles con la tecnología iBeacon de Apple, y en un futuro con extensiones opcionales por parte de terceros para Android. ¿Recuerdan la revolucionaria tecnología iBeacons de Apple de la cual les hablé hace un tiempo atrás en eliax? Pues la empresa Qualcomm cree que tiene futuro, y ha decidido lanzar sus propios beacons ("faros") que serán compatibles con la tecnología iBeacon de Apple, y en un futuro con extensiones opcionales por parte de terceros para Android.Para los que no sepan (aunque recomiendo leer mi artículo anterior al respecto), iBeacon es una tecnología de relativo corto alcance que permite que dispositivos móviles detecten estos "faros", y puedan tomar acción al respecto. Un iBeacon por ejemplo podría instalarse en la entrada de un restaurante, y darle la bienvenida a los clientes al momento de entrar. Otro podría colocarse en la vitrina que de hacia la calle para que los potenciales clientes que pasen vean el menú en sus celulares antes de entrar, mientras que varios otros faros podrían colocarse en cada una de las mesas del restaurante, y que permitiría saber al sistema informático del restaurante exactamente en cuál mesa está sentado cada cliente (para pedir la cuenta, ordenar, etc). Y obviamente, este es un solo ejemplo, y recomiendo una vez más leer mi artículo anterior para un vistazo a lo que nos espera con esta tecnología... En cuanto a Qualcomm, planea tener dos familias de estos faros, y lo mejor de todo es que serán a un precio muy bajo. La familia Gimbal Series 10 costarán apenas US$5 dólares por faro, mientras que la Gimbal Series 20 costarán US$10 por faro. La diferencia entre la Serie 10 y 20 es que la 20 está protegida contra los elementos y pueden utilizarse en exteriores. Ambas familias utilizan una batería con una vida útil de 1 a 3 años. página oficial de Gimbal página informativa de Gimbal en Qualcomm nota de prensa oficial autor: josé elías |

|

|

|

|

|

miércoles, noviembre 27, 2013

|

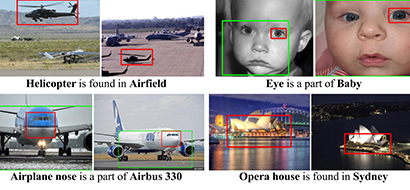

La Universidad de Carnegie Mellon en los EEUU acaba de dar un gran paso en el campo de la Inteligencia Artificial (IA) al haber desarrollado un sistema al que llama el Never Ending Image Learner (NEIL, que en español sería algo como el "Aprendiz Interminable de Imágenes"), que según sus investigadores ha aprendido por sí mismo el concepto del "sentido común", cuando menos en lo que a reconocer imágenes se refiere por ahora... La Universidad de Carnegie Mellon en los EEUU acaba de dar un gran paso en el campo de la Inteligencia Artificial (IA) al haber desarrollado un sistema al que llama el Never Ending Image Learner (NEIL, que en español sería algo como el "Aprendiz Interminable de Imágenes"), que según sus investigadores ha aprendido por sí mismo el concepto del "sentido común", cuando menos en lo que a reconocer imágenes se refiere por ahora...Lo que NEIL ha logrado aprender por sí solo es el entender las conexiones que hacemos los humanos para asociar distintos tipos de imágenes diferentes dentro de un mismo grupo, en esencia buscando el sentido común que varias imágenes comparten. NEIL es un sistema de IA con 200 núcleos que funciona 24 horas al día, los 365 días del año, y lo único que hace es navegar el Internet por su cuenta, buscar imágenes, y tratar de hacer todo tipo de conexiones entre ellas. Entre las cosas que NEIL ha aprendido por su cuenta (y que son cosas que los humanos clasificamos como "sentido común") están que los edificios son por lo general altos, o que los patos son animales parecidos a los gansos. Pero tan asombroso como eso, es que uno puede visitar la página web del proyecto NEIL, y ver en tiempo real las últimas cosas que NEIL está aprendiendo por su cuenta, y debo decirles que es verdaderamente asombroso lo que he visto en esa página, ya que aunque son cosas que incluso para un niño son "obvias", no son cosas que uno esperaría de "una máquina". Me refiero a que literalmente está aprendiendo el concepto del sentido común en las cosas, y más asombroso aun, que ha expandido su dominio de las cosas a temas que no son estrictamente visuales (aunque sí las aprendió visualmente), como el hecho de haber aprendido por sí sola que los autos tienen ruedas (una vez más, algo obvio para nosotros, pero que nadie le enseño previamente a NEIL). Noten que aparte de ver lo que NEIL está aprendiendo en determinado momento, que puedan además entrenar a NEIL en cosas nuevas si lo desean, así como ver "el interior de su mente", que los desarrolladores de NEIL llaman "escenas", viendo ustedes las asociaciones que NEIL ha hecho previamente para descubrir nuevos conceptos. Noten que esta noticia se las traigo apenas días después de hablarles de la IA de Google acá mismo en eliax, testamento a lo rápido que estamos avanzando en el área de la Inteligencia Artificial en estos días... página oficial de NEIL nota de prensa oficial autor: josé elías |

|

|

|

|

|

martes, noviembre 5, 2013

|

Recientemente Google anunció su esperado celular Google Nexus 5, el sucesor del Nexus 4, y una vez más, es mi opinión que este es el mejor celular Android que puedan comprar a ese precio. Recientemente Google anunció su esperado celular Google Nexus 5, el sucesor del Nexus 4, y una vez más, es mi opinión que este es el mejor celular Android que puedan comprar a ese precio.Sin embargo, es bueno entender que similar a lo que ocurre con iPhones (o cualquier otro celular Android, como los de Samsung particularmente), en donde cada generación es por lo general una mejora sobre la versión anterior y no toda una revolución, que el Nexus 5 no es una excepción a la regla, pues este no es más que una mejora sobre el Nexus 4, y no nada revolucionario. A tal fin, hoy quiero compartirles una lista "lado a lado" que compara el Nexus 4 vs el Nexus 5, para que así tengan una mejor idea de lo que obtienen por su dinero.. Fabricante Nexus 4: LG Nexus 5: LG Pantalla Nexus 4: 4.70" IPS, 1280 x 768 pixeles, 318 ppi , Corning Gorilla Glass 2 Nexus 5: 4.95" IPS, 1920 x 1080 pixeles, 445 ppi, Corning Gorilla Glass 3 Noten que la pantalla del Nexus 5 es de mayor tamaño, y de mayor resolución, pero en la práctica les será difícil diferenciar la resolución de ambos a una distancia prudente, al menos que busquen una lupa. Android Nexus 4: v4.3 Jelly Bean Nexus 5: v4.4 Kit Kat Noten que Android 4.4 KitKat estará disponible también para el Nexus 4 como una actualización en las próximas semanas, por lo que no será algo exclusivo del Nexus 5. Procesador Nexus 4: Qualcomm Snapdragon S4 Pro, 4 núcleos a 1.5GHz Nexus 5: Qualcomm Snapdragon 800, 4 núcleos a 2.3GHz GPU (gráficos) Nexus 4: Adreno 320, 400MHz Nexus 5: Adreno 330, 450MHz Memoria (RAM) Nexus 4: 2GB Nexus 5: 2GB Almacenamiento Nexus 4: 16GB, 8GB Nexus 5: 32GB, 16GB Cámara Nexus 4: Delante: 1.3 MP. Atrás: 8.0 MP con flash LED Nexus 5: Delante: 1.3 MP. Atrás: 8.0 MP con flash LED + estabilización óptica de imagen Noten que salvo la estabilización óptica, la cámara del Nexus 5 no se espera que sea una mejora notable sobre la cámara del Nexus 4, la cual no era una cámara muy buena que digamos (al menos no comparada contra los últimos modelos de HTC, Samsung y Apple), por lo que quizás el único aspecto que no sea "de lo mejor" en el Nexus 5 sea su cámara, pero esperemos a ver las primeras pruebas de fotos tomadas con el nuevo equipo antes de dar estas conclusiones por dadas... Batería Nexus 4: 2100 mAh. Hablando solamente: Hasta 11 horas Nexus 5: 2,300mAh. Hablando solamente: Hasta 17 horas Noten que aunque la batería del Nexus 5 no es muy superior a la del Nexus 4, que el 5 tiene componentes que son más eficientes energéticamente, y de ahí la gran diferencia en horas. Aunque ojo: (1) Esas son 17 horas si solo utilizas el celular para hablar, no para navegar, y mantienes el WiFi y Bluetooth apagado, y no utilizas el 4G. Y (2), en el momento que Android 4.4 llegue al Nexus 4, este también gozará de una ligera mejora en la batería debido a optimizaciones en Kit Kat. Redes celulares Nexus 4: 3G Nexus 5: 3G, 4G/LTE WiFi y otros Nexus 4: NFC , Bluetooth v4.0, Wi-Fi 802.11 a/b/g/n Nexus 5: NFC , Bluetooth v4.0, Wi-Fi 802.11 a/b/g/n/ac, WiFi doble banda (2.4 GHz y 5 GHz) En la práctica, el incremento en velocidad WiFi no será notado para la vasta mayoría de usuarios, ya que por lo general incluso las velocidades de WiFi tipo "g" son superiores a la velocidad de Internet hacia tu casa o local comercial. Dimensiones Nexus 4: 133.90 x 68.70 x 9.10 mm Nexus 5: 137.84 x 69.70 x 8.59 mm Noten que el Nexus 5 es un poco más grande, para acomodar la nueva pantalla. Peso Nexus 4: 139 g Nexus 5: 130 g Asombrosamente, el Nexus 5 peso menos que el Nexus 4, el cual ya era un celular que pesaba bastante poco. Precio de salida al mercado Nexus 4: US$349 por 16GB, US$299 por 8GB Nexus 5: US$399 por 32GB, US$349 por 16GB Noten que esos son precios de cuando ambos celulares salieron al mercado. Es obvio que el precio del Nexus 4 ahora bajará en relación al Nexus 5 (y obviamente, Google ya dejó de fabricar el Nexus 4 a favor del Nexus 5). Ahora, hablemos de lo que no vemos en esas especificaciones técnicas... Una cosa que Apple la he enseñado a la industria, es que uno no debe llevarse mucho de numeritos en papel si la comparación no se hace en un ambiente en donde todo sea casi idéntico. Por ejemplo, si nos llevamos de puras especificaciones sobre el papel, un iPhone 4S de dos años atrás aparentaría una chatarra en comparación a los más potentes celulares Android de hoy día, pero cualquiera que tiene un iPhone 4S sabe bastante bien que se siente y comporta muchísimo más fluido que la basta mayoría de celulares Android que surgieron incluso dos años después, eso debido a que en el ecosistema de iOS, Apple controla todo, desde el hardware (incluyendo su propio diseño de microprocesador) hasta el software, así como tiene un número limitado de dispositivos en donde ejecutar iOS, lo que le permite optimizar específicamente para esos dispositivos, ofreciendo una experiencia superior. Similarmente, si comparamos el recién anunciado Nexus 5 contra los otros celulares Android, es bastante posible que lo tilden como "un celular más del montón", pero dista mucho de eso... Para empezar, algo que no se ve sobre numeritos en el papel es el hecho de que este celular incluye circuitos especializados diseñados para estar escuchando constantemente al usuario, y en particular para detectar la frase "Okey Google". Con el Nexus 5, incluso si este está con la pantalla apagada al lado tuyo , e incluso sin tu tocarlo, con tu solo decir "OK Google" este despierta directamente en su buscador integrado con Google Now, listo para escuchar tus comandos de voz. Eso significa que si estás recostado en la cama con tu Nexus 5 al lado, y de pronto tienes la necesidad o el deseo de saber el clima/tiempo en algún lugar, simplemente tienes que decir algo como "okey google, cual es el clima en new york" y este despertará, captará lo que dijiste, y te responderá inmediatamente con una voz sintética, sin tu levantar las manos o incluso moverte de la cama. Aunque ojo, el Nexus 5 tiene que tener la pantalla activada para que esto funcione. Eso, es genial y novedoso, y se hace posible debido a sensores dedicados del Nexus 5. Noten que esta funcionalidad se podría implementar en teoría en cualquier otro celular del mercado, pero la batería se le acabaría en pocos minutos al celular estar constantemente escuchando y procesando todo el sonido de su entorno en su CPU principal, razón por la cual esta funcionalidad solo está disponible en el Nexus 5 y en otros celulares Android que implementen estos circuitos dedicados ahora y en el futuro (ojo, el recientemente anunciado Moto X de Motorola/Google también posee esta funcionalidad). Noten que esto es muy similar al co-procesador M7 del iPhone 5S (y iPad Air y iPad mini Retina) que le permite obtener lecturas de sensores (giroscopio, acelerómetro, compás, etc) constantemente en tiempo real, sin impactar la batería. Así mismo otra de las grandes ventajas del Nexus 5 es una que vienen gozando todos los celulares oficiales de Google: Este está garantizado a tener futuras actualizaciones disponibles de Android, razón por la cual es el celular Android que más recomiendo (por eso mismo tengo un Nexus 4 y no un HTC One conmigo, junto a mi iPhone). Aparte de eso, noten que la integración que Google y LG han logrado con el Nexus 5 y su hardware ha sido de primera, siendo este celular junto al Sony Xperia Z1 lo dos celulares más rápidos en temas de procesamiento bruto y videojuegos en Android, siendo estos superados únicamente por el iPhone 5S y su potentísimo PowerVR G6430 GPU y su CPU A7 diseñado por la misma Apple (como pueden ver en esta comparación técnica, y noten que en esa comparación solo tenían acceso al iPhone 5S, aun no han actualizado a las nuevas iPads con sus potentes procesadores). Pero lo verdaderamente mejor de todo quizás sea el precio. Por US$350 dólares para el modelo de 16GB, totalmente desbloqueado y libre de contratos y con capacidad para funcionar en prácticamente cualquier red 3G y 4G/LTE del mundo, este es sin la menor pizca de duda, el mejor celular por tu dinero en el campamento Android, y dado el precio, no dudaría que esto haga pensar a unos cuantos sobre pagar el premium que Apple demanda por su iPhone 5S. Ojo, y lo aclaro nuevamente como varias veces lo he hecho acá en eliax: Desde el punto de vista del usuario final, si tuviese que recomendar un celular, y el dinero no fuera objeción, aun recomiendo un iPhone 5S o 5C, pues al menos para mis necesidades personales (y no olviden eso, las mías, no necesariamente la de ustedes) este es el celular de más elegante uso, de más fácil uso, y que menos problemas da, pero para los que prefieran el campamento Android y su ecosistema más liberado y con más opciones de personalización, el Nexus 5 es lo mejor que pueden comprar ahora mismo al costo que lo vende Google. página oficial del Nexus 5 autor: josé elías |

|

|

|

|

|

lunes, noviembre 4, 2013

|