Tecnología Visual

|

sábado, agosto 23, 2008

|

|

A continuación les mostramos este video de una nueva aplicación de demostración para el iPhone llamada iHologram, la cual crea lo que aparenta es un holograma flotando sobre el iPhone.

Obviamente todo es una ilusión óptica, en donde el truco está en utilizar el acelerómetro del iPhone para saber en qué dirección lo están girando y dibujar las gráficas tridimensionales acorde a un punto de vista fijo. No dejen de ver el video que les intrigará. Esto sería sensacional en un video-juego que tome ventaja de este truco... Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, agosto 22, 2008

|

Microsoft por fin sacó la versión final de Photosynth al aire, y de manera gratuita para todos. Para el que no sepa, Photosynth es posiblemente la tecnología de navegación de fotografías mas avanzada del momento (y señal de que aun quedan unos cuantos visionarios dentro de Microsoft), que te permite navegar de manera "casi-3D" un entorno al cual se le haya tomado varias fotografías desde diferentes ángulos y distancias, sin importar quien, cuando o con qué cámara hayan tomado las fotos. Microsoft por fin sacó la versión final de Photosynth al aire, y de manera gratuita para todos. Para el que no sepa, Photosynth es posiblemente la tecnología de navegación de fotografías mas avanzada del momento (y señal de que aun quedan unos cuantos visionarios dentro de Microsoft), que te permite navegar de manera "casi-3D" un entorno al cual se le haya tomado varias fotografías desde diferentes ángulos y distancias, sin importar quien, cuando o con qué cámara hayan tomado las fotos.Es una de esas cosas que hay que ver en funcionamiento para creer y entender (en los enlaces anteriores de eliax acá abajo puedes ver videos de esta tecnología en acción). Con esta primera versión puedes subir tus fotos y Photosynth te crea un "synth" (entorno 3D de Photosynth) para que las navegues. Nota que por ahora todas las fotos y synths son compartidas con todo el mundo, sin embargo algo interesante de esta tecnología es que mientras mas foto tiene de un lugar, mayor su grado de exactitud al crear los entornos virtuales. Photosynth acaba de salir esta noche y está disponible por el momento solo para Windows, pero soportando tanto a Internet Explorer como a Firefox (en ambos requiere la instalación de una extensión/plugin especial). Una versión para el Mac OS X está en desarrollo. Muy recomendado que lo pruebes (aunque recomiendo una conexión de banda ancha a Internet para disfrutar mejor de esta tecnología). Página oficial de Photosynth Previamente en eliax: Asombroso video demostrando a Photosynth (Junio 2007) Increíble video del sucesor de Photosynth (Agosto 2008) autor: josé elías |

|

|

|

|

|

miércoles, agosto 20, 2008

|

No bien nos enteramos de tecnología que nos permitirá crear imágenes con detalles sin precedentes en tiempo real por Internet, cuando sale ahora NVIDIA y demuestra una tecnología que permite crear gráficos con técnicas de raytracing, en tiempo real y en alta definición, utilizando su última generación de GPU (Graphic Processing Units), en tu PC de escritorio. No bien nos enteramos de tecnología que nos permitirá crear imágenes con detalles sin precedentes en tiempo real por Internet, cuando sale ahora NVIDIA y demuestra una tecnología que permite crear gráficos con técnicas de raytracing, en tiempo real y en alta definición, utilizando su última generación de GPU (Graphic Processing Units), en tu PC de escritorio.Para que tengan una idea de lo que estamos hablando, y por qué esto es sorprendente, les explico brevemente lo que es raytracing, y lo que es scanline rendering. Primero, todos los video-juegos que utilizan gráficos de 3D, sea en una PC, un Nintendo Wii, una Xbox 360, un Sony PSP o PlayStation 3, utilizan la técnica de scanline rendering. Lo que esa técnica hace (a altos rasgos) es determinar la posición de la geometría de los objetos en el espacio, determinar dónde hay fuentes de luces, y determinar los colores, propiedades y texturas de las superficies de tales objetos, y calcular en base a complejos algoritmos como se "debería" ver una determinada superficie tridimensional en pantalla. Es decir, el cálculo para "renderizar" un cubo sobre una superficie plana va mas o menos así: "El ángulo de la cara izquierda del cubo está a 45 grados en relación a la cámara por la cual se ve el video-juego, y como hay una luz del otro lado eso significa que esa cara del cubo debe ser un poco oscura, por tanto, pintemos esa cara del cubo de color azul oscuro." En otras palabras, scanline rendering (o rasterizing), es una técnica de deducción, y aunque puede ofrecer excelentes resultados, no es muy precisa ya que no simula "la realidad". Raytracing, sin embargo, es una técnica mucho mas sencilla y fácil de implementar que scanline rendering, ya que de la manera que funciona es como una "cámara digital inversa". Notemos que una cámara digital lo que hace es captar rayos de luz del mundo exterior, sobre un sensor de dos dimensiones (digamos, de 1920 x 1080 pixeles), asignándole a cada puntito en el sensor un valor que indica el nivel de intensidad (y color) de la luz que calló en ese punto. Al combinar todos los puntos obtenemos una imagen. Raytracing hace lo mismo que una cámara digital, pero al revés. En esta técnica, nosotros creamos una "sensor virtual" cuyas dimensiones sean las mismas que la pantalla en donde pensamos desplegar la imagen tridimensional (digamos, un monitor con resolución de 1920 x 1080 pixeles), y lo que hacemos ahora es que simulamos un rayo de luz, no entrando al sensor, sino que saliendo de este hacia el mundo exterior (que en este caso es un cubo sobre una superficie plana), y "midiendo" el rayo de luz mientras este interactúa con los objetos de la escena, la idea siendo que después de que ese rayo de luz emitido por el sensor virtual haya llegado lo suficientemente lejos, que podremos determinar el valor del punto (o pixel) en el lugar desde donde salió el rayo de luz virtual. Es decir, en vez de recibir luz en un sensor (como en una cámara digital), lo que hacemos es emitir luz "blanca", y en base a donde "rebote" ese haz de luz (digamos que la superficie del cubo es de color azul), determinar cual es el color real de ese punto en el sensor (que en este caso hemos determinado no es blanco, sino azul). Esto tiene como resultado que estamos simulando la realidad "al revés", pero simulándola de todas maneras, por lo que podemos obtener resultados verdaderamente asombrosos y realistas. Esta es la técnica que se utiliza en el cine cuando se necesita el mas alto grado de realidad en la pantalla. Siguiendo el ejemplo anterior, la computación en este caso iría algo así: "Acabo de disparar un haz de luz blanca pura desde el pixel con coordenadas 100,580 de la pantalla y voy a ver hacia donde va. Oh, acabo de chocar contra algo (la pared del cubo), ¿cuáles son las propiedades de este objeto en este lugar? ¿cómo desviaría este haz de luz? ¿cómo afectaría su color? Oh, terminaría siendo un color azul. Ahora desviar el rayo de luz unos 193 grados y con menor intensidad X, ya que la superficie es un poco reflectiva, y repetir el proceso unas vez mas, siguiendo el rayo hasta que rebote 10 veces mas y obtener el color final para este pixel." Ahora, los que aun estén leyendo esta explicación dirán, ¿y por qué no utilizar esta técnica en vez de la otra? Por la sencilla razón que es demasiado demandante en poder de computación, ya que por cada punto del "sensor virtual", hay que disparar un rayo de luz virtual, y seguirlo, mientras este rebota, se modifica, se atenúa, etc por toda la escena, y después hacerlo con todos los otros pixeles virtuales. Para que tengan una idea, con un sensor virtual de 1920 x 1080 (que es "full" alta definición en Blu-ray), hablamos de repetir este proceso 2,073,600 veces, y no solo eso, sino que hay que hacer estos cálculos unas 30 veces mas en un solo segundo para lograr video en movimiento. O aproximadamente 60 millones de rayos de luz por segundo, cada uno sumamente demandante en cálculos matemáticos. Es esta la razón por la cual, hasta ahora, las películas de Hollywood que dependen de muchos efectos especiales con raytracing se ejecutan en miles de máquinas en paralelo, las cuales toman tan solo un cuadro de la película, y lo renderizan en cuestión de minutos o hasta horas (a veces días), y después todos estos cuadros son ensamblados en secuencia para formar la película. Habiendo dicho eso, noten ahora el significado de esta noticia: NVIDIA acaba de demostrar que puede hacer raytracing con video de alta definición, en tiempo real a 30 cuadros por segundo, suficiente para uno renderizar el mundo entero de un video-juego mientras uno lo juega. Por ahora la calidad no será igual que la de Hollywood, pero conforme aumenta el poder de computación la calidad continuará incrementando. Noten que en raytracing, aparte de la calidad del algoritmo que calcula cómo es afectado un pixel virtual conforme la luz interactúa con el medio ambiente virtual, saltando de una superficie a otra como si de espejos se tratara, que la otra gran variable que determina la calidad visual de una escena renderizada con raytracing es precisamente cuántas veces uno permite que un rayo de luz "salte" de un lado a otro en la escena, ya que mientras mas saltos y reflejos da ese haz de luz, con mas exactitud se puede calcular el valor final del pixel virtual. Noten que Intel es un gran proponente de raytracing, y dice que sus futuros diseños de chips serán optimizados para acelerar la renderización tridimensional con esta técnica. Reseña curiosa: Hace unos 15 años atrás, con una computadora Commodore Amiga 500, renderizar una escena medio compleja por medio de raytracing me tomaba hasta un día entero (sí, 24 horas, o hasta mas). Hoy día esa misma escena se renderiza en unos segundos, y con esta tecnología de NVIDIA se renderiza en "tiempo real". ¡Como cambian los tiempos y el poder de computación! Fuente de la foto (tienen mas fotos) con mas información Previamente en eliax: Renderización de gráficos en tiempo real desde el Internet (Agosto 2008) autor: josé elías |

|

|

|

|

|

martes, agosto 19, 2008

|

|

A continuación los dejamos con un video que los dejará atónitos. Es sobre "Emily", una mujer que verán en el video hablando sobre gráficos por computadora. Lo impresionante del video es que Emily no es una persona real, ni fue basada en una persona real, sino que fue desarrollada y animada completamente en un entorno sintético con las mas avanzadas gráficas "3D" de la industria.

La animación fue creada por Image Metrics, y desde ya está siendo considerada como la primera actuación virtual verdaderamente convincente jamás creada. Noten que hasta ahora la única manera de obtener este grado de realismo era capturando digitalmente las actuaciones de actores reales (como Golum en El Señor de los Anilos, o los personas en Beoworlf), pero esto marca la primera vez que por fin podemos crear actores verdaderamente digitales. Hasta ahora el gran problema era que mientras mas parecido a humanos uno hacía los actores, mas "muertos" aparentaban. Como ejemplo, los personajes de una película como Monsters Inc. aparentan mucho mas "realistas" que los de Final Fantasy The Spirit Within, aun los primeros sean "muñequitos" y los segundos sean "personas". Con este nuevo software ahora se puede emular las pequeñas idiosincrasias y diminutos detalles que nos dan pistas a los humanos de que estamos viendo a una persona. Cosas como pequeños movimientos de músculos, o ver de un lado a otro, o respirar, o la velocidad y ritmo de los movimientos, etc. Así que prepárense, porque combinando esto con tecnología como esta o esta otra, llegará el tiempo en donde será difícil juzgar si un actor es real o sintético. Fuente de la noticia Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

lunes, agosto 18, 2008

|

|

A continuación les presento la investigación realizada por unos científicos de la Universidad de Washington en los EEUU que es capaz de mejorar o modificar sustancialmente un video, en base a varias tomas fotográficas del mismo lugar que fue grabado.

Lo que esta técnica logra es bastante asombroso, y espero vean el video para que entiendan mejor el concepto. La idea es tomar la alta resolución de fotos digitales, deducir su información espacial (es decir, que tan cerca o lejos están los objetos en la foto), y hacer lo mismo con el video. Después el próximo paso es saber cuáles elementos de las fotos corresponden a los del video, y super-imponer las fotos sobre el video, pero tomando en consideración aspectos como la exposición de la foto y el video, la profundidad de campo, la dirección de la toma, etc. El resultado es que uno puedo tomar un simple video casero de muy mala calidad, y combinarlo con unas cuantas fotografías, y terminar con un video de alta definición. Otra cosa interesante es que dado la técnica utilizada, el mismo sistema se puede utilizar para reemplazar, borrar o añadir objetos al video, y hacerlo de tal manera que todo aparente perfectamente natural. Inclusive este software permite crear videos con alto rango dinámico de luz ("HDR" o High Dynamic Range), así como permite estabilizar video que haya sido grabado con "temblores". Este proyecto, si lo entienden bien, fuera un complemento ideal para este otro (Photosynth), y creo que deberían combinarlo y llamarlo "VideoSynth", pues lo que hacen es bastante similar, solo que uno lo hace con imágenes estáticas, y el otro con video. Fuente de la noticia Previamente en eliax: Increíble video del sucesor de Photosynth Video a continuación... autor: josé elías |

|

|

|

|

|

viernes, agosto 15, 2008

|

|

¿Se acuerdan del proyecto Photosynth desarrollado por la Universidad de Washington y Microsoft del cual les hablamos hace poco mas de un año atrás? Pues si creyeron que eso era asombroso, se sorprenderán aun mas al ver cómo ha evolucionado ese software de visualización en tan solo un año.

Lo que este software hace es que toma millones de fotos tomadas por todo tipo de personas, en diferentes tiempos y con diferentes tipos de cámaras y en diferentes calidades, pero tomadas de un mismo lugar (como por ejemplo, La Estatua de la Libertad), y lo que hace es que infiere automáticamente el espacio tridimensional original de entre todas las fotografías, combinando todas las fotos para entre todas ellas crear un espacio por el cual te puedes desplazar como si estuvieras en ese lugar viendo La Estatua de la Libertad desde todo ángulo imaginable. Esta es una tecnología que espero se haga disponible eventualmente en todo tipo de portales de fotos como Flickr, o como una herramienta para extender las vistas en herramientas como Google Earth. Esta es una tecnología que hay que ver en video para apreciarla. Créanme que quedarán sorprendidos. Esta tecnología acaba de ser presentada en el evento SIGGRAPH 2008 actualmente en curso. Página oficial del proyecto Previamente en eliax: Asombroso video demostrando a Photosynth (Junio 2007) Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, agosto 13, 2008

|

Desde hace al menos un año, después del evidente éxito del Nintendo Wii, muchos se han aventurado en Internet a pronosticar lo que será del sucesor del Wii. Así que sin esperar mas aquí van mis predicciones al respecto. Desde hace al menos un año, después del evidente éxito del Nintendo Wii, muchos se han aventurado en Internet a pronosticar lo que será del sucesor del Wii. Así que sin esperar mas aquí van mis predicciones al respecto.Primero, no creo el próximo Wii será una revolución como lo fue el Wii en relación a todo lo existente. Es obvio que el éxito del Wii no radica en sus gráficos (que son bastante inferiores al PlayStation 3 o el Xbox 360), sino que mas bien en su innovador control, el "WiiMote". Muchos tienen ya mas de un año diciendo que "en los próximos meses el Wii decaerá porque la innovación del control es solo algo pasajero". Esas son las mismas personas que 2 años atrás pronosticaban que el PS3 sería líder del mercado en el 2007. En otras palabras, las mismas personas que no han tenido la visión de entender que hay millones de personas en el mundo que (como yo) están cansadas de tener que aprenderse durante 1 día la combinación de 8 botones diferentes en un control super-complicado solo para pegarle a una bola de tenis. Con el Wii, haces el gesto de pegarle a la pelota y ya está. Gratificación instantánea. Es la misma razón por la cual en el momento que un nuevo tipo de interfaz permita que uno pueda comunicarse directamente con una PC, y de manera efectiva, con tan solo pensarlo, que ese sí será el fin del teclado y el ratón. Por ahora les quedan muchos años a esos dos dispositivos. En otras palabras, el sistema ideal de interactuar con dispositivos electrónicos es el sistema que nos permita hacer el menor esfuerzo posible de comunicar nuestra intención de hacer algo, y de hacerlo de una manera intuitiva. Hoy día tanto el Wii como el iPhone son los dos ejemplos máximos que tenemos al respecto. En el iPhone por ejemplo, si quiero agrandar una foto en la pantalla, o ampliar una sección de una página web, simplemente "agarro" con los dedos la imagen y la amplio con los dedos, como si de masilla se tratara. Es un interfaz "orgánico". Entonces, ¿qué podemos esperar del sucesor del Wii? Pues si acierto no creo que sea un sensor que te coloques en la cabeza y que este convierta tus pensamientos en acciones en el video-juego, como muchos están prediciendo. Aunque la tecnología para hacer eso existe, y la podemos comprar hoy día, lo cierto es que aun falta mucho para que esta tecnología se pueda masificar, en particular en el sector de video-juegos casuales, en donde hablamos de crear interfaces que deban ser utilizados por personas que van desde niños hasta ancianos. Habiendo dicho eso, creo que la próxima iteración del Wii será mas evolutiva que revolucionaria, en donde Nintendo tomará las debilidades de su formula ganadora, y las mejore sustancialmente. Mas específicamente, y de lo que todos se quejan, está el tema de los gráficos, que están una generación por detrás de la competencia. Muchos dirán que por qué Nintendo pondría atención a los gráficos en el sucesor del Wii, cuando en su forma actual estos no han sido un factor para el éxito, y la respuesta es que pueden desde ya apostar a que la próxima generación del PlayStation y el Xbox, ambos poseerán interfaces intuitivos como los del Wii, aparte de poseer un tremendo poder de procesamiento. En otras palabras, la competencia ya entendió muy bien el mensaje de Nintendo en esta generación, y tomarán todos sus puntos buenos y los integrarán en sus próximas consolas, por lo que Nintendo ya no contará con un gran diferenciador en la próxima generación. Eso solo puede significar que Nintendo ofrezca un "Wii Advanced" o "Super Wii" o "Wii 2" o "Wii 2010" o lo que quieran llamarlo, que posea tanto un mejorado interfaz basado en acelerómetros (y quizás asistido por cámaras para poder captar movimientos de cuerpo entero con software de visión artificial, similar al EyeToy del PlayStation 2 y 3), asi como un muy mejorado poder crudo de procesamiento de datos y gráficos. Aunque quisiera equivocarme, tendremos que esperar dos generaciones mas de consolas para poder controlar nuestros video-juegos (y por ende, entornos virtuales) tan solo con pensarlo. Creo que pueden esperar el nuevo Wii entre finales del 2010 y 2011. Noticia que me inspiró a escribir esta autor: josé elías |

|

|

|

|

|

martes, agosto 12, 2008

|

Los que programan gráficos tridimensionales hoy día por lo general utilizan una de dos tecnologías, o OpenGL (OS X, Linux, y Windows) o Direct X de Microsoft. La diferencia (aparte de ser bastante diferentes desde el punto de vista técnico) es que OpenGL es un estándar abierto, por lo que si creas una aplicación con OpenGL es fácil portarla a otra plataforma, lo que hace a OpenGL popular entre programadores de video-juegos, mientras que DirectX (ahora en su versión 10.x) es solo para Windows. Los que programan gráficos tridimensionales hoy día por lo general utilizan una de dos tecnologías, o OpenGL (OS X, Linux, y Windows) o Direct X de Microsoft. La diferencia (aparte de ser bastante diferentes desde el punto de vista técnico) es que OpenGL es un estándar abierto, por lo que si creas una aplicación con OpenGL es fácil portarla a otra plataforma, lo que hace a OpenGL popular entre programadores de video-juegos, mientras que DirectX (ahora en su versión 10.x) es solo para Windows.Sin embargo, antes de salir, muchos han criticado que la versión 3 de OpenGL no es una trabajo "desde cero" como se creía, por lo que la comunidad no está muy feliz que digamos con esta versión, y algunos incluso amenazan con cambiarse a DX10. Por ahora solo falta ver la reacción que tendrán los desarrolladores de software, ahora que tienen una versión final con la cual trabajar... Fuente oficial de la noticia autor: josé elías |

|

|

|

|

|

lunes, agosto 11, 2008

|

Científicos estadounidenses acaban de revelar que han desarrollado un nuevo tipo de material que puede "doblar" la luz alrededor de objetos tridimensionales, esencialmente haciendo tales objetos invisibles. Científicos estadounidenses acaban de revelar que han desarrollado un nuevo tipo de material que puede "doblar" la luz alrededor de objetos tridimensionales, esencialmente haciendo tales objetos invisibles.Hasta ahora (y como hemos reportado anteriormente en eliax) los científicos solo habían podido hacer este truco en objetos de dos dimensiones a escalas microscópicas, pero ahora este adelanto permitirá que un día personas completas, o hasta tanques y aviones, se puedan tornar completamente invisibles, ya que según los científicos esta nueva tecnología es escalable a grandes tamaños. Esta investigación fue publicada por su principal desarrollador, Xiang Zhang, en las dos prestigiosas publicaciones científicas Nature y Science. Esta tecnología funciona creando lo llamado "índice de refracción negativa". Esto es, en palabras sencillas, lo opuesto a lo que hace un lente o un prisma que desvía la luz en cierta dirección como todas las otras cosas en la naturaleza. Estos meta-materiales (materiales compuestos de otros materiales sintéticos y/o no sintéticos, usualmente creados con nano-tecnología), hacen todo lo contrario, desviando la luz en la dirección opuesta. Debido a esto, es posible que en vez de un rayo de luz que se encuentra entre un objeto y tus ojos se desvíe y te revele al objeto, que el rayo de luz sea "doblado" alrededor del objeto para que llegue a tus ojos como abría llegado si el objeto no estuviera entre tu y la fuente de luz, efectivamente haciendo que el objeto intermedio no lo puedas ver. Noten que esta tecnología es muy diferente a otras que hemos mencionado en eliax, en donde lo que se hace es proyectar un video en tiempo real de lo que ocurre detrás del objeto sobre un material especial (que se encuentra sobre el objeto). Esta nueva tecnología verdaderamente permite crear objetos invisibles. Por ahora la tecnología ya funciona a escalas del espectro electromagnético de las telecomunicaciones, por lo que según Zhang ya nos estamos acercando al espectro de rango de luz que detecta el ojo humano para hacer esto una realidad. Una fuente de la noticia Otra fuente de la noticia autor: josé elías |

|

|

|

|

|

domingo, agosto 10, 2008

|

|

Esta noticia de hoy es una que recomiendo lean, pues estoy seguro que pasará de alto en muchos medios que no entienden su importancia.

Investigadores del Instituto de Tecnología de Massachussetts (MIT) acaba de crear un nuevo tipo de tecnología que permite crear imágenes tridimensionales que cambian dependiendo de la luz ambiental fuera de la imagen, un proceso a lo que el MIT llama "imágenes 6-D" o de 6 dimensiones. Dicen 6 dimensiones refiriéndose primero a las estándares 3D que todos conocemos, pero añadiendo la posibilidad de uno poder moverse horizontal (4D), vertical (5D), o en relación a la luz (6D) del objeto. Déjenme explicarle ahora de una manera mas simple... Lo que esta tecnología permite es crear imágenes tridimensionales cuyas sombras, reflexiones y refracciones de luz dependen de la luz ambiental (es decir, fuera de la imagen) que existe. En otras palabras, imagínate una fotografía de una persona que tengas frente a ti. Si esa fotografía fue tomada con el sol al lado izquierdo, la persona proyectaría una sombra a su derecha como es de esperarse, pero con esta tecnología, la sombra de la persona, así como la textura de su cuerpo y color, cambiaría dependiendo no en relación a la luz que existía en el lugar en donde se tomó la fotografía ese día, sino que en relación a la luz en en lugar en donde tu estés parado viendo la foto hoy. Es decir, la sombra de la persona en la foto y su iluminación cambiarían dependiendo de cómo sostengas la foto en tus manos, o de como la ilumines con el sol, una linterna o varias fuentes de luz en tu casa. Algo extraordinariamente asombroso. Esta tecnología sin embargo no se puede apreciar sin uno verla con sus propios ojos, y por eso los desarrolladores de esta tecnología muestran un video en la página a donde los envío (y reproducido al final de esta noticia) que les enseña visualmente lo que sucede cuando a un holograma de una botella de vino se le alumbra desde atrás desde diferentes direcciones. Notarán que tanto la sombra, así como los patrones de la luz mientras pasan por la botella imaginaria, cambian en relación a la luz del "mundo real" fuera de la imagen (esto es demostrado cerca de la primera mitad del video, así que sean pacientes primero viendo unas gráficas que muestran un poco de teoría). Ahora, para los que aun no ven lo asombroso de esto, esta tecnología permitirá en un futuro crear hologramas de cosas que se mezclen tan bien con nuestra realidad, que será literalmente imposible saber si es real o no, ya que sin importar el ángulo desde la cual veamos esas imágenes, y la iluminación ambiental en el lugar en donde las veamos, las imágenes simularán exactamente el mismo comportamiento visual que nos provee una imagen "real". Esto significa que en un futuro podremos hacer cosas que solo se ven en el cine actualmente, como podría ser desplegar un paisaje de un lago frente a una pared de nuestra casa en el medio de la ciudad, y aun tengamos las ventanas abiertas el lago reflejará la luz ambiental en su agua, poniéndose oscuro de noche y claro de día, aparentando un lago totalmente real ante nuestros ojos. Esto además tiene implicaciones en todo tipo de realidad virtual mixta, en donde será difícil distinguir entre lo que estamos viendo en un mundo simulado, y el mundo real, creando esto un nuevo nivel de realismo jamás imaginado. Noten finalmente que el primer prototipo que los desarrolladores de esta tecnología han construído ha sido a mano, a un costo de unos US$30 dólares por pixel, requiriéndose de miles o millones de estos pixeles para crear imágenes realistas. Sin embargo, como dicen en el artículo, esto será comercialmente posible en unos 10 años, inicialmente para las industrias del entretenimiento y de mercadeo visual, pero ya pueden apostar a que esta tecnología estará en todos nuestros hogares mas temprano que tarde... Fuente oficial de la noticia Video a continuación (si el video no sale, prueben en el enlace oficial de la noticia aquí arriba que contiene el video original)... autor: josé elías |

|

|

|

|

|

|

A continuación los dejamos con un video que demuestra lo lejos que hemos llegado en el arte de animar caras humanas. A continuación los dejamos con un video que demuestra lo lejos que hemos llegado en el arte de animar caras humanas.Lo que verán es un software que genera en tiempo real todo tipo de expresiones humanas en actores sintéticos. El software se llama AlterEgo, y fue creado por Pendulum, una empresa que entre otras cosas crea herramientas para ser utilizadas en video-juegos, por lo que esperen un nuevo nivel de realismo en la nueva generación de juegos de consolas y PC en los próximos meses. Página oficial de esta herramienta Anteriormente en eliax: La nueva generación de software de animación de humanos (Abril 2008) Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

lunes, agosto 4, 2008

|

|

A continuación les mostramos este asombroso video del grupo "Obscura Digital" una tecnología que combina hologramas de 2 dimensiones con tecnología multi-toque para crear algo verdaderamente asombroso a lo que llaman "VisionAire" ("Visión en el Aire"), que nos hace recordar de la película Minority Report con Tom Cruise.

No dejen de verlo, es espectacular. Fuente del video Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, julio 23, 2008

|

|

A diferencia de tecnologías como LCD, en donde apenas el 5 al 10% de la luz detrás de la pantalla llega a los ojos del espectador (aparte de consumir hasta el 30% de la batería de una laptop), la nueva tecnología llamada "Pixeles Telescópicos" puede transmitir hasta el 36% de la luz (y hasta 56% según simulaciones), lo que significa que se puede utilizar mucho menos energía para lograr el mismo resultado que una pantalla plana tradicional, así como aumentar la calidad de la imagen misma. Además, el tiempo de respuesta de los pixeles es de apenas 0.625 milisegundos (versus 2 a 10 en LCD), lo que significa una pantalla ideal para video que tiene mucho movimiento, como por ejemplo en video-juegos. Esta velocidad de respuesta además (asumo yo) es ideal para crear pantallas 3D, ya que permitiría un ritmo de refresco de pantalla mucho mas acelerado, y por tanto sería posible tener video sólido en 3D aun a 60 cuadros por segundo. Esta tecnología funciona implementando un telescopio en miniatura para cada pixel, lo que sirve para amplificar la luz notablemente, tal cual lo hace un telescopio tradicional. La gran desventaja actual de la tecnología es el radio/proporción de contraste, que en los primeros prototipos es de unos abismales 20:1, pero según los desarrolladores de la tecnología creen poder llegar pronto a 800:1. En otras palabras, esta es una tecnología que promete ser asombrosa, pero le faltan unos años de refinamiento. Mientras tanto, esperemos que lleguen pronto esos "TV Laser" que nos están prometiendo desde hace unos años... Fuente de la noticia Otra fuente autor: josé elías |

|

|

|

|

|

viernes, julio 18, 2008

|

|

Si alguna vez has manejado de noche en una carretera sin iluminación, o a través de niebla bien densa, ya sabes el peligro que eso representa, y eso sin hablar de lo lento que debes manejar.

Ahora, General Motors está desarrollando un "Parabrisas Inteligente" que combina telemetría de rayos láser, sensores infrarrojos y una cámara para detectar y reconocer todo tipo de obstáculos en el camino, así como el camino mismo. El sistema es tan avanzado que no solo te presenta obstáculos que no podrías ver con tu vista, sino que hasta te dibuja en 3D el contorno de la carretera para que la "veas" aun no veas nada con tus propios ojos. La tecnología está diseñada originalmente para personas mayores, pero es obvio que la utilidad de esto va mas allá que ayudar a las personas mayores. Solo me preocupa que la gente confíe demasiado en esto y arriesgue su vida manejando mas rápido de lo que se lo indique el sistema... Fuente de la noticia autor: josé elías |

|

|

|

|

|

viernes, julio 11, 2008

|

A continuación una colección de fotografías con la técnica de "Graffiti de Luz", en donde se fija la cámara en un trípode y se pone la cámara en modo de larga exposición para poder captar la luz durante unos segundos, tiempo suficiente como para mover un objeto brillante frente a la cámara y crear todo tipo de llamativos efectos visuales. A continuación una colección de fotografías con la técnica de "Graffiti de Luz", en donde se fija la cámara en un trípode y se pone la cámara en modo de larga exposición para poder captar la luz durante unos segundos, tiempo suficiente como para mover un objeto brillante frente a la cámara y crear todo tipo de llamativos efectos visuales.Enlace a las fotos autor: josé elías |

|

|

|

|

|

martes, julio 8, 2008

|

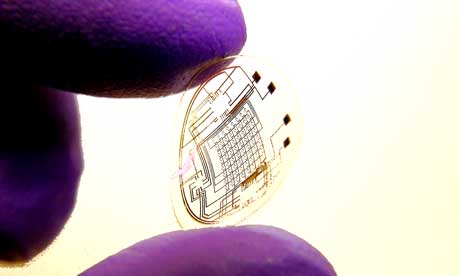

Científicos de la Universidad de Washington en los EEUU acaban de desarrollar un lente de contacto totalmente flexible pero que contiene todo tipo de componentes electrónicos en su superficie. Científicos de la Universidad de Washington en los EEUU acaban de desarrollar un lente de contacto totalmente flexible pero que contiene todo tipo de componentes electrónicos en su superficie.El primer prototipo ya se ha creado, y el próximo contendrá una pantalla flexible integrada que permitirá desplegar imágenes directamente sobre la retina, permitiendo una nueva generación (y revolución) de dispositivos visuales como nunca antes. Entre las aplicaciones que esto tendrá se encuentran video-juegos inmersivos en 3D, interfaces visuales para dispositivos móviles (como el iPhone), asistentes visuales para trabajos de todo tipo (como por ejemplo, desplegar en 3D las piezas de un motor y cómo desarmarlo mientras uno ve a un motor real frente a uno), asistentes en salas de cirugías (que permitiría que un cirujano se sienta que "navega" dentro del cuerpo humano), y obviamente las mandatorias aplicaciones militares. Fuente de la noticia autor: josé elías |

|

|

|

|

"Todos alegan que nos volvemos cada vez mas malos pero creo que mas bien nos volvemos cada vez mas sensibles hacia lo malo.. y es por eso que creemos que cada vez hay mas maldad.

Esto es bueno, me refiero a que mas gente piense que hay mas maldad, pues esto demuestra que tenemos los ojos mas abiertos y nos demos cuenta que debemos cambiar hacia bien."

Esto es bueno, me refiero a que mas gente piense que hay mas maldad, pues esto demuestra que tenemos los ojos mas abiertos y nos demos cuenta que debemos cambiar hacia bien."

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax