Tecnología Visual

|

viernes, junio 3, 2011

|

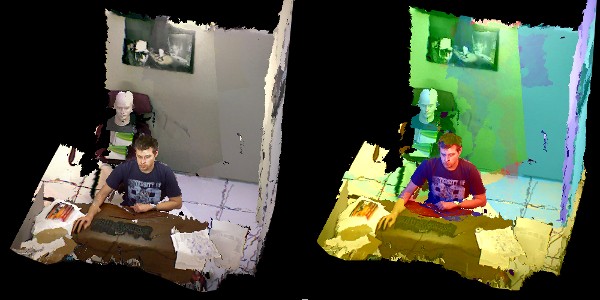

El Kinect del Xbox ha sido hackeado en incontables formas, pero esta es quizás la mejor de todas. El Kinect del Xbox ha sido hackeado en incontables formas, pero esta es quizás la mejor de todas.Un grupo de estudiantes de UNC-Chapel Hill han combinado varios Kinects para lograr lo que efectivamente es un sistema de video-conferencia volumétrico en 3D (y para entender todos estos términos técnicos lo mejor es ver el video para que aprecien el producto final). Lo que han logrado es combinar varios hacks del Kinect y del Nintendo Wii, en uno solo. Primero, capturan video en tiempo real desde varios Kinects, y después reconstruyen una versión volumétrica (en 3D) de la escena que se capta con las cámaras. Después esta información es enviada remotamente a un software que no solo despliega el video desde cualquier ángulo, sino que lo hace tomando en consideración la posición de los ojos de la persona que ve el video, de modo que si la persona se mueve de derecha a izquierda, o de arriba hacia abajo o de delante hacia atrás, el video en 3D se auto-ajusta para mostrar una nueva perspectiva. Esto después se repite simultáneamente con las personas en el otro extremo, de modo que ambos extremos puedan tener la misma experiencia. Esto tiene como resultado que uno sienta que la imagen que ve en el monitor tenga "profundidad" o "volumen" (aunque quizás el próximo paso sería combinar esto con una pantalla de 3D estereoscópica para lograr el mejor efecto posible), dando una impresión bastante fuera de la realidad dentro del monitor. Noten que esto tiene implicaciones y usos que van más allá de ofrecer un ambiente natural de video-conferencia, pues como explican en el video estas técnicas se pueden combinar con realidad aumentada y realidad virtual para combinar imágenes sintéticas con la vida real de forma bastante natural. página oficial del proyecto Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

jueves, mayo 26, 2011

|

Es asombroso que hace apenas unos años 2 Megapixeles sonaban asombrosos. Incluso 20 son bastante respetables hoy día, pero la venerable empresa de cámaras de formato medio, Hasselblad cree que debe ir Es asombroso que hace apenas unos años 2 Megapixeles sonaban asombrosos. Incluso 20 son bastante respetables hoy día, pero la venerable empresa de cámaras de formato medio, Hasselblad cree que debe ir ¿El precio de esta fuente oficial (en español) Actualización: Noten que esta cámara en realidad tiene un sensor que físicamente solo capta 50 megapixeles, pero está diseñado para ajustar el punto de enfoque y tomar varias imágenes sucesivamente y de forma rápida, combinando en tiempo real todas las imágenes y formando una sola de 200 megapixeles "virtuales" :) autor: josé elías |

|

|

|

|

|

|

En nuestro universo actual, sabemos que la materia más densa posible existe dentro de los Agujeros Negros, estrellas colapsadas por su propio peso y comprimidas a un nivel y densidad tal, que escapa nuestra imaginación, y ahora los científicos del LHC (Gran Colisionador de Hadrones, por sus siglas en inglés), acaban de crear la materia más densa del Universo fuera de estos agujeros. En nuestro universo actual, sabemos que la materia más densa posible existe dentro de los Agujeros Negros, estrellas colapsadas por su propio peso y comprimidas a un nivel y densidad tal, que escapa nuestra imaginación, y ahora los científicos del LHC (Gran Colisionador de Hadrones, por sus siglas en inglés), acaban de crear la materia más densa del Universo fuera de estos agujeros.Para que tengan una idea de lo que hablamos, aunque la cantidad de materia que se creó fue bastante minúscula, si pudiésemos crear apenas 1 centímetro cúbico de esta materia, esta pesaría la titánica suma de 40,000,000,000 toneladas (no es un error: 40 mil millones de toneladas en una cucharadita de esta materia). Lo que crearon específicamente es una "sopa" llamada un plasma quark-gluon, que se cree es exactamente el mismo plasma que existió justo en el mismísimo inicio de nuestro Universo, y de donde eventualmente originó la materia y todo lo que vemos hoy día en nuestro universo. Combinen esto con esta otra noticia pasada sobre el LHC, y si seguimos así dentro de pocos vamos a respondera varias de las más profundas incógnitas que tenemos sobre nuestra existencia... fuente autor: josé elías |

|

|

|

|

|

lunes, mayo 23, 2011

|

Esta foto, y el video que lo acompaña, de verdad que me dejaron sorprendido... Se trata de la imagen más nítida e impactante jamás tomada de los efectos de un super-masivo Agujero Negro en la galaxia que lo aloja. Esta foto, y el video que lo acompaña, de verdad que me dejaron sorprendido... Se trata de la imagen más nítida e impactante jamás tomada de los efectos de un super-masivo Agujero Negro en la galaxia que lo aloja.Este agujero negro en particular se encuentra en una vecina galaxia llamada la "Centauro A", y que en términos relativos se encuentra cercana a nosotros (12 millones de años luz), y la imagen que ven es el resultado de los "chorros" de gas estelar que estos agujeros negros por lo general emanan en sus polos. Una forma de imaginarlo es pensando que la Tierra es un Agujero Negro, y que desde nuestro polo norte y sur salen dos grandes chorros de gas en direcciones opuestas. Este es un mecanismo que aun no se entiende por completo, pero sí se especula (y más con esta evidencia fotográfica en rayos X por el observatorio espacial Chandra de la NASA) que en algún momento y acorde cae materia al horizonte del agujero negro, que parte de esta es reemitida de forma espectacular por los polos del Agujero Negro. Noten que un Agujero Negro no es más que una estrella que exhausta suficiente cantidad de su combustible interno como para poder seguir ejerciendo presión externa en su superficie, lo que causa que la parte externa de la estrella colapse sobre sí misma por su propio peso, lo que genera que toda la materia se comprima en una esfera extremadamente pequeña (en el orden de unos pocos kilómetros). Estos Agujeros Negros contienen tanta materia en tan poco espacio, que son esencialmente objetos ultra-masivos, tan masivos que distorsionan el espacio-tiempo a su alrededor a un nivel tal, que ni siquiera los rayos de luz pueden escapar el ser atraídos a su interior (de ahí el nombre "Agujero Negro", ya que estos objetos no emiten luz y por tanto solo pueden ser observador indirectamente por sus estragos, como en este caso). Finalmente, noten que toda la evidencia apunta a que nuestra propia galaxia, La Vía Láctea, también posee uno de estos titanes en su centro, e incluso se teoriza que ese es el caso en quizás la vasta mayoría de galaxias maduras. fuente 1 fuente 2 Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, mayo 14, 2011

|

|

He aquí una tecnología acuñada ZeroTouch ("Cero Toque") que consiste de un marco que se coloca alrededor de cualquier pantalla tradicional (¡incluso televisores viejos del tipo CRT a blanco o negro!) y que la transforma en una pantalla multi-táctil capaz de reconocer no solo los 10 dedos de las manos, sino que incluso otros objetos.

El sistema incluso ni necesita de una pantalla, ya que todo lo que sucede dentro de su marco es interpretado como una superficie multi-táctil (como verán en el video más abajo). ZeroTouch funciona de una manera bastante simple: En los cuatro bordes del marco se encuentra una serie de emisores y detectores de LEDs (cuyos rayos de luz infrarrojos son invisibles a la vista humana), los cuales crean un patrón o malla de rayos invisibles entre ellos. Cuando uno o varios dedos interrumpen esos rayos, eso provee una coordenada que es calculada por un algoritmo el cual puede deducir exactamente en dónde se "tocó" la pantalla. Vean el video que explica todo bastante bien (no necesitan saber inglés, es altamente visual). ¡Gracias a todos los que me enviaron esta noticia por distintos medios! fuente autor: josé elías |

|

|

|

|

|

viernes, mayo 13, 2011

|

|

Uno de los temas que trato en mis charlas sobre la Singularidad Tecnológica es el efecto que esta tendrá en las artes, en donde nos acercamos a un futuro en donde cambiaremos arte pasivo y visto desde una tercera persona, a arte activo e "inmerso" y visto desde una primera persona, en donde nosotros nos hacemos parte del arte mismo, o como veremos en este ejemplo de hoy, del video musical mismo.

El siguiente video toma ventaja de una tecnología en navegadores web llamada "WebGL", una tecnología para renderizar gráficos en 3D dentro de navegadores web, que aunque apenas ha sido recientemente implementada ya llevaba años en desarrollo. En particular este video dice requerir las más recientes versiones del navegador Google Chrome que implementa WebGL. El video, después que pasan unos segundos de video tradicional, se torna a un entorno 3D que parece dibujado a mano, y lo interesante es que con el ratón uno puede moverse y "ver" de lado a lado el mundo siendo generado en tiempo real y en 3D ante nuestros ojos. Imaginen entonces en un futuro algo como esto, pero con Realidad Virtual, en donde en cualquier dirección que veamos vemos este mundo generado. Así que desde ese punto de vista, esto es un pequeñito vistazo a la punta de un témpano de hielo del futuro... El video musical interactivo se llama 3 Dreams of Black del album Rome de Danger Mouse & Daniele Luppi, y noten que el nombre ("3 Sueños de Negro") en inglés en realidad inicia con las mismas iniciales de "3D". ¡Gracias a todos los lectores que me enviaron el enlace al video! enlace al video (requiere Google Chrome) autor: josé elías |

|

|

|

|

|

|

Si eres una persona no muy experta en el manejo manual de cámaras digitales, y te gustaría experimentar con cosas como ISO, Apertura, Velocidad, Zoom, etc, tienes dos tres opciones: Si eres una persona no muy experta en el manejo manual de cámaras digitales, y te gustaría experimentar con cosas como ISO, Apertura, Velocidad, Zoom, etc, tienes dos tres opciones:1. Obtienes una cámara y experimentas. 2. Puedes aprender al respecto leyendo un artículo que te explica todo detalladamente y en palabras sencillas (como este acá mismo en eliax). 3. y/o puedes experimentar virtualmente desde dentro de tu navegador web con un simulador de cámara digital. Ese último punto 3 es de lo que se trata la página a donde los envío hoy, y de verdad que hicieron un trabajo genial. Para utilizar la herramienta primero noten que necesitan tener activada la tecnología Adobe Flash en sus navegadores de Internet (esperemos que alguien se anime a crear una versión HTML5 en un futuro no lejano), y segundo noten que aunque muchos cambios se ven en tiempo real (como el zoom), que para ver el efecto real de cambiar los otros parámetros (como ISO, Velocidad, etc) deben oprimir el botón que dice "Snap Photo" abajo a la derecha. Espero se diviertan, ¡de verdad que es una herramienta divertida y educacional a la vez! :) ¡Gracias a los lectores Emmanuel Bretón y eliezer por el enlace! enlace a la página autor: josé elías |

|

|

|

|

|

martes, mayo 3, 2011

|

Hace poco más de un mes les presenté un video de un prototipo de Photoshop siendo demostrado nativamente funcionando en un iPad. Hoy Adobe sacó por fin al mercado su Adobe Creative Suite 5.5 (Adobe CS 5.5), en donde uno de sus puntos fuertes es una nueva arquitectura que se integra con el iPad. Hace poco más de un mes les presenté un video de un prototipo de Photoshop siendo demostrado nativamente funcionando en un iPad. Hoy Adobe sacó por fin al mercado su Adobe Creative Suite 5.5 (Adobe CS 5.5), en donde uno de sus puntos fuertes es una nueva arquitectura que se integra con el iPad.En esencia, en al menos el programa Photoshop, ahora es posible ir al App Store de Apple y comprar/descargar extensiones de Photoshop que funcionan en el iPad, incrementando considerablemente el poder de Photoshop gracias al iPad. Por ejemplo, una de las aplicaciones que puedes obtener te permite utilizar la superficie del iPad como una extensión al teclado de tu PC, en esencia transfiriendo las acciones de herramientas más utilizadas a botones táctiles en la superficie del iPad. Con esta extensión por ejemplo será posible mantener el iPad al lado de tu teclado como una manera super rápida de elegir opciones. Incluso, en un futuro quizás esto reemplace por completo al teclado, necesitando tu solo el teclado y el ratón. Pero algunos se preguntarán, ¿y que gano uno con simplemente transferir las funciones de un teclado de US$20 dólares a un dispositivo de US$500?, lo que es una pregunta muy válida, y cuya respuesta la veremos en el próximo párrafo. Sucede que con esta metodología, el iPad funciona no solo como teclado, sino que como superficie multi-táctil y como pantalla, incluso como reemplazo del ratón en algunas operaciones, todo en un solo lugar.  Por ejemplo, otra extensión te permite combinar colores de una forma muchísimo más natural que con un ratón, utilizando tus dedos para mezclar virtualmente distintos colores sobre la superficie del iPad, viendo tu en tiempo real los resultados sobre el mismo iPad, lo que será bastante útil para diseñadores gráficos y aquellos que deseen replicar la experiencia de pintar a mano de forma digital. Por ejemplo, otra extensión te permite combinar colores de una forma muchísimo más natural que con un ratón, utilizando tus dedos para mezclar virtualmente distintos colores sobre la superficie del iPad, viendo tu en tiempo real los resultados sobre el mismo iPad, lo que será bastante útil para diseñadores gráficos y aquellos que deseen replicar la experiencia de pintar a mano de forma digital.Pero lo mejor de todo es que Adobe permitirá que terceros creen sus propias extensiones, lo que abre un sin-fin de posibilidades, en donde Photoshop se convierte en su propio derecho en una plataforma, la cual en combinación con el iOS del iPad se extiende para hacer cosas de forma muchísimo más eficiente. Incluso, no veo por qué a alguien no se le pueda ocurrir utilizar el poder adicional del iPad para acelerar ciertas funciones en Photoshop (como filtros visuales), lo que debe traerles memorias de este artículo reciente en eliax en donde hablo de un futuro de procesamiento distribuído simple en todos los rincones del consumismo digital. Noten que para aquellos que tengan CS 5.0, que Adobe ha creado una actualización que les permitirá utilizar estas extensiones de Photoshop en el iPad. Esa actualización la pueden obtener en este enlace. Finalmente, debo agregar que esta es una modalidad que muy posiblemente se convierta en tendencia, creando del iPad una extensión adicional al mundo de herramientas profesionales y creativas, así como quizás en futuros modelos del iPad veremos suceder también lo contrario: La adopción por el iPad de teclados, ratones, lápices digitales, pantallas externas y otras herramientas, borrando la linea entre lo que muchos denominan una PC tradicional y lo que es un tablet como el iPad.... fuente autor: josé elías |

|

|

|

|

|

viernes, abril 29, 2011

|

Ahora los envío a una curiosa página en donde podrán pasar minutos muertos jugando con lo que hace. Ahora los envío a una curiosa página en donde podrán pasar minutos muertos jugando con lo que hace.Se trata de una super sencilla página en donde escribes un nombre (o cualquier palabra), y este te genera una cara pixelada basada en el nombre. Lo interesante es que no es una cara generada aleatoriamente, ni pre-generada, sino que utiliza un algoritmo que basado en las letras de tu nombre genera la cara. Algo que notarán es que el algoritmo no toma en consideración si el nombre es femenino o masculino, por lo que no se sorprendan si escriben su nombre y sale una cara con el género opuesto... :) enlace a la página autor: josé elías |

|

|

|

|

|

martes, abril 26, 2011

|

|

A continuación comparto con ustedes este alucinante video de un efecto llamado "Projection Mapping" en donde se utilizan unos proyectores de video de alta potencia contra la pared de un edificio, para después "distorsionar" y "animar" al edificio.

Este es uno de esos casos en donde literalmente una imagen vale más que mil palabras, así que no dejen de ver el video, les aseguro que los impresionará. Y si les gustó este video, no dejen de ver este otro, que aunque un tanto diferente, es igual de impresionante. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, abril 20, 2011

|

Ayer les hablé de tecnología que por medio de chips permitirán reparar el ojo humano para que este vea (hoy día ya existen decenas de personas con prototipos de implantes similares), y hoy les hablaré de otra forma asombrosa de curar la ceguera en el futuro... Ayer les hablé de tecnología que por medio de chips permitirán reparar el ojo humano para que este vea (hoy día ya existen decenas de personas con prototipos de implantes similares), y hoy les hablaré de otra forma asombrosa de curar la ceguera en el futuro...Se trata de un adelanto en donde científicos japoneses han logrado que "nazca" (o se desarrolle) un ojo a partir de simples células madre embrionarias. Recuerden que un ser humano completo inicia como una célula, la cual se divide incontables veces, formando en su proceso células especializadas que eventualmente continúan subdividiéndose y especializándose para crear huesos, músculos, órganos, sentidos, extremidades, etc, por lo que sabemos que es posible en principio crear cualquier parte del cuerpo a partir de una sola célula. Pues eso es precisamente lo que han logrado estos científicos, iniciando con una célula madre embrionaria de un ratón, y modificándola genéticamente para que esta se subdividiera y desarrollada hasta formar un ojo rudimentario (lo que hace de este escenario algo no tan lejano ni descabellado). Recuerden que este experimento con un ojo es el primero de su tipo, por lo que no es un ojo perfecto el que se formó, pero el hecho de que se formó un ojo primitivo es ya un gran hito en la ciencia, que apunta a un futuro en donde sería posible que si quedas ciego o pierdes un ojo, te podamos crear uno nuevo e implantártelo, siendo este 100% compatible con tu cuerpo ya que provendría de ti mismo. Como digo con regularidad, estamos viviendo los momentos más emocionantes hasta la fecha de la humanidad... :) fuente Nota: El video a continuación es un video compuesto de varias fotografías tomadas durante un período de tiempo muchísimo más largo que el video mismo, y que muestra los pasos paulatinos de como las células madre se convertían poco a poco en un ojo rudimentario. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, abril 19, 2011

|

En eliax por años les he informado de varias tecnologías que permiten que personas totalmente ciegas puedan volver a ver (consultar enlaces de noticias previas en eliax al final de este artículo), pero casi siempre estos avances proceden o de los EEUU o del bloque europeo. Ahora Australia se une a la carrera ofreciendo lo que dice es un "gran adelanto" en el campo de implantes para ojos biónicos... En eliax por años les he informado de varias tecnologías que permiten que personas totalmente ciegas puedan volver a ver (consultar enlaces de noticias previas en eliax al final de este artículo), pero casi siempre estos avances proceden o de los EEUU o del bloque europeo. Ahora Australia se une a la carrera ofreciendo lo que dice es un "gran adelanto" en el campo de implantes para ojos biónicos...Un grupo de investigadores australianos unidos bajo el consorcio Bionic Vision Australia, acaba de desarrollar un chip implantable que contiene 98 estimuladores que se conectan directamente al fondo del ojo, obteniendo una imagen digital de una cámara y estimulando directamente los nervios ópticos del cerebro en el ojo. Según los investigadores que están trabajando en el proyecto, ya tienen prototipos funcionando con los cuales están haciendo pruebas de laboratorio, y para el 2013 planean tener implantes completos funcionando en modo de pruebas en pacientes humanos. Este tipo de noticia me encantan, pues demuestran que en poco tiempo tendremos tantos equipos trabajando en la misma cosa que rápidamente veremos estos ojos biónicos avanzar en funcionalidades, así como disminuir en precios hasta ser algo accesible a cualquier persona con un seguro médico promedio. página oficial del proyecto (BionicVision Australia) fuente autor: josé elías |

|

|

|

|

|

lunes, abril 18, 2011

|

Los que han visto hologramas a color rápidamente notan algo: En el momento que mueves la superficie del holograma o en el momento que uno se mueve alrededor del holograma, los colores de este cambian automáticamente, lo que aparentaba hacer imposible la creación de hologramas con colores fijos. Hasta ahora. Los que han visto hologramas a color rápidamente notan algo: En el momento que mueves la superficie del holograma o en el momento que uno se mueve alrededor del holograma, los colores de este cambian automáticamente, lo que aparentaba hacer imposible la creación de hologramas con colores fijos. Hasta ahora.Un equipo de investigadores japoneses ha inventado una manera de utilizar un efecto físico llamado plasmons (asumo que "plasmones" en español - y que es un estado cuántico de determinadas partículas) para crear hologramas que por primera vez mantienen su color de forma independiente al ángulo de visión de nuestros ojos con respecto a ellos. Esto es un avance significativo pues abre las puertas a un nuevo capítulo en esta tecnología visual, quizás en un futuro pudiéndose finalmente crear pantallas holográficas que sin necesidad de gafas y trucos visuales (como los explicados en este artículo) proyecten una imagen tridimensional en cualquier espacio. Esto bien podría ser uno de los elementos claves para el cine holográfico del futuro (tanto en salas de gran escala como en espacios hogareños), así como para la proyección de ambientes en tiempo real de un lugar a otro de forma holográfica (como por ejemplo, video-conferencia holográfica similar a lo visto en películas como Star Wars). fuente autor: josé elías |

|

|

|

|

|

miércoles, abril 13, 2011

|

Ayer les ofrecí mi opinión sobre el significado de que Google esté invirtiendo US$100 Millones de dólares en contenido original para YouTube, y finalicé el artículo dejándolos con una incógnita: ¿Qué tiene Google que otras empresas no tienen que permitirá que tenga una muy buena oportunidad de ser uno de los titanes del futuro de la TV? Ayer les ofrecí mi opinión sobre el significado de que Google esté invirtiendo US$100 Millones de dólares en contenido original para YouTube, y finalicé el artículo dejándolos con una incógnita: ¿Qué tiene Google que otras empresas no tienen que permitirá que tenga una muy buena oportunidad de ser uno de los titanes del futuro de la TV?La respuesta se las ofrezco hoy: Ancho de banda. Y noten que no hablo de simple ancho de banda como lo conocemos tradicionalmente, en donde una empresa conpra ancho de banda de otra. hablo de una estrategia que gracias a su CEO de entonces, Eric Schmidt, ha hecho que Google hoy valga muchísimo más de lo que aparente a simple vista... Específicamente, hablo de algo de lo cual les hablé hace 4 años, en este sencillo artículo, en una noticia que en ese entonces prácticamente nadie le hizo caso, pero que a mi me llamó muchísimo la atención: Google se ha convertido, bajo las narices de todo el mundo, en uno de los más grandes propietarios de fibra óptica del mundo (sino el más grande de todos). Pero, ¿y cómo sucedió eso? Pues como expliqué en ese artículo del 2007, Google vio una tremenda oportunidad en medio de la adversidad (como hubiera dicho Einstein) en el momento que explotó la burbuja de Internet a finales de los 1990s, en donde decenas de miles de empresas quebraron de la noche a la mañana por estar sobrevaloradas. Sucede que muchas de esas empresas eran empresas de telecomunicaciones, y por tanto cuando se fueron en picada Google inteligentemente decidió comprar su infraestructura a precios casi por el suelo. Específicamente lo que compraron fue lo denominado "dark fiber" o "fibras oscuras", cables de fibras ópticas sin uso (de ahí el nombre de "fibras oscuras", ya que estaban "apagadas, sin luz"), que conectaban a centenares de estas empresas con otras, así como a través de los principales backbones (autopistas principales de Internet) de la red. En otras palabras, como les expliqué en ese entonces, Google es para sorpresa de muchos (incluso para expertos en esta área de redes) uno de los principales dueños de la infraestructura del Internet, principalmente (pero no exclusivo) en los EEUU que es precisamente el principal mercado del video por Internet en estos momentos. Y eso, le trae a Google unos beneficios interesantes... Para empezar, esta es la razón primaria por la cual solo una empresa como Google podría haber comprado a YouTube en el 2006, pues aunque el precio pareciera alto (US$1,600 millones de dólares), lo cierto es que todo el mundo sabía que el verdadero costo vendría en costos posteriores de ancho de banda. Para que tengan una idea, 3 años después de la compra, en el 2009, YouTube ya servía 1,000 millones de videos diariamente, y hoy en el 2011 es posible que esa cifra sea una orden de magnitud superior. La única manera de una empresa poder llegar a ese nivel de escalabilidad es con su propia infraestructura, pues un servicio gratuito como YouTube no se iba a sostener por varios años con los inmensos costos que eso hubiera significado para cualquier otra empresa (y noten que apenas en meses recientes YouTube ha empezado a generar dinero para Google de forma significativa). Y toda esa introducción nos lleva al artículo de hoy... Alguien como Facebook ciertamente podría utilizar el poder de su red social para combinar exactamente los gustos de sus usuarios (los cuales felizmente le dicen a Facebook las películas que les gustan, el tipo de comida que prefieren, la música que escuchan, sus lugares favoritos, etc), con la de sus anunciantes, pero esto funciona solo hasta un límite. Llega un límite en donde cuando Facebook llegue a videos, se enfrentará con la realidad que toda otra empresa, salvo Google, deberá enfrentarse: ¿cómo pagar por todo el ancho de banda requerido por video en Internet? Para que tengan una idea de lo que hablamos, una página web típica como la de Facebook con varias fotografías ocupa alrededor de 1MB de espacio. Pero un solo video de YouTube puede fácilmente ocupar entre 10 y 100MB, lo que significa que le costaría a Facebook unas 10 a 100 veces más caro implementar una estrategia con videos, en relación a Google (quien ya tiene acuerdos con varios de los proveedores principales de Internet del mundo para compartir su fibra óptica). Y la única manera de competir contra Google sería entonces incrementando los precios de los anuncios, o cobrándole a los usuarios, y he ahí la ventaja de Google: Google puede ofrecer un servicio similar de videos a cualquier otro competidor a un precio al menos una orden de magnitud menor, simplemente por el hecho de que su ancho de banda en gran medida es un costo marginal. Es por eso que empresas como Netflix son las que han podido competir efectivamente contra YouTube, ya que (1) Netflix tiene un mercado nicho en el negocio de rentas de películas por Internet y (2) Netflix puede pagar ese ancho de banda ya que debido al servicio que ofrece sus usuarios son los que pagan por el ancho de banda (pagando a Netflix unos US$8 dólares mensuales, en el plan básico). Sin embargo, en el momento que Google empiece a crear contenido original, y ofrecerlo a un costo sumamente bajo, o incluso gratis, los anunciantes se alinearán en fila india para apoyar el servicio de Google. Noten que esto no significa que competidores como Facebook o Apple no podrán competir efectivamente contra Google, sino que tendrán que recurrir a otros modelos más dramáticos para poder competir mejor. Y lo mismo aplica no solo para video, sino que para cualquier servicio de cualquier tipo que cualquier empresa desee proveer por Internet. Como dijo alguien una vez en, es difícil competir contra "gratis"... Nota: Y mañana les tengo otra noticia más sobre este tema, en lo que será el final de esta trilogía de artículos sobre Google y videos por Internet... Actualización: He aquí la primera y tercera parte de esta trilogía de artículos. autor: josé elías |

|

|

|

|

|

sábado, abril 2, 2011

|

He aquí un software desarrollado por un talentoso Zdenek Kalal de la Universidad de Surrey, que sin duda hará que reciba ofertas de trabajo de las más grandes empresas (y gobiernos) del mundo. He aquí un software desarrollado por un talentoso Zdenek Kalal de la Universidad de Surrey, que sin duda hará que reciba ofertas de trabajo de las más grandes empresas (y gobiernos) del mundo.Se trata de un sistema llamado "Predator", el cual no solo es un software de seguimiento/rastreamiento de imágenes en tiempo real, sino que además combina las funciones de aprendizaje automático por medio de Inteligencia Artificial para de alguna forma "entender" lo que rastrea y por tanto ser muchísimo más efectivo que soluciones actuales. El sistema es tan inteligente, que incluso aprende de sus propios errores, mejorando así su efectividad con el tiempo, muy similar a como funcionan los circuitos de reconocimiento de patrones en el cerebro de seres humanos y otras criaturas biológicas. Este software tiene innumerables aplicaciones que van desde video-juegos hasta reconocimientos faciales en ambientes de seguridad, y desde rastreo policial de sospechosos, hasta aplicaciones bélicas en armas remotas. Abajo los dejo con un video que no pueden dejar de ver, en particular al final en donde al software se le muestran todo tipo de videos (autos, animales, etc) y este los sigue con una efectividad increíble. Y a propósito, esta noticia me recordó mucho esta otra, y ya me imagino lo poderoso que pudiera ser un sistema que combine los dos... fuente Video a continuación (enlace YouTube)... Actualización 3 de Abril 2011: Después de publicar esta noticia originalmente, varios lectores me enviaron a verificar el artículo ya que en la misma página del autor de este software se había cambiado la descripción del proyecto y de repente ahora decía que era un chiste del Día de los Inocentes, razón por la cual en un momento actualicé el artículo para hacer notar que aparentaba ser una broma. Pues investigué más, ya que una vez más el mensaje desapareció de la página oficial del proyecto, por lo que me puse en contacto con el autor mismo directamente. ¿Y adivinen qué? Es real. Parece que alguien le jugó una broma del Día de los Inocentes al autor de Predator, lo que lo desacreditó después de 3 arduos años de trabajo. Así que ya saben, la corazonada inicial resultó ser cierta, y esto es real. autor: josé elías |

|

|

|

|

|

viernes, abril 1, 2011

|

En enero del 2010, apenas horas después de ser revelado al iPad al mundo, escribí uno de mis artículos favoritos en eliax, titulado "Análisis eliax: La importancia y significado del Apple iPad". 3 meses después, el mismo día que salió el iPad por fin a la venta escribí otro titulado "Hoy sale al mercado el Apple iPad, la primera y verdadera PC". Y mucho anterior a eso, hace 4 años, escribí un artículo titulado "Editorial: ¿Podría el iPhone OS destronar a Windows?", y hoy, creo que podemos decir que esos artículos (que causaron mucha risa, burlas, y acusaciones de fanboyismo) resultaron ser bastante proféticos... En enero del 2010, apenas horas después de ser revelado al iPad al mundo, escribí uno de mis artículos favoritos en eliax, titulado "Análisis eliax: La importancia y significado del Apple iPad". 3 meses después, el mismo día que salió el iPad por fin a la venta escribí otro titulado "Hoy sale al mercado el Apple iPad, la primera y verdadera PC". Y mucho anterior a eso, hace 4 años, escribí un artículo titulado "Editorial: ¿Podría el iPhone OS destronar a Windows?", y hoy, creo que podemos decir que esos artículos (que causaron mucha risa, burlas, y acusaciones de fanboyismo) resultaron ser bastante proféticos...Y hoy tiene que ver con Adobe, una empresa que en años recientes ha tenido una relación de amor-y-odio con Apple, debido a que compiten en ciertos campos, pero se necesitan en otros (la mayoría de los profesionales del diseño gráfico prefieren Macs y Photoshop a otras plataformas), pero que de tener opción optaría por soportar solo a Windows para liberarse de los controles de Apple. Sin embargo, el iPad ha cambiado todo esto. Para empezar, las últimas estadísticas indican que Apple obtuvo alrededor del 99% del mercado de tablets en el 2010 (con casi cero competencia, pues tomó a todos los fabricantes por sorpresa), y en el 2011 se estima que el iPad comande al menos el 70% del mercado, y proyecciones indican que se comerá unos US$30 Mil Millones de dólares del mercado tradicional de la PC en el 2011. Como escribí en esos artículos pasados, el iPad no era sencillamente un iPhone gigante, ni una tableta similar a los primeros intentos de Microsoft años atrás. El iPad tampoco es una moda pasajera. Como he expresado varias veces desde el primer instante que vi anunciado el iPad por Steve Jobs, el iPad es genuinamente el próximo paso en la computación personal y social, e incluso voy más lejos al decir que es el iPad la primera computadora verdaderamente personal de la historia. Una que cualquiera puede utilizar sin entrenamiento (o al menos con un mínimo entrenamiento de unos pocos minutos), y que simplemente "funciona", similar a como esperamos que al presionar un botón nuestros televisores simplemente enciendan y funcionen. Así que este anuncio por parte de Adobe es bastante interesante, ya que una de las aplicaciones emblemáticas de la era de la "PC" tradicional es sin duda alguna Photoshop, y Adobe acaba de ofrecer una demostración de una versión prototipo de este genial programa, funcionando nativamente en el iPad. Eso no significa que podrán comprar Photoshop mañana mismo para el iPad, pero sí significa unas cuantas cosas importantes: 1. El iPad no es solo un dispositivo para consumir contenido, sino que como algunos predecimos sucedería, también para generarlo, solo se necesitaba tiempo para que los desarrolladores entendieran el nuevo paradigma multi-táctil y directo del iPad para re-pensar sus modelos tradicionales. 2. Adobe demostró que algunas operaciones son incluso más fáciles y poderosas en el iPad que en una PC tradicional, demostrando por ejemplo manipular el tamaño y rotación de objetos de una manera natural con los dedos. 3. Quedó demostrado también en el demo que el hardware del iPad es lo suficientemente potente como para manejar aplicaciones de alto poder. Photoshop, como muchos sabemos, es una aplicación que consume tantos recursos uno le haga disponible, y el hecho de que funcione en un dispositivo portátil y tan ligero, es de asombrar a muchos. 4. Se ha hecho evidente también que empresas como Adobe ya no pueden obviar al iPad como una "moda pasajera". Ya están entendiendo que ese es el futuro, y quien no se prepara, se queda atrás. Tan sencillo como eso. Esperemos ahora que la innovación no se detenga, y que la competencia haga algo y rápido. Android ya ha anunciado Android 3.0 para Tablets, HP viene con su TouchPad (con el Palm Web OS), y RIM con su Blackberry PlayBook - solo falta Microsoft, quien se ha quedado dormido como un gran dinosaurio esperando que los pequeños y más ágiles mamíferos, mágicamente desaparezcan... Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

"“Insistir, persistir, resistir y nunca desistir” esa es la formula,...seguimos contigo José...Ah! y Feliz Navidad..."

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax