Tecnología Visual

|

viernes, diciembre 4, 2009

|

Reflexiones es un espacio en donde se muestran conversaciones hipotéticas de la vida cotidiana en varias eras del futuro de la humanidad, basado en artículos de eliax. El objetivo es presentar la vida del futuro no tanto desde un punto de vista tecnológico, sino que mas bien desde un punto de vista humano. Mas información en este enlace. Reflexiones es un espacio en donde se muestran conversaciones hipotéticas de la vida cotidiana en varias eras del futuro de la humanidad, basado en artículos de eliax. El objetivo es presentar la vida del futuro no tanto desde un punto de vista tecnológico, sino que mas bien desde un punto de vista humano. Mas información en este enlace.Reflexiones 14: Hay que tener visión... En un futuro no lejano... Paciente: Doctor, entonces, en mi caso, ¿cuáles opciones tengo? Doctor: Pues bien, debes sentirte afortunado porque tienes dos opciones, las dos iguales de buenas. La primera es que podemos retirar tu ojo dañado, y con ingeniería genética hacer que te crezca otro ojo en el espacio de unas pocas semanas. Paciente: ¡Otro ojo! ¿Pero será igual que el mío? Doctor: Igual no, pero mejor sí, ya que removeremos de tu ADN los problemas genéticos que cargas en tu genoma, y de paso haremos otras modificaciones para que el ojo posea una visión perfecta. Sin embargo, al final no notarás una diferencia visual entre el nuevo ojo y el que perdiste. Paciente: Hummm... ¿y la segunda opción es peor o mejor que esta? Doctor: ¡Ja Ja! Buena pregunta, dejaré que tú mismo decidas eso... La segunda opción consiste de removerte el ojo dañado, y opcionalmente el segundo ojo que te funciona bien para... Paciente: ¡Qué! ¡¿es broma lo que dice?! Doctor: No, no es broma, pero déjame terminar de hablar... Te removemos uno o ambos ojos, pero en su lugar te hacemos un implante de uno o dos ojos biónicos. Paciente: ¿Como en los anuncios de Internet? Doctor: Exactamente, como los anuncios en Internet. Paciente: ¿Pero no que esa tecnología no se había perfeccionado aun? Doctor: No se había perfeccionado hasta hace un par de años atrás, pero acabamos de recibir aprobación de la FDA y otras entidades afiliadas en el mundo para proceder con la técnica, ya que las pruebas dieron excelentes resultados en todos los pacientes. Paciente: ¿Pero no existen algún riesgo? ¿Qué gano yo con este procedimiento sobre el de ingeniería genética? Doctor: Pues primero, sí, existen riesgos, pero son mínimos y podemos repetir el procedimiento tantas veces queramos hasta que quede bien en el peor de los casos, y tu póliza de seguros cubre esa posibilidad, y en cuanto a los beneficios son muchos que debes contemplar... Para empezar, debes saber que este implante reemplaza naturalmente tu ojo biológico en todos los sentidos, lo que significa que como mínimo funciona igual que uno natural. De paso aparenta un ojo normal y solo con una inspección de cerca podría un experto saber que es un ojo artificial. Lo segundo es que debido a que no es un ojo biológico, que podemos hacer que este haga cosas que nunca soñaste, y las cuales podrás dominar con poco tiempo de entrenamiento. Por ejemplo, la percepción de la definición de la imagen que verás será muchísimo mas alta que tu ojo natural, con mejores contrastes, colores, etc. Pero además, te ofrecemos módulos opcionales que te permitirán ver mas allá del espectro electromagnético que vemos los humanos, permitiéndote ver por ejemplo luz infrarroja o ultravioleta, permitiéndote apreciar toda una gama de colores que no sabías que existían, y de paso permitiéndote ver muchísimo mejor en todo tipo de ambientes, incluso nocturnos. Como si fuera poco podemos opcionalmente habilitar un receptor de video inalámbrico de modo que todos tus dispositivos electrónicos desplieguen imágenes directamente a tu cerebro, o flotando encima del mundo que percibes. Incluso, podemos apagar por completo el mundo externo y presentarte solo un mundo virtual que será bastante convincente para tu cerebro, al estilo de esa película clásica The Matrix. Paciente (con sonrisa y cara de asombroso): Ehhhh Doctor, deténgase ahí... Si usted está hablando en serio, y creo que lo está, y mi seguro lo cubre, solo dígame en donde firmo para que me haga ese procedimiento hoy mismo... Reflexión inspirada en este articulo y en este otro.... Lee las otras Reflexiones en eliax... autor: josé elías |

|

|

|

|

|

miércoles, diciembre 2, 2009

|

|

Una de las propiedades mas humanas es el sentido del tacto, el cual no había sido replicado de manera factible en robots, pero ahora un equipo de científicos de Ghent University en Bélgica han creado un nuevo tipo de piel sintética que utiliza una forma fundamentalmente diferente de detectar el sentido del tacto a como lo hacemos lo humanos.

En este nuevo sistema, se crea una piel artificial debajo de la cual se coloca una red de sensores ópticos. Acorde se presiona la superficie de esta piel sintética, los sensores fotónicos detectan la mas mínima variación en presión, registrando eso como un voltaje el cual se puede medir de manera extremadamente exacta, pudiéndose registrar hasta la mas mínima cantidad de presión. Lo que este invento significa es que pronto los robots tendrán la capacidad de sentir fluctuaciones en sus pieles de una manera muchísimo mas precisa que los humanos. Inclusive ya se habla en el artículo de dotar a la última generación de robots cirujanos de esta tecnología para hacerlos muchísimo mas sensibles en su trabajo. Y si quieren ver mas noticias similares no dejen de visitar la sección de Robots en eliax. ¡Gracias al lector Xavier Segura por la noticia! Fuente de la noticia Fuente secundaria de la noticia autor: josé elías |

|

|

|

|

|

miércoles, noviembre 25, 2009

|

|

Cualquier modelador de objetos tridimensionales (3D) sabe lo costoso que es escanear un objeto profesionalmente para que te devuelvan una versión virtual en un archivo, sin embargo, como verán en esta demostración por un investigador de nombre Qi Pan de la Universidad de Cambridge en el Reino Unido, es posible que pronto eso sea cosa del pasado.

Lo que este investigador ha logrado es perfeccionar una técnica que permite utilizar una cámara web como un digitalizador o escaneador en 3D, el cual no solo capta formas de manera similar a como lo hacemos los humanos, sino que también texturas. Algo impresionante del video es que todo lo que verán es hecho en tiempo real, y noten como según el investigador rota el modelo, el software va reconociendo poco a poco la forma de tal modelo. El software tiene el nombre de ProFORMA (Probabilistic Feature-based On-line Rapid Model Acquisition), y por ahora es solo un proyecto de investigación, aunque sería interesante ver esto funcionando con modelos mas complejos que el mostrado en el video. Un uso futuro que me puedo imaginar para esto es en video-juegos, en donde con una cámara este te reconozca y escanee en tiempo real, y te inserte en el juego que ves en la pantalla. Otro uso es para arquitectos, quienes podría simplemente utilizar un celular con una cámara para "escanear" un edificio en tiempo real con solo caminar alrededor de este. No me sorprendería si esto terminara en manos de una empresa como Google algún día para mejorar sus mapas con mejor información 3D... Página oficial del proyecto Video a continuación (enlace YouTube)... Previamente en eliax: Tarjetas deportivas que interactúan en 3D con tu cámara web (Marzo 2009) Asombroso video de Realidad Aumentada en el iPhone (Abril 2009) Realidad Aumentada con Star Trek, con cámara web y página impresa (Mayo 2009) Confirmado: "Natal" para el Xbox 360 detecta tus movimientos, te reconoce (Junio 2009) autor: josé elías |

|

|

|

|

|

martes, noviembre 24, 2009

|

Si recuerdan, hace casi un año atrás que les presenté en eliax la noticia de un misterioso monitor curvado presentado por Alienware (desde entonces la empresa fue comprada por Dell, aunque ninguna empresa tiene relación con la creación o venta del monitor), y ahora por fin sale al mercado en general. Si recuerdan, hace casi un año atrás que les presenté en eliax la noticia de un misterioso monitor curvado presentado por Alienware (desde entonces la empresa fue comprada por Dell, aunque ninguna empresa tiene relación con la creación o venta del monitor), y ahora por fin sale al mercado en general.Se trata del Ostendo CRVD, un monitor semi-envolvente con resolución de 2880 x 900, que "tras bastidores" es en realidad 4 monitores de 900 x 720 colocados verticalmente uno al lado del otro de manera bastante indetectable. Lo mejor es que puedes utilizar varios de estos juntos para crear un ambiente envolvente en casi 180 grados (o mas) si lo deseas, como podrán apreciar en el asombroso video. Lo único negativo de este monitor es el precio, el cual a US$6,499 dólares me lo encuentro excesivo, lo que significa que esto solo verá la luz en mercados bien nichos (como algunos ejecutivos que manejen la bolsa de valores, editores de cine de gran calibre, etc). No dejen de ver el video que demuestra el uso de 3 de estos monitores juntos (¡es decir, casi US$20 mil dólares en monitores!) jugando un video-juegos de autos de carreras. Se les aguará la boca a los amantes de estos juegos :) Página oficial del producto Fuente de la noticia Video a continuación (enlace YouTube)... Previamente en eliax: El monitor curveado de Alienware (Enero 2008) Conecta hasta 16 monitores a tu PC, 10240 x 6400 pixeles, 65.5 Megapixeles (Noviembre 2009) autor: josé elías |

|

|

|

|

|

lunes, noviembre 16, 2009

|

Tal cual les informé por medio del canal oficial de eliax en Twitter hace unos días, Google ya lanzó oficialmente soporte para videos en resolución de 1080p en YouTube, es decir, videos con resolución de 1920 x 1080 pixeles. Tal cual les informé por medio del canal oficial de eliax en Twitter hace unos días, Google ya lanzó oficialmente soporte para videos en resolución de 1080p en YouTube, es decir, videos con resolución de 1920 x 1080 pixeles.Es importante notar que para disfrutar de tales videos necesitas tres cosas: 1. Una muy buena conexión a Internet, sino vas a hacer un buen ejercicio en paciencia mientras esperas que descarguen esos videos. 2. Un monitor capáz de reproducir una resolución similar a 1080p, ya que si por ejemplo tu monitor está seteado para una resolución de 1024x768 pixeles, entonces no verás mas detalle que el mismo video en resolución de 720p (1280 x 768). 3. Una PC o Laptop con un CPU bastante potente como para decodificar el video Flash en 1080p, el cual demanda muchísimo mas de lo que te imaginas (en un Intel Core 2 Duo, puede fácilmente comerse el 85% de tu CPU). Si no, verás el video como si fuera en cámara lenta, saltando por todas partes. Una buena noticia es que a inicios del 2010 Adobe planea lanzar la versión 10.1 de Flash, que será la primera en utilizar aceleración del GPU (es decir, de tu chip de gráficos) para tales videos, lo que significa que inclusive una Netbook con un chip de gráficos ION de NVIDIA dará la talla para ver tales videos. Mientras tanto, esto es solo para algunos afortunados... :) Un video de prueba (asegúrate de hacer clic sobre el icono que expande el video para cubrir toda tu pantalla) Previamente en eliax: YouTube lanzando videos en alta resolución (Marzo 2008) Google YouTube a permitir videos de larga duración (Junio 2008) YouTube a ofrecer videos de larga duración de CBS. TV asustada (Octubre 2008) Rumor: YouTube a ofrecer películas de larga duración (Noviembre 2008) YouTube ya ofrece oficialmente videos en Alta Definición (HD) (Diciembre 2008 - en ese entonces eran videos 720p) Opinión: ¿YouTube a dejar atrás a Flash Video? ¿HTML 5 a reinar? (Junio 2009) YouTube ya sirve 1,000 Millones de videos cada día (Junio 2009) autor: josé elías |

|

|

|

|

|

jueves, noviembre 12, 2009

|

En eliax a través de los años han visto varias soluciones para conectar varios monitores a sus PCs (vean enlaces al ginal de esta noticia), pera esta de Matrox es la madre de todas esas otras soluciones (salvo quizás, esta excepción). En eliax a través de los años han visto varias soluciones para conectar varios monitores a sus PCs (vean enlaces al ginal de esta noticia), pera esta de Matrox es la madre de todas esas otras soluciones (salvo quizás, esta excepción).Es la Matrox M9188, una tarjeta con 1o 2GB de memoria de video, que ocupa un puerto PCIe x16 en tu PC y que tiene 8 salidas simultáneas de miniDisplayPort, DisplayPort o DVI, en donde cada monitor puede tener una resolución máxima de 2560 x 1600 pixeles. Como si fuera poco, puedes poner dos de estas tarjetas funcionando en paralelo en tu PC, para un total de 16 monitores, los cuales si los pones en configuración de 4 monitores horizontales por 4 monitores verticales obtienes una monstruosa resolución de 10240 x 6400 pixeles, o 65.5 Megapixeles. Suficiente como para jugar a Doom en toda su gloria... La tarjeta es compatible con Windows XP, Windows Vista, Windows 7 y Linux, y cuesta US$1995 dólares... Página oficial de la Matrox M9188 Nota de Prensa oficial Previamente en eliax: Conecta dos monitores externos a tu Laptop (Noviembre 2005) Conecta 6 monitores, teclados y ratones a una sola Linux PC (Marzo 2006) World of Warcraft en multi-monitores con Matrox TripleHead2Go (Noviembre 2006) Una pantalla de 220 Megapixeles, utiliza 80 tarjetas de video (Agosto 2007) Conecta hasta 6 monitores a 1600x1200 en tus puertos USB (Noviembre 2007) Conecta un monitor de manera inalámbrica por USB (Agosto 2008) 12 pantallas sincronizadas te dan 27.6 millones de pixeles (Octubre 2008) autor: josé elías |

|

|

|

|

|

martes, noviembre 3, 2009

|

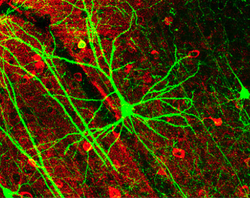

Científicos del Delft University of Technology en los Países Bajos (Netherlands) acaban de utilizar una cámara similar a esta que les hablé en el 2005 que por primera vez permite ver una neurona individual funcionando, es decir, disparando y reciiendo señales nerviosas a (y desde) otras neuronas. Científicos del Delft University of Technology en los Países Bajos (Netherlands) acaban de utilizar una cámara similar a esta que les hablé en el 2005 que por primera vez permite ver una neurona individual funcionando, es decir, disparando y reciiendo señales nerviosas a (y desde) otras neuronas.La cámara toma 1 millón de fotogramas por segundo, y es lo suficientemente diminuta como para captar estos eventos en vivo. Como explican en el artículo, se necesitaba no solo alta velocidad y alta sensibilidad a la luz para grabar video a estas velocidades, sino que además una alta sincronización para que cada fotograma ocurra en el mismo espacio de tiempo que el anterior. A tal fin el dispositivo utiliza una hilera de detectores, cada uno capaz de detectar un solo fotón de luz (lo que en sí es bastante asombroso) a los que llaman SPADs, y a los que tienen conectados a un cronómetro especializado con una exactitud de unos 100 picosegundos. Para que tengan una idea, 1 segundo tiene 1,000,000,000,000 picosegundos. En el prototipo, el fotosensor que graba el video está compuesto de 1024 SPADs (lo que me indica un resolución de 32 x 32 pixeles). El objetivo de esta tecnología es ahora filmar un grupo completo de neuronas para ver los patrones generados entre estas, lo que sin duda nos ofrecerá un gran salto en el entendimiento de estas creaciones de la naturaleza, lo que de paso nos permitirá clonarlas a un ambiente sintético de manera mucho mas eficiente que lo que lo hacemos hoy día. O en otras palabras, acabamos de dar un gran paso en la creación de cerebros sintéticos (con tecnologías como esta) basados en patrones biológicos. Como ven, no estamos tan lejos como muchos se imaginan de un Cerebro Artificial... Fuente de la noticia Máquinas en el Paraíso (donde hablo de estos temas en mas profundidad) autor: josé elías |

|

|

|

|

|

sábado, octubre 31, 2009

|

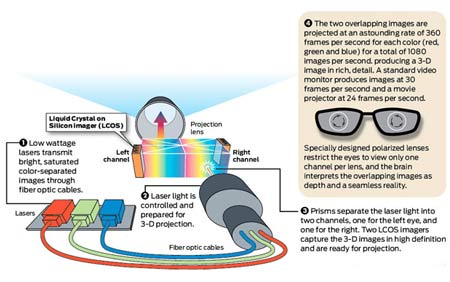

Buenas noticias para los fans del cine en casa: La empresa HDI no solo será la primera en el mercado en el 2010 con un televisor basada en tecnología de rayos láser, sino que además este vendrá con tecnología para desplegar imágenes en 3D (tridimensionales). Buenas noticias para los fans del cine en casa: La empresa HDI no solo será la primera en el mercado en el 2010 con un televisor basada en tecnología de rayos láser, sino que además este vendrá con tecnología para desplegar imágenes en 3D (tridimensionales).La tecnología de Láser TV ya lleva varios años en desarrollo (en eliax se ha estado reportando su progreso desde al menos el 2006), y promete ser una tecnología revolucionaria, proveyendo una imagen de alto contraste sin precedentes con una amplia gama de colores. Para que tengan una idea, según HDI, sus televisores láser 3D consumen 80% menos energía que uno tradicional de plasma en 2D del mismo tamaño, así como pesa 75% menos, y de paso vendrán a un costo menor. Eso del "costo menor" habría que ver, puesto que en un determinado tamaño de televisores hay todo tipo de precios, y hoy día un buen televisor Plasma o LCD de 42" se puede obtener por menos de US$1,000 dólares. Sin embargo, el hecho de que soporte 3D, y que la imagen supuestamente sea muchísimo mejor que lo mejor que Plasma y LCD pueda ofrecer, y que venga en tamaños de 100", es suficiente para aguarle la boca al menos a este fan del cine... Fuente de la noticia autor: josé elías |

|

|

|

|

|

jueves, octubre 29, 2009

|

Si no haz visto a Google Maps Navigation en acción, he aquí un video que te muestra bastante bien lo que es capaz de hacer. A los que no sepan, Google Maps Navigation es un sistema de navegación para tu auto (o a pie) con GPS y te celular inteligente (por ahora, Google Android) que te indica cómo llegar a cualquier lugar con instrucciones visuales y con voces sintéticas. Si no haz visto a Google Maps Navigation en acción, he aquí un video que te muestra bastante bien lo que es capaz de hacer. A los que no sepan, Google Maps Navigation es un sistema de navegación para tu auto (o a pie) con GPS y te celular inteligente (por ahora, Google Android) que te indica cómo llegar a cualquier lugar con instrucciones visuales y con voces sintéticas.Noten algunas cosas: - Google Maps Navigation básicamente hace lo mismo que equipos dedicados que cuestan entre US$50 y US$300 dólares, y es gratis. - Incluso hace cosas que equipos dedicados no hacen, como recibir comandos de voz e integrarlos al mapa. Por ejemplo, puedes hablarle a esta aplicación y decirle que quieres ir a un cine cercano en donde estén dando la película X, o que quieres ir a un museo en donde haya una exhibición de Salvador Dalí. - Algo que equipos dedicados tienen que es mejor que esta oferta gratuita de Google es que tienen ya almacenados los mapas a utilizar, mientras que Google Maps Navigation requiere de una conexión a Internet. Sin embargo, sí guarda una buena parte de los mapas pasados y a tu alrededor, así como una parte de los mapas en la dirección a donde vas, lo que significa que si no tienes conexión celular en teoría podrías seguir manejando. - El sistema te habla las instrucciones hacia donde debes manejar ("dobla a la derecha en la siguiente esquina"). - Integra de manera opcional la "vista satelital" de Google Maps, lo que en muchos casos es mucho mejor que un simple diagrama de mapas vectoriales, ya que te da un mejor sentido de donde estás.  - Está consciente del tráfico de vehículos a tu alrededor y te avisa de las condiciones de tráfico hacia adelante. Esto lo hace combinando datos públicos en tiempo real (cuando estén disponibles) de varias ciudades, sí como de otros usuarios de Google que reportan su localización, lo que ayuda a Google saber qué tan rápido se mueven y deducir que tan lento (o rápido) está el tránsito. Si notas que hay embotellamientos de tránsito adelante, puedes pedirle al sistema que cambie tu ruta a una alternativa y mas rápida. - Está consciente del tráfico de vehículos a tu alrededor y te avisa de las condiciones de tráfico hacia adelante. Esto lo hace combinando datos públicos en tiempo real (cuando estén disponibles) de varias ciudades, sí como de otros usuarios de Google que reportan su localización, lo que ayuda a Google saber qué tan rápido se mueven y deducir que tan lento (o rápido) está el tránsito. Si notas que hay embotellamientos de tránsito adelante, puedes pedirle al sistema que cambie tu ruta a una alternativa y mas rápida.- Puedes hacer búsquedas de cosas sobre la ruta que piensas seguir. Así que por ejemplo si vas de una ciudad a otra y te da hambre, puedes decirle a Google que te indique los restaurantes (incluso, de algún tipo de comida en específico) que se encuentran en ruta, y este te los muestra en el mapa. Incluso puedes decirle que te indique donde existen cajeros automáticos, empresas de transporte, estaciones de combustible, hospitales, etc. Básicamente cualquier cosa que esté en la "nube a de información" de Google. - Está diseñado para Android 2.0, y detecta (con una base especial) que estás en un automóvil y su interfaz cambia acorde, para hacerte mas fácil tocar botones grandes y especializados para un auto.  - Se integra con Google Street View para permitirte ver de manera virtual en donde estás. Así que por ejemplo cuando llegues a un lugar Street View te puede apuntar el lugar exacto a donde debes ir, con imagen y todo del lugar, en vez de solo decirte que llegaste y dejarte a ti a buscar en los alrededores a donde debes ir. Esto también sirve como una manera alternativa de guiarte, en donde en vez de presentarte un mapa en tiempo real, lo que hace es que te muestra fotos reales del lugar en donde está, con flechas y lineas que te guían diciéndote exactamente hacia donde debes ir y donde debes doblar (esto si duda será bastante útil). - Se integra con Google Street View para permitirte ver de manera virtual en donde estás. Así que por ejemplo cuando llegues a un lugar Street View te puede apuntar el lugar exacto a donde debes ir, con imagen y todo del lugar, en vez de solo decirte que llegaste y dejarte a ti a buscar en los alrededores a donde debes ir. Esto también sirve como una manera alternativa de guiarte, en donde en vez de presentarte un mapa en tiempo real, lo que hace es que te muestra fotos reales del lugar en donde está, con flechas y lineas que te guían diciéndote exactamente hacia donde debes ir y donde debes doblar (esto si duda será bastante útil).- Aunque no es oficial, todos esperamos que Google saque una versión para el iPhone eventualmente. Y si no llega, Apple tendrá una gran tarea de hacer algo similar, ya que si no, esta será otra buena razón para que muchos nos mudemos a Android... - Esta es una versión "beta" (aun en desarrollo), lo que significa que aun veremos mas mejoras. Entre las que espero hagan: Poder guardar mapas antes de un viaje, por si no tienes una conexión a Internet. Integración de técnicas de Realidad Aumentada para reemplazar a Street View, de tal manera que cuando llegues a un lugar puedas apuntar la cámara de tu celular y moverla en 360 grados y que un marcados hacia el lugar hacia donde debas ir aparezca "flotando" sobre el lugar real. Página oficial de Google Maps Navigation Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, octubre 11, 2009

|

Todos sabemos que en el verano, un techo oscuro absorbe mucho mas los rayos del Sol y por consiguiente aumenta la temperatura en tu casa, así como en el invierno un techo blanco refleja los rayos del Sol haciendo mas difícil expulsar el frío. Todos sabemos que en el verano, un techo oscuro absorbe mucho mas los rayos del Sol y por consiguiente aumenta la temperatura en tu casa, así como en el invierno un techo blanco refleja los rayos del Sol haciendo mas difícil expulsar el frío.Pues ahora un equipo de científicos del MIT (Instituto de Tecnología de Massachussetts) tiene una solución: Tejas que automáticamente cambian al color negro con las temperaturas de invierno, y al color blanco en el verano. Esto significa que ahora nuestros hogares podrán ser mucho mas confortables independiente de la temperatura exterior, y mas importante aun, nos ahorraremos mucho dinero en energía y de paso ayudaremos a contaminar menos el medio ambiente. Esto se debe a que ahora si tienes un aire acondicionado o un sistema de calefacción, este tendrá que trabajar mucho menos. Según los inventores de estas novedosas tejas, en su estado en blanco estas reflejan el 80% de la luz solar, representando un ahorro de energía de un 20%, y en su estado negro estas reflejan solo el 30% de la luz solar, representando un ahorro que aun no han cuantificado (en estos momentos están realizando experimentos con el modo negro). A este tipo de material utilizado en las tejas sus inventores han bautizado como Thermeleon (como "camaleón térmico"), y aun lo están perfeccionando haciéndolo lo mas barato posible (una gran consideración para ser comercialmente viable). Fuente de la noticia autor: josé elías |

|

|

|

|

|

viernes, octubre 9, 2009

|

Hace apenas 2 años reporté acá en eliax un hito en la ciencia en donde se pudo capturar por primera vez en video el movimiento de un solo electrón, y apenas hace 2 meses también reporté que IBM logró fotografiar los enlaces entre átomos. Hace apenas 2 años reporté acá en eliax un hito en la ciencia en donde se pudo capturar por primera vez en video el movimiento de un solo electrón, y apenas hace 2 meses también reporté que IBM logró fotografiar los enlaces entre átomos.Hoy les informo de otro gran hito logrado hace unas pocas semanas unos investigadores lograron fotografiar un solo electrón. A diferencia de captar el movimiento de un electrón en video, esto captó al electrón mismo en todo detalle, captando incluso lo que se interpreta como su "nube de posibilidades". Recuerden que la Mecánica Cuántica establece que un electrón no está en realidad un solo lugar absoluto en el espacio, sino que en una nube de posibilidades, por lo que se ve es una imagen difusa de este. Como expliqué en el artículo del 2007, y para que tengan una idea de lo increíble que es esto, noten que la masa de un electrón es una mil-millonésima de una mil-millonésima de una mil-millonésima de un gramo, y cuyas dimensiones son imposibles de imaginar para la mente humana. El equipo que logró esta hazaña, lo hizo modificando un microscopio de emisiones de campo de electrones, inventado en los 1930s, y lo modificaron para aumentar su resolución considerablemente. Como dice el científico que reporta la noticia en la fuente, él no solo no creía que viviría para ver esto, sino que inclusive pensaba que era imposible lograrlo, pero como he repetido incontable veces en eliax, cuando la ciencia y la tecnología avanzan exponencialmente, las cosas llegan muchísimo mas rápido de lo que la mayoría de las personas se imaginan... Fuente de la noticia autor: josé elías |

|

|

|

|

|

miércoles, septiembre 30, 2009

|

NVIDIA recién reveló la base de su nueva arquitectura gráfica hacia el futuro próximo, y lo único que creo cualquier persona que lea las especificaciones técnicas puede decir es... nada, por el asombro. NVIDIA recién reveló la base de su nueva arquitectura gráfica hacia el futuro próximo, y lo único que creo cualquier persona que lea las especificaciones técnicas puede decir es... nada, por el asombro.La nueva arquitectura a la cual NVIDIA ha apodado con el código Fermi, contendrá 16 procesadores del tipo stream, cada uno con 32 núcleos, para un total de 512 núcleos. Como si fuera poco, y para poder mantener a todos esos núcleos ocupados, Fermi adoptará el nuevo tipo de memoria GDDR5 Pero lo mejor de todo es que esta arquitectura estará optimizada para aplicaciones que utilicen el GPU como un procesador genérico, lo que significa que arquitecturas como la de Grand Central en el nuevo OS X 10.6 Snow Leopard tendrán de repente 512 procesadores mas para acelerar todo tipo de tareas. Esto también representará un gran salto en velocidad y realismo visual en aplicaciones 3D (en particular video-juegos y diseño y animación 3D), trayendo niveles de super-computación a las PCs de escritorio (y prontamente, laptops y netbooks). Según NVIDIA, un chip con estos 512 núcleos contendrá unos 3 mil millones de transistores. Esta es una de esas cosas que ilustran bastante bien el crecimiento exponencial de la tecnología, pues hace apenas un par de años que los chips de 2 núcleos empezaron a filtrarse en el mercado, y hoy día ya hablamos de 512. Cabe notar que NVIDIA ha implementado en esta nueva generación de GPUs una tecnología que llaman GigaThread, que escala a "miles" de hilos de ejecución de código, lo que nos puede dar un indicio de lo que nos depara el futuro no lejano. Algo me dice que esta arquitectura tendrá un tremendo impacto en el mundo de la investigación científica, y además de paso nos servirá como una pista de lo que podremos esperar de la próxima generación de consolas de video-juegos al mediano plazo (que pienso empezaremos a ver en el 2011). Página oficial de Fermi en NVIDIA Previamente en eliax: NVIDIA muestra Raytracing en tiempo real y alta definición (Agosto 2008) Finalizada la especificación OpenCL 1.0 en tiempo récord (Diciembre 2008) NVIDIA anuncia tarjeta con 480 núcleos y casi 2 TeraFlops (Enero 2009) Sobre evolución del GPU, e implementación de AMD de OpenCL en CPU/GPU (Agosto 2009) autor: josé elías |

|

|

|

|

|

lunes, septiembre 28, 2009

|

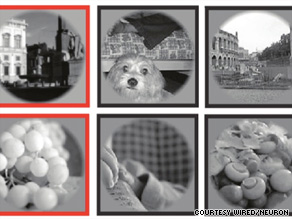

Hoy les hablaré de una tecnología que sin duda nadie creería posible apenas hace pocos años. Se trata de una tecnología que se está desarrollando en University of California at Berkeley que permite, por mas asombroso que aparente, saber lo que haz visto antes o recientemente, con solo escanear tu cerebro en una máquina fMRI (Functional Magnetic Resonance Imaging). Hoy les hablaré de una tecnología que sin duda nadie creería posible apenas hace pocos años. Se trata de una tecnología que se está desarrollando en University of California at Berkeley que permite, por mas asombroso que aparente, saber lo que haz visto antes o recientemente, con solo escanear tu cerebro en una máquina fMRI (Functional Magnetic Resonance Imaging).Antes de proseguir aclaremos que esta es una tecnología aun en su infancia, pero dado los primeros experimentos, y al igual que casi toda tecnología desarrollada por humanos, es solo cuestión de tiempo hasta que esta se perfeccione a un grado tal que parecerá magia para personas que viven hoy día. Lo que esta técnica hace es analizar las áreas de tu cerebro concerniente a tus memorias visuales, y sin saber absolutamente nada de ti, poder literalmente "sacar" imágenes de tu cabeza. Así que por ejemplo, digamos que en un futuro alguien comete un crimen, con esta tecnología sería posible entrar en la cabeza del sospechoso y literalmente "ver" lo que este vio recientemente con sus ojos. Mas parecido a la ciencia ficción pocas cosas... Esto me recuerda a una tecnología casi igual de asombrosa de la cual les hablé en el 2005 acá en eliax, en donde es posible que una computadora conectada a un cerebro puede ver lo que este esté viendo en ese momento (el sistema fue probado exitosamente con gatos). La diferencia con esta nueva tecnología es que esta puede indagar en tu pasado y no solo en el presente (y no duden que veremos tecnologías en un futuro no lejano que podrán extraer lo que imaginemos hacer en un futuro, similar a la película Minority Report). Entre las aplicaciones citadas están que en un futuro una pueda diseñar visualmente al estilo Photoshop o Autocad, pero con solo pensarlo sin ni siquiera tocar un ratón. Es decir, sistemas computarizados conectados a nuestros cerebros que interpretarán nuestras imágenes visuales que pensamos y las traducen a imágenes digitales, lo que sin duda acelerará enormemente no solo el desarrollo de estas imágenes, sino que la comunicación visual entre humanos, ya que me imagino un futuro como el que expliqué en este artículo, en donde enviaremos nuestros pensamientos (en este caso, imágenes) directamente de una mente a otra, como si de telepatía se tratara, pero por puros medios tecnológicos. Y a propósito, si este tema les interesó, y quisieran aprender mas sobre las repercusiones que esta tecnología conllevará, no dejen de leer este artículo reciente que trata justo sobre estos temas. Fuente de la noticia en CNN autor: josé elías |

|

|

|

|

|

viernes, septiembre 25, 2009

|

|

Como muchos saben, desde hace al menos un par de años existen rumores de que Apple está desarrollando una iTablet o iPad, que será una especie de iPod Touch pero del tamaño de la pantalla de una netbook (unas 9" o 10"), que soportará gestos multi-táctil, y (especulo yo) tendrá acceso al App Store.

Pues recientemente han surgido rumores de que Microsoft también tiene un proyecto similar en marcha, y este video que verán hoy es la primera "vista preliminar" que muestra cómo funcionaría tal dispositivo. Se llama tentativamente el Microsoft Courier, y algo interesante es que consiste de dos pantallas que se doblan sobre sí como si de un libro tradicional de tratara. Esto se ve bastante genial, y sin duda es uno de los mejores demos tecnológicos que ha salido de Microsoft desde el Microsoft Surface o el Microsoft Photosynth. ¡Gracias al lector Amaury Rodriguez por el enlace al video! Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

jueves, septiembre 24, 2009

|

Los científicos de MIT (el Instituto de Tecnología de Massachussetts) están trabajando junto con varios equipos de otras universidades, centros de investigación y entidades privadas estadounidenses para hacer realidad su propia versión de un ojo biónico (del tipo que hemos hablado previamente en eliax en varias ocasiones - ver enlaces abajo así como Máquinas en el Paraíso). Los científicos de MIT (el Instituto de Tecnología de Massachussetts) están trabajando junto con varios equipos de otras universidades, centros de investigación y entidades privadas estadounidenses para hacer realidad su propia versión de un ojo biónico (del tipo que hemos hablado previamente en eliax en varias ocasiones - ver enlaces abajo así como Máquinas en el Paraíso).Este nuevo ojo biónico está diseñado específicamente para pacientes que han quedado ciegos debido a retinitis pigmentosa o a degeneración macular por edad avanzada, las cuales son las dos causas principales de ceguera en el mundo. El ojo biónico consiste de un implante que se coloca alrededor del iris del paciente (como si de un anillo se tratara), y que recibe información visual de una cámara montada en unas gafas que el paciente utiliza. La información de las gafas es transmitida la corta distancia entre estas y el ojo biónico de manera inalámbrica. En ese momento, el implante toma las señales visuales, las transforma en señales eléctricas, y estimula directamente los nervios que anteriormente eran estimulados por la retina biológica del paciente, en efecto reemplazando una parte del ojo por un componente artificial. Una diferencia entre este sistema y otros ojos biónicos actualmente en desarrollo es que el sistema electrónico que procesa todo está detrás de la retina, lo que reduce considerablemente las posibilidades de daños. Otra diferencia es que todo el implante está envuelto en un compuesto de titanio, a diferencia de silicona que permite con el tiempo filtraciones de agua sobre los dispositivos electrónicos. En donde este modelo está detrás de otros ojos biónicos es en pruebas con personas. Sin embargo por ahora ya han realizado pruebas con cerdos (cuyos ojos tienen una composición bastante similar a la de los humanos), a quienes se les han hecho los implantes por períodos de hasta 10 meses. Una aclaración final es que estos ojos biónicos de primera generación todavía no pueden ofrecer ni cerca de la resolución o definición de un ojo biológico, pero por ahora ese no es el objetivo de estas investigaciones. Por ahora lo que se quiere lograr es un grado de visión mínimo como para que estos pacientes sean autosuficientes visualmente en el mundo. Sin embargo no duden que así como las computadoras nos dejaran hace mucho tiempo atrás en temas de computación cruda, que así mismo estos ojos un día ofrezcan un tipo de visión muchísimo mas avanzada que los ojos de hoy día... Fuente de la noticia autor: josé elías |

|

|

|

|

|

viernes, septiembre 18, 2009

|

|

Desde hace un par de años les vengo hablando de una tecnología de Microsoft llamada Photosynth (aunque desde el 2006 les vengo hablando de este tipo de tecnologías), la cual permite reconstruir escenarios en casi-3D basado puramente en interpolar miles de fotografías. Es decir, si tomamos 1,000 fotografías de la Torre Eifel en París, y las ponemos en Photosynth, este detecta cuales fotos tienen algo en común, y las pone unas al lado de las otras como si se tratara de una gran pizarra en 3D.

Esa tecnología en realidad fue desarrollada por investigadores de la Universidad de Washington, y ahora los mismos investigadores han dado un salto aun mas inmenso, mejorando los algoritmos matemáticos permitiéndoles a ellos ahora recrear no solo objetos en verdadero 3D, y no solo de un solo lugar (como la Torre Eifel), sino que de ciudades enteras. Como dicen en el artículo, ahora pueden procesar una cantidad muchísimo mas grande de fotos en un tiempo práctico. Como ejemplo, citan que en el caso de Roma se utilizaron 500 procesadores durante 13 horas para compaginar 150,000 fotos (tomadas del popular portal de fotos Flickr, es decir, fotos tomadas por personas comunes y corrientes con todo tipo de cámaras) y ver como se relacionaban unas con otras, y después se dedicaron 8 horas mas para extraer información tridimensional de esos resultados. En cuanto a Venecia se necesitaron 27 y 38 horas respectivamente para procesar 250,000 fotos. Como base de comparación, dicen que los algoritmos en el actual Photosynth tardarían al menos 1 año en hacer el mismo trabajo de Venecia. Lo que mas me interesa de esta noticia sin embargo es que esto tiene un tremendo potencial para la Inteligencia Artificial y el reconocimiento de entornos reales en las mentes virtuales de robots inteligentes. Dado el incremento constante del poder de computación, en una década este tipo de análisis se podrá hacer no en horas, sino que en tiempo real, lo que significa que no estamos lejos de un futuro en donde una máquina obtenga un mejor punto de vista del mundo que todos los humanos juntos. A mas corto plazo sin embargo, sería genial si esta tecnología se integrara con Google Earth, en el sentido de que si hacemos zoom en Google Earth al nivel de las calles, que lo que veamos directamente sobre el mapa sean un entorno 3D deducido por esta tecnología, que de paso sería una excelente manera de mantener actualizado los mapas en lugares de interés (como grandes ciudades) sin necesidad de invertir en costosos satélites (que de paso no ofrecen datos 3D de los lados laterales de edificios, o con la misma resolución que este sistema). Y a propósito, en los videos notarán muchos "cuadritos" en todos lados, en particular en el piso. Esos son los puntos desde donde se tomaron las miles de fotos, según fue deducido por el software. Fuente de la noticia Video 1 a continuación (enlace YouTube)... Video 2 a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

"Gracias por todos los artículos que has publicado día a día, gracias por el esfuerzo y la enseñanza que nos has brindado, es una bendición que en este mundo existan personas como tu, que compartan conocimientos, ideas y filosofía propia sin pedir nada a cambio, ese esfuerzo tuyo ha hecho en mi un seguidor oculto y muy recurrente a este tu blog...

debo mencionar que este artículo me ha dejado pasmado de las bonitas palabras y el gran mensaje que dejas para con tus hijos, y yo personalmente he aprendido mucho y valoro tu filosofía, ya que no es fácil comprender o ver la vida desde un cierto punto, mas aun cuando somos nosotros mismos los que nos enfocamos en otras cosas que creemos que son importantes, de vivir a ciegas si saber que perdemos tiempo imitando, muchas gracias por los artículos que escribes, un saludo y un abrazo desde Perú y mis felicitaciones por tu dedicación en este blog, muchos éxitos."

debo mencionar que este artículo me ha dejado pasmado de las bonitas palabras y el gran mensaje que dejas para con tus hijos, y yo personalmente he aprendido mucho y valoro tu filosofía, ya que no es fácil comprender o ver la vida desde un cierto punto, mas aun cuando somos nosotros mismos los que nos enfocamos en otras cosas que creemos que son importantes, de vivir a ciegas si saber que perdemos tiempo imitando, muchas gracias por los artículos que escribes, un saludo y un abrazo desde Perú y mis felicitaciones por tu dedicación en este blog, muchos éxitos."

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax