Hardware

|

jueves, diciembre 30, 2010

|

|

Ahora los dejo con estas breves de noticias recientes que no quiero dejar pasar en eliax antes de fin de año...

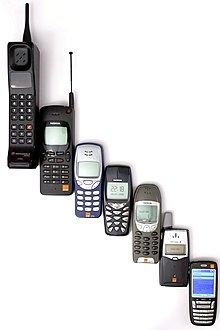

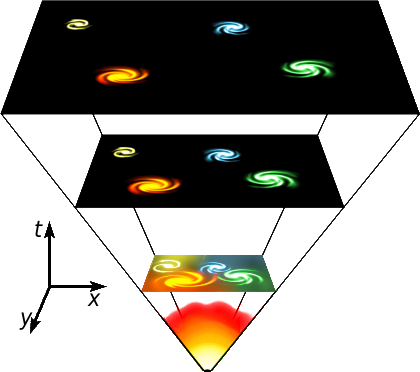

1. Procesador con 1000 núcleos  Científicos de la Universidad de Glasgow recientemente demostraron un prototipo de chip que contiene nada más ni nada menos que 1000 (mil) núcleos (me imagino la cara de los que se compraron un procesador con 4 núcleos recientemente, pensando que tenían "lo último"). Científicos de la Universidad de Glasgow recientemente demostraron un prototipo de chip que contiene nada más ni nada menos que 1000 (mil) núcleos (me imagino la cara de los que se compraron un procesador con 4 núcleos recientemente, pensando que tenían "lo último").El chip fue implementado utilizando un FPGA (Field Programmable Gate Array), que no es más que un chip cuyos conectores internos no son estáticos, sino que pueden ser programados dinámicamente en tiempo real (similar al chip de Skynet en la película Terminator 2). Según sus diseñadores, el chip es 20 veces más rápido que procesadores actuales, y de paso consume menos energía. Para los curiosos, recuerden que Intel ya demostró un prototipo de procesador de 80 núcleos hace 4 años, y hace un par de años anunció que nos preparemos para un futuro con "miles de núcleos", por lo que esto es solo el inicio... fuente 2. Hackers rompen seguridad de celulares GSM utilizando celulares de US$15  En una reciente conferencia de expertos en seguridad, unos hackers demostraron que con 4 celulares de US$15 dólares cada uno, una simple laptop, y software disponible libre y gratuitamente por Internet, ya es posible romper la seguridad de los celulares GSM para no solo obtener copias de los mini-mensajes enviados, sino que escuchar y grabar las conversaciones de las personas. En una reciente conferencia de expertos en seguridad, unos hackers demostraron que con 4 celulares de US$15 dólares cada uno, una simple laptop, y software disponible libre y gratuitamente por Internet, ya es posible romper la seguridad de los celulares GSM para no solo obtener copias de los mini-mensajes enviados, sino que escuchar y grabar las conversaciones de las personas.Según los hackers, entre las cosas que aprendieron en este proyecto es que las operadoras de telefonía móvil ponen un gran esfuerzo en proteger las llaves digitales utilizadas en comunicación entre las centrales y los chips SIM de los celulares, debido a que obviamente es aquí en donde está el negocio, pero a la hora de proteger seriamente las llaves digitales que facilitan la comunicación entre un celular y otro (y que por tanto, protegen tu privacidad), ahí ponen menos esfuerzo. Noten que esto es algo que tiene al menos dos años desarrollándose (como reportado previamente en eliax), pero esto que sin duda es cerca de la cúspide de estos hacks. En cuanto al motivo de estos hackers, alegan que hacen esto para demostrar que es hora de que las empresas de telefonía móvil presten seria atención a GSM, cuya infraestructura de seguridad ya data de hace 20 años. fuente 3. Skype con video-conferencia para el iOS  Esta madrugada (como anuncié entonces por Twitter), apenas 1 días después de publicar mis predicciones y tendencias para el 2011, una de las cuales es la #13, Skype anunció sorpresivamente una versión actualizada de su software para iOS, que activa por fin sus servicios de video-conferencia en iPhone, iPod Touch y iPad. Esta madrugada (como anuncié entonces por Twitter), apenas 1 días después de publicar mis predicciones y tendencias para el 2011, una de las cuales es la #13, Skype anunció sorpresivamente una versión actualizada de su software para iOS, que activa por fin sus servicios de video-conferencia en iPhone, iPod Touch y iPad.En dispositivos con doble cámaras como el iPhone 4 y el iPod Touch de 4ta generación, se pueden hacer llamadas de video en ambas direcciones (enviar video, recibir video). Con el iPhone 3GS curiosamente también permiten esta funcionalidad bi-direccional, pero debido a que el 3GS tiene una sola cámara detrás eso significa que te las tendrás que ingeniar, utilizando la cámara solo al estilo "reportero" para mostrarle a la otra persona lo que vez, o girando la cámara para que te vean sin tu poder ver la pantalla (otra opción es un espejo para hacer ambas cosas). En cuanto a otros dispositivos (como versiones anteriores del iPhone, iPod Touch y el actual iPad), solo puedes recibir el video de la otra persona (aunque algo es mejor que nada, supongo). Otra cosa interesante es que en el iPhone, las video-llamadas funcionan no solo con WiFi, sino que también por la red celular 3G (aunque cuidado, video de cualquier tipo te puede comer en minutos casi cualquier plan básico de datos 3G). Como dije en mi predicción, esto será todo un éxito, y ya esperaremos a ver en el 2011 si se cumple. Por el momento, quien sale feo de todo esto es la tecnología FaceTime de Apple, la cual aun prometiendo mucho, si no se dispersa a otras plataformas de manera universal como lo ha hecho Skype peligrará en poder ser relevante en este mercado de video-llamadas. 4. CityVille eclipsa a FarmVille en Facebook  Si eres un usuario de Facebook, te guste o lo odies es casi seguro que has recibido alguna invitación reciente para jugar "CityVille" recientemente, y además es casi seguro que ya conocías de FarmVille, el fenómeno que captó sobre 80 millones de jugadores en Facebook hasta hace poco. Si eres un usuario de Facebook, te guste o lo odies es casi seguro que has recibido alguna invitación reciente para jugar "CityVille" recientemente, y además es casi seguro que ya conocías de FarmVille, el fenómeno que captó sobre 80 millones de jugadores en Facebook hasta hace poco.Pues ahora CityVille acaba de sobrepasar a FarmVille como el juego más popular dentro de esta gigante red social. Según AppData, hasta hace poco CityVille logró captar 61.7 millones de usuarios, dejando atrás a FarmVille con 56.8 millones de usuarios. Mi sugerencia: Si son personas ocupadas, o tienen familia, o desearían pasar más tiempo lejos de una PC, eviten estos juegos a toda costa, pues son altamente adictivos. Y lo digo por experiencia de algunas personas en mi familia, que están leyendo esto ahora mismo y que saben quienes son, y que parecen zombies jugando estos dos juegos constantemente... :) fuente - Y esta otra fuente dice que ya tienen más de 70 millones de jugadores (en tan solo unas pocas semanas de estar en el mercado). 5. El Simulador Viviente de la Tierra  Un grupo de científicos ha creado un proyecto al que han acuñado "The Living Earth Simulator" o el "LES" ("El Simulador Viviente de la Tierra"), cuyo objetivo es desplegar en tiempo real datos provenientes de miles de millones de sensores y fuentes de datos de todo el planeta en tiempo real, con el objetivo de poder modelar todo lo que ocurre en la Tierra, desde transacciones financieras hasta el tráfico de automóviles, y desde el esparcimiento de enfermedades por el mundo hasta el consumo energético, más todo lo que se podrían imaginar de por medio (conferencias, conciertos, días festivos, accidentes, huracanes, terremotos, actividad aerea, flujo de personas, protestas, el clima, etc). Un grupo de científicos ha creado un proyecto al que han acuñado "The Living Earth Simulator" o el "LES" ("El Simulador Viviente de la Tierra"), cuyo objetivo es desplegar en tiempo real datos provenientes de miles de millones de sensores y fuentes de datos de todo el planeta en tiempo real, con el objetivo de poder modelar todo lo que ocurre en la Tierra, desde transacciones financieras hasta el tráfico de automóviles, y desde el esparcimiento de enfermedades por el mundo hasta el consumo energético, más todo lo que se podrían imaginar de por medio (conferencias, conciertos, días festivos, accidentes, huracanes, terremotos, actividad aerea, flujo de personas, protestas, el clima, etc). Noten que esto proyecto aun no entrará en operación por muchos años, pues están aun por construirse las super-máquinas capaces de procesar un flujo tan masivo de datos, pero el objetivo final es poder entender mejor no solo nuestro planeta sino que a nosotros mismos como sociedad, y quizás con esa información poder tomar mejores decisiones para mejorar la vida en la Tierra... Y a propósito, esto suena como una excelente aplicación para integrar con Google Earth. fuente 6. Rompen récord de tiempo volando por una aeronave  La aeronave Zephyr ya lleva 2 semanas volando sin detenerse, utilizando energía solar como su forma de propulsión, y sigue volando. Ya ha sido reconocida oficialmente con el récord de la aeronave que más tiempo ha durando volando sin detenerse en la historia, y dado el hecho de que el Sol por todo este tipo seguirá con nosotros, algo me dice que este récord se seguirá extendiendo por mucho tiempo más... fuente La aeronave Zephyr ya lleva 2 semanas volando sin detenerse, utilizando energía solar como su forma de propulsión, y sigue volando. Ya ha sido reconocida oficialmente con el récord de la aeronave que más tiempo ha durando volando sin detenerse en la historia, y dado el hecho de que el Sol por todo este tipo seguirá con nosotros, algo me dice que este récord se seguirá extendiendo por mucho tiempo más... fuente7. Open Source en Rusia ordenado por el estado   El Primer Ministro de Rusia, Vladimir Putin, ha decretado recientemente que todo el software utilizado por el estado deba ser del tipo Open Source. Esto sin duda que dará un gran empujo a este modelo de software, dado que Rusia posee algunos de los programadores más talentosos del mundo. Rusia sigue los pasos de otras naciones como Brasil, Venezuela, Cuba y China que han hecho decretos similares. El Primer Ministro de Rusia, Vladimir Putin, ha decretado recientemente que todo el software utilizado por el estado deba ser del tipo Open Source. Esto sin duda que dará un gran empujo a este modelo de software, dado que Rusia posee algunos de los programadores más talentosos del mundo. Rusia sigue los pasos de otras naciones como Brasil, Venezuela, Cuba y China que han hecho decretos similares.Noten que esto no significa que no se pueda utilizar software privativo/propietario en Rusia, sino que esto afecta solo a software utilizado por el estado/gobierno, algo que me encuentro bien pues como ciudadanos la transparencia es un derecho que nos debe el estado, y esto encaja bastante bien con el modelo Open Source. fuente 8. Facebook.com fue la página más visitada del 2010  Aunque entre todas sus propiedades Google recibió más visitas que Facebook, Microsoft o Yahoo este año, la página singular que más visitantes recibió en el 2010 fue Facebook.com, según Hitwise. fuente Aunque entre todas sus propiedades Google recibió más visitas que Facebook, Microsoft o Yahoo este año, la página singular que más visitantes recibió en el 2010 fue Facebook.com, según Hitwise. fuente

autor: josé elías |

|

|

|

|

|

sábado, diciembre 18, 2010

|

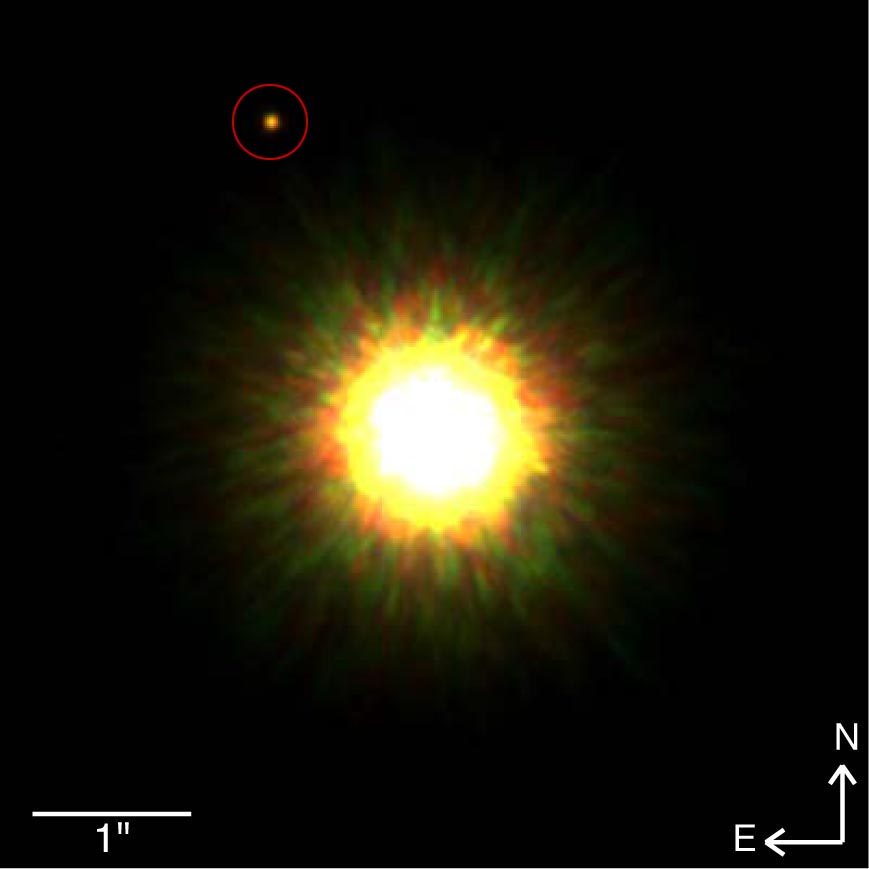

A petición popular, he aquí lo que creo fueron las mejores tecnologías, ciencias, momentos, personajes y situaciones del 2010. A petición popular, he aquí lo que creo fueron las mejores tecnologías, ciencias, momentos, personajes y situaciones del 2010.Noten que (1) esta es una lista personal, no tienen que estar de acuerdo en lo absoluto con ella, y (2) ¿Ya mencioné que es una lista personal (recuerden eso en los comentarios)? 1. Dispositivo del año: El iPad  Por qué: Por redefinir por primera vez en al menos un par de décadas lo que catalogábamos como una "PC", tirando por completo el concepto de pantalla llena de ventanas, teclado y ratón, y substituyéndolo por una sola pantalla multi-táctil de un uso tan fácil que cualquier persona le puede dar uso en pocos minutos sin entrenamiento alguno. Lectura recomendada. Por qué: Por redefinir por primera vez en al menos un par de décadas lo que catalogábamos como una "PC", tirando por completo el concepto de pantalla llena de ventanas, teclado y ratón, y substituyéndolo por una sola pantalla multi-táctil de un uso tan fácil que cualquier persona le puede dar uso en pocos minutos sin entrenamiento alguno. Lectura recomendada.2. Plataforma del año: Facebook  Por qué: Por afectar la vida (para bien o para mal) de 600 millones de personas en todo el mundo, y por convertirse en la maquinaria más pesada capaz de darle una buena batalla al creciente imperio de Google. Lectura recomendada. Por qué: Por afectar la vida (para bien o para mal) de 600 millones de personas en todo el mundo, y por convertirse en la maquinaria más pesada capaz de darle una buena batalla al creciente imperio de Google. Lectura recomendada.3. Navegador Web del año: Google Chrome  Por qué: Hace apenas un par de años Chrome era solo un "experimento" de Google, pero desde su inicio mostró potencial con su sencillez y velocidad. Hoy día es el navegador de más rápido crecimiento, y pronto dejará a Firefox detrás, en camino a apuntar al reinado de Internet Explorer. Además incendió la competencia con HTML 5, acelerando la adopción de esa tecnología por al menos 2 años. Lectura recomendada. Por qué: Hace apenas un par de años Chrome era solo un "experimento" de Google, pero desde su inicio mostró potencial con su sencillez y velocidad. Hoy día es el navegador de más rápido crecimiento, y pronto dejará a Firefox detrás, en camino a apuntar al reinado de Internet Explorer. Además incendió la competencia con HTML 5, acelerando la adopción de esa tecnología por al menos 2 años. Lectura recomendada.4. Celular Inteligente del año: iPhone 4  Por qué: Lo adoren o lo odien, la recepción del iPhone 4 en la industria fue prácticamente un unánime "celular del año", y lo mismo opino yo. No solo es sumamente rápido, sexy, funcional y poderoso, sino que además posee la tienda de aplicaciones con la mayor y mejor selección de software, y su pantalla es sencillamente espectacular. Sin embargo, existe una gran posibilidad de que iPhone pierda su reinado a Android en el 2011... Lectura recomendada (del 2007). Por qué: Lo adoren o lo odien, la recepción del iPhone 4 en la industria fue prácticamente un unánime "celular del año", y lo mismo opino yo. No solo es sumamente rápido, sexy, funcional y poderoso, sino que además posee la tienda de aplicaciones con la mayor y mejor selección de software, y su pantalla es sencillamente espectacular. Sin embargo, existe una gran posibilidad de que iPhone pierda su reinado a Android en el 2011... Lectura recomendada (del 2007).5. Sistema Operativo del año: Android OS  Por qué: El iPhone quizás haya sido el celular del año 2010, pero el sistema operativo del año fue sin duda Android OS. Así como el navegador Chrome evolucionó extremadamente rápido en relación a la competencia, así lo hizo Android. Hasta hace apenas unos meses la mayoría de los celulares Android sufrían de muchos pequeños pero tediosos problemas, que incluían problemas de velocidad en su interfaz visual, inconsistencia en la presentación de las aplicaciones, un interfaz subpar al del App Store del iPhone, etc, pero en tan solo las últimas semanas hemos visto una nueva generación de celulares y cambios al mismo Android OS, que apuntan directamente al corazón del iOS (aunque Android OS debe cuidarse con el tema de fragmentación de la plataforma). El 2011 será un año interesante para estos dos contrincantes. Lectura recomendada (del 2008). Por qué: El iPhone quizás haya sido el celular del año 2010, pero el sistema operativo del año fue sin duda Android OS. Así como el navegador Chrome evolucionó extremadamente rápido en relación a la competencia, así lo hizo Android. Hasta hace apenas unos meses la mayoría de los celulares Android sufrían de muchos pequeños pero tediosos problemas, que incluían problemas de velocidad en su interfaz visual, inconsistencia en la presentación de las aplicaciones, un interfaz subpar al del App Store del iPhone, etc, pero en tan solo las últimas semanas hemos visto una nueva generación de celulares y cambios al mismo Android OS, que apuntan directamente al corazón del iOS (aunque Android OS debe cuidarse con el tema de fragmentación de la plataforma). El 2011 será un año interesante para estos dos contrincantes. Lectura recomendada (del 2008).6. Cámara digital del año: Canon T2i (550D)  Por qué: Por revolucionar el concepto de "cine independiente y casero". Esta fue la cámara que hizo que yo regresara (después de una década con Nikon) al campo de Canon, siendo la primera cámara en su rango de precio (por debajo de los US$800 dólares) en ofrecer verdadera calidad cinematográfica profesional comparable a lo que vemos en discos de alta definición Blu-ray (aunque para sacarle provecho, es bueno tener un buen lente, como el Canon 50mm f1.4 o al menos el f1.8). Lectura recomendada. Por qué: Por revolucionar el concepto de "cine independiente y casero". Esta fue la cámara que hizo que yo regresara (después de una década con Nikon) al campo de Canon, siendo la primera cámara en su rango de precio (por debajo de los US$800 dólares) en ofrecer verdadera calidad cinematográfica profesional comparable a lo que vemos en discos de alta definición Blu-ray (aunque para sacarle provecho, es bueno tener un buen lente, como el Canon 50mm f1.4 o al menos el f1.8). Lectura recomendada.7. Sistema de Mensajería del año: GMail  Por qué: No solo se convirtió GMail en una alternativa viable a Microsoft Exchange y Outlook, sino que en mi opinión lo superó en muchos sentidos, dejando de paso en el olvido a Yahoo Mail y Hotmail (ambos servicios fueron forzados a reinventarse este año devido a los avances de GMail). Sin embargo, ya veremos que sucede el próximo año con el nuevo sistema de mensajería de Facebook y como termina impactando el mercado... Lectura recomendada. Por qué: No solo se convirtió GMail en una alternativa viable a Microsoft Exchange y Outlook, sino que en mi opinión lo superó en muchos sentidos, dejando de paso en el olvido a Yahoo Mail y Hotmail (ambos servicios fueron forzados a reinventarse este año devido a los avances de GMail). Sin embargo, ya veremos que sucede el próximo año con el nuevo sistema de mensajería de Facebook y como termina impactando el mercado... Lectura recomendada.8. Fracaso del año: Nokia y Symbian  Por qué: Por fallar en adaptarse al mercado de celulares inteligentes, y a las nuevas modalidades de uso y expectativas de usuarios (como lo crucial que es tener una buena Tienda de Aplicaciones). La empresa no solo desaceleró su crecimiento drásticamente, sino que cerró varios aspectos de su proyecto Symbian, varios de sus mejores aliados anunciaron que se concentrarían en Android, y se iniciaron los despidos de empleados. La típica historia milenaria de "camarón que se duerme, se lo lleva la corriente". Lectura recomendada. Por qué: Por fallar en adaptarse al mercado de celulares inteligentes, y a las nuevas modalidades de uso y expectativas de usuarios (como lo crucial que es tener una buena Tienda de Aplicaciones). La empresa no solo desaceleró su crecimiento drásticamente, sino que cerró varios aspectos de su proyecto Symbian, varios de sus mejores aliados anunciaron que se concentrarían en Android, y se iniciaron los despidos de empleados. La típica historia milenaria de "camarón que se duerme, se lo lleva la corriente". Lectura recomendada.9. Tecnología del año: Tablets  Por qué: Sin la menor duda, el iPad no solo se convirtió en el dispositivo emblemático del 2010, sino que además creó toda una industria, tomando a la competencia por sorpresa. Cuando Apple la anunció, varios competidores se rieron, burlaron y ridiculizaron, pero hoy día, enfrentados a una baja en ventas de laptops y netbooks debido al iPad, y a ventas que superarán los 50 millones de unidades de iPads en los próximos meses, esos mismos competidores han entrado su colita entre las piernas y han decidido entrar al mercado (a la fecha se han anunciado al menos 40 modelos distintos de tabletas que competirán contra el iPad en el 2011). Lectura recomendada. Por qué: Sin la menor duda, el iPad no solo se convirtió en el dispositivo emblemático del 2010, sino que además creó toda una industria, tomando a la competencia por sorpresa. Cuando Apple la anunció, varios competidores se rieron, burlaron y ridiculizaron, pero hoy día, enfrentados a una baja en ventas de laptops y netbooks debido al iPad, y a ventas que superarán los 50 millones de unidades de iPads en los próximos meses, esos mismos competidores han entrado su colita entre las piernas y han decidido entrar al mercado (a la fecha se han anunciado al menos 40 modelos distintos de tabletas que competirán contra el iPad en el 2011). Lectura recomendada.10. Tecnología de video-juegos del año: El Xbox Kinect  Por qué: Así como el Nintendo Wii revolucionó las consolas de video-juegos, de manera similar el Xbox Kinect apunta a revolucionarlo una vez más, proveyendo un nuevo tipo de interfaz en donde no necesitas controles, sino que controlas todo con simples gestos corporales. Sin duda que no se sentirá tan nuevo como lo fue el Wii cuando salió por primera vez, pero no hay duda que trae algo nuevo al terreno de juego. Lectura recomendada. Por qué: Así como el Nintendo Wii revolucionó las consolas de video-juegos, de manera similar el Xbox Kinect apunta a revolucionarlo una vez más, proveyendo un nuevo tipo de interfaz en donde no necesitas controles, sino que controlas todo con simples gestos corporales. Sin duda que no se sentirá tan nuevo como lo fue el Wii cuando salió por primera vez, pero no hay duda que trae algo nuevo al terreno de juego. Lectura recomendada.11. Personaje del año: Julian Assange  Por qué: Estén de acuerdo o no con Julian Assange y sus tácticas con WikiLeaks, lo cierto es que dentro de unos años serán pocas las personas del 2010 que podremos decir impactaron al mundo como este hombre. Como escribí en un editoria reciente en eliax: En un futuro, cuando regresemos a los anales de historia a la fecha de hoy, WikiLeaks será solo una breve entrada en donde dirá "Influenció el inicio de una transparencia gubernamental a nivel global, y de la transferencia de poder de los gobiernos de regreso a los ciudadanos gracias al Internet". Lectura recomendada. Por qué: Estén de acuerdo o no con Julian Assange y sus tácticas con WikiLeaks, lo cierto es que dentro de unos años serán pocas las personas del 2010 que podremos decir impactaron al mundo como este hombre. Como escribí en un editoria reciente en eliax: En un futuro, cuando regresemos a los anales de historia a la fecha de hoy, WikiLeaks será solo una breve entrada en donde dirá "Influenció el inicio de una transparencia gubernamental a nivel global, y de la transferencia de poder de los gobiernos de regreso a los ciudadanos gracias al Internet". Lectura recomendada.12. Noticia científica del año: Bacterias con supuestas estructura interna de Arsénico presentada por la NASA  Por qué: Esta noticia no solo fue impactante (para los que la entendieron), sino que controversial, y desde que salió en los medios muchos científicos han mostrado escepticismo sobre su veracidad, algo que no será dado por resuelto hasta al menos el 2011 cuando otros científicos puedan reproducir los datos revelados. Por qué: Esta noticia no solo fue impactante (para los que la entendieron), sino que controversial, y desde que salió en los medios muchos científicos han mostrado escepticismo sobre su veracidad, algo que no será dado por resuelto hasta al menos el 2011 cuando otros científicos puedan reproducir los datos revelados.Sin embargo, más allá de su gran importancia científica, esta noticia fue importantísima porque precisamente debido a la polémica que se inició dentro de la misma comunidad científica (que es algo que ocurre a diario con casi cualquier tipo de anuncio, y se espera que así sea), y debido a que esa polémica llegó a la cultura popular, esto creo que enseñó a la población en general una de las mayores bondades de la ciencia: No podemos creer todo ciegamente, y tenemos no solo el poder, sino que el deber, de ser escépticos y de demandar evidencia, algo que lamentablemente no se practica en varios sectores de la sociedad, en donde se les enseña a las personas a creer ciegamente "por pura Fe" en cosas que son de dudosa veracidad. Lectura recomendada. 13. Noticia biológica del año: La primera forma de vida artificial  Por qué: Craig Venter, el mismo en ser el primero cuyo equipo descodificó por primera vez el genoma humano, y el mismo en crear el primer genoma artificial en el 2007, sorprendió a toda la comunidad científica al anunciar la primera forma de vida artificial este año. Noten que aunque no fue estrictamente 100% artificial, su importancia es que nos enseñó que la vida la podemos crear nosotros mismos los humanos, sin intervención divina o ninguna fórmula mágica o espíritu especial de otra dimensión. La vida, al fin y al cabo, no es más que otro proceso natural e intrínseco más del Universo. Lectura recomendada. Por qué: Craig Venter, el mismo en ser el primero cuyo equipo descodificó por primera vez el genoma humano, y el mismo en crear el primer genoma artificial en el 2007, sorprendió a toda la comunidad científica al anunciar la primera forma de vida artificial este año. Noten que aunque no fue estrictamente 100% artificial, su importancia es que nos enseñó que la vida la podemos crear nosotros mismos los humanos, sin intervención divina o ninguna fórmula mágica o espíritu especial de otra dimensión. La vida, al fin y al cabo, no es más que otro proceso natural e intrínseco más del Universo. Lectura recomendada.14. Noticia sobre la Inmortalidad del año: Logran que organismos rejuvenezcan  Por qué: Hasta hace apenas pocas semanas, se creía que desde el punto de vista biológico lo mejor que podíamos hacer para lograr la inmortalidad era retrasar (o quizás incluso algún día lograr detener) el envejecimiento, pero experimentos por científicos de Harvard demostraron que es posible incluso retroceder el envejecimiento, logrando estos hacer que ratones viejos de laboratorio se tornaran otra vez en jóvenes, y no solo en apariencia externa, sino que en la estructura de sus órganos internos, lo que sin duda abre grandes esperanzas a la humanidad en las próximas décadas. Lectura recomendada. Por qué: Hasta hace apenas pocas semanas, se creía que desde el punto de vista biológico lo mejor que podíamos hacer para lograr la inmortalidad era retrasar (o quizás incluso algún día lograr detener) el envejecimiento, pero experimentos por científicos de Harvard demostraron que es posible incluso retroceder el envejecimiento, logrando estos hacer que ratones viejos de laboratorio se tornaran otra vez en jóvenes, y no solo en apariencia externa, sino que en la estructura de sus órganos internos, lo que sin duda abre grandes esperanzas a la humanidad en las próximas décadas. Lectura recomendada.15. Noticia esperanzadora de salud del año: La primera persona oficialmente curada al 100% del HIV/SIDA  Por qué: Fue sola una persona, y bajo circunstancias muy especiales, pero el solo hecho de que se pudo verdaderamente curar, de forma verificable por la ciencia (el procedimiento en realidad ocurrió hace 3 años, pero solo ahora se ha podido declarar con certeza que el paciente se curó), es una noticia altamente esperanzadora no solo para los que padecen de esta temible enfermedad, sino que incluso para los que padecen otras formas de condiciones atroces como varias formas de cánceres. Lectura recomendada. Por qué: Fue sola una persona, y bajo circunstancias muy especiales, pero el solo hecho de que se pudo verdaderamente curar, de forma verificable por la ciencia (el procedimiento en realidad ocurrió hace 3 años, pero solo ahora se ha podido declarar con certeza que el paciente se curó), es una noticia altamente esperanzadora no solo para los que padecen de esta temible enfermedad, sino que incluso para los que padecen otras formas de condiciones atroces como varias formas de cánceres. Lectura recomendada.16. Noticia sobre fusión de humanos y máquinas del año: Bio-baterías que extraen energía/combustible de células vivas  Por qué: Unos de los grandes retos de integrar humanos con nanomáquinas dentro del cuerpo ha sido el problema de energía. Es decir, ¿cómo proveer a estas micromáquinas de energía para que hagan su función dentro del cuerpo humano? Hasta ahora se habían probados técnicas con microbaterías, o incluso generando energía del movimiento natural del cuerpo, pero este año un grupo de científicos franceses lograron crear una fuente energía que se alimenta de la energía misma del cuerpo, es decir, extraen energía de forma similar a como las extraen nuestras propias células, abriendo las compuertas para todo tipo de aplicaciones, desde nanobots que nos monitorearán la salud, hasta una nueva generación de sistemas inmunológicos "digitales" hechos a la medida de cada persona. Lectura recomendada. Por qué: Unos de los grandes retos de integrar humanos con nanomáquinas dentro del cuerpo ha sido el problema de energía. Es decir, ¿cómo proveer a estas micromáquinas de energía para que hagan su función dentro del cuerpo humano? Hasta ahora se habían probados técnicas con microbaterías, o incluso generando energía del movimiento natural del cuerpo, pero este año un grupo de científicos franceses lograron crear una fuente energía que se alimenta de la energía misma del cuerpo, es decir, extraen energía de forma similar a como las extraen nuestras propias células, abriendo las compuertas para todo tipo de aplicaciones, desde nanobots que nos monitorearán la salud, hasta una nueva generación de sistemas inmunológicos "digitales" hechos a la medida de cada persona. Lectura recomendada.17. Noticias sobre computación del año: Quantum Walk y Computación Cuántica con componentes faltantes  Por qué: Este par de noticias demostraron no solo que es posible hacer computación con innumerables partículas en estado cuántico de una forma práctica (algo monumentalmente difícil o casi imposible hasta este año), sino que además es posible hacer computación práctica con gran cantidad de esas partículas fallando (es decir, auto-corrección de errores). Los refiero a los artículos para más detalles técnicos en esta lectura recomendada y esta otra. Por qué: Este par de noticias demostraron no solo que es posible hacer computación con innumerables partículas en estado cuántico de una forma práctica (algo monumentalmente difícil o casi imposible hasta este año), sino que además es posible hacer computación práctica con gran cantidad de esas partículas fallando (es decir, auto-corrección de errores). Los refiero a los artículos para más detalles técnicos en esta lectura recomendada y esta otra.18. Noticia astronómica del año: Primera fotografía directa de un planeta orbitando otra estrella  Por qué: Hasta ahora los alrededor de 500 planetas descubiertos fuera del sistema solar habían sido detectados de forma indirecta (generalmente, viendo su influencia en su estrella madre), pero este año se logró algo que muchos de los más destacados científicos hubieran dicho sería imposible lograr esta década: Fotografia directamente un planeta en otra estrella. Y con la nueva generación de instrumentos que tendremos en operación en los próximos años, ya podemos incluso a empezar en soñar en el día que detectemos una atmósfera amigable (o que incluso indique) a la vida. Lectura recomendada. Por qué: Hasta ahora los alrededor de 500 planetas descubiertos fuera del sistema solar habían sido detectados de forma indirecta (generalmente, viendo su influencia en su estrella madre), pero este año se logró algo que muchos de los más destacados científicos hubieran dicho sería imposible lograr esta década: Fotografia directamente un planeta en otra estrella. Y con la nueva generación de instrumentos que tendremos en operación en los próximos años, ya podemos incluso a empezar en soñar en el día que detectemos una atmósfera amigable (o que incluso indique) a la vida. Lectura recomendada.19. Noticia cosmológica del año: El LHC recrea estado del Universo antes de existir los átomos  Por qué: El LHC (o Gran Colisionador de Hadrones por sus siglas en inglés) no deja de sorprender, este año logrando por primera vez recrear las condiciones del origen de este Universo en el momento de incluso no existir todavía los átomos. Este avance sin precedente nos acerca mucho más no solo al inicio de nuestro Universo, sino que a un mejor entendimiento de toda nuestra existencia. Lectura recomendada (y otra noticia de quizás tanta importancia fue esta otra, sobre antimateria) Por qué: El LHC (o Gran Colisionador de Hadrones por sus siglas en inglés) no deja de sorprender, este año logrando por primera vez recrear las condiciones del origen de este Universo en el momento de incluso no existir todavía los átomos. Este avance sin precedente nos acerca mucho más no solo al inicio de nuestro Universo, sino que a un mejor entendimiento de toda nuestra existencia. Lectura recomendada (y otra noticia de quizás tanta importancia fue esta otra, sobre antimateria)20. Noticia preferida por los fans del año: ???

Es aquí en donde entran ustedes en los comentarios, ¿cuáles fueron sus noticias favoritas de eliax este año? :) autor: josé elías |

|

|

|

|

|

lunes, diciembre 13, 2010

|

Una de las tecnologías que más tiempo han perdurado en el mundo de la "PC" es el conector de video VGA, con nosotros desde el 1987 (¡hace unos 23 años!), y encontrado en el 100% de las PCs de escritorio de todo el mundo, así como en la vasta mayoría de Laptops y proyectores de video. Una de las tecnologías que más tiempo han perdurado en el mundo de la "PC" es el conector de video VGA, con nosotros desde el 1987 (¡hace unos 23 años!), y encontrado en el 100% de las PCs de escritorio de todo el mundo, así como en la vasta mayoría de Laptops y proyectores de video.Sin embargo, su tiempo ha llegado, y los titanes de la industria Intel, AMD, Dell, Lenovo, Samsung y LG han anunciado que para el 2015 no fabricarán más equipos con ese conector, abriendo paso a una mayor adopción a HDMI y DisplayPort. Esto por fin dejará atrás las tecnologías analógicas para transmisión de video, para concentrarnos en video 100% digital, lo que de paso es una medida bienvenida por la industria del cine ya que estas tecnologías están diseñadas para transmitir una señal cifrada, de modo que no pueda ser fácilmente interceptada y copiada por usuarios finales. Incluso para el 2013 AMD e Intel planean ser quienes lideren esta transición, haciendo la mayoría de sus productos "libres de VGA". Nota de Prensa oficial autor: josé elías |

|

|

|

|

|

jueves, diciembre 9, 2010

|

Según la firma investigadora IDC, el fin del reinado de la PC está a la vuelta de la esquina, y los herederos al trono serán los celulares inteligentes y los tablets como el iPad. Según la firma investigadora IDC, el fin del reinado de la PC está a la vuelta de la esquina, y los herederos al trono serán los celulares inteligentes y los tablets como el iPad.Según la empresa, dentro de apenas 18 meses la cantidad de unidades combinadas de tablets (lideradas actualmente por el iPad) y de celulares inteligentes (lideradas por iPhone y Android), eclipsarán por primera vez las unidades de PCs/Laptops/Netbooks tradicionales (que para todos los fines prácticos, hablamos mayoritariamente de Windows, y a menor medida de Mac OS X y Linux). Esta noticia viene 2 años después que las laptops portátiles eclipsaran las ventas de PCs de escritorio, y 3 años después que en países como Japón los celulares empezaran a afectar las ventas de PCs. Lo interesante de esta noticia (asumiendo que las predicciones de IDC se cumplan) es lo rápido que caerá el reinado del sistema operativo tradicional de escritorio, pues estoy seguro que si a 100 personas le preguntamos (antes de leer esta noticia) en cuantos años ven el reinado de la PC caer, muy posiblemente la mayoría diría "dentro de al menos una década", pero la tecnología avanza a pasos exponenciales, y no solo veremos el reino de la PC caer en pocos años, sino que así mismo veremos el reino de las tablets y celulares caer eventualmente (quizás ante dispositivos como este). Ojo, estos datos no significan que no se seguirán vendiendo cientos de millones de PCs y laptops en los próximos años, sino que la cantidad de unidades vendidas de estas empezarán a ser menos que las de dispositivos móviles y tipo tablets, por lo que aun no den por muerto del todo a Windows hasta dentro de unos años. Finalmente, creo que este es un excelente momento para mirar atrás a este artículo de hace poco más de 3 años en donde ponderaba la pregunta de si un dispositivo como el iPhone podría destronar a Windows. La respuesta creo que por fin la tenemos ante nosotros... Fuente de los datos por IDC Crédito de la imagen autor: josé elías |

|

|

|

|

|

jueves, diciembre 2, 2010

|

La aceleración tecnológica continúa caminando con precisión de manecillas de reloj, y esta noticia de hoy es un magno ejemplo de ese proceso... La aceleración tecnológica continúa caminando con precisión de manecillas de reloj, y esta noticia de hoy es un magno ejemplo de ese proceso...IBM acaba de crear una técnica que permitirá una nueva generación de super-computadoras 1000 (mil) veces más potentes que las más potentes supercomputadoras de hoy día, lo que hará realidad en menos de una década que IBM cree una máquina capaz de 1 ExaFLOPS de poder. Hablamos de una máquina capaz de procesar 1,180,591,620,717,411,303,424 operaciones por segundo, o en otras palabras, sobre los mil millones de millones de millones (sí, no es un error) de operaciones por segundo. Lo que ha hecho este adelanto posible es una tecnología que IBM llama CMOS Integrated Silicon Nanophotonics, que integra en un solo chip de silicio los componentes necesarios para convertir electricidad a pulsos de luz de una manera super eficiente, permitiendo que estos terminales que se colocan en el borde del chip se comuniquen con otros chips a unos 3 órdenes de magnitud más rápido que con métodos actuales de lineas de cobre. De paso, la tecnología funciona además en múltiples longitudes de onda (si lo quieren imaginar así, en "multiples colores del arcoiris") en vez de un sola longitud ("color"), lo que ayuda también a este masivo incremento de velocidad. Y como si fuera poco, esta tecnología se fabrica con exactamente los mismos procesos de fabricación de los chips tradicionales hoy día, haciéndolos bastante baratos y fáciles de producir (IBM incluso ya tiene prototipos funcionando fabricados de esta manera). Según IBM, el próximo reto es utilizar técnicas similares a esta para comunicación no solo entre un chip y otro, sino que entre los mismos componentes dentro del chip, algo en lo que dicen ya están trabajando pero que no tienen nada público para demostrar por el momento, pero que en cuando lo tengan, pueden estar seguros que veremos otro aumento masivo en el rendimiento de los microprocesadores y otros componentes electrónicos. Fuente de la noticia autor: josé elías |

|

|

|

|

|

lunes, noviembre 15, 2010

|

Uno de los problemas más difíciles en la fabricación de una computadora cuántica práctica es el hecho de que estas son extremadamente sensibles a cualquier perturbación ambiental, fácilmente perdiendo la coherencia de los componentes de su estructura, y por tanto se pensaba, arruinando sus cálculos. Sin embargo, científicos de la University of Queensland en Brisbane, Australia, acaban de dar un gran avance teórico que podría resolver ese problema. Uno de los problemas más difíciles en la fabricación de una computadora cuántica práctica es el hecho de que estas son extremadamente sensibles a cualquier perturbación ambiental, fácilmente perdiendo la coherencia de los componentes de su estructura, y por tanto se pensaba, arruinando sus cálculos. Sin embargo, científicos de la University of Queensland en Brisbane, Australia, acaban de dar un gran avance teórico que podría resolver ese problema.Antes de continuar, noten que una computadora cuántica, a diferencia de una computadora digital (o "computadora clásica" como se le llaman en este contexto), no funciona bajo los parámetros tradicionales de ausencia o presencia de cargas eléctricas (representando un "0" o "1" binario respectivamente), sino que funcionan bajo las leyes de la mecánica cuántica. Bajo este esquema no se utilizan "bits" con posibles valores de "cero" o "uno", sino que unos denominados "qubits", que son la versión análoga en Mecánica Cuántica de los bits en la Física Clásica. Una particularidad de estos qubits es que no existen independientes unos de otros, sino que todos están en un estado llamado "entrelazado", lo que causa la curiosa (y sumamente útil) propiedad de que 1 qubit no almacena solo on cero o u uno, sino que ambos valores simultáneamente, y si se combinan varios qubits (digamos, 8 de ellos), estos no almacenan simplemente 1 de 256 posibles valores como en las computadoras clásicas, sino que todos los posibles valores simultáneamente. Más interesante aun, es que una computadora cuántica puede también hacer computación entre todos esos números, de manera instantánea y simultánea. Es decir (y como ejemplo), si a una computadora cuántica le pedimos el número de teléfono de una persona entre millones de personas almacenadas en una base de datos cuántica, el sistema devolvería inmediatamente el número, en vez de buscar entre todos ellos con una técnica llamada un árbol binario, lo que significa que computadoras cuánticas son (para ciertos problemas) infinitamente más rápidas que la más potente super-computadora clásica que podamos construir (y noten que empresas como Google ya están trabajando en esto). Ahora bien, toda esa explicación viene porque para que todo esto funcione, se necesita que todos esos qubits "colaboren" unos con otros, pero el problema es que incluso la más sencilla vibración ambiental, o interacción con partículas externas al sistema, arruina los qubits. Pero según los investigadores de este adelanto, pueden demostrar de forma teórica, que con ciertos algoritmos cuánticos de su invención es posible perder incluso el 25% de todos los componentes de una computadora cuántica, y aun así mantener la máquina funcionando perfectamente. Esto se debe a que a diferencia de máquinas clásicas, cada qubit al estar entrelazado con otros, contiene información sobre ellos, y por tanto es posible recuperar esa información aun si varios de ellos faltan. Esto es un poco similar a las técnicas de CRC, Checksums, RAID y diversas otras formas de mantener información válida aun cuando algunos bits de información en computadoras clásicas fallan, pero en este caso hablamos de poder restaurar hasta el 25% del estado de la máquina, sin invertir en añadir más qubits al sistema. Es decir, el sistema es auto-verificable en su estado natural. ¿Qué significa esto? Que esto ahora nos ha acercado muchísimo más a computadoras cuánticas prácticas, lo que es una muy buena noticia dado que nos acercamos a los límites de los procesos actuales. Fuente de la noticia autor: josé elías |

|

|

|

|

|

domingo, noviembre 14, 2010

|

Recientemente Intel, Samsung y Toshiba anunciaron la formación de una alianza para crear un proceso de fabricación de chips con tecnología de "10nm", y creo que este es un excelente momento para explicar el tema ese de los "nm" en este contexto. Recientemente Intel, Samsung y Toshiba anunciaron la formación de una alianza para crear un proceso de fabricación de chips con tecnología de "10nm", y creo que este es un excelente momento para explicar el tema ese de los "nm" en este contexto.Si eres un técnico que tiene una idea de lo que es este número, recomiendo de todas maneras seguir leyendo por si acaso, pues hay más aquí de lo que aparenta, como aprendí yo cuando empecé a diseñar mi propio microprocesador al estilo VLSI en mis días universitarios. Así que he aquí una explicación didáctica para todos en el formato de "Pregunta a eliax". Si han visto alguna vez una fotografía ampliada de un chip, notarán que estos están fabricados con innumerables pequeñas lineas o trazos, pareciendo uno de estos chips una ciudad con calles y avenidas en miniatura. El ancho de esas "calles" (que son las que llevan las señales eléctricas de un lugar del chip a otro) se miden en "nm," o "nanómetros", en donde 1nm es igual a una mil-millonésima parte de un metro, por lo que hablamos de crear lineas de 10 mil-millonésimas de un metro de ancho. Para que tengan una idea de que tan pequeño es eso, el punto sobre esta letra "i", visto en un monitor estándar de hoy día (digamos, uno de 19 pulgadas y con resolución de 1280x 1024 pixeles), mide de ancho (a groso modo) aproximadamente 1 millón de nanómetros. Por lo que hablamos de que en este puntito cabrían de lado a lado 100,000 lineas eléctricas, todas corriendo paralelas las unas a las otras. Sepan sin embargo que hoy día ya poseemos tecnología para fabricar chips de 30nm, y aunque no aparente mucho bajar de 30nm a 10nm, en realidad es un gran salto, porque en la misma área cuadrada que cabe un solo chip de 30n, caben a groso modo 9 chips de 10nm, y eso tiene grandes repercusiones... Para empezar, eso significa que en el mismo espacio que se fabricaba antes 1 chip, ahora se pueden fabricar 9, lo que significa que el costo de fabricación se reduce al menos 9 veces (y en realidad, se reduce mucho más por otro tema relacionado a las impurezas que ahora causarían menos estragos, por lo que hablamos de al menos 10 veces más barato). Sin embargo, eso no es todo. Ahora, debido a que las distancias son más cortas dentro del chip, eso significa que las señales llegan más rápidamente, lo que significa también un gran aumento en rendimiento, y de paso, debido a que ahora los electrones recorren menos camino, eso significa que el chip también consume menos energía y de paso se calienta menos. Esto entonces permite fabricar no solo chips más baratos, sino que más rápidos y eficientes energéticamente. Pero aparte de eso ahora podemos, si lo deseamos, fabricar chips del mismo tamaño que antes, pero llenarlos de múltiples núcleos, lo que significa que por el mismo precio que uno antes fabricaría un chip con 2 núcleos, ahora podría fabricar uno con 18 núcleos (o uno con 9 núcleos a mitad del precio de antes). Así que como ven, aunque a primera vista esos "nanómetros" aparentan ser solo simples números, en realidad estos quizás sean entre los números más importantes a la hora de determinar el tamaño, precio y rendimiento de los dispositivos electrónicos que compramos todos los días. Una nota final que debo mencionar es que existe un límite de qué tan finas podemos trazar esas líneas, pues si seguimos como vamos llegaremos al punto en donde una de estas lineas será del grosor de uno o dos átomos, y cuando eso suceda será bastante difícil fabricar chips con procesos actuales. Debido a eso es que se hace tanta investigación sobre computación cuántica, computación molecular, computación óptica, etc, pues sabemos que estamos llegando a un límite (o al menos, eso aparenta), y debemos buscar la manera de seguir incrementando el poder de nuestras máquinas exponencialmente. Sin embargo, no se preocupen, que como podrán leer en los artículos previos en eliax relacionados a este (que aparecen al final de este artículo), tenemos muchas tecnologías promisorias en camino... autor: josé elías |

|

|

|

|

|

viernes, octubre 29, 2010

|

Por décadas los EEUU ha mantenido un liderazgo en las supercomputadoras más potentes del mundo. Hasta ahora... Por décadas los EEUU ha mantenido un liderazgo en las supercomputadoras más potentes del mundo. Hasta ahora...China ha anunciado que tiene una máquina llamada la "Tianhe-1A PC", totalmente operacional, que es la supercomputadora más potente del mundo. Esta máquina tiene una potencia de 2.507 PetaFLOPS, y fue desarrollada por la Universidad Nacional de la Defensa y Tecnología de China. Hasta ahora, la supercomputadora más potente era la una Jaguar Cray XT5-HE con un rendimiento de 1.750 PetaFLOPS. Para que tengan una idea, esta máquina china es capaz de ejecutar 2507 millones de millones de cálculos en un solo segundo. Irónicamente, lo que le da la potencia a esta máquina son componentes estadounidenses de las empresas Intel y NVidia. Este monstruo de computación posee nada más ni nada menos que 7,168 tarjetas de video NVIDIA M2050 (valoradas en US$2,500 dólares cada una), y 14,336 procesadores de Intel. Actualización: Sobre algunas incógnitas que han expresado en los comentarios: 1. Sí, por lo general la gran mayoría de super-computadoras utiliza Linux, no solo porque ha sido adoptado por la comunidad científica que por lo general ya proviene de un trasfondo de supercomputación con UNIX (el precursor de Linux), sino que además porque con tantos procesadores sería prohibitivo pagar licencias a sistemas operativos convencionales. 2. El tipo de aplicaciones son simulaciones climáticas, simulaciones de armas nucleares, simulaciones de interacciones entre proteínas (más otras simulaciones de índole farmaceutico), simulaciones de mercados, simulaciones neuronales, como buscadores de patrones en grandes volúmenes de datos, etc. Fuente de la noticia autor: josé elías |

|

|

|

|

|

martes, octubre 26, 2010

|

|

Continuando con un aparentemente-eterno Modo de Baja Productividadtm, hoy los dejo con varias noticias breves:

1. Sony PSP Go y PSP 2 1. Sony PSP Go y PSP 2Ayer reporté por Twitter que el nuevo precio oficial del Sony PSP Go será de US$199 dólares, pero otra noticia jugosa para los fans de esta consola de video-juegos es que algunos desarrolladores de video-juegos ya están poniendo sus manos en prototipos del PSP 2, que supuestamente viene con una pantalla más grande y de alta definición, así como una superficie multi-táctil. Supuestamente lo veremos en tiendas en las navidades del próximo año 2011. fuente 2. VLC en iPhone y iPod Touch El venerable reproductor universal de media VLC recientemente fue hecho disponible en el iPad, y ahora acaba de salir una versión para el iPhone y iPod Touch. Noten que solo funciona en el iPhone 3GS, el iPhone 4, y las últimas dos generaciones del iPod Touch. Disponible en el App Store ahora mismo. 3. SDK y Simulador para BlackBerry PlayBook Si planeas desarrollar aplicaciones para el RIM BlackBerry PlayBook, la empresa acaba de anunciar un entorno de desarrollo y simulador del hardware para que inicies a trabajar lo antes posible. fuente  4. El crecimiento de Netflix 4. El crecimiento de NetflixSegún estudios, Netflix, la empresa que se ha consagrado como la líder en rentar películas por Internet (en particular en los EEUU, y lean mi predicción #41 para este año),ya consume el 20% del tráfico de Internet en los EEUU en los horarios principales de teleaudiencia. fuente Así mismo el CEO de la empresa reveló que Netflix ya es primariamente una empresa de renta de películas por Internet, y no tanto de rentas de DVDs por correo (que fue como se inició). Incluso han anunciado que iniciarán a vender planes de rentas de películas que no incluyen DVDs (alrededor de US$7 a US$9 dólares por todas las películas que puedas descargar). En resumen, pongas las empresas de rentas de películas de la vuelta de la esquina en la lista en extinción junto con el kiosco que vende los libros impresos...  5. The Pirate Bay en órbita 5. The Pirate Bay en órbitaEl grupo The Pirate Bay, que promueve el libre intercambio de información (que lamentablemente se transforma también, en este caso, en piratería de películas, canciones, libros y programas) ha anunciado que debido a que ninguna nación es amigable a alojar sus servidores de bitTorrent, que lo que planean hacer en un futuro es lanzar un satélite en órbita y conectarlo a Internet, ya que no existen regulaciones que eviten que operen desde el espacio exterior... fuente 6. Almacenamiento casero de 70 TeraBytes Cuando necesitas más espacio para tus películas, canciones y fotos, ¿qué haces? Por lo general comprar más discos duros, pero este hacker decidió construir su propio sistema de almacenamiento de 70TB, lo que le permite almacenar unas 24 millones de canciones mp3 o 70,000 videos descargados por Internet. Lo construyó con 60 discos, 40 ventiladores y un poco de madera... fuente  7. Nokia en picada, despidos 7. Nokia en picada, despidosNo solo se rumorea que la Fundación Symbian (la misma que provee de sistemas operativos a Nokia) cerrará próximamente sus puertas, sino que además Nokia anunció (en medio de unos buenos resultados en Q3 2010) que despedirá 1,800 empleados para "eficientizar" sus operaciones. fuente  8. Windows 8 en el 2012 8. Windows 8 en el 2012Según la división de los Países Bajos de Microsoft (y como reporté por Twitter hace un par de días, así como reporté en eliax el año pasado), podemos esperar la próxima versión de Windows, llamada sin sorpresas "Windows 8" en Octubre del 2012, es decir, dentro de exactamente 2 años. No se ofrecen detalles de la nueva versión, pero si observamos las tendencias del mercado creo que podemos asumir que tendrá un fuerte componente de integración con la Nube de Internet. fuente 9. MakerLegoBot, de LEGOs e imprime LEGOs Este si que es un hack curioso: Un hacker ha publicado instrucciones que te muestran como construir, con bloques de LEGO, una impresora que imprime objetos en 3D utilizando bloques de LEGO. El proyecto utiliza los Lego Mindstorms NXT. fuente Video de la impresora de LEGOs a continuación, en cámara rápida (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, octubre 24, 2010

|

Esto es algo que me han pedido desde hace mucho tiempo, y aquí por fin está. He subido la versión original de mi libro del 2001 "Máquinas en el Paraíso" al portal Issuu, lo que me permite ahora ponder incrustar el libro en eliax y así lo pueden leer directamente desde dentro de sus navegadores web, transformando sus navegadores en un lector de libros electrónicos. Esto es algo que me han pedido desde hace mucho tiempo, y aquí por fin está. He subido la versión original de mi libro del 2001 "Máquinas en el Paraíso" al portal Issuu, lo que me permite ahora ponder incrustar el libro en eliax y así lo pueden leer directamente desde dentro de sus navegadores web, transformando sus navegadores en un lector de libros electrónicos.Aparte de poder leerlo en este nuevo formato aquí, también lo podrán leer en la página oficial del libro acá en eliax (en donde podrán obtener información adicional sobre el libro). También recomiendo leer esta entrada anterior en eliax que les explica en un poco más de detalle el contenido de de este. Por ahora les digo que si les intrigan temas como La Singularidad Tecnológica, la robótica, Inteligencia Artificial, la nano-tecnología, la mecánica cuántica, la Teoría de la Relatividad, el futuro del Universo, y los últimos grandes avances científicos, que este libro lo disfrutarán, en particular ya que está deliberadamente escrito para que cualquier persona entienda estos temas de avanzada. ¡Espero que lo disfruten! Nota: Esta tecnología también funciona con dispositivos que no tengan Flash y que soporten HTML5 (como el iPad). En ese caso, visiten este enlace. autor: josé elías |

|

|

|

|

|

viernes, octubre 8, 2010

|

Desde que salió la primera PC al mercado hace cerca de 3 décadas atrás, Intel ha tenido un virtual monopolio en el mercado de los microprocesadores que sirven de cerebros a nuestras PCs y laptops, a grado tal, que junto con el monopolio de Windows a ambos se les acuñaron el término "Wintel" (es decir, el monopolio de Windows + Intel). Desde que salió la primera PC al mercado hace cerca de 3 décadas atrás, Intel ha tenido un virtual monopolio en el mercado de los microprocesadores que sirven de cerebros a nuestras PCs y laptops, a grado tal, que junto con el monopolio de Windows a ambos se les acuñaron el término "Wintel" (es decir, el monopolio de Windows + Intel).Sin embargo, como ha sucedido incontables veces en el pasado, cada imperio eventualmente se encuentra con su rival, y esta vez el rival de Intel no es una empresa, sino que más bien una arquitectura, la ARM. Para los que no son técnicos, sepan que toda computadora (desde una laptop hasta la computadora dentro de un horno de micro-ondas) tiene lo que se llama una "arquitectura", y por arquitectura nos referimos a una forma de hacer las cosas al màs bajo nivel, similar a la arquitectura de la mayoría de los seres vivos de este planeta que está basada en ADN, en donde el ADN se puede considerar tanto una máquina como un código o lenguaje. Similarmente, existen distintos tipos de "ADN" dentro de computadoras, siendo el más popular de todos el representado por la arquitectura x86 de Intel (la que utiliza Windows por ejemplo), así como la arquitectura PowerPC (utilizada por ejemplo en parte del PlayStation 3 y el Xbox 360), o la ARM (en el iPhone, iPad, Android, etc). Pero he aquí algo que muchas personas desconocen (y ya verán en un instante por qué es relevante mencionar esto): Aunque Intel tiene casi un monopolio en la arquitectura x86 (su competidor principal, AMD, tiene una minoría en el mercado), lo cierto es que Intel hace muchísimo más dinero de otras dos formas. La primera es en el negocio de los chipsets. Un chipset es el conjunto de otros chips periféricos necesarios para que tu PC o laptop funcione adecuadamente. Estos chipsets son los encargadas de servir como puente de comunicación entre el CPU (es decir, el cerebro x86) y los puertos USB, el disco duro, el chip de video (GPU), los puertos de expansión PCI Express, etc. La segunda forma en que Intel hace dinero, es proveyendo los chips gráficos a fabricantes de laptops, netbooks y PCs. Para sorpresa de muchos, el fabricante de chips de gráficos/vídeos más grande del mundo es Intel, y no NVIDIA o AMD/ATI como muchos se imaginan, pues aunque NVIDIA y AMD/ATI ciertamente son líderes en tarjetas de gráficos potentes para PCs, ese mercado de PCs es un nicho comparado con el de laptops, netbooks y PCs de bajo costo con tarjetas de video integradas. Sin embargo, ahora entra en escena ARM... ARM es una arquitectura introducida originalmente en 1983, y está basada en una filosofía de diseño muy diferente a la x86. La x86 está basada en una arquitectura denominada CISC (Complex Instruction Set Computing) mientras que ARM está basada en RISC (Reduced Instruction Set Computing), incluso, el nombre ARM significa en realidad Advanced Risc Machines (y por motivos históricos que no explicaré, inicialmente significaba Acorn RISC Machines). La idea de RISC es tener un grupo de instrucciones extremadamente simples, y después dejar que sea el "compilador" (lo que traduce instrucciones o comandos de alto nivel a instrucciones de bajo nivel) el que optimice el código generado, mientras que CISC se basa en el concepto de tener instrucciones más complejas en donde una sola puede hacer el trabajo de varias instrucciones más simples (esto sin embargo significa necesitar chips por lo general más grandes para acomodar las instrucciones más complejas). Vale la pena notar que hoy día ambas arquitecturas han tomado prestado de la otra, y en muchos escenarios en difícil diferenciarlas, pero aun así hay una crucial diferencia que ha marcado el destino de ambas: CISC/x86 apostó a computación de alto rendimiento, y por tanto, de alto consumo energético, mientras que ARM apostó por un rendimiento más moderado pero a cambio de una muchísima mayor eficiencia en el consumo energético y chips más baratos de producir. Durante un par de décadas, estas dos arquitecturas no entraron en conflicto, pues x86 vivía felizmente en PCs y laptops, mientras que ARM vivía en un espacio de dispositivos industriales que requerían bajo consumo de energía y bajo costo, como las computadoras en automóviles, televisores, e incluso consolas de videojuegos portátiles Pero algo ocurrió en los últimos 3 años que cambiò el panorama por completo: La salida el mercado del iPhone de Apple. Con el iPhone, se abrió toda una nueva industria de celulares inteligentes para el consumidor final, y este dispositivo había adoptado no la tecnología x86 de Intel, sino que ARM, y por razones bastante obvias: A diferencia de una PC, un celular depende demasiado de su batería, por lo que cada gota de energía ahorrada es una gota más de satisfacción para los clientes, así como era necesario utilizar componentes de bajo costo. Rápidamente surgieron los competidores al iPhone por parte de Palm, HP, ASUS, Dell, HTC, RIM, Nokia, Samsung y Google (entre otros), y en todos los casos estos decidieron adoptar la arquitectura ARM por sobre la x86. Y este año otro gran evento ocurrió: El gran éxito del iPad, el cual también ha abierto todo un nuevo mercado de dispositivos estilo "tableta", y adivinen qué: Casi todos los competidores anunciados utilizarán la arquitectura ARM. Pero he aquí lo preocupante para Intel: No solo no se utilizan los CPUs de Intel, sino que tampoco sus chipsets o chips de gráficos, ya que una de las otras ventajas de ARM es el hecho de que al ser más sencilla que x86, ocupa menos espacio, lo que significa que se hace más barato crear los llamados SoC "Sistema en un Chip", que es básicamente poner dentro de un mismo chip toda la lógica del CPU, los chipsets, los gráficos y sonidos. Es decir, un chip ARM moderno es toda una computadora completa en un solo componente. Como si fuera poco, estos nuevos mercados de celulares inteligentes y tabletas están teniendo un impacto que ya se siente en el mercado de las PCs y Laptops/Netbooks, pues aunque ciertamente las ventas de PCs y laptops continúan incrementando cada año, las ventas de celulares y tabletas está incrementando a un ritmo mayor, lo que significa que es solo cuestión de tiempo para que el crecimiento de los equipos tradicionales se frene y se torne negativo, y cuando eso suceda Intel (y Microsoft con Windows, aunque astútamente ha adoptado a ARM para su Windows Phone 7) será la empresa que más sienta ese crecimiento negativo. Pero las cosas se ponen peor aun para Intel... A diferencia de x86, ARM no es un producto, sino que una especificación técnica que cualquier empresa puede licenciar y modificar, similar a como cualquier empresa puede licenciar a Android de Google y hacer sus propios equipos y modificaciones (lo que ya está afectando las ventas del iPhone). Eso significa que Intel está compitiendo no contra una empresa, sino que contra toda una industria, ya que decenas de empresas crean sus propios diseños basados en ARM, desde NEC y Texas Instruments, hasta la misma Apple (su chip A4 no es más que un diseño ARM modificado). Al final, Intel solo podrá competir a nivel de innovación, o sacando un competidor a ARM. Noten que algo que muchos también desconocen de Intel es que la empresa tiene una licencia de ARM, pero obviamente no ha hecho uso de ella a favor de sus propios chips x86 (en particular, Atom), pero a esta altura del juego, en donde el futuro está claramente en dispositivos móviles, el panorama no se ve bien para Intel sino adopta a ARM, y se tendrá que conformar con el mercado de PCs y Laptops, un mercado que pasará de ser el dominante, a un simple nicho en los próximos años... autor: josé elías |

|

|

|

|

|

domingo, octubre 3, 2010

|

Una de las técnicas más promisorias en el campo de la Computación Cuántica es la de poder utilizar la propiedad de spin (giro) de los electrones para almacenar información, en donde en un solo electrón no solo se puede almacenar un bit, sino que incluso un qbit (el equivalente cuántico al bit tradicional), y hoy hemos dado otro gran paso en esa dirección. Una de las técnicas más promisorias en el campo de la Computación Cuántica es la de poder utilizar la propiedad de spin (giro) de los electrones para almacenar información, en donde en un solo electrón no solo se puede almacenar un bit, sino que incluso un qbit (el equivalente cuántico al bit tradicional), y hoy hemos dado otro gran paso en esa dirección.A la fecha ha sido posible teorizar sobre utilizar esta técnica (2006), lograrlo en la práctica a temperatura ambiental (2009), y ahora en el 2010 han logrado perfeccionar la técnica de lectura (hasta el momento las lecturas de bits/qbits habían sido imperfectas). En otras palabras, en el momento que podamos perfeccionar la técnica de escritura, y combinarla con esta de lectura, podremos iniciar el proceso de perfeccionar el proceso de fabricación para masificar esta tecnología. Lo más interesante de esta vez sin embargo es el hecho que no solo ya pueden leer eficazmente los datos almacenados en el spin/giro de electrones, sino que lo han logrado en base a componentes fabricados con silicio, lo que significa que esto es compatible con los sistemas tradicionales de fabricación de procesadores y memorias. En otras palabras, estamos relativamente cerca de un futuro en donde en un dispositivo del tamaño de un celular podremos almacenar miles de veces más información de lo posible hoy día. O en otras palabras, un componente más del IrixPhone está en vía a desarrollarse... :) Fuente de la noticia autor: josé elías |

|

|

|

|

|

martes, septiembre 28, 2010

|

Por lo general en eliax no se cubren nuevos modelos de laptops genéricas, ya que usualmente lo que vemos a diario son pequeños cambios evolutivos, más de lo mismo, y hoy no es tanta la excepción a la regla, pero reporto esto simplemente para que lo utilicemos de referencia en el futuro. Por lo general en eliax no se cubren nuevos modelos de laptops genéricas, ya que usualmente lo que vemos a diario son pequeños cambios evolutivos, más de lo mismo, y hoy no es tanta la excepción a la regla, pero reporto esto simplemente para que lo utilicemos de referencia en el futuro.La empresa ORIGIN acaba de anunciar lo que bien podría ser la laptop más potente del mundo, con las siguientes especificaciones técnicas: - Un procesador Intel Core i7 980X (la versión "full" de escritorio, adaptada al factor laptop), 3.33GHz, 6 núcleos y 12MB Cache. - Doble tarjetas de video (GPU) NVIDIA GeForce GTX 480M, 4GB de video. - 3TB de disco duro, configurable como RAID 0 o RAID 1. - 24 GB de memoria RAM DDR3 de triple canal. - Pantalla de 17.3" LED de 1920 x 1080 pixeles (1080p). - Reproductor y quemador de discos Blu-ray 3D. - Trackpad multi-táctil. - Salida y entrada de video HDMI. Salida DVI. - Salida y entrada de Sonido Óptico Digital. - Sonido de 7.1 canales de alta definición de audio. - 2 Puertos USB 3.0, y 3 puertos USB 2.0. 1 Puerto eSATA. - Lector de media en tarjetas Flash y lector de huella digital. - Wi-Fi Link 802.11A/B/G/N, 1000 Mbps Ethernet. - Cámara Web de 3 Megapixeles. - Sintonizador de TV de Alta Definición (HDTV) - Windows 7 Ultimate 64-Bit. Noten que hoy el estándar de memoria en una Netbook es 1GB, en una laptop 2GB, y en una muy buena laptop 4GB como máximo, por lo que 24GB de memoria es algo extraordinario hoy día. En cuanto al precio, configurada como en esta lista el costo de este monstruo de máquina es de poco menos de US$9,000 dólares... :) Puedes armar tu propia máquina en este enlace autor: josé elías |

|

|

|

|

|

lunes, septiembre 27, 2010

|

RIM, empresa fabricante de la plataforma BlackBerry, acaba de anunciar hoy la rumoreada tablet que competirá contra el iPad, y a la cual ha llamado la PlayBook. RIM, empresa fabricante de la plataforma BlackBerry, acaba de anunciar hoy la rumoreada tablet que competirá contra el iPad, y a la cual ha llamado la PlayBook.Estas son las principales especificaciones técnicas: - Pantalla LCD de 7" con resolución de 1024 x 600 pixeles y multi-táctil. - Un nuevo sistema operativo al que llaman el BlackBerry Tablet OS. - Procesador tipo ARM a 1 GHz y con doble núcleos. - 1 GB de memoria RAM. - Doble cámaras, una enfrente de 3 MP para video-conferencias, y otra detrás de 5MP para tomar fotos y grabar videos en 1080p. - Reproduce videos de 1080p en formatos H.264, MPEG, DivX, WMV, y audio en formatos MP3, AAC, WMA. - Salida de video micro-HDMI. - Puerto micro-USB - WiFi - 802.11 a/b/g/n. - Bluetooth 2.1 + EDR. - Soporte de Adobe Flash 10.1, Adobe Mobile AIR y Java. - Herramientas de desarrollo WebWorks para programar similar al Palm Web OS. - Mide 5.1" x 7.6" x 0.4" (130mm x 193mm x 10mm) - Pesa menos de 1 libra (400 gramos). La fecha de salida al mercado es "inicios del 2011", lo que significa que muy posiblemente el PlayBook se enfrente al iPad 2 cuando este salga al mercado. Esperen entre hoy y mañana mi análisis de este nuevo dispositivo, el cual debo decir me sorprendió, pues yo (y creo que el resto de la industria) no se esperaban algo tan potente de parte de RIM. Sin embargo, y como en todos mis análisis, tendremos que ver la propuesta de RIM con su PlayBook no solo desde el punto de vista de hardware, sino que desde otras perspectivas y compararla con las realidades del mercado. Mientras tanto, felicito a RIM, pues a diferencia de su recientemente anunciado BlackBerry Bold, esta vez RIM decidió hacer algo verdaderamente novedoso. Página oficial del RIM BlackBerry PlayBook Crédito de la imagen Video a continuación (enlace YouTube)... Actualización: También lanzado el mismo día fueron: - WebWorks, una plataforma para desarrollar aplicaciones para el PlayBook con tecnologías de HTML 5 similar a como se programa el Palm Web OS, en donde aparte de programar con estándares como HTML y javascript, también obtienes acceso de bajo nivel a ciertas funcionalidades del sistema operativo. - BlackBerry Messenger Social Platform, que es básicamente una manera de utilizar la mensajería (BB Messenger) bajo control programático, para enviar archivos, invitaciones, perfiles, datos, y por supuesto los tradicionales mensajes. - BlackBerry Payment Service SDK, esto permite que los desarrolladores de aplicaciones cobren de manera similar a como Apple cobra en el App Store, pero con más opciones de cobro que incluyen tarjetas de crédito, PayPal o hasta pago a la factura de tu celular (que está genial). - BlackBerry Advertising Service, esta es una plataforma de anuncios similar a los iAds de Apple en el iOS y al AdSense Mobile de Google. Bajo este esquema, el desarrollador cobra el 60% de los anuncios y RIM el restante 40%. autor: josé elías |

|

|

|

|

|

domingo, septiembre 26, 2010

|

Esta noticia de hoy, me lamenta decir en este caso, es una de las más importantes de la década, y trata sobre el primer virus a gran escala que amenaza con hacer estragos contra infraestructura de utilidades de todo el mundo. Esta noticia de hoy, me lamenta decir en este caso, es una de las más importantes de la década, y trata sobre el primer virus a gran escala que amenaza con hacer estragos contra infraestructura de utilidades de todo el mundo.El virus (o más técnicamente un "gusano digital" en este caso), ha sido bautizado como la red Stuxnet, y desde hace un año se ha estado instalando sigilosamente en toda forma de equipos industriales que controlan desde los sistemas eléctricos hasta los sistemas de manejo de gas propano y de aguas sanitarias de todo el mundo. Según expertos, Stuxnet no es el trabajo de un novato o de un pequeño grupo de hackers, sino que muestras todas las señales de que fue creado por un grupo bastante bien financiado, pues es una las piezas de software más sofisticadas jamás creadas en temas de virus informáticos. El virus ataca específicamente a un sistema de la empresa Siemens en Microsoft Windows que maneja equipos industriales (como sensores, válvulas, compuertas, etc), y su código demuestra un conocimiento profundo no solo de Windows y del software de Siemens, sino que además de las peculiaridades del hardware manipulado por ese software. Esto, mis queridos lectores, es algo que desde hace tiempo les he advertido acá en el blog, e incluso propuse un "Protocolo_X" a ser creado para contrarrestar los efectos de un ataque como este.  Este virus está programado para que en determinado momento, dada una señal distribuída por Internet, inicie una secuencia de eventos que crearían caos en los sistemas infectados. Hablamos de cosas bastante serias que van desde deshabilitar redes eléctricas completas, hasta abrir válvulas que controlen represas, y desde desviar el flujo vial, hasta causar situaciones fuera de control en plantas nucleares. Este virus está programado para que en determinado momento, dada una señal distribuída por Internet, inicie una secuencia de eventos que crearían caos en los sistemas infectados. Hablamos de cosas bastante serias que van desde deshabilitar redes eléctricas completas, hasta abrir válvulas que controlen represas, y desde desviar el flujo vial, hasta causar situaciones fuera de control en plantas nucleares.Es decir, hablamos de generar caos a gran escala. La posible buena noticia, es que al menos el virus fue detectado a tiempo antes de que actúe, y ya la empresa Symantec ha alertado a la industria (este próximo miércoles emitirá un boletín oficial al respecto), así como Siemens ha ofrecido una herramienta para tratar de remover el virus (herramienta que ya ha sido descargada unas 12,000 veces, lo que les debe dar una idea de la magnitud del daño si nadie hubiera hecho nada), aunque según expertos nadie sabe si verdaderamente el virus está bajo control, pues existen aun muchas plantas industriales que sin duda desconocen de este tema de seguridad, y por otro lado se ha descubierto que el virus es tan sofisticado que incluso haya sido creado para esconder una copia de sí mismo que se reactivaría incluso después de uno creer que lo haya removido. En cuanto a los posibles autores, los expertos opinan que Stuxnet es una pieza de software demasiada sofisticada para ser un simple hobby de unos simples hackers, y no descartan la posibilidad de que exista algún gobierno detrás de la maniobra dedicando muchos recursos en talento humano y dinero para operarlo. Incluso se han menciona hipótesis de que el virus podría estar no tanto buscando como objetivo a todas las plantas industriales del mundo, sino que una en particular en Irán, algo que es pura especulación pero que al menos nos indica la tendencia de los expertos en pensar que este nuevo tipo de ataques se trata ya no solo de algunos jóvenes curiosos trabajando desde el sótano de sus hogares, sino que de una nueva generación de armas cibernéticas a la disposición de gobiernos dispuestos a utilizarlas. En cuanto a la razón de nombrar esta una de las noticias más importantes de la década, lo hice porque independientemente de si Stuxnet no termine haciendo nada o sea neutralizado por completo, al menos sienta un gran hito en lo que sin duda será la norma en el futuro, algo que ya inició hace un tiempo atrás, pero que ya se hace inminente con esta noticia que será algo con lo que tendremos todos que lidiar en nuestras vidas. Finalmente, para los que se quieran apresurar a llamar a esta noticia sensacionalista, les recomiendo leer al menos los titulares de noticias previas en eliax relacionadas a este tema, y que aparecen justo al final de este artículo, para que así tengan una idea del panorama mundial en que nos encontramos... Fuente de la noticia en CNN Actualización 1: Se confirma que en Irán se infectaron unas 30,000 máquinas con este virus. Fuente. Actualización 2: Aparenta que el virus se originó en Israel. Fuente. autor: josé elías |

|

|

|

|

|

viernes, septiembre 24, 2010

|