|

viernes, julio 22, 2011

|

Sin la menor duda, Capitán América fue una de las películas más esperadas por mi este año, y si algo puedo decir, es que la película no decepciona… Sin la menor duda, Capitán América fue una de las películas más esperadas por mi este año, y si algo puedo decir, es que la película no decepciona…Una buena noticia es que Marvel Studios ya tiene dominada la fórmula para llevar a la pantalla sus super-héroes, y esta adaptación fue de tan alta calidad como la de Iron-Man y Thor, y lo mejor de todo, es una película puente para prepararnos para The Avengers (Los Vengadores) el próximo año. La película goza de un excelentísimo guión, muy bien escrito en cuanto a diálogo se refiere, y sin duda que los que sean "llorones" es posible que casi sientan un par de lagrimitas salírseles en un par de escenas heróicas, en donde sale a relucir la personalidad del Capitán América antes de convertirse en héroe. El actor que interpretó al Capitán América (Chris Evans) fue el mismo que vimos como la Antorcha Humana en la última adaptación de Los 4 Fantásticos, pero a diferencia de su papel en esa película, aquí brilla como actor, dando lo que quizás sea su mejor actuación a la fecha, y similar a las últimas adaptaciones de Spider-Man, le trae un sentido bastante "carne y hueso" al personaje, con el cual nos podemos sentir identificados (en particular los que amamos la justicia y somos un poco rebelde ante el establecimiento tradicional). La película fue muy bien dirigida, y aunque la primera mitad me gustó más que la segunda, lo cierto es que toda la película fue muy buena, aunque (afortunadamente) no esperen demasiada acción rápida al estilo Transformers. Algo que me encantó de esta adaptación es que funciona como puente para varias lineas de trama entre los otros personajes de Marvel (vemos por ejemplo los antecedentes de Iron-Man), así como explica varias cosas que vimos en las otras adaptaciones recientes (como Thor, en la escena después de los créditos). Y hablando de escenas después de los créditos, no se muevan de sus asientos hasta el mismísimo final de los (muy largos) créditos, pues serán muy bien recompensados, no solo con escenas adicionales, sino que con el primer avance oficial de The Avengers, la cual se perfila para ser una de las películas más taquilleras de todos los tiempos (este es el mismo avance que compartí con ustedes hace un par de días vía Twitter). Noten que vi la versión 3D de la película, pero en esta lo cierto es que no aportó casi nada, por lo que si prefieren ver películas sin las molestosas gafas, y con mejor brillantés de imagen, vayan a ver la versión 2D y no se van a perder mucho. En resumen, no dejen de verla, es una de las mejores adaptaciones de comics llevada al cine, y una de las más interesantes películas del año. Le doy 8.75 de 10 Avance de la película a continuación (enlace YouTube)... Actualización: Quiero agregar que me quito el sombrero ante los realizadores de los efectos especiales que pusieron la cara del persona principal en un cuerpo delgado, antes de verlo en su cuerpo musculoso final. El efecto es el mejor que se haya logrado de este tipo, a un nivel tal que es prácticamente imposible detectar que fue un efecto especial. autor: josé elías |

|

|

|

|

|

jueves, julio 21, 2011

|

|

Hoy los dejo con una dosis de breves en eliax...

1. AMD habla sobre sucesor del Xbox 360  Según la empresa de microprocesadores AMD, el sucesor de la consola de Microsoft, el Xbox 360, al que los medios estamos llamando temporalmente como la "Xbox 720", tendrá un poder gráfico tan potente, que la consola podrá renderizar gráficos equivalentes a los vistos en la película AVATAR, en tiempo real. Como dicen, ver para creer... fuente Según la empresa de microprocesadores AMD, el sucesor de la consola de Microsoft, el Xbox 360, al que los medios estamos llamando temporalmente como la "Xbox 720", tendrá un poder gráfico tan potente, que la consola podrá renderizar gráficos equivalentes a los vistos en la película AVATAR, en tiempo real. Como dicen, ver para creer... fuente2. Costo de anuncios en Facebook aumentan  El costo de colocar anuncios en Facebook ha aumentado un 74% sobre el mismo período del año anterior. Esto obviamente se debe al crecimiento acelerado que ha experimentado el portal social más grande del mundo (en la actualidad con más de 750 millones de usuarios activos). Y este, a propósito, es el mercado de Google, por como dije una vez, esta es una Furia de Titanes... fuente El costo de colocar anuncios en Facebook ha aumentado un 74% sobre el mismo período del año anterior. Esto obviamente se debe al crecimiento acelerado que ha experimentado el portal social más grande del mundo (en la actualidad con más de 750 millones de usuarios activos). Y este, a propósito, es el mercado de Google, por como dije una vez, esta es una Furia de Titanes... fuente3. Amazon renta libros escolares vía Kindle  Amazon acaba de lanzar un nuevo servicio para su plataforma de libros electrónicos Kindle, en donde estudiantes pueden rentar por un período de su elección todo tipo de libros escolares/universitarios con hasta un 80% de descuento del precio del libro impreso original. página oficial del proyecto Amazon acaba de lanzar un nuevo servicio para su plataforma de libros electrónicos Kindle, en donde estudiantes pueden rentar por un período de su elección todo tipo de libros escolares/universitarios con hasta un 80% de descuento del precio del libro impreso original. página oficial del proyecto4. Asombroso video del despegue de Atlantis Hace unos días fue el último lanzamiento al espacio en toda la historia de los transbordadores espaciales de la NASA (como reporté en eliax), en donde el honor lo tuvo el trasbordador Atlantis. Así que ahora los dejo con un video de aproximadamente media hora en donde podrán ver el despegue y la llegada en órbita desde varios ángulos por cámaras que captaron toda la acción. Verdaderamente asombroso para los que le guste la exploración espacial. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, julio 20, 2011

|

Los humanos somos criaturas altamente predecibles, estadísticamente hablando, e incluso de forma individual también solemos repetir los mismos patrones, prefiriendo las mismas cosas y por lo general teniendo los mismos gustos. Los humanos somos criaturas altamente predecibles, estadísticamente hablando, e incluso de forma individual también solemos repetir los mismos patrones, prefiriendo las mismas cosas y por lo general teniendo los mismos gustos.Tomando eso en consideración, una empresa ha creado una aplicación para el iPhone que es en realidad una Inteligencia Artificial que no solo te sugiere cosas, sino que incluso te sugiere cosas que ni idea tenías te gustarían. El software, llamado Aldred (como el mayordomo de Batman, asumo), utiliza la web como fuente de información sobre los restaurantes, bares, discotecas y cafés (las cuatro categoría con las cuales funciona actualmente), para saber su grado de popularidad entre personas que considera similares a ti, utilizando criterios de likes en redes sociales, menciones, etc. Y por otro lado el software literalmente aprende de tus hábitos, haciéndote algunas preguntas de vez en cuando para entenderte mejor. Armado con esos dos tipos de datos, Alfred puede crear una muy buena aproximación y deducción sobre las cosas que te gustan, e incluso puede predecir las cosas que te van a gustar. La aplicación es gratuita en el App Store, y los creadores planean expandir los conocimientos de Alfred a otras áreas en el futuro próximo. Ahora si tan solo pudieran combinar a Aldred con esto, y que quepa en la palma de la mano, no estaríamos lejos de este escenario... ¡Gracias al lector Gadiel Tavarez por el enlace! enlace a Aldred en el App Store fuente autor: josé elías |

|

|

|

|

|

martes, julio 19, 2011

|

Las personas fuera de círculos científicos piensan de "telescopios" como aquellos objetos en forma de tubos con lentes de magnificación en ambos extremos, o quizás incluso hasta entiendan que existen telescopio que utilizan espejos en vez de lentes para captar luz. Las personas fuera de círculos científicos piensan de "telescopios" como aquellos objetos en forma de tubos con lentes de magnificación en ambos extremos, o quizás incluso hasta entiendan que existen telescopio que utilizan espejos en vez de lentes para captar luz.Sin embargo, esto es apenas un tipo de telescopio, y ni siquiera el tipo más útil, ya que se concentra en observar fenómenos celestes en lo que es un muy estrecho ancho de banda en el espectro electromagnético. Es decir, los telescopios tradicionales (al igual que nuestros ojos) ven apenas una minúscula parte de los "colores" del Universo, pero para ver los otros colores (los cuales a propósito no existen como tal) se necesita de otro tipo de instrumentos, y uno de ellos son los llamados "radiotelescopios". El más conocido de todos en la cultura popular es el de Arecibo, que con un diámetro de 305 metros (1000 pies) aparenta ser un aparato bastante grande. Sin embargo, acabamos de lanzar hace horas el RadioAstron por la Agencia Espacial Rusa, y este radiotelescopio tendrá un diámetro de cobertura equivalente a 30 veces el ancho de la tierra. RadioAstron es un proyecto con más de 3 décadas de planeamiento, por lo que su lanzamiento al espacio es toda una celebración mundial en los círculos científicos. Este radio-telescopio se posará en una órbita que rondará entre los 10,000km (unas 6,000 millas) a 300,000km (unas 185,000 millas) de distancia de nosotros, y aunque su antena principal mide apenas 10 metros (32.8 pies) de ancho, permitirá captar imágenes con una resolución unas 10,000 veces más nítidas que el Telescopio Espacial Hubble. ¿Cómo? Pues con una técnica ya conocida hace mucho tiempo llamada interferometría. La mejor manera de entender lo que es interferometría es pensando en una multitud de personas al lado de un rio, tratando de ver un accidente que ocurrió al otro lado del río. Posiblemente una sola persona no pueda ver en detalle lo que ocurre del otro lado, pero entre todas pueden discernir más detalle. Una persona que por ejemplo esté parada a varios metros a la derecha de otra es posible que pueda discernir detalles que la primera persona no puede ver debido a su posición con relación al accidente, y así mismo es posible que algunas personas tengan una vista más agua que otras, o estén viendo el accidente desde encima de un edificio y tengan un mejor punto de vista, Pues interferometría es más o menos (aunque no exactamente) similar a esta escena, en donde combinamos los resultados de dos o varios instrumentos para combinar sus observaciones y entre todos obtener una "imagen" de mayor calidad y resolución. Específicamente, los datos del RadioAstron se combinarán con dos radiotelescopios de 100 metros localizados en EEUU, el radiotelescopio de 305 metros de Arecibo, y otros localizados en Alemania y otras regiones del mundo. RadioAstron enviará sus datos a 144Mbps a una antena en Rusia, pero se necesitará próximamente de la ayuda de otras antenas ya que de lo contrario la antena primaria en Rusia no tendrá capacidad para este flujo de datos y un gran volumen de las observaciones podrían perderse. Esperemos que más antenas se unan próximamente, y esperemos con ansias las primeras imágenes... fuente otra fuente autor: josé elías |

|

|

|

|

|

lunes, julio 18, 2011

|

En lo que es considerado como un gran hito en la exploración espacial, la sonda Dawn se acaba de confirmar que llegó a su destino y convirtió en el primer objeto terrestre que jamás haya entrado en órbita en torno a un asteroide en el cinturón de asteroides que existe entre los planetas Marte y Júpiter. En lo que es considerado como un gran hito en la exploración espacial, la sonda Dawn se acaba de confirmar que llegó a su destino y convirtió en el primer objeto terrestre que jamás haya entrado en órbita en torno a un asteroide en el cinturón de asteroides que existe entre los planetas Marte y Júpiter.El asteroide en cuestión es Vesta, y esta es la misión de la cual les hablé hace un par de meses (consulten ese artículo para más detalles de la misión). Dawn fue lanzada en Septiembre del 2007 y desde entonces ha llegado a una distancia equivalente a 188 millones de kilómetros (117 millones de millas), para posarse en órbita sobre este asteroide que mide unos 530km (330 millas) de ancho. Noten que aunque Dawn se encuentra a esa distancia, que en realidad ha viajado un camino de unos 2,700 millones de km (1,700 millones de millas), pues en el espacio por lo general no se vuela en lineas rectas" sino que se aprovecha la gravedad de otros planetas para maniobrar y ahorra combustible.  Y hablando de combustible, esta nave utiliza el novedoso sistema de propulsión de iones del cual les hablé por primera vez hace cinco años en el 2006. Y hablando de combustible, esta nave utiliza el novedoso sistema de propulsión de iones del cual les hablé por primera vez hace cinco años en el 2006.Posterior a esa visita se dirigirá hacia el asteroide Ceres, el cual midiendo unos 950km de ancho (unas 590 millas) es considerado no solo un asteroide, sino que incluso un "protoplaneta" (un planeta que no llegó al tamaño considerado como planeta o siquiera planeta enano como Plutón). Se espera que Dawn llegue a Ceres en el 2015. más información sobre la misión en space.com (recomendado visitar por las imágenes que verán) fuente autor: josé elías |

|

|

|

|

|

|

Acá en eliax he escrito cientos de artículos que de una forma u otra apoyan la noción de que tarde o temprano en nuestra planeta surgirán Inteligencias Artificiales con un intelecto, y sentimientos, superiores en todos los sentidos a la Inteligencia Biológica que poseemos los humanos. Acá en eliax he escrito cientos de artículos que de una forma u otra apoyan la noción de que tarde o temprano en nuestra planeta surgirán Inteligencias Artificiales con un intelecto, y sentimientos, superiores en todos los sentidos a la Inteligencia Biológica que poseemos los humanos.Pero un comentario recurrente cada vez que hablo del tema es el de los que alegan que esto es sencillamente imposible, ya que (según van sus argumentos) el hecho de que hoy día tengamos computadoras que quepan en la palma de la mano y que sean millones de veces más potentes que las de hace 40 años atrás, o incluso el hecho de que si seguimos esa tendencia dentro de 15 años tendremos dispositivos millones de veces más potentes a los que tenemos hoy día, que eso no garantiza que estas máquinas no sean simplemente "más rápidas" pero no más inteligentes. Lo cual, es un punto válido (aunque en mi opinión, erróneo, como explicaré brevemente). En otras palabras, muchas personas alegan que la inteligencia como la conocemos es algo exclusivo de nosotros los humanos, aun exista tanta evidencia de que animales como pulpos, cuervos, delfines, elefantes y primates den pistas de que tienen cierto grado de inteligencia avanzada, o incluso dada la evidencia de que existieron otros seres de inteligencia comparable a la de nosotros en el pasado terrestre. Alegan además que es pura especulación el hecho de que digamos que algún día una máquina podrá ser tan inteligente como un humano, ya que no poseemos ningún ejemplo viable en primer lugar. Pues hoy quiero exponerles este pensamiento, con el cual planeo demostrar precisamente lo contrario: Tenemos no solo un ejemplo, sino que el mejor de los ejemplos. ¿Y cuál es ese ejemplo? Pues nosotros mismos... Primeramente, muchos de seguro que pusieron una cara de incredulidad o confusión cuando dije que nosotros somos el mejor ejemplo de una Inteligencia Artificial, pero les ruego me sigan la corriente por unos breves instantes más y todo les quedará claro. Debo admitir que suena incluso paradójico el tratar de explicar que existirán seres de Inteligencia Artificial creados por nosotros, utilizando como ejemplo o evidencia a nosotros mismos en primer lugar, pero en realidad tiene mucha lógica. Sucede (y que suenen los tambores como en el circo justo antes de disparar al hombre bala por el cañón gigante) que nosotros los humanos, no somos más que complejas máquinas. Somos máquinas químicas, compuestas por miles de millones de células, en donde esas células contienen ADN, que en sí es una computadora química encargada de describir nuestro ser desde los pies hasta la cabeza. Eso implica de paso que nuestro cerebro también no es más que parte de esa máquina, y por consiguiente nuestras neuronas y los procesos que ocurren entre ellas. Y he aquí lo curioso: Una PC, un celular o el cerebro humano, al final del día no solo son máquinas, sino que están compuestas de exactamente los mismos ingredientes: átomos. En otras palabras, el denominar una inteligencia "artificial" no es más que en realidad querer decir "sintetizada por nosotros los humanos", pero la realidad es que la Inteligencia "Artificial" es tan natural como nuestra propia inteligencia. Tomando eso en consideración podemos decir entonces que definitivamente, y de forma contundente, tenemos un excelente ejemplo de una máquina ultra-compleja, formada por átomos, que piensa y está consciente de su existencia. Nosotros mismos. A tal fin, es lógico que si la naturaleza ya ha creado un ejemplo funcional de inteligencia avanzada con una mezcla compleja de átomos, ¿qué evita que hagamos nosotros lo mismo? La realidad es que salvo grandes retos de ingeniería, no existe absolutamente nada en la ciencia (ni siquiera a nivel teórico) que evite que podamos crear Inteligencias Artificiales. No es cuestión de si es posible, o de si lo lograremos o no. Es solo cuestión de tiempo, y ese tiempo se acerca cada vez más rápido con el desarrollo de tecnologías exponenciales como las que presento constantemente en el blog. Y no solo eso, sino que a diferencia de la versión biológica de inteligencia que poseemos los humanos hoy día, que evoluciona a un ritmo extremadamente lento (ya que depende de genes biológicos), las Inteligencias Artificiales que crearemos podrán evolucionar no a niveles de cientos de miles de años, sino que a niveles de semanas, horas o minutos (ya que no tendrán las restricciones genéticas de las cuales hemos evolucionado), y por tanto estas rápidamente nos superarán en todo sentido imaginable. Sin embargo, como he expresado en varios artículos y en Máquinas en el Paraíso, eso no significa el fin de la humanidad, sino que simplemente será nuestro próximo paso evolutivo (quizás de esta manera). Seremos Humanos 2.0... autor: josé elías |

|

|

|

|

|

domingo, julio 17, 2011

|

|

He aquí algo que no es nuevo, pero la manera en que lo implementaron hacer aparentar casi todo un nuevo invento, y cuando vean el video notarán por qué...

Se trata de Crowdflow ("Flujo de Multitudes"), un portal que lo único que hace es sencillamente graficar de forma animada todos los lugares en un mapa en donde grandes cantidades de multitudes han estado con sus celulares. En este caso y por el momento, esto solo funciona con iPhone, pero es obvio que esto se puede adaptar también a cualquier otra plataforma que utilice tecnología GPS. Lo interesante sin embargo, son las visualizaciones generadas, que como verán, son hipnotizantes... En el video notarán como fluyen las personas (en este caso, entre algunos lugares en Europa), y debo agregar que más allá de una simple curiosidad visual, esto en un futuro cercano tendrá muchos usos. Por ejemplo, con una aplicación como está será fácil ver cuáles son los lugares turísticos más populares en algún lugar (similar a esto), o los bares/discotecas nocturnos de más actividad (similar a esto), o las tiendas más concurridas, o los embotellamientos de tránsito más importantes, o los lugares de más concentración de personas en zonas de desastre, etc. página oficial de crowdflow Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

|

Fumiyuki Sato, un investigador del Instituto de Investigación Técnica y Desarrollo del Ministerio de Defensa de Japón acaba de revelar un invento que cuando lo vean en video les recordará todo tipo de objetos voladores en películas y literatura de ciencia ficción. Fumiyuki Sato, un investigador del Instituto de Investigación Técnica y Desarrollo del Ministerio de Defensa de Japón acaba de revelar un invento que cuando lo vean en video les recordará todo tipo de objetos voladores en películas y literatura de ciencia ficción.La esfera, a la que han bautizado como el Futurista Objeto Circular Volador, mide 42cm (17 pulgadas) de diámetro, pesa 340 gramos (unas 12.3 oz), y puede volar a una velocidad de 60kph (unas 37mph). Pero lo más asombroso de este dispositivo es verlo en acción en video, pues se mueve de una manera tan versátil que casi aparenta que el video es falso o que la esfera cuelga de algún hilo invisible. La esfera (que me recuerda mucho las esferas de entrenamiento de los Jedi en Star Wars), costó menos de US$1,400 dólares construirla, y utiliza una seria de hélices y aspas internas para moverse y mantener el equilibrio. Fue diseñada para poder moverse en lugares difícil de penetrar por humanos, o incluso por otros tipos de vehículos voladores o terrestres. Esta puede por ejemplo maniobrar (como verán en el video a continuación) por una ventada y subir escaleras flotando como si de un fantasma se tratara. Cuando se perfeccione, se espera poder utilizarla en labores de rescate, reconocimiento, antiterrorismo, y no duden que incluso posibles labores de espionaje. fuente Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, julio 16, 2011

|

Hace un par de semanas Google reveló uno de sus secretos peor guardados, Google+ ("Google Plus"), su primera propuesta seria para competir contra el campeón indiscutible de los portales sociales, Facebook, portal que ya ostenta la marca de más de 750 millones de usuarios activos mensualmente (y en crecimiento). Hace un par de semanas Google reveló uno de sus secretos peor guardados, Google+ ("Google Plus"), su primera propuesta seria para competir contra el campeón indiscutible de los portales sociales, Facebook, portal que ya ostenta la marca de más de 750 millones de usuarios activos mensualmente (y en crecimiento).Y en gran medida, es contra esa cifra de 750 millones de usuarios que Google se enfrenta, no tanto contra Facebook en sí. Pero antes de continuar, regresemos un poco en el tiempo para ver cómo llegamos a este punto... El fenómeno de los portales sociales es algo relativamente reciente, y que como toda nueva tendencia pasó por un período de caos mientras se sacudía el mercado y surgían los líderes. Hasta hace poco los líderes eran tres: MySpace, Twitter y Facebook (y existen otros portales que han sobrevivido en nichos, como LinkedIn que se ha especializado en redes sociales para profesionales). Muchos titanes (incluyendo el mismo Google) no creo que hayan captado la importancia de las redes sociales hasta muy reciente, razón por la cual Facebook y Twitter proliferaron con relativa poca competencia, y sí es que captaron la importancia entonces no supieron entenderla o como tomar ventaja de ella. Google es un ejemplo de ambos de esos escenarios. Primero no captó la importancia de estas redes, y la amenaza que representa para su negocio, entrando demasiado tarde al mercado, y segundo entró con una solución que aunque sumamente poderosa (Google Wave) estaba demasiada adelantada a su tiempo (pues espero que el concepto detrás de Google Wave resurja como el ave fénix en un futuro no lejano). El otro intento de Google fue el Google Buzz, el cual era no tanto un competidor de Facebook, sino que más bien de Twitter, sin embargo no solo también entró demasiado tarde al mercado, sino que además era (es) muy complejo para el usuario promedio. En ambos casos, con Google Wave y con Google Buzz, Google violó uno de los conceptos básicos que se necesitan para que un producto o servicio masivo sea exitoso: Hay que hacer que el producto/servicio sea lo más fácil de utilizar posible, aun se sacrifiquen funcionalidades que a algunos usuarios expertos le hagan falta. Eso fue precisamente lo que causó la muerte de MySpace. El portal ofreció tantas libertades y funcionalidades a sus usuarios, que entrar a un perfil de MySpace se estaba convirtiendo no tanto en una interacción social, sino que más bien en una visita a una discoteca psicodélica en donde la página de cada usuario de MySpace se veía totalmente diferente a las demás, super personalizada, en muchos casos con fondos que hacían difícil leer la información, canciones tocando en el fondo, decenas de aplicaciones tratando de captar tu atención a la misma vez, y en medio de todo eso uno se perdía por completo en el interfaz de usuario, tratando de entender a qué opción darle clic para hacer incluso las cosas más básicas. Similarmente, Wave y Buzz eran demasiado sofisticados, y quizás no tanto sofisticados en algún sentido absoluto, sino relativo a los tiempos en que vivimos. Todavía para gran parte de esos 750 millones de usuarios de Facebook, algunas cosas son sencillamente muy complicadas para entender. Sin embargo eso cambiará con la nueva generación de humanos en los años venideros. Así que después de esos dos strikes, me da placer decir que Google por fin le ha pegado a la pelota, y no con un simple hit, sino que posible tengan un home-run en sus manos... Lo primero es que Google por fin hizo algo que muchos nos preguntábamos por qué no lo había hecho antes: Integraron a Google+ directamente en su página principal de su buscador, en esencia replicando la estrategia que utilizó Amazon para popularizar sus lectores de libros electrónicos Kindle, ofreciéndolos prominentemente en su página principal. Con Google+ tan prominentemente en la barra superior de google.com, no es de extrañarnos que en poco más de 2 semanas el servicio ya haya alcanzado más de 10 millones de usuarios (y eso, que con restricciones de invitaciones por el momento), así como ya se comparten más de mil millones de cosas (mensajes, fotos, notificaciones, etc) diariamente. Tan solo esta medida será un factor clave en el éxito de G+ (un apodo que muchos ya estamos utilizando para el servicio). Sin embargo, lo cierto es que aun sin ese gran empuje que ofrece google.com a Google+, el servicio se nota que iba a crecer de todas maneras de forma vertiginosa. Google ha creado lo que posiblemente sea la mejor implementación de "círculos de amigos" que se haya implementado en un portal social, y lo ha llamado aptamente "Circles". Con Circles, Google logró dos cosas claves: La primera es que se hace extremadamente fácil (al borde de lo trivial) por fin organizar nuestros contactos en categorías o círculos. Por fin ahora en vez de yo tener 5000 "amigos" (como en Facebook), ahora puedo fácilmente organizar los que son mis verdaderos amigos en un grupo, y poner los otros en otros grupos (yo por ejemplo tengo grupos para mi familia, amigos, fans de eliax, etc). Y lo segundo es que también hace trivial el agregar grandes cantidades personas a tus círculos, por lo que la red en sí crece mucho más rápido que muchas otras redes sociales.  Pero Google no se detuvo ahí. La otra gran funcionalidad que creo ofrece es la de los hangouts, en donde puedes crear de forma instantánea pequeñas reuniones con video-conferencia con tus amigos, contactos, círculos, etc, y de forma sencilla, y a diferencia de la solución que posteriormente lanzó Facebook hace unos días en donde solo puedes hacer video-conferencia con una persona a la vez, con Google+ puedes hacer video-conferencia con varias personas simultáneamente, en donde todos ven a los demás "en vivo" creando un verdadero sentido de comunidad personal, algo que en Facebook uno rara vez siente. Pero Google no se detuvo ahí. La otra gran funcionalidad que creo ofrece es la de los hangouts, en donde puedes crear de forma instantánea pequeñas reuniones con video-conferencia con tus amigos, contactos, círculos, etc, y de forma sencilla, y a diferencia de la solución que posteriormente lanzó Facebook hace unos días en donde solo puedes hacer video-conferencia con una persona a la vez, con Google+ puedes hacer video-conferencia con varias personas simultáneamente, en donde todos ven a los demás "en vivo" creando un verdadero sentido de comunidad personal, algo que en Facebook uno rara vez siente.Sin embargo, no todo es color de rosa, aunque debo aclarar (y esto es importante entenderlo si comparamos con un servicio como Facebook que ya tiene años operando): Google+ está aun en fase "beta" (de pruebas), razón por la cual por el momento no todos pueden entrar, sino que deben recibir una invitación de alguien ya adentro, cosa que Google está limitando constantemente. Debido a ese estado "beta", hay muchas cosas que he notado que deben mejorarse (y asumo que Google está al tanto perfectamente de estas deficiencias, por lo que no me sorprendería verlas resulta al corto plazo). Lo primero es que de vez en cuando existen problemas de rendimiento. Me pasa constantemente que veo mensajes de que mis notificaciones no se pueden ver debido a la carga en el sistema, o por algún error de conectividad de Google+. Lo segundo es que me sorprende que Google+ no esté más integrado entre las otras propiedades de Google, como por ejemplo GMail (todo contacto debería ya tener una opción para agregarlo directamente a uno de mis círculos), Google Docs, Blogger, o Feedburner (me sorprende por ejemplo que puedo compartir el feed RSS de eliax desde Feedburner con Twitter, pero no con Google+). Otra cosa es que soy usuario de Google Apps for your Domain, y mi cuenta de email personalizada no la puedo utilizar con Google+, por lo que me vi forzado a utilizar una de GMail. Y lo tercero es que es urgente que Google haga público unos APIs (Interfaces de Programación para Aplicaciones) de modo que terceros puedan integrar sus soluciones con Google+ (por ejemplo, si existiera un API yo quizás pudiera dedicar unas horas para integrar a eliax con Google+). Relacionado a ese tercer punto es el crear widgets (componentes visuales que páginas como eliax integran en su portal), similar como los que muestran los lectores de Facebook y Twitter en eliax, o como el Facebook Comment Plugin. Este es el tipo de cosas que no solo son útiles, sino que expanden la red muchísimo más rápidamente, y de paso crean un sentido de lealtad (y sí, dependencia) a la plataforma al largo plazo. Otra cosa de mi agrado es que según Google, la empresa planea crear soluciones de Google+ específicamente para empresas e instituciones varias (es decir, no solo soluciones personales), lo que podría ser otra gran vía de crecimiento, en particular dado los potentes servicios de Google como Google Docs o el Google Apps Marketplace. Pero la gran pregunta es, ¿será esto suficiente para destronar a Facebook? Pues honestamente, al corto plazo no creo que nadie destronará a Facebook, dado el gran impulso y ventaja que tiene, y la gran penetración y dependencia que se ha formado a su alrededor. Sin embargo, no lo duden por un instante que en estos momentos Google+ es finalmente el primer contendiente digno de Facebook, y el que al mediano y largo plazo podría igualar en importancia. Pero tampoco duden que Google aun tiene mucho trabajo por hacer con Google+ (como algunos de los puntos que expuse anteriormente), pero si siguen como van, es posible que en las oficinas corporativas de Facebookse se pongan un poco nerviosos dentro de unos meses... Bienvenidos a otro round de esta Furia de Titanes. Actualización: Los que deseen agregarme a sus círculos pueden hacerlo accediendo a mi perfil en Google+ autor: josé elías |

|

|

|

|

|

viernes, julio 15, 2011

|

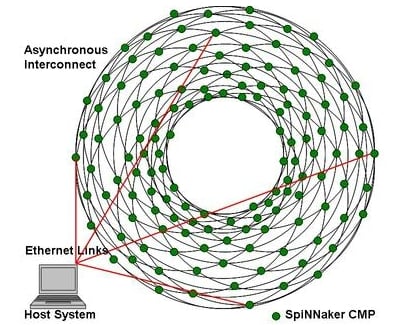

Científicos de la Universidad de Manchester en el Reino Unido planean crear una de las más complejas simulaciones jamás intentadas del cerebro humano, y a diferencia de varias soluciones anteriores que dependen de software (programas) para emular neuronas humanas, este nuevo proyecto planea utilizar hardware. Mucho hardware, y por mucho hardware hablamos de 1 millón de procesadores, un cifra sin precedentes en la confección de sistemas de computación altamente paralelos. Científicos de la Universidad de Manchester en el Reino Unido planean crear una de las más complejas simulaciones jamás intentadas del cerebro humano, y a diferencia de varias soluciones anteriores que dependen de software (programas) para emular neuronas humanas, este nuevo proyecto planea utilizar hardware. Mucho hardware, y por mucho hardware hablamos de 1 millón de procesadores, un cifra sin precedentes en la confección de sistemas de computación altamente paralelos.El proyecto ha sido bautizado como "SpiNNaker" ("Spiking Neural Network architecture"), y utilizará 1,000,000 de procesadores ARM (del mismo tipo que encontrarmos en la mayoría de los celulares inteligentes de hoy día como Android o iPhone). Cada procesador ARM simulará a 1,000 neuronas y sus correspondientes conexiones, por lo que hablamos de una simulación que abarcará mil millones de neuronas. Noten que el cerebro humano contiene entre 80 y 90 mil millones de neuronas, por lo que este sistema simulará apenas poco más de un 1% del cerebro. Sin embargo, esto es suficiente, según dicen los investigadores a cargo del proyecto, para ofrecernos un gran entendimiento sobre el funcionamiento de nuestro asombroso órgano, y de paso adelantar el campo de la Inteligencia Artificial. De particular importancia en este estudio es entender mejor (y quizás, a fondo) el mecanismo de señalización de información entre neuronas. Hoy día existen varias teorías sobre cómo se codifica y decodifica información entre neuronas. Una teoría dice que el ritmo de "spikes" (breves pero potentes impulsos eléctricos) es lo que codifica información, y otra más moderna dice que es el orden en que se emiten estos spikes. Con este modelo podremos probar ambas teorías y quizás por fin decodificar este misterio, lo que sería un gran avance para la creación de una nueva generación de máquinas pensantes. Un par adicional de curiosidades sobre este proyecto es que el diseñador de este fue el mismo que diseño el chip ARM de 32-bits mientras trabajaba en la empresa Acorn, por lo que eso tuvo mucho que ver con la decisión de utilizar estos procesadores. Sin embargo, la decisión de utilizar ARM fue más racional de lo que quizás se imaginen, pues estos chips son de entre los que consumen menos energía en el mercado en la actualidad, razón por la cual son utilizados tanto en dispositivos móviles, y razón por la cual son ideales para este sistema. La otra curiosidad es que según ha sido diseñado el sistema, cada neurona podrá actuar en el orden de 1 milisegundo, que es precisamente la velocidad de una neurona biológica, por lo que esta simulación en teoria ocurrirá "en tiempo real". Es importante también notar que si hoy ya podemos simular un 1% de todas las neuronas del cerebro, y si el poder de computación continúa duplicándose cada 18 meses (como lo ha hecho desde hace varias décadas), que entonces podremos simular el 100% del cerebro humano en alrededor de 10 años, en el peor de los casos (en el artículo fuente dicen 25 años, pero calcularon mal según mis cálculos). Y noten que hablamos de simular un cerebro humano dentro de 10 años en un solo chip, por lo que al conectar varios de esos chips hablamos de un poder computacional que eclipsaría a cualquier humano (aunque ojo, esto es poder bruto, falta entender mejor y codificar mejor el tema de la Inteligencia Artificial). Otro error en el artículo fuente es que asumen que veremos mejoras en el tema de consumo energético, necesitándose varios Kilovatios de energía para simular un cerebro, pero lo cierto es que ya tenemos indicios (con noticias de avances como este) de que será todo lo contrario: Llegará un momento en donde simular un cerebro humano consumirá muchísimo menos energía que lo que consume cualquier cerebro biológico sobre la faz de la Tierra. fuente autor: josé elías |

|

|

|

|

|

|

¿Alguna vez se han preguntado en dónde están esos cables submarinos de Internet que conectan a los distintos países, continentes e islas? ¿Alguna vez se han preguntado en dónde están esos cables submarinos de Internet que conectan a los distintos países, continentes e islas?Pues un tal Greg Mahlknecht se hizo la misma pregunta y decidió investigar por varios meses hasta confeccionar el interesante mapa interactivo que verán a continuación... enlace al mapa de cables submarinos de Internet autor: josé elías |

|

|

|

|

|

jueves, julio 14, 2011

|

El año pasado publiqué acá en eliax un artículo sobre un nuevo virus informático bautizado como "Stuxnet", en donde escribía que este no era un virus informático común y corriente, sino que era un nuevo tipo de virus que podría causar serios estragos en el mundo físico (en particular, plantas nucleares, plantas eléctricas, bancos, represas, etc). El año pasado publiqué acá en eliax un artículo sobre un nuevo virus informático bautizado como "Stuxnet", en donde escribía que este no era un virus informático común y corriente, sino que era un nuevo tipo de virus que podría causar serios estragos en el mundo físico (en particular, plantas nucleares, plantas eléctricas, bancos, represas, etc).En ese entonces algunos catalogaron el artículo de alarmista, pero hoy los invito a leer por fin todo lo que ocurrió tras bastidores, en un super artículo publicado en la revista Wired, en donde nos explican con lujo de detalles por qué este fue el virus informático más sofisticado de todos los tiempos (y de paso, que es solo el inicio de cosas mucho peores por venir). El artículo lo recomiendo como lectura obligatoria para cualquier persona que tenga incluso el más pequeño interés en este mundo de la seguridad cibernética. Es uno de esos artículos seminales en el tema que todos referencian en un futuro. Pero para animarlos a leerlo (pues es un artículo sumamente largo, les tomará al menos una hora leerlo), he aquí algunos datos interesantes sobre Stuxnet... Este virus tenía en su carga digital 4 "zero-day exploits". Estas son vulnerabilidades descubiertas (por lo general con mucho esfuerzo y por hackers sumamente talentosos) que aun no han salido a la luz pública y por lo general son muy peligrosas. Sin embargo, al año se presentan quizás de entre 10 a 12 casos de estas vulnerabilidades (entre cientos de miles que surgen constantemente), y el hecho que este solo virus tuviera 4 de ellas nos dice que quienes crearon este virus estaban sumamente bien financiados o al menos era un equipo extremadamente talentoso (para que tengan una idea, en el mercado negro una vulnerabilidad como esta se compra por entre US$50,000 a US$500,000 de dólares). Stuxnet además se diseñó para que se propagara sin necesidad de redes públicas, utilizando solo memorias USB o comandos de redes locales de Windows. Así mismo permanecía totalmente fuera del radar de los antivirus (con mecanismos que meritan una película de Hollywood y detallados para usuarios técnicos en el artículo). El virus podía manejarse remotamente, tenía varios niveles de cifrado (varios núcleos unos dentro de otros), y era totalmente modular y reconfigurable con unas 400 variables por los atacantes. Para que tengan una idea, aun bajo las mismas narices de los antivirus que creían lo tenían dominado, Stuxnet infectó a unas 100,000 máquinas, y lo más asombroso es que lo hizo ¡sin querer infectar máquinas por el Internet! No quería infectar máquinas por el Internet ya que este virus fue diseñado específicamente para atacar a una central nuclear en específico en Irán. El virus era tan sofisticado, y el conocimiento de los que lo crearon tal, que este buscaba los IDs de las válvulas que controlaban esa central, y con una cantidad y configuración específica de válvulas (en otras palabras, los creadores del virus obtuvieron información por medio de espionaje de la configuración exacta de la platan nuclear a atacar). Sin embargo, eso es solo parte de toda esta historia, lean el artículo que se lee como una novela de ficción, con la gran diferencia de que todo fue real... artículo original en Wired (en inglés) traducción al español por Google Translate autor: josé elías |

|

|

|

|

|

miércoles, julio 13, 2011

|

Cuando escribí el artículo de ayer sobre Call Centers y como estos van a ser afectados negativamente por la nueva generación de dispositivos móviles de bajo mantenimiento, dejé una As bajo la mano para continuar el artículo hoy. Ese As es la supercomputadora Watson de IBM, que como reporté en una serie de artículos terminó ganando en Febrero de este año uno de los concursos intelectuales más difíciles que cualquier humano podría enfrentar. Cuando escribí el artículo de ayer sobre Call Centers y como estos van a ser afectados negativamente por la nueva generación de dispositivos móviles de bajo mantenimiento, dejé una As bajo la mano para continuar el artículo hoy. Ese As es la supercomputadora Watson de IBM, que como reporté en una serie de artículos terminó ganando en Febrero de este año uno de los concursos intelectuales más difíciles que cualquier humano podría enfrentar.Posterior a ese gran logro por IBM, la empresa anunció que adaptaría a Watson al sector de la salud, en esencia convirtiéndose en un consultor médico para diagnosticar y responder preguntas difíciles de la medicina a cualquier nivel. Y ahora, la empresa anuncia que adaptará a Watson al sector de servicios por telefonía, lo que incluye Call Centers y servicios asociados como tele-ventas, tele-mercadeo y servicio al cliente. Muchas personas de seguro que todavía piensan que "una máquina jamás igualará a un humano en estas tareas" (cosa con la que no estoy de acuerdo, pues creo que es solo cuestión de tiempo), pero a veces se olvidan (como bien notan en el artículo fuente) que incluso el más humano de los humanos a quienes le hacemos una pregunta vía telefónica no sabe siempre como resolvernos el problema, algo para lo que Watson tendrá poca dificultad. A diferencia de un humano, Watson puede almacenar una cantidad virtualmente ilimitada sobre un tema en específico, y hacer todo tipo de correlaciones, automáticamente, y después inferir una respuesta a prácticamente cualquier pregunta, de paso aceptando preguntas que jueguen con las idiosincracias del lenguaje hablado humano. Recuerden además que un sistema como este no tiene que ser perfecto, sino que con que solo sea "suficientemente perfecto" como para responder la mayoría de las preguntas eso es más que suficiente para tener un caso sólido de negocio en las manos de IBM. Solo ponderen esto: Una nube de supercomputación con la tecnología utilizada por Watson puede abastecer a miles de centros de llamadas, a un costo extremadamente inferior al de los sueldos de humanos. Por lo que una empresa que antes requería de 1000 empleados, ahora solo requerirá de quizás 100 de los más expertos, y el resto sería manejado por Watson. Y yéndonos más lejos, ¿para qué contratar a un Call Center en primer lugar si ahora con una solución como esta podemos dar soporte nosotros mismos a nuestros productos y servicios? Esto como siempre trae el tema de los futuros escenarios que vemos en el cine en donde todos los humanos son desplazados por seres sintéticos y quedamos todos como cucarachas. Yo soy de los optimistas que opina que eso no va a suceder (salvo quizás parcialmente por un breve período de transición), ya que nosotros los humanos evolucionaremos para fusionarnos con nuestras creaciones (en este artículo explico en detalle mi hipótesis). fuente autor: josé elías |

|

|

|

|

|

martes, julio 12, 2011

|

Antes de siquiera continuar escribiendo sobre esta noticia debo advertirles algo (en particular para los lectores más jóvenes): Independientemente de los resultados de este estudio, siempre utilicen un condón/preservativo antes de tener relaciones sexuales, pues es importante prevenir no solo embarazos no planeados, sino que además enfermedades sexuales de todo tipo. Antes de siquiera continuar escribiendo sobre esta noticia debo advertirles algo (en particular para los lectores más jóvenes): Independientemente de los resultados de este estudio, siempre utilicen un condón/preservativo antes de tener relaciones sexuales, pues es importante prevenir no solo embarazos no planeados, sino que además enfermedades sexuales de todo tipo. Habiendo hecho esa aclaración, continuemos con esta curiosa noticia de hoy... Según un estudio realizado en el State University of New York, el semen actúa como un antidepresivo en mujeres (y ya me imagino la controversia que este estudio generará en los próximas días/meses/años). El estudio, realizado a 293 mujeres, utilizó una técnica llamada el Beck Depression Inventory, en donde se le hacen una serie de preguntas a las personas, y dependiendo de la puntuación obtenida se determina más o menos el grado de depresión de la persona. Mientras mayor la puntuación mayor el nivel de depresión (y como guía, una puntuación de 17 representa a una persona moderadamente deprimida). Entonces, he aquí los resultados: - Mujeres que nunca utilizaron condones obtuvieron un 8 - Las que utilizaron condones a veces, un 10.5 - Las que utilizaron condones frecuentemente, un 15 - Las que utilizaron condones siempre, un 13.5 Otro dato interesante encontrado fue que las mujeres que rara vez utilizaban condones se deprimían más mientras más tiempo pasaban sin hacer el amor, mientras que el tiempo entre sesiones de hacer el amor no afectó la psicología de mujeres que usualmente o siempre utilizaban condones. O en otras palabras, las mujeres que hacían el amor sin condones se deprimían menos mientras con más frecuencia hacían el amor. Otro dato curioso (y sin duda también controversial) es que las tendencias suicidas eran mayores entre mujeres que utilizaban condones que en mujeres que no (una vez más, porque aparentemente el semen actúa como antidepresivo natural). Agregando más leña al fuego, la empresa investigadora Gallup dice que aunque aun no había hecho la publicación oficial (en el momento que salió este primer estudio), que otro estudio que realizó con 700 mujeres confirman los datos de esta investigación. Noten que los que realizaron el estudio buscaron muchas otras posibles razones que podrían explicar estos resultados, pero siempre regresaban al semen, y como explican, no es de sorprendernos ya que el semen contiene todo tipo de hormonas, incluyendo testosterona, estrógeno, hormonas estimulante de folículos, hormonas luteinizantes, prolactina y varias prostaglandinas diferentes. Alegan incluso que este tipo de hormonas son fácilmente detectadas en el flujo sanguíneo de las mujeres apenas horas de haber tenido relaciones sexuales sin condones. Asombrosamente, se cree que incluso varios de los efectos obtenidos por el semen introducido por la vagina se deberían obtener también por el sexo oral (aunque esto está aun por comprobarse con otro estudio). Y esto, a propósito, es otra de esas curiosidades de la Evolución en acción. Se especula por ejemplo que los humanos desarrollamos esta cualidad ya que los hombres que más hacen sentir mejor a las mujeres son los que más posibilidades tienen de seguir teniendo relaciones sexuales, y por tanto procrearse, lo que hace que los genes que promueven este "antidepresivo natural" sobrevivan más entre la población. ¡Gracias Tania Mukai por el enlace vía Google+! fuente autor: josé elías |

|

|

|

|

|

|

Hoy día toda la industria de microprocesadores (es decir, los "chips" que le dan inteligencia a nuestras máquinas) funciona en su modo más fundamental, de exactamente la misma forma, independientemente de cual sea el fabricante, o la potencia del chip: Todos funcionan moviendo electrones de un lugar a otro. Hoy día toda la industria de microprocesadores (es decir, los "chips" que le dan inteligencia a nuestras máquinas) funciona en su modo más fundamental, de exactamente la misma forma, independientemente de cual sea el fabricante, o la potencia del chip: Todos funcionan moviendo electrones de un lugar a otro.El problema es, que en términos de eficiencia energética, esta es una operación bastante costosa (y la razón principal por la cual la batería de tu laptop o celular se descarga tan rápidamente), pero ahora una investigación de punta realizada en la Universidad de California, Berkeley, promete hacer que en un futuro los microprocesadores (y transistores) de hoy día aparenten dinosaurios... La investigación se centra en una novedosa técnica que no utiliza electrones para mover información en un chip, sino que utiliza magnetos/imanes, en efecto creando una nueva forma de computación que podríamos llamar "Procesadores Magnéticos". Es decir, en vez de transferir o almacenar información por medio de transferencia de electrones, la idea es trasferir/almacenar por medio de los efectos magnéticos que un imán tiene sobre otro. La importancia de esta investigación es que según estudios teóricos, y posteriormente experimentales, una procesador que funcione a base de magnetos en vez de electrones sería 1 millón de veces más eficiente en términos energéticos que uno tradicional de hoy día. En otras palabras, en un futuro podríamos tener dispositivos de computación móvil que durarían años y no solo horas, antes de tener que ser recargados una vez más. Según los estudios, circuitos creados con esta técnica funcionarían en lo que se llama el Límite de Landauer. Rolf Landauer fue un científico que hace 50 años calculó la mínima cantidad de energía necesaria para hacer un operación lógica en un circuito. Específicamente, un circuito con esta nueva técnica disiparía apenas 18 milielectrón-voltios a temperatura ambiente, o 6 órdenes de magnitud inferior a un circuito de hoy día. Noten que esta es una investigación que apenas se inicia, por lo que tardarán años para que veamos los frutos de esta investigación, sin embargo lo interesante de esto es que nos habla sobre lo que veremos en un futuro no lejano, con dispositivos equivalentes a las supercomputadoras de hoy día, en la palma de la mano. Así que si combinamos esta noticia de hoy, con esta de hace un par de años, solo podemos llegar a la conclusión de que cerebros sintéticos no están tan lejos en el futuro como muchos se imaginaban... fuente autor: josé elías |

|

|

|

|

|

|

A través de los años he tenido familiares, amigos y conocidos que han trabajado directa o indirectamente en el negocio de los Call Centers ("Centros de Llamadas"), y este artículo de hoy es una advertencia no solo para ellos, sino que para toda persona involucrada en el sector... A través de los años he tenido familiares, amigos y conocidos que han trabajado directa o indirectamente en el negocio de los Call Centers ("Centros de Llamadas"), y este artículo de hoy es una advertencia no solo para ellos, sino que para toda persona involucrada en el sector...El fenómeno de los Call Centers es algo que surgió poco después de la masificación de las computadoras personales, pero que como muchos empresarios pronto aprendieron, no tiene que ser necesariamente ligado al negocio de las PCs (otro uso que se le da es como centro de ventas por llamadas telefónicas para empresas que soliciten tales servicios). Sin embargo, hoy nos concentraremos específicamente en Call Centers que dan soporte técnico a usuarios. Estos Call Centers, proliferaron junto con el crecimiento de empresas como IBM, HP/Compaq, Dell y otros, como una respuesta al creciente problema del soporte técnico. En vez de una empresa como Dell tener que pagar altos salarios a empleados estadounidenses, solo por recibir llamadas telefónicas de clientes frustrados, empresas en lugares como la India empezaron a ofrecer ese servicio a un costo muchísimo menor. El negocio creció tanto que hoy día es una excepción a la regla el uno llamar a una de estas grandes empresas en EEUU, y hablar con un estadounidense en los EEUU. Es más posible que la llamada que creemos hacemos en EEUU es manejada en la India, México, u otros lugares remotos. Pero he aquí lo interesante (y recuerden, no hablo de todos los tipos de Call Centers, sino de un grupo específico de Call Centers): Este negocio creció a medida que crecían las frustraciones de los usuarios con sus PCs. Se podría incluso decir que gran parte del negocio de los Call Centers fue el resultado de las frustraciones de los usuarios con Windows de Microsoft y todo el ecosistema que creció alrededor de ese entorno. O en otras palabras, es fácil notar la siguiente fórmula: Mientras más problemas tienen los usuarios con el hardware y software de sus electrodomésticos, más crece el negocio de los Call Centers ya que se generan más llamadas de soporte técnico. Y he aquí en donde entra en escenario Apple. Apple revolucionó el mercado de los celulares al introducir el original iPhone hace 4 años, pero entre todas las bondades que trajo el iPhone al mercado hay una que es la que nos interesa en este artículo de hoy: El iPhone fue uno de los primeros dispositivos con la capacidad de poder reemplazar muchas funciones que tradicionalmente eran delegadas a PCs, y que además era un dispositivo de casi cero mantenimiento. Esas dos cualidades son los dos enemigos de los actuales Call Centers que dan soporte técnico a PCs hoy día. Después del iPhone, todo nuevo celular inteligente que surgió copió (en varios niveles de éxito) el modelo iPhone de "algo sencillo y que simplemente funciona". Lo copió Google con Android. Palm con Web OS. Y más recientemente RIM/Blackberry y Nokia (ambos con mucho menor éxito). Y para empeorar más las cosas a los Call Centers, vimos el reciente triunfo del iPad. Estos dispositivos de bajo mantenimiento y alto poder ya han empezado a desplazar la PC (y en específico, Windows) de su estandarte tradicional de ser el dispositivo principal con el cual interactuamos día a día. Incluso, los más recientes datos indican que en tan solo los últimos 12 meses Windows perdió un alarmante 5% del mercado, algo insólito para un producto que en muchos sentidos Y ese fen[omeno de Windows decaer, y plataformas móviles crecer, tendrán un efecto que se sentirá cada vez mayor en la industria de los Call Centers, ya que estos dispositivos móviles por lo general generan un número significativamente menor de llamadas a soporte técnico, así como son reemplazados por usuarios a un ritmo muchísimo mayor que antes. Hoy día muchos usuarios prefieren simplemente cambiar a un celular más moderno que lidiar con soporte técnico. El mercado de celulares se está convirtiendo en una simple industria de "equipos desechables". En otras palabras, estamos entrando en una era en donde nuestros dispositivos de computación personal no requerirán de soporte técnico (en gran medida, no por completo obviamente), se actualizarán ellos mismos, se repararán ellos mismos, y cuando den problemas los usuarios simplemente los reemplazarán por otros más potentes y/o sencillos. Finalmente, noten que aunque este escenario por el momento solo aplica a Call Centers que lidian con este tipo de soporte técnico, que no duden que al largo plazo afectará a otros tipos de Call Centers, según se continúe haciendo negocio más directo entre productores y consumidores de todo tipo de productos y servicios, y conforme tales productos y servicios se conviertan en algo tan sencillo y trivial, que un usuario preferirá posiblemente buscar ayuda inmediata por medio de una búsqueda a Google, que a perder media hora de su vida haciendo una llamada telefónica... autor: josé elías |

|

|

|

|

"Cada quien tiene su derecho a opinar, es cierto. Pero hay debates que en mi opinión no tienen pies ni cabeza... Los seres humanos nacemos con los mismos derechos, no importa la orientación sexual, el color, la religión, o punto de vista político... Así mismo como nacemos con los mismos derechos, también nacemos con los mismos deberes, el respeto a la libre expresión, a la vida, etc.... Mi punto es que mientras no se le haga daño a terceros, cada quien haga con su vida lo que quiera."

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax