Software

|

miércoles, septiembre 4, 2024

|

Hola amig@s lectores, Hola amig@s lectores, Si les dijera que este artículo completo fue escrito por una Inteligencia Artificial (IA), ¿me lo crearían? Hace apenas dos años atrás quizás no, pero con la llegada de una nueva generación de IAs del tipo LLM (Large Language Model) como ChatGPT es posible que muchos de ustedes no sepan qué responderme. Y eso, es un problema. Aunque por un lado estamos adentrándonos en uno de los más emocionantes (sino, el más emocionante) momentos de la humanidad, a la misma vez esto trae consigo un nuevo tipo de problemas, problemas que aunque no son totalmente nuevos (me refiero a la capacidad de hacer creer que algo ficticio es real) sí podemos decir que amplifica de forma exponencial esos problemas anteriores. Como ejemplo, el año pasado se hizo viral una imagen del Papa Francisco aparentemente modelando un abrigo de nieve en una pasarela, y poco después se hizo viral otra imagen de Elon Musk aparentemente enamorado de una mujer cibernética, y recientemente hemos visto personas como Donald Trump utilizar tecnología deep fake e imágenes de famosos creadas enteramente por software para hacer aparentar que esas personalidades apoyan su segunda candidatura presidencial en los EEUU. Pero eso apenas es el comienzo… Nos estamos adentrando a un mundo en donde no vamos poder estar seguros de nada de lo que leemos, vemos o escuchamos, y esto tendrá graves repercusiones sociales de forma masiva, al menos que tomemos medidas al respecto (medidas que sugiero más adelante en este mismo artículo). Imaginen por ejemplo si llega un reclamo a una empresa de seguros, con no solo evidencia de audio de una llamada telefónica pidiendo auxilio, sino además fotografías desde múltiples ángulos del accidente reportado, y hasta video de una cámara de seguridad cercana a los hechos. Hasta hace par de años esta evidencia se hubiese considerado prueba contundente de que el supuesto accidente reclamado realmente sucedió, y la empresa aseguradora hubiese sido obligada a pagar potencialmente millones en daños. Pero, hoy día, ¿cómo podemos estar seguros de que esa llamada telefónica, esas fotos y ese video no fueron generados por las más recientes versiones de programas como Midjourney o Sora de OpenAI? Similarmente, si recibes una llamada de emergencia de un familiar cercano, y la voz es idéntica a esa persona, e incluye incluso el tipo de lenguaje que utilizaría, con las mismas expresiones que caracteriza a esa persona, ¿enviarías algo dinero de ayuda a esa persona para sacarla de un apuro? Si la pregunta anterior les intrigó, noten el caso de un ejecutivo de una empresa multinacional con sede en Corea del Sur, a quienes unos hackers estafaron US$25 Millones de dólares al convencer a alguien en la empresa para que transfiriera esa cantidad de dinero. ¿Y cómo lo lograron? Pues convocaron a una víctima en el departamento de finanzas (que teníala capacidad de hacer transferencias bancarias) a una reunión virtual con el supuesto General General de Finanzas y varios otros ejecutivos de alto nivel de la empresa para discutir un asunto urgente, y sucede que todos los “ejecutivos” de la reunión habían sido personificados con tecnología deep fake para crear avatars/clones de ellos que se veían, hablaban y comportaban como los seres humanos que reemplazaban. Es decir, en esa llamada de videoconferencia grupal, la única persona real era la víctima, y todos los demás integrantes que participaron en la videollamada eran clones digitales de sus otros compañeros de trabajo y superiores de la empresa. Estos avances en Inteligencia Artificial Generativa (IA que genera desde cero cualquier tipo de contenido que puedas imaginar) están proveyendo a una nueva generación de criminales digitales un nuevo conjunto de herramientas para engañar, estafar, atacar, sabotear, sobornar y robar a una escala hasta hace poco inimaginable. Estamos literalmente entrando a un umbral en donde se está haciendo extremadamente difícil (por no decir casi imposible) distinguir lo real de lo falso. Y el gran problema que eso trae es que la sociedad humana desde sus orígenes se mantiene estable en base a una sola cosa: La confianza. ¿Y cómo podrá funcionar una sociedad en donde no exista confianza a nivel personal, profesional, institucional o a cualquier otro nivel? Es decir, ¿cómo sabes que la tienda a la cual le estás comprando algo online es real? ¿Cómo sabes que el portal o app de tu banco no es uno falso? ¿Cómo sabes que con quien estés hablando en una videoconferencia es quien dice ser? ¿Cómo sabes que el video que viste de un ser querido supuestamente haciendo una fechoría es real? ¿Cómo sabes que los resultados de tus búsquedas en Internet son reales? ¿Cómo sabes que el video de tu hija haciendo pornografía no es real? ¿Cómo sabes que la empresa con la cual llevas semanas negociando es real? ¿Cómo sabes que las autoridades gubernamentales que te están demandando un pago de impuestos es real? ¿Cómo sabes que un documento científico que estás leyendo es real y cita fuentes reales y contiene datos reales? ¿Cómo sabes que las noticias que estás viendo es real? ¿Cómo sabes que lo que dice el próximo candidato presidencial es reall? Bajo este nuevo esquema social que estamos entrando gracias a la IA Generativa se hará casi imposible operar, creer o maniobrar, y podríamos fácilmente llegar a un estancamiento social de proporciones épicas. Sin embargo, hay soluciones que podemos implementar como sociedad. La primera es una recomendación que hago a nivel familiar y de amigos cercanos, y es la de crear una palabra o frase clave que solo ustedes conozcan, y que nunca hayan comunicado de forma digital en ningún momento, de modo que si algún día reciben una llamada de emergencia o de alguna otra índole dudosa, ustedes puedan preguntar la palabra o frase clave para verificar la identidad de la persona al otro extremo de la comunicación. Así que por ejemplo, si en una reunión familiar nos ponemos de acuerdo de que nuestra palabra de seguridad será “Segismundo”, y posteriormente recibes una llamada de un familiar aludiendo una emergencia y pidiendo una transferencia de dinero, lo primero que le preguntarías es la palabra clave secreta. Si la persona no pueda contestarla (o al menos decirte el lugar y otros datos del día en que acordaron la clave) eso significa entonces que esa persona está posiblemente siendo personificada por un hacker con tecnología deep fake. La segunda sugerencia es una sugerencia tecnológica que debemos exigir se integre a toda tecnología que capture o genere contenido en cualquier formato (sea texto, sonido, imágenes o videos), y tiene que ver en que desde su misma fuente debemos poder codificar una firma digital que podamos verificar contra alguna fuente. Así que por ejemplo, bajo este esquema toda cámara digital, todo celular, todo micrófono y toda IA que genere imágenes, texto, sonido o video debe poder incrustar información que permita comprobar que el cotenido o fue (1) generado por medios “orgánicos” (como por ejemplo, un video que capturaste en un cumpleaños) o (2) por medios sintéticos (como un video de un cumpleaños imaginario generado por una IA), así como proveer información de su fuente (como el autor, fecha de creación, etc). De esta manera, si vemos una noticia o leemos un libro o artículo, o recibimos una llamada de audio o participamos en una videoconferencia, podemos tener algún grado de certeza de que lo que percibimos es real o sintético y de su actual procedencia. Para esto es necesario desarrollar estándares tecnológicos en la industria para que la información capturada (por ejemplo) por una cámara digital esté cifrada desde el momento que es capturada por su sensor de imagen, y para que una firma digital sea parte de la imagen antes de que esta se almacene o esté disponible para distribuirse, y de paso que en cualquier momento se pueda detectar si el contenido fue alterado en lo más mínimo. Una buena noticia es que ya existe una iniciativa de parte de algunos fabricantes de cámaras y líderes de la industria para crear algo similar, e incluso ya existen algunas cámaras profesionales del mercado con tecnología similar a esto, y de paso ya existe investigación para crear sistemas que incluyan watermarks (“sellos de agua” digitales) en habla generada por IA Generativa, e incluso ya existe una propuesta de ley en el estado de California en EEUU para requerir que todo contenido sintético tenga que venir con un watermark, por lo que poco a poco veremos este tipo de tecnología esparcirse a todo sistema que genere contenido de alguna forma. Y esperemos que estas soluciones ocurran más temprano que tarde, ya que de no ser así nos arriesgamos a que la falta de confianza en nuestros sentidos nos lleven a un caos social con resultados posiblemente catastróficos para la humanidad. - p.d.: Para los curiosos sobre la pregunta que puse al inicio del artículo, no, este articulo no fue escrito por una IA. O al menos eso le digo a ustedes… Actualización: El lector Sergio Hernandez hizo una buena observación en los comentarios sobre el tema de firmas digitales, y respondí a su comentario para aclarar que cuando hablamos de una firma de agua digital hablamos de una firma criptográfica basada en el concepto de un Hash (y por extensión en cifrado de datos con llaves públicas y privadas), sin embargo esos son conceptos demasiados técnicos que extenderían demasiado este artículo, lo importante es el concepto de poder verificar la fuente de algo. Actualización 8 de abril 2025: Panasonic se une al Content Authenticity Initiative para poder autenticar que las fotos tomadas con sus cámaras que soportan el estándar no fueron modificadas posteriormente. autor: josé elías |

|

|

|

|

|

miércoles, agosto 17, 2022

|

¿Imaginan un futuro en donde por fin no tengan que entrar una clave más en una página web o app para poder acceder? Pues ese futuro ya está aquí, y hoy les explico cómo funciona. ¿Imaginan un futuro en donde por fin no tengan que entrar una clave más en una página web o app para poder acceder? Pues ese futuro ya está aquí, y hoy les explico cómo funciona.Lo que permite esto es una técnica que en sí existe desde hace años y se llama "criptografía de llaves públicas y privadas", sin embargo hasta recientemente esa técnica se ha utilizado para temas muy específicos de bajo nivel de los cuales la mayoría de usuarios desconoce (por ejemplo, es lo que permite que salga "el candado" que protege tu navegador de Internet cuando estás entrando tus credenciales y compras, y es lo que también permite que distintas entidades bancarias transmitan entre sí información de forma segura por el internet público). Pero desde el 2016, una de las entidades que vela por la estandarización del internet (la W3C) emitió un estándar llamado WebAuthn que por fin está siendo adoptado por las grandes empresas que tienen plataformas con miras al usuario común (como Apple, Google y Microsoft), y que permitirá que por fin nunca tengas más ni que crear, memorizar o escribir claves. Y la razón que escribo este artículo hoy es porque estamos a semanas de que Apple lance su tecnología PassKeys en iOS 16 y en macOS Ventura, que permitirá que cientos de millones de personas inicien a utilizar esta tecnología, lo que la popularizará y masificará y hará que otras plataformas como Android y Windows (que también ya ha sacado tecnologías similares) también expandan su base de usuarios con sus respectivas tecnologías libres de claves que también interoperarán por medio del estándar WebAuthn. Ok, ¿cómo funciona esto? Para entender utilicemos una analogía de cómo funcionan los sistemas tradicionales de "login" de hoy día: Hoy día cuando entras a una página web o app que solicita tu usuario y clave, en esencia lo que está ocurriendo es que la página web o app te está pidiendo que le pases la llave de un candado digital que ellos tienen almacenados en su servidor o app. Y si tu llave abre ese candado entonces eso significa que tus credenciales son válidos y te permiten entrar. Pero en el caso de WebAuthn y PassKeys, lo que sucede es que la página web o app te envía a ti tu candado, y si tu logras abrirlo para ellos entonces esa es la señal de que tus credenciales son válidos ya que tú debiste haber tenido la llave que abre el candado. Eso de paso significa que los administradores de la página web o app nunca tienen acceso a tan siquiera ver tu llave que abre el candado de seguridad, ya que la llave la mantienes tú en todo momento. Pero, ¿cómo es esto posible? Pues lo que sucede tras bastidores es realmente bastante simple: Se utiliza un par de llaves, una privada y una pública, que están relacionadas matemáticamente entre sí, en donde lo que tú cifres con la llave privada solo puede ser descifrado por la llave pública, y viceversa. La llave privada siempre permanece almacenada localmente en tu dispositivo local (digamos, tu celular como ejemplo), y la llave pública (que en este caso podemos ver más como un candado) se la das a todo el mundo que desee poder darte acceso a su página web o app. Y de la manera que funciona el mecanismo es que en el momento que visitas una página web o app por primera vez tu dispositivo le provee automáticamente tu llave pública (el "candado") junto con cualquier otra información requerida (nombre, email, etc). Esto crea tu cuenta y nota que nunca tuviste que escribir una clave. Después de ahí cuando desees entrar a tu cuenta lo que sucede es que la página web o app le pregunta a tu celular quien eres, y este le da tu usuario (digamos, tu email) en cuyo momento la página web o app responde enviándole a tu dispositivo un mensaje cifrado con tu llave pública (el candado), y lo que tu dispositivo tiene que hacer ahora es utilizar tu llave privada (que solo tienes tu) para descifrar el mensaje y que la página web o app sepa que tú eres realmente quien dices ser. Esto es posible ya que solo tu llave privada puede descifrar un mensaje cifrado con tu llave pública. Y es bueno notar que en el paso en donde la página web o app envía tu llave pública que en ese momento tu dispositivo utiliza los datos biométricos asociados a tu dispositivo (como por ejemplo tu huella digital o cara, con tecnologías como Touch ID o Face ID de Apple) para enviar el mensaje cifrado al chip de seguridad de tu celular para que este descifre el mensaje con tu llave privada. O en otras palabras, tus datos biométricos ahora se convierten en tu forma de acceder a una página web o app. Así que en la práctica para entrar por ejemplo a una página web o app el procedimiento sería el siguiente: 1. Visitas la página web o abres el app. 2. Escaneas tu huella digital o cara en el celular. 3. Y esto es todo. Entras inmediatamente al app. Pero ojo, que no es tan solo que ahora con tu huella o cara puedes entrar a una página web o app sin tu hacer nada, la otra gran ventaja de esto es que no existen claves en ningún paso que tengas que crear, almacenar o recordar. Esto es sin duda alguna la forma más transparente que existe a la fecha para que accedas a tus datos sin necesidad alguna de utilizar claves. Pero aparte de que ya no existirían claves que tengas que manejar, la otra gran ventaja de este mecanismo es que eliminarían gran parte de los riesgos de seguridad que existen en el momento que hackers malignos traten de adivinar o robarte tu clave, ya que no hay clave para robar por ningún lado. Incluso si un hacker tuviese grabando todo lo que haces en la pantalla de tu celular, o instalara uno de esos programas troyanos que monitorean tu teclado, aun así no podrán acceder a tus páginas web o app ya que el mecanismo realmente depende de que tu celular utilice tu llave digital privada para descifrar mensajes cifrados con tu llave pública, y esa operación ocurre en un área protegida de tu celular (en iPhones ocurre en el Digital Enclave, un chip que solo puede ser desbloqueado por ti y cuya firma digital almacenada no puede sacarse de ese chip incluso por medio de programación de software; y en Windows y Android existen mecanismos similares: en Windows con la tecnología TPM y en Android hay ejemplos como la tecnología Knox de Samsung). Habiendo dicho todo eso, he aquí ahora algunas respuestas a preguntas que quizás tengan sobre esta tecnología: 1. ¿Cuál es la diferencia entre esto y el usar un Password Manager (Gestionador de Claves) que utiliza mis datos biométricos? Un Gestionador de Claves con lo único que te ayuda es en almacenar tus claves en un lugar centralizado en una zona relativamente segura, y en escribir las claves por ti en páginas web y apps, pero sufren del tema de que todavía estás teniendo que depender de una clave que hay que escribir en algún formulario, y por tanto no te protege en lo absoluto de las más populares formas de ataque (como leer tu teclado, infectar una página web con malware, o simplemente adivinar tu clave de forma bruta probando millones de combinaciones una a la vez). 2. ¿Qué sucede si quiero que alguien más entre a mi cuenta con mis credenciales, no podrán hacerlo si no tienen mis datos biométricos? Para esto esos usuarios tendrían o que (1) entrar de forma tradicional con un usuario y clave, lo que no es muy seguro, o (2) imagino que en un futuro cercano será posible que desde tu celular des permiso en tiempo real a esa otra persona de forma remota para que entre (similar a como con el sistema de ScreenTime de Apple los padres podemos autorizar que nuestros hijos compren cosas por Internet desde sus propios celulares). 3. Si soy usuario de Apple o Google y quiero acceder a un servicio de otro proveedor como Microsoft, Amazon, eBay u otro ¿tengo que tener un dispositivo en esa plataforma para acceder o recrear mis datos biométricos con ellos de alguna forma? La tecnología WebAuthn es totalmente interoperable, por lo que funcionará de forma transparente entre distintas plataformas, proveedores y dispositivos. Eso significa por ejemplo que un usuario de Android que haya instalado el app iTunes de Apple en su celular podrá seguir utilizando sus credenciales de su celular Android para acceder a los servicios de subscripción de Apple sin necesidad de entrar claves. 4. ¿Qué sucede si mi dispositivo no tiene capacidades biométricas para por ejemplos leer mi huella digital o escanear mi cara en 3D? Es posible (a opción del proveedor de tu celular o laptop por ejemplo) de utilizar WebAuthn sin datos biométricos, utilizando un PIN de unos cuantos dígitos, sin embargo esta opción no es tan segura ni conveniente como la opción biométrica, aunque ciertamente es más segura y conveniente que la forma tradicional de hacer login. Mi recomendación es que opten por celulares que al menos puedan leer la huella digital, y noten que ya la nueva generación de laptops y teclados están soportando leer tus huellas digitales (como por ejemplo todas las nuevas laptops de Apple, así como sus teclados externos con Touch ID), por lo que en cuestión de 2 a 5 años esta será la norma. 5. He leído que hackers han podido sacar copias 3D de huellas digitales, ¿no comprometerá eso la seguridad de esta tecnología? Una ventaja de esta tecnología es que tu llave privada está almacenada en tu celular o laptop a mano, por lo que incluso si alguien clonara tu huella digital no les serviría de nada al menos que también tengan acceso físico a tu celular para poner la huella en el lector. 6. ¿Y qué tal de hackers que ponen fotos o estatuas de réplica de una persona para engañar el sistema biométrico de tu cara? El mismo comentario anterior de huellas digitales aplica aquí, si los hackers no tienen acceso a tu celular físicamente no pueden tener acceso a tus credenciales. Noten además que hay dos tipos de reconocimiento facial. Hay una que es utilizada por muchos celulares Android que lo que hacen simplemente es sacarle una foto a tu cara y compararla con una foto previamente tomada. Esta forma no es segura para acceder a tu celular (y recomiendo no utilizarla) ya que es fácilmente penetrable con solo mostrarle una foto de tu cara al celular (lo he hecho personalmente con amigos). La otra forma es lo que hace Apple con Face ID que es totalmente diferente: El iPhone dispara más de 30,000 puntos invisibles a tu cara con los cuales crea una máscara virtual en 3D, cuyos datos combina también con una imagen previamente tomada de tu cara en 2D y 3D, y de paso el iPhone observa tus pupilas para asegurarse de que estés vivo y atento a la pantalla (por eso es que el iPhone te solicita que veas el celular directo). Esto es muchísimo más seguro y es la forma recomendada de implementar reconocimiento facial, y razón por la cual para temas biométricos el iPhone es permitido por varias instituciones financieras para asegurar tus transacciones con tu cara, mientras que no lo permite con varios otros tipos de celulares. En el mundo Android, cuando estés en duda, opta por el momento de escribir este artículo en autenticación biométrica con tu huella digital, al menos que al leer las especificaciones técnicas de tu celular sepas y entiendas qué tipo de autenticación biométrica facial realiza. --- Actualización Febrero 2023: Apple recientemente con iOS 16.3 y macOS 13.2 permite el uso de llaves en hardware para sus dispositivos iPhones, iPad y Macs, lo que se une a la misma funcionalidad que también se puede obtener en Windows y en algunas versiones de Android. Con este tipo de llaves o "Hardware Keys" es posible asegurar aun más tu cuenta, ya que para iniciar sesión en cualquier nuevo dispositivo con tu cuenta debes conectar físicamente (en un puerto USB-A o USB-C o Lightning) o de forma inalámbrica cercana (con NFC, como en todos los iPhones recientes) una llave en forma de memoria USB que contiene tus credenciales para poder entrar. En la implementación de Apple es requerido que tengas que activar dos llaves como mínimo (y un máximo de 6) con la finalidad de que si se te pierde, avería o te roban una, tengas una segunda de repuesto para emergencias. Nota que si por alguna razón pierdes accedo a tus llaves, que Apple te permite devolver a entrar de forma manual con tu clave y PIN siempre y cuando tengas habilitada la función de Autenticación de Dos Factores (2FA, o Two-Factor Authentication), pues es la única forma que pueden asegurarse (en la medida de lo posible) que nadie te pueda hackear remotamente. autor: josé elías |

|

|

|

|

|

martes, diciembre 21, 2021

|

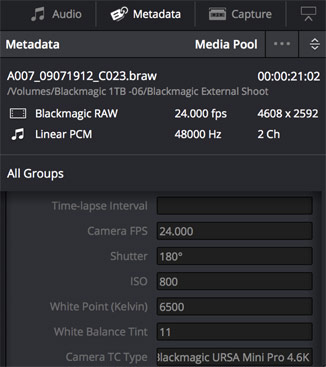

Hola amig@s lectores, Hola amig@s lectores,Antes de finalizar el año quiero hacer una breve reseña de las cosas tecnológicas más relevantes de este año 2021, desde sorpresas hasta cosas que cambiarán nuestras vidas en el futuro. Así que sin mucho más que decir, y sin ningún orden en particular, he aquí mi lista: 1. Iniciativa del Año: El Metaverso, por Meta (previamente llamada Facebook) El Metaverso no ha sido inventado por nadie en particular, pero Mark Zuckerberg se apropió del término y hasta renombró a su empresa Meta para demostrar lo serio que está con este tema. Y aunque falta ver si Meta será el principal o uno de los principales jugadores en todo esto del Metaverso (piensen de ello como el inicio a un mundo similar al de Matrix), lo cierto es que hay que darles crédito por no solo popularizar el término en la cultura popular, sino por animar al resto de a industria a tomar el concepto totalmente en serio. 2. Tendencia del año: NFT Si hay algo que junto con el Metaverso será parte fundamental de nuestro futuro tecnológico, es el concepto de los NFT (o Tókens No-Fungibles), que son el equivalente digital a tu ser propietario de cosas en el mundo fuera del ciberespacio. Lean más sobre NFTs aquí. 3. Palabra del año: NFT Y en segundo lugar "Metaverso". 4. Cripto-plataforma del año: Ethereum Aunque Bitcoin fue lo que indudablemente puso el tema de las criptomonedas en el mapa, en realidad ha sido Ethereum con su plataforma y su Ether que han estado revolucionando el espacio de las cripto-transacciones, permitiendo no solo pagar con monedas digitales sino proveyendo herramientas para crear toda una nueva generación de aplicaciones desentralizadas (como los NFTs). Y si les interesa el cripto-trading, acá un artículo al respecto. 5. Visor de Realidad Virtual del Año: Oculus Quest 2 Aunque este visor salió el año pasado, continúa al día de hoy siendo la mejor introducción al Metaverso que puedan comprar, y lo mejor de todo es que dependiendo dónde y cuándo compren su precio ronda entre los US$250 y US$300 dólares, que en mi opinión es una mejor compra que una consola tradicional de video-juegos que cuesta mucho más y no ofrece ni cerca del grado de inmersión que este equipo ofrece. Esta es una de las compras tecnológicas que más recomiendo a cualquiera. 6. Innovación Cinematográfica del Año: Empate entre (1) la cámara DJI Ronin 4D con tecnología flotante y LIDAR, y (2) la tecnología Cinema ProRes en el iPhone 13 Pro. La cámara DJI Ronin 4D es una cámara totalmente diferente a todas las que vinieron antes. No solo tiene un diseño en donde el sensor y el lente flotan delante de la cámara (para hacer imágenes super estables) sino que además incluye tecnología LIDAR para enfocar, lo que significa que la cámara crea una representación tridimensional de su entorno por medio de rayos láser para saber la distancia exacta entre el lente y el sujeto a grabar, permitiendo enfocar de manera super precisa no solo de día sino incluso en casi total oscuridad (la tecnología LIDAR es utilizada también por algunos fabricantes de automóviles robóticos para entender su entorno). Y en cuanto a la tecnología Cinema ProRes, de alguna manera Apple logró meter dentro del espacio de un celular (en este caso la versión Pro del iPhone 13) un encodificador del estándar de codificación de cine, ProRes, lo que le permite grabar video en crudo con una calidad que hasta ahora era solo posible en cámaras que costaban decenas de miles de dólares. Y de paso le agregaron un modo de desenfoque computacional a las imágenes para darle un "look" más cinemático a los videos. Si tienen un iPhone 13 Pro noten que esto deben activarlo en Configuración, y que si no saben lo que hacen no recomiendo lo utilicen ya que este tipo de videos genera archivos varias veces más grandes que videos normales. Esto está diseñado específicamente para profesionales que necesitan la más alta calidad posible (que tampoco será evidente hasta que sepan como manipular los parámetros del video generado para cambiar su exposición y otros factores). 7. Cámara Computacional del Año: Google Pixel 6 Hay dos maneras principales de crear imágenes fotográficas: De forma óptica (es decir, lo que sea que entre al sensor por el lente) y de forma computacional (es decir, se toman datos del lente y después se mejoran con computación), y un ejemplo de fotografía computación es la funcionalidad que popularizó Apple que permite desenfocar el fondo de una foto después de esta haber sido tomada. Sin embargo ha sido Google quien ha llevado esto a otro nivel con su nuevo celular Pixel 6, que en mi opinión es el mejor valor por tu dinero en el mundo Android en estos momentos. 8. Tecnología Revolucionaria del Año: Los procesadores M1 Pro/Max de Apple Cada cierta cantidad de años una tecnología surge que estremece los cimientos de su industria ocasionando grandes cambios, y la serie de procesadores M1 Pro/Max acaban de hacer eso. Estos procesadores no solo han creado un abismo en la relación precio/rendimiento entre Macs y las tradicionales PCs con Windows, sino que han creado toda una revolución que ahora están forzando a Microsoft y los demás participantes del mundo Windows a adoptar procesadores con tecnología ARM. Solo para que tengan una idea, una laptop MacBook Pro 2021 con el procesador M1 Max puede manipular en tiempo real hasta 7 fuentes de video 8K en crudo y HDR, lo que significa el manipular 56 veces más flujos de datos en tiempo real que un video 4K tradicional. Lograr eso en una PC tradicional requiere en la actualidad de comprar tarjetas de video especializadas que cuestan por sobre los US$5,000 dólares, y aun así no pueden manejar 7 flujos de 8K HDR simultáneos. Y todo eso lo hace un solo chip dentro de una MacBook Pro ahora. Y esto no es solo mercadeo. Todas las pruebas que ya se han hecho públicas por profesionales creativos han confirmado que una MacBook Pro M1 ya es entre 3 y 15 veces más rápida que una PC super potente costando varias veces más, utilizando el mismo programa en ambas máquinas (como Photoshop, Lightroom, etc). Y como si fuera poco, Apple logra todo eso con un super bajo consumo energético que permite que todo ese poder se pueda utilizar en una laptop corriendo en batería todo el día, sin conectar la corriente eléctrica a una pared, mientras que en el mundo Windows hacer lo mismo por lo general significa PCs de escritorio con power supplies halando al menos 250 vatios continuos como mínimo. Esto está provocando una ola de adopción y migración hacia Macs como nunca antes vista en la historia de Apple, y acelerando la llegada de una nueva generación de procesadores ARM para Windows en el 2022. Aprende más sobre la tecnología de chips propietarios de Apple aquí. 9. Sistema de Computación Personal del Año: Apple MacBookPro M1 Pro/Max Debido a las razones enumeradas en el punto anterior, en estos momentos no hay nada ni siquiera remotamente cercano a lo que puedes obtener en términos de rendimiento por tu dinero al comprar una MacBook Pro 2021 con procesador M1 Pro o M1 Max. 10. Innovación Cotidiana del Año: AirTags de Apple Los AirTags son objetos del tamaño de monedas grandes que dejas en tu automóvil, mochila, mascota, cartera o cualquier cosa que se te pueda perder o te puedan robar, y que te permite localizarlo rápidamente. Los AirTags es bueno notar que no tienen función de GPS con ellos, sino que dependen de que cerca de ellos existan personas con un iPhone, ya que Apple ha creado una red global en donde todos los iPhones del mundo se comunican de forma segura con los AirTags, y reportan su ubicación. Así que por ejemplo si te roban tu automóvil, y dejaste un AirTag adentro, es bastante posible que en algún momento algún desconocido que tenga un iPhone estará cerca de tu vehículo, en cuyo caso el AirTag se comunicará contigo y sabrás donde está tu auto (y claro está, que como todo en la vida, esto tiene sus usos buenos y malos como ya ha sido reportado de bandidos pegando AirTags a autos que desean robar para saber la ubicación de su propietario). 11. Sorpresa visual del año: La cámara Nikon Z9. Nikon salió literalmente de la nada con una cámara mirrorless (sin espejo) que ha no solo dejado atónitos a todos sino que dejado hasta mal parada a la competencia. Esta cámara aparte de poder disparar fotos a 20fps en RAW, 30fps en JPG, también tiene un modo especial para capturar 120 fotos por segundo en menor resolución. Esto la hace en una cámara ultra potente para deportes y acción. La cámara además tiene 45 Megapixeles con un impresionante rango dinámico lo que la hace también excelente para fotografía de bodas, retratos artísticos, y moda. Como si fuera poco graba video crudo con resolución 8K lo que de paso la hace una máquina ultra potente para el cine profesional. Una actualización gratuita próxima le permitirá grabar video12-bit 8K N-Raw y 4K ProRes RAW internamente, con 8K/60fps. Algo inaudito. Como si fuera poco, tiene un ultra-rápido sistema de enfoque automático 3D que se asegura que tus fotos salgan nítidas sin importar cuánto se mueva el sujeto que estás capturando en fotos o video. Y noten que aunque la cámara cuesta US$5,500 dólares, que eso es más barato que las cámaras de gama alta de Canon (la EOS R3) y Sony (la A1). 12. Renacimiento del año: Nikon Gracias a su cámara Z9, la empresa se acaba de levantar como el ave Fenix de sus cenizas. La empresa no ha podido fabricar suficientes para satisfacer la demanda. 13. Herramienta de Desarrollo de Software del Año: Microsoft Visual Studio Code No confundir con su otro producto llamado simplemente "Visual Studio", esta es la versión open-source que se ha tornado indispensable para toda una nueva generación de desarrolladores de software, gracias a su expandabilidad por medio de plug-ins que expanden su funcionalidad a esencialmente cualquier área imaginable de la computación. 14. Plataforma de Desarrollo Multi-Plataforma del Año: Google Flutter Si planean arrancar desde cero un App que deba compilar tanto para Android como iPhone, iPad, y ahora hasta Web, Windows, Linux y Mac, no creo exista mejor opción en el mercado que Flutter de Google. No solo genera Apps multi-plataforma sino que de muy alto rendimiento, y la más reciente versión ahora incluye librerías para video-juegos 2D de alto rendimiento. 15. Plataforma de Streaming del Año: Disney+ Disney+ no tiene ni cerca del contenido de Netflix, sin embargo se ha enfocado en algunos nichos que ha hecho que despegue más rápido que Speedy Gonzalez. Parte de su truco ha sido capitalizar sus franquicias de Marvel, creando series originales que solo se pueden ver por esa vía, como la excelente Loki. 16. Tecnología Científica del Año: El James Webb Space Telescope Si todo sale bien este telescopio se lanzará este próximo 25 de Diciembre 2021, y durará 1 mes para llegar a su destino a 1.5 millones de km de distance a un punto calmado y equilibrado grabitacionalmente, en donde desplegará una gran sombrilla espacial para bloquear la luz solar y poder observar el universo en tranquilidad como ningún otro instrumento en la historia de la humanidad. Su misión principal será la de observar los primeros 100 a 250 millones del años después del Big Bang (es decir, cuando nuestro universo era un bebé) para así entender mejor nuestros orígenes. Sin embargo la ciencia que hará será mucho más extensa que eso, tocando todos los campos de la astronomía y astrofísica a nuestro alcance, desde agujeros negros y posible materia oscura hasta la evolución de galaxias y el estudio de objetos exóticos como los cuásares. El lanzamiento de este instrumento es algo que hemos estado esperando desde el 1989 (a un costo de casi 10 mil millones de dólares) cuando se propuso por primera vez, por lo que esta será la misión con más nervios jamás lanzada al espacio por la humanidad. 17. Avance de Salud del Año: AlphaFold por DeepMind DeepMind es una inteligencia artificial de Google, y uno de los proyectos en que participó se llama AlphaFold, que ha permitido en tiempo record predecir como se doblan de forma tridimensional todo tipo de moléculas, específicamente proteínas de ADN. Esto es un paso monumental que en pocos años acelerará el descubrimiento de medicinas y tratamientos para todo tipo de enfermedades. 18. Viaje Espacial del Año: William Shatner (“Captain Kirk”) en la nave de Blue Origin Jeff Bezos (fundador de Amazon y Blue Origin) ganó muchos puntos de mercadeo este año al anunciar que enviaría al espacio a William Shatner, mejor conocido como el Capitán Kirk en la serie clásica de Star Trek ("Viaje a las Estrellas"), logrando con eso un sueño de muchos geeks de ver a este actor subir al espacio en la realidad. 19. Empresa Espacial del Año: SpaceX ¿Qué más podemos decir de esta empresa? Sencillamente no tiene igual. No solo hizo decenas de pruebas y lanzamientos (de cargo a naves espaciales exploratorias, de viajes a la Estación Espacial Internacional, y subiendo todo tipo de satélites), sino que está bien encaminada a cumplir su misión de llevar la humanidad al planeta Marte, como lo prometió su fundador Elon Musk. 20. Nave Espacial del Año: StarShip de SpaceX ¿Podrían imaginar un edificio rascacielos no solo despegando sino que volviendo a aterrizar de espalda nuevamente? Pues eso es exactamente lo que hace la nave StarShip que en el 2021 SpaceX logró demostrar que podrá cumplir su misión no solo de subir grandes cantidades de cargo al espacio, sino de llevarnos al planeta Marte. 21. Tecnología Espacial del Año: StarLink de SpaceX ¿Internet satelital de alta velocidad y baja latencia en cualquier parte del mundo y a un costo razonable? Envíenme el contrato rápidamente... Elon Musk es un genio certificado. 22. Empresa Automovilística del Año: Tesla Tesla casi por su propia cuenta ha sido la principal responsable a nivel mundial de popularizar los vehículos eléctricos, y no vemos fin a su buena racha. Cuando salga a la venta el Cybertruck será todo un fenómeno de ventas y de cultura popular. Una vez más, Elon Musk a la cabeza. 23. Personaje del Año: Elon Musk No hay sorpresas aquí. Este año ni siquiera hubo competencia remota para un segundo lugar a ponderar. Este hombre se está consagrando como el Leonardo DaVinci de nuestros tiempos, y todavía le falta mucho por vivir. autor: josé elías |

|

|

|

|

|

sábado, octubre 30, 2021

|

Hola amig@s lectores, Este artículo me lo han solicitado por años, e incluso es el tema que más me han solicitado para escribir, y la verdad es que hasta hoy me había negado a escribirlo de forma concienzuda. Verán, que por motivos que no detallaré aquí, que soy una persona que no le gusta apostar al azar (salvo uno que otro día que juego la lotería cuando viajo a EEUU o gasto US$20 dólares cuando visitó Las Vegas). Son muchas las personas que he visto en mi vida que a causa de las apuestas, el vicio de los juegos y de temas como proyectos piramidales y otras estafas, lo han perdido todo. Y la verdad es que no me gustaría sentirme jamás que he sido responsable de destrozar una familia o una sola vida a causa de mis consejos. Sin embargo, el mundo ha llegado a un punto el día de hoy, debido al auge de las criptomonedas, que millones de personas están apostando a ellas y lamentablemente muchas están perdiendo los ahorros de su vida en ello, sea por inexperiencia, ingenuidad o sencillamente por seguir consejos e invertir en personas sin escrúpulos o que sencillamente no saben lo que hacen. A tal fin, este artículo servirá tanto como una guía como una lista de advertencias básicas para que no caigan en ciertas trampas. Así que sin nada más que decir al respecto, iniciemos… El tema de hoy será el crypto-trading, que no es más que el acto de comprar y vender (o quizás sería más apropiado decir, apostar) al mercado de las criptomonedas, como lo es bitcoin (que por mucho es la más conocida en la actualidad en la cultura popular). Y es bueno mencionar que el crypto-trading en muchos sentidos es bastante similar al simple trading en la bolsa de valores tradicional, pero con algunas diferencias… En el trading tradicional por lo general utilizas un intermediario, pero en el crypto-trading no solo no necesitas intermediarios si no deseas, sino que incluso puedes permanecer anónimo en tus transacciones, lo que significa que si así lo deseas puedes incluso mantenerte al margen del radar del ministerio que regule el fisco en tu país (aunque aclaro, en países como los EEUU está prohibido el no reportar acciones en criptomonedas por temas de impuestos, así que es importante que estés al tanto de las leyes que regulan el mundo de las criptomonedas en tu nación si quieres evitar violentar alguna ley fiscal). Sin embargo, aunque puedes definitivamente hacer tus propias transacciones directamente con otros que deseen comprar tus criptomonedas (o comprar las de ellos), lo cierto es que en la mayoría de los casos los usuarios que particularmente están iniciándose en este mundo optan por elegir alguna plataforma que funciona similar a un mercado de bolsa de valores, en donde unos ponen un precio al cual están dispuesto a vender una criptomoneda y otros están dispuestos (o no) a pagar ese precio. A tal fin entre las plataformas más populares en la actualidad para Cryptotrading están Binance, Coinbase, Kraken, Crypto, Robinhood, y otras. Es bueno aclarar que estas plataformas funcionan por medio de Wallets o Carteras Digitales, y que existen distintos tipos de Wallets, desde unas que alojan tus criptomonedas enteramente en la nube, hasta otras que lo alojan en tu PC o celular. Sin embargo las carteras más seguras alojan tus criptomonedas en equipos de hardware especial que tienen formas que van desde memorias USB hasta tarjetas de crédito que accedes por Bluetooth y que vienen con la particularidad de que generalmente están totalmente desconectados de cualquier red que pueda acceder a su preciado contenido. Y hablando de estas carteras he acá la primera gran advertencia de la cual debes estar al tanto y entender bien: Las criptomonedas son esencialmente una serie de tokens o códigos con los cuales transmites esas monedas a otras personas, y si alguien llega a tener acceso a tu cartera y transfiere ese dinero a cualquier otra cuenta (por lo general anónima), hay un 99.9999% de que vas a perder ese dinero y no tendrás a quien reclamarle en lo absoluto. Y eso se debe a la naturaleza de las criptomonedas que fueron creadas específicamente para evitar la centralización corporativa y el control de gobiernos centrales (aunque ya países como China han creado criptomonedas que sí están bajo control del estado), lo que significa que por un lado tienes la ventaja de que nadie tiene que saber sobre el dinero que tienes o donde lo tienes o incluso a quien le transfieres o quien te transfiere a ti, pero eso también significa (y esta parte rara vez te la dicen los que utilizan carnada para que inviertas en estos mercados) que si alguien algún día llega a tener acceso a tu cartera, que eso es lo mismo que tomar todo el dinero que tengas en el banco y prenderle fuego. Sucede, que al las criptomonedas no ser centralizadas, que por lo general eso significa que *tu* eres el responsable de salvaguardar tus criptomonedas, y por eso es que es tan importante el tomar medidas conscientes sobre cómo proteger esas carteras. En máquinas tradicionales con Windows por ejemplo, o en celulares Android (salvo si tienen versiones especializadas y actualizadas como la tecnología Knox de Samsung y su Samsung Blockchain Keystore), en donde a diario son atacados por miles de malware, el riesgo es altamente alto para el usuario común que le da “ok” a todo lo que ve en Internet o que no mantiene actualizada su máquina o celular constantemente, o que sencillamente descarga programas pirateados, ya que los hackers criminales que se encargan de robar criptomonedas por lo general utilizan debilidades en esos sistemas operativos y en aplicaciones descargadas para monitorear la actividad en tu equipo y observar sus claves y posteriormente blanquear tu cartera antes de que te des cuenta. Y esto es un fenómeno que ocurre con muchísima más frecuencia de lo que se imaginan (o de lo que muchos quieren admitir por temor a pasar vergüenza o admitir que no se llevaron de las advertencias de los expertos). A tal fin, si planean realmente adentrarse en este mercado, lo primero que tienen que asegurarse es de tener un equipo seguro, de mantenerlo actualizado constantemente, de no instalar programas que no sean originales, y de mantener un respaldo de sus datos en caso de que la máquina o celular se pierda, sea robada o se averíe, ya que en esos casos si no tienes respaldo también perderás todo (al menos que utilices una cartera que haga respaldo en la nube). Similarmente, si utilizas una cartera en la nube, debes asegurarte de tener extrema precaución y utilizar una clave difícil de adivinar, así como evitar compartir esa clave con nadie, y de paso debes también evitar escribir esa clave en máquinas de otras personas (que bien pudiesen estar infectadas con programas que monitorean los teclados para robar tus credenciales). De forma similar, si optas por el sistema más seguro de todos, que es el de carteras en hardware externo, debes también tomar medidas ya que si ese dispositivo externo se te pierde o avería o se rompe, perderás para siempre todas las criptomonedas almacenadas en este. Y por último, en muchos casos estas carteras te dan un “token de acceso” y te dicen en letras bien grandes que lo anotes a mano y pongas en un lugar seguro, y lo dicen bastante en serio, pues si pierdes ese token (esencialmente una clave de acceso) nunca jamás en tu vida podrás tener acceso a tus criptomonedas, las perderás para siempre, ya que ese token es lo que quita el candado digital de las criptomonedas almacenadas en la nube o en tu celular. Si pierdes el token ni los mismos creadores de la cartera podrán ayudarte, perdiste ese dinero para siempre. Una buena práctica para aquellos que decidan invertir grandes cantidades de dinero en estro es utilizar varias carteras, dejando la mayor cantidad de dinero en carteras de hardware en distintos lugares diferentes para evitar que si alguien algún día tiene acceso a una de esas carteras que solo pierdas lo que contiene esa cartera y no todo lo demás. He leído incluso de usuarios que viajan físicamente a distintos lugares del mundo y depositan sus carteras en bancos externos o las esconden en lugares específicos para evitar así casos extremos como cierre de bancos locales, incendios en sus hogares, revuelos contra el gobierno, etc. Ahora bien, ¿por qué con tantos peligros la gente está viendo a las criptomonedas como la nueva fiebre del oro? Pues la respuesta sencilla es por novedad y volatilidad. Con novedad me refiero a que el mercado, aun con tanta actividad a escala global, está en su infancia, y millones de personas están invirtiendo en estas criptomonedas sin incluso entender bien qué hacen, quién las genera, cómo se generan, si tendrán futuro, o incluso si tiene sentido invertir en ellas. La gente invierte en ellas porque todos los demás lo están haciendo. Así que a diario vemos cientos de miles de personas invirtiendo en criptomonedas que poco después se devalúan y pierden todo lo invertido, beneficiando a los que vendieron sus monedas inicialmente. Pero, ¿y por qué la gente continúa invirtiendo? Pues por el otro factor que mencioné: Volatilidad. El mercado de las criptomonedas es tan volátil en la actualidad (es decir, los precios varían tanto de día a día) que eso ha abierto una brecha increíblemente grande a la especulación. Así como tradicionalmente existe un mercado que especula en que el precio del dólar sube o baje, y compra o vende acorde, así mismo lo que está inyectando capital en la economía del cryptotrading es la especulación. La moda ahora es esencialmente tomar una moneda que sea popular y que varíe de precio constantemente (el ejemplo clásico es el bitcoin) y comprar cuando baja de precio con el propósito de vender cuando el precio suba al otro día o a los pocos días después y lograr un margen de ganancia. Obviamente que así como el dinero no crece en árboles es bueno entender que los expertos en cryptotrading que hacen dinero con estas tácticas hacen dinero a consta de otros pierden. Por cada persona que en el mundo de las criptomonedas está haciendo dinero hay otros que lo están perdiendo, por lo que el mundo del cryptotrading realmente es un mundo sobre quién es más vivo que quien, quién tiene más conocimiento que quien, quién tiene más suerte que quien, y quién se puede aprovechar mejor de quien. Y sobre eso último les quiero dar mi segunda advertencia: Si alguien se les acerca y les dice que si inviertes tu dinero en criptomonedas que te pueden “garantizar” un porcentaje X de ganancia cada X tiempo, sal corriendo, aléjate lo más posible de esa persona, bloquea su contacto, y date tres golpes en el pecho y da gracias a todos los cielos de que evitaste caer en una trampa. Quien sea que te prometa algo así cae en solo una de estas dos categorías: Es alguien que definitivamente te quiere engañar y te está vendiendo sueños. Es alguien que no tiene ganas de engañarte pero ha tenido suerte en sus transacciones y cree que ya sabe lo que está haciendo hasta que le llegue la mala racha (generalmente con tu dinero) Ahora bien, ¿existen cryptotraders serios? Pues por supuesto que sí, aquellos que te dirán todas las advertencias que les estoy dando yo aquí, que te explicarán los riesgos, y que tratarán de que no tomes un préstamo con hipoteca de tu casa para invertirlo todo de una vez (y no, no me pregunten si les puedo ayudar a invertir, no me dedico a eso). Y acá ahora les quiero dar la tercera advertencia: Es casi seguro que se toparán en algún momento con alguien que les dirá algo similar a “Invertí en criptomoneda X y me gané tantos miles de dólares”, cosa que te dejará pensando en “¡yo también quiero ser como tú y ganarme esos miles de dólares!”, y he ahí el gran error. La mayoría de esos que te dicen eso confunden el que el precio de sus acciones haya subido un día con el haber ganado dinero, sin embargo tu no ganas un solo centavo hasta el día que vendas tus criptomonedas y conviertas ese dinero en efectivo (léase, dólares o alguna moneda tradicional, al menos hasta el día en que las criptomonedas en sí se puedan parar sobre sus propios hombros). Esa misma persona que te dice que hoy “ganó” US$10,000 dólares muy posiblemente al otro día “perdió” US$12,000 dólares. En el mundo de las finanzas el único dinero seguro es dinero el liquidéz, depositado en efectivo en alguna cuenta o en tus propias manos, no se olviden de eso. Y esto es algo que pasa con las bolsas de valores tradicionales también: Alguien invierte US$100 dólares en alguna empresa, las acciones suben de precio y ahora sus acciones valen US$300, y la persona le anuncia a todos sus amigos que “acaba de ganarse US$200 dólares”, pero al otro día se desploman las acciones (o incluso quiebra la empresa) y las acciones bajan a US$5 dólares, y la persona vende sus acciones a US$5 antes de perderlo todo quedándose con una pérdida de US$95 dólares, sin embargo pueden estar seguros que esta persona no va a correr a decirle a sus amigos de su fracaso. La gente por lo general solo mercadea los triunfos, y eso que pasa con la bolsa de valores tradicional ocurre tal cual con el cryptotrading, por lo que no crean todas esas historias de “¡hice tantos miles de dólares en un día!”, cuando la realidad es que en la mayoría de casos los que invierten en criptomonedas pierden dinero si no saben lo que están haciendo. Pero, ¿cómo hacer dinero en el mercado con cryptotrading? Pues hay tres formas: Con trabajo arduo todo el tiempo, comprando y vendiendo sin parar y durmiendo pocas horas al día. Con mucho conocimiento de los mercados de las criptomonedas y entendiendo realmente lo que se mueve, cuáles son las tendencias, etc. Con suerte. En el primer punto, la idea es aparentemente sencilla: Observas los mercados de las criptomonedas que tienes en tu mira objetivo, y compras cuando bajan los precios y vendes cuando suban de precio. El problema aquí es que en la práctica debes estar atento constantemente al movimiento de los mercados, y si no sabes cuándo salirte definitivamente es posible que termines con una criptomoneda que al final no tendrá valor alguno y terminarás perdiendo todo lo invertido en esa criptomoneda. Con el segundo punto prepárate a invertir *mucho* tiempo leyendo, analizando, buscando noticias, viendo la opinión de expertos, descartando exageraciones, detectando los líderes del mercado, etc, y en base a eso haciendo tus inversiones. Si le dedicas tiempo y realmente entiendes el mercado, quizás puedas detectar alguna criptomoneda que crecerán, y otras que tendrán mucha volatilidad y tomar ventaja de ellas. Así quizás inviertas en una que otra para el largo plazo. Y en cuanto al tercer punto, el depender de la suerte, solo digamos que no recomiendo esa ruta al menos que tengas dinero para quemar (en cuyo caso quizás no tengas incentivo para invertir en criptomonedas…). Ahora bien, ¿en cuáles criptomonedas invertir? Pues esa es una tarea para ustedes, sin embargo si la quieren jugar a lo seguro por ahora lo más “seguro” (y eso es un término muy relativo en este mercado) es la venerable bitcoin. Y si quieren apostar a algo que podría ser bastante grande en el futuro, quizás quieran estudiar a Ethereum, que es la segunda criptomoneda en importancia y la que para mi ofrece un mejor valor a largo plazo, ya que aparte de ser una criptomoneda es también toda una plataforma programable que está permitiendo toda una nueva generación de aplicaciones (como los NFT de los cuales les hablé recientemente). En el otro extremo hay toda una familia de criptomonedas que realmente nadie sabe si tendrán futuro o no pero que son extremadamente volátil y con ellas pueden jugar el juego de comprar y vender y cruzar los dedos para no estar ahí invirtiendo en ellas el día que posiblemente se desplomen. Entre ellas están Dogecoin (popularizada por varios tweets de Elon Musk), Shiba, Litecoin, y otras. Personalmente mi mayor preocupación actual (y tomen esto como una “predicción eliax”) es el hecho de que están surgiendo decenas de nuevas criptomonedas continuamente, y el sentido común nos dice que será insostenible y que eventualmente habrá que “menear el árbol” para que solo caigan las frutas maduras (es decir, hasta que solo queden las criptomonedas principales, en el orden de 5 a 10 como mucho). Creo que tarde o temprano llegaremos a una gran burbuja en donde la gran mayoría de esas criptomonedas explotarán (y de mala forma) y se perderá mucho dinero cuando eso ocurra, a nivel tal que podría afectar la economía no solo del núcleo familiar, sino de todo el planeta. Incluso no lo llamaría una burbuja, más bien podría ser una supernova económica. ¿Y cuándo ocurrirá esa explosión? Pues en el momento que un suficiente porcentaje de la población entienda qué son realmente las criptomonedas, y qué uso y valor real tienen más allá de una simple apuesta (por eso me gusta tanto Ethereum, pues fue creada con miras a ser toda una plataforma financiera descentralizada con aplicaciones prácticas en la vida real). Habiendo dicho todo eso, y sabiendo que diga lo que sea que yo diga muchos continuarán y entrarán con los dos pies a este mercado, he aquí unas cuantas recomendaciones que les hago para cuando menos tratar de reducir los riesgos e incrementar las posibilidades de éxito: 1. No inviertan todo su dinero en criptomonedas. Por más tentador que suenen las historias de los que se hicieron millonarios haciendo eso de la noche a la mañana después de obtener préstamos y vender todo lo que tenían para invertirlo en criptomonedas, esas son historias de una en un millón. Sean prudentes. 2. Si van a invertir en criptomonedas no lo inviertan todo en criptomonedas de poca circulación, o en criptomonedas poco populares. Ciertamente si “la pegan” en una de estas comprando super barato y después vendiendo super caro eso sería genial, pero esa es la excepción (por mucho) y no la regla, por lo que procedan con precaución. 3. Traten de balancear su portafolio invirtiendo una parte en monedas relativamente estables (como bitcoin y Ethereum), y otra parte en criptomonedas que crean tendrán futuro o que tienen alta volatilidad (si es que están dispuestos a invertir el tiempo en comprar y vender constantemente). 4. Muchas monedas menos populares (o nuevas) cuestan literalmente milésimas de un dólar cada una. En estas podrías invertir una pequeña cantidad de dinero ya que si despegan es posible que una inversión de US$10 dólares termine valiendo hasta US$10,000 unos meses o años después si esta por alguna razón explota positivamente en valor (como ocurrió con Dogecoin, antes de desplomarse su valor). Sin embargo hagan estas pequeñas inversiones a sabiendas que lo más probable es que perderán esos US$10 dólares. Piensen de estas pequeñas inversiones como una lotería a modo de hobby. Si la pegas bien, sino, solo perdiste US$10. 5. Antes de hacer transacciones infórmense sobre los costos de transacción (si utilizan intermediarios). No haces nada comprando y vendiendo pequeñas cantidades si los costos operativos son mayores a las potenciales ganancias del día. 6. Hablen con amigos que ya estén invirtiendo en criptomonedas ya que ellos les asesorarán sobre carteras digitales y sobre cuáles mercados de compra y venta de criptomonedas funcionan en sus respectivos países (no todas las carteras funcionan en todos los países y muchas requieren identificación en forma de documentos de identidad oficiales). 7. Hay cientos de tutoriales, guías, preguntas frecuentes, grupos de Facebook, páginas de Instagram, portales de noticias, cuentas de Twitter, grupos de Whatsapp y Telegram, videos de YouTube, e innumerables recursos sobre estos temas. Google es el mejor amigo que tendrán para encontrar esos recursos, así como otros amigos en sus comunidades. Esto no es algo con lo que se harán ricos sin esfuerzo, como cualquier otra cosa deben invertir tiempo y recursos para ver los beneficios. Quien les diga que esto es “fácil” es alguien que o no sabe de lo que habla o está exagerando para animarlos a entrar a este mundo sin estar bien preparados. 8. Reitero, por sobre todas las cosas, procedan con precaución. Esto es sin duda un mundo emocionante y estamos viviendo unos tiempos en donde abundan muchas oportunidades, pero a la misma vez los riesgos y aquellos que quieren aprovecharse de ustedes, abundan. Ejerzan moderación. Y si les gustó este artículo compártanlo con aquellas otras Mentes Curiosas de este mundo... autor: josé elías |

|

|

|

|

|

domingo, julio 4, 2021

|

Hola amig@s lectores, Hola amig@s lectores,Microsoft está en un renacimiento. Hace 7 años (en el 2014) la empresa tomó una decisión bastante importante al elegir a Satya Nadella como su nuevo CEO, y ese mismo día escribí un artículo con mi opinión al respecto (que recomiendo leer para poner en contexto lo que escribo hoy), expresando lo que creía debería hacer ese hombre si quería sacar a Microsoft del agujero negro que la había metido Steve Ballmer, y curiosamente Nadella se enfocó en precisamente las cosas que sugerí debía enfocarse, poniendo atención al sector empresarial (miren el éxito de Azure en la nube), eliminando cientos de productos (lo cual hizo), hacer Windows gratis (que lo acaba de hacer en el anuncio de Windows 11 hace unos días), y concentrarse también en el mercado de consumidores (que es su nueva lanza y de la cual les voy a hablar hoy). Si se leyeron el artículo que sugerí en el párrafo anterior ya entenderán que Microsoft ha estado pasando por unos momentos muy transformadores en la última década, y si hay algo que puedo decir para resumir los últimos 7 años de Microsoft bajo la tutela de Nadella, es que se ha ganado una calificación de “A” en ejecución. Estoy seguro que muchos hubiesen querido ver el recién anunciado Windows 11 varios años antes, y ver el Microsoft que tenemos hoy (que incluso ha abrazado la cultura de Linux bajo su organización, algo que hubiese sido inaudito bajo Ballmer o Bill Gates) mucho tiempo atrás, pero hay que entender también la titánica labor que tenía Nadella bajo su liderazgo: Primero tenía que desmontar toda la burocracia impuesta por Ballmer dentro de la organización, enemistarse de cientos de Project Managers, ganarse la confianza de los desarrolladores internos, y mientras hacía malabarismo con esas tareas de paso trazar el rumbo futuro de Microsoft, eficientizar la empresa, y desarrollar una nueva generación de productos y apostar a la Nube, los video-juegos, y de vuelta al sector de consumidores. Para mi a Nadella no le están dando el debido crédito de lo que ha logrado en tan relativo poco tiempo. Literalmente se ha ganado mi admiración. Sin embargo, y desafortunadamente para Microsoft, la vida fuera de sus paredes corporativas continuó, y empresas como Google, Amazon y Apple se adelantaron en todas las áreas que Microsoft tenía debilidades, o que desantendíó. Hoy día Amazon AWS es el líder indiscutible en soluciones en la nube (aunque gracias a Nadella, Microsoft Azure ya es un número 2 creciendo vertiginosamente), Google Docs le ha comido gran parte del mercado a Microsoft Office, GMail Corporativo le ha comido gran parte del negocio a Microsoft Exchange y Outlook, Internet Explorer fue aplastado por Google Chrome, MySQL ha estado comiendo sin piedad el mercado de Microsoft SQL Server, Android y iOS completamente desterraron a Windows Mobile, y la Web junto a el iPad y macOS han estado haciendo a Windows (en un momento, la principal fuente de ingresos de Microsoft) en algo cada vez menos relevante. En esencia, Microsoft, que una vez era el epicentro del mundo tecnológico, cada vez está siendo desterrada más y más a los brazos exteriores de la galaxia tecnológica terrestre. Sin embargo, se ha hecho obvio que Nadella ha estado viendo hacia dónde soplan los vientos y esto lo ha hecho notar con varias decisiones que están ya tomando efecto exitosamente en el mercado. La empresa por ejemplo ha puesto un renovado interés en la versión online de Office 365, ha tomado un gran interés en Microsoft Teams (al punto tal que vendrá integrado por defecto en Windows 11), le da dado su corazón por completo a la plataforma de juegos Xbox (innovando con cosas como el GamePass), ha hecho de Azure su punto de lanza para el sector corporativo y de desarrolladores de software grandes y pequeños, se ha abierto a colaborar con soluciones de Linux, y ahora con Windows 11 está haciendo algo que muchos aun no han notado pero que sin duda es la razón principal de la existencia de Windows 11: Un ataque frontal al iPad, y por tanto a Apple. ¿Y por qué me refiero al iPad y no al iPhone o macOS en las Macs? Pues porque se ha hecho evidente que el futuro de la computación personal fuera de celulares inteligentes son las tabletas, o más específicamente, dispositivos compactos de fácil uso, gestionados mayoritariamente a través de tiendas de aplicaciones, con larga duración de batería, y con interfaces amigables y simples (y con la opción de convertirse en PCs o laptops por medio de teclados externos, monitores, ratones, etc). Apple no planea dejar por ahora el negocio de las Macs (y al contrario, ha apostado el doble a ese segmento con sus Macs M1 y próximas sucesoras), sin embargo a la empresa se la ha hecho evidente que en el sector de consumidores el futuro son dispositivos más parecidos en funcionalidad a un iPad que a una Mac, razón por la cual si son usuarios tanto de iPads como Macs ya habrán notado que las últimas tres versiones de macOS cada vez se acercan más a parecerse un interfaz de iPad, y estamos llegando a un punto tal en donde desde el punto del vista del consumidor final el iPadOS y el macOS serán casi la misma cosa. Es por eso que ya el iPad (particularmente el iPad Pro con el teclado y trackpad y soporte para monitores externos y ratones) ya están empezando a hacer funciones tradicionalmente de las Macs, e incluso ya hay cosas en las iPads en lo que son enormemente mejores (por ejemplo, el programa de dibujo Procreate con el Apple Pencil, que ya ha desterrado casi por completo a Photoshop en varios nichos). Y no duden que poco a poco veremos cada vez más y más aplicaciones “Pro” salir en simultáneo para iPad y Mac, y en particular gracias a que ya Apple ha entregado a desarrolladores una serie de herramientas que les permite hacer aplicaciones que funcionan en ambos ambientes. Así que habiendo dicho eso, podemos decir que el principal nuevo enemigo de Microsoft en el ámbito de computación personal (fuera de celulares) no es la Mac ni el iPhone, sino que el iPad. El iPad ha dominado tanto que incluso las tabletas Android son casi irrelevantes en ese mercado. La mayoría de tabletas Android (o Kindle de Amazon) que se venden se compran por su bajo costo y para labores usualmente específicas (para que los niños jueguen, o para leer, o para ver videos, y el ocasional uso de Google Drive o navegar el internet), y muy rara vez para labores profesionales o de uso continuo con aplicaciones equivalentes a una laptop. Y la razón es la calidad de las Apps. Desde el día 1 Apple diferenció el iPad del iPhone y creó una forma diferente de crear Apps optimizadas para el tamaño mayor de pantallas. Sin embargo en el mundo Android eso ha sido un reto ya que la mayoría de Apps en tabletas Android no son más que versiones ampliadas de la misma App en el celular, y la realidad es que son desastrosas en la mayoría de los casos, particularmente al compararlas con sus equivalentes en iPad. Sin embargo, es ahí donde entra Microsoft con Windows 11… Para mi el cambio más importante que ha dado Windows con la nueva versión es que por fin aparenta que será optimizado para tabletas (y sí, estoy súper consciente y he utilizado las Surface de Microsoft), y al Windows 11 soportar la arquitectura ARM para procesadores de eficiente consumo energético y menor costo, y al Microsoft hacer ahora mucho más fácil colocar aplicaciones en la mejorada tienda que estrenará con Windows 11 (y de paso permitiendo que se cobren productos y servicios por vías alternativas, a diferencia de Apple y Google que requieren que los pagos se realicen a través de sus propias pasarelas de pago), creo que esto hará por fin que una nueva generación de tabletas con Windows 11 salga al mercado, con precios bastante competitivos, ofreciendo la primera real alternativa al iPad en el mercado. Recordemos que hoy día muchos prefieren pagar entre 2 y 5 veces más por un iPad que una tableta Android debido a que las aplicaciones que utilizan y la experiencia de usuario que obtienen con el iPad son marcadamente superior a una tableta Android, pero si un usuario puede obtener aplicaciones de alta calidad, con elementos visuales optimizados realmente para tabletas, y en equipos de relativo bajo costo, creo que eso podría ser una fórmula ganadora para aflojar un poco el control de Apple en ese espacio. Y lo mejor de todo (para Microsoft) es que diseñó a Windows 11 con un núcleo que se puede adaptar a distintos factores de uso, por lo que no me sorprendería en un futuro ver un dispositivo “Microsoft TV Stick” similar al Amazon Fire TV, o interfaces para automóviles y casas inteligentes con tecnología de Microsoft. Y más intrigante aun, es que si Microsoft logra ejecutar bien y logra capturar una buena parte del mercado de tabletas, que podría quizás considerar volver entrar al mercado de celulares inteligentes con una nueva versión de celulares basados en futuras versiones de Windows, aunque algo me dice que por ahora eso es solo eso, una intrigante posibilidad y no el enfoque inicial de Microsoft con Windows 11. Otra cosa que aplaudo de Microsoft es haber tomado la sabia decisión de ofrecer a Windows 11 como una actualización gratuita para usuarios existentes de Windows 10 (un práctica que Apple lleva desde hace muchos años exitosamente), para así acelerar la adopción de su nueva estrategia, pues el nuevo Microsoft no es una empresa para ganar dinero vendiendo licencias de Windows sino vendiendo servicios (locales y en la nube), subscripciones, y obteniendo comisiones de ventas desde sus tiendas. Y finalizo diciendo algo que repito constantemente en mis artículos, comentarios y charlas: Estos tipos de desarrollos no solo son emocionantes sino que beneficiosos para todos, pues la competencia al final del día es una herramienta más para mejorar la vida de los consumidores. autor: josé elías |

|

|

|

|

|

domingo, marzo 14, 2021

|

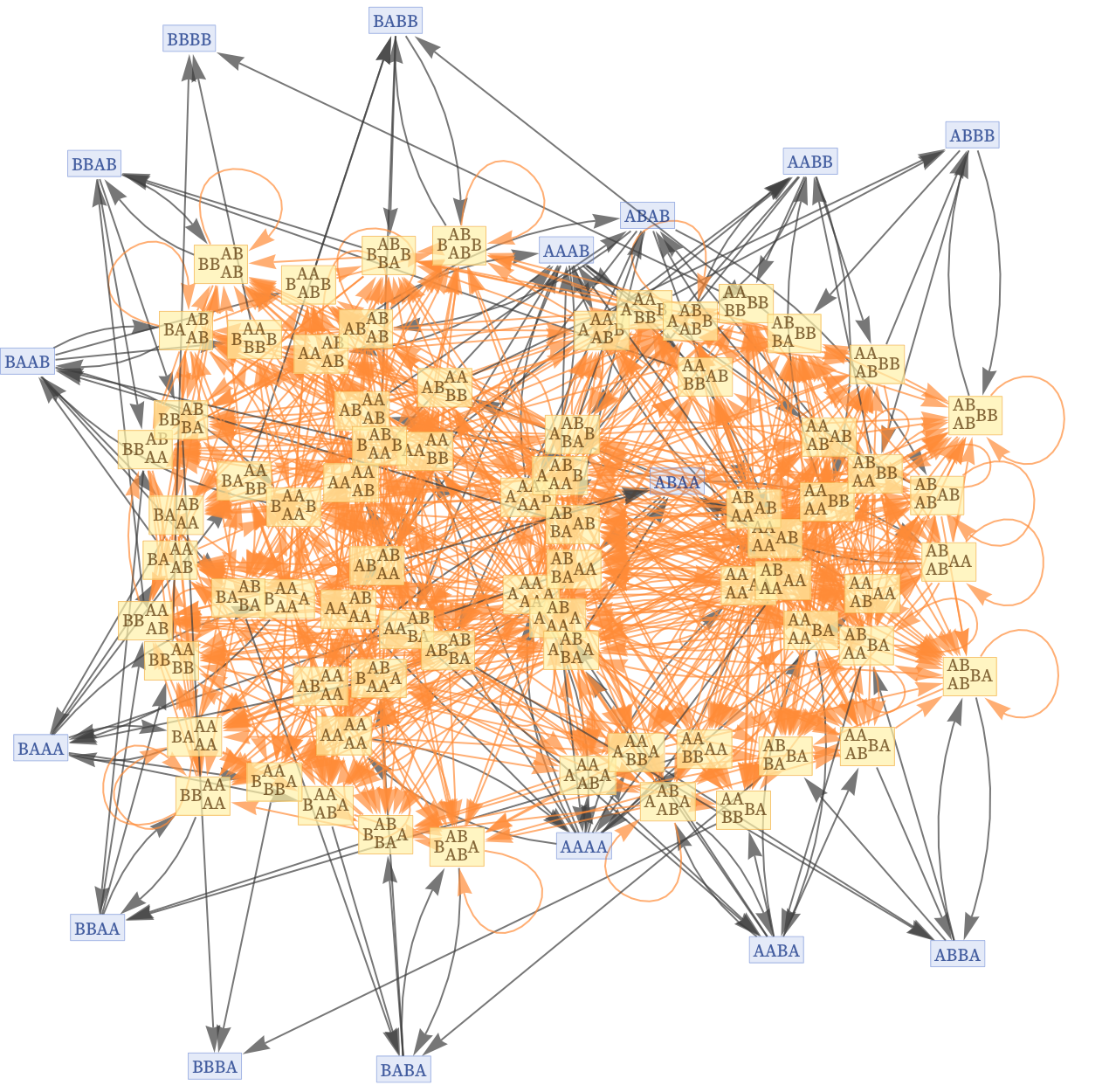

Hola amig@s lectores, Hola amig@s lectores,Hace unos días una obra de arte se vendió en US$69 Millones de dólares en la prestigiosa casa de subastas Christie’s, pero lo interesante de esa venta no fue el precio, sino el hecho de que lo que se vendió fue una obra de arte digital, de la cual cualquiera puede obtener una copia 100% exacta pixel-por-pixel y tenerla en su celular, tableta, laptop o incluso impresa. Así que viene la pregunta, ¿por qué alguien pagaría tanto dinero por algo tan fácilmente reproducible (a diferencia de por ejemplo un cuadro de Picasso en donde solo tú tienes “el original”)? Pues bienvenidos al nuevo mundo de los NFTs... Una nueva revolución tecnológica en el tema de la propiedad intelectual y la sociedad en general. Pero iniciemos con lo básico. NFT es un acrónimo en inglés que significa “Non-Fungible Token”, y ya de por sí resulta curiosa la definición. La palabra “fungible” es de uso muy infrecuente en español (e inglés), y en esencia se refiere a algo que se puede reemplazar por algo de lo mismo. Un ejemplo es una moneda de 1 peso. Si la intercambias por otra moneda de 1 peso continúas teniendo un peso. Sin embargo, si lo que tienes es (por ejemplo) una pintura de Picasso, no la puedes cambiar por otra pintura de Picasso y terminar con lo mismo, ya que son irremplazables, o no-fungibles. Así que en el mundo de los NFT no-fungible significa que el Token que obtienes (y que avala que eres el propietario) no es genérico y reemplazable, sino que es único y solo existe uno, similar a como existe una sola pintura en particular de Picasso sin otras copias exactas o que puedan intercambiarse. Y para continuar tenemos que hacer un breve paréntesis y explicar que los NFTs están ligados intrínsecamente a la misma tecnología que hace posible las criptomonedas, una tecnología llamada Blockchain (“Cadena de Bloques”). O en otras palabras, la misma tecnología que permite la creación y uso de algo como los bitcoins, es la que se utiliza en los NFTs. ¿Y qué es un Blockchain? En esencia es una técnica que permite agrupar una secuencia de datos en el tiempo de forma tal que matemáticamente es virtualmente imposible modificar cualquier elemento de la cadena para falsificarlo, removerlo o modificarlo, algo que se logra con una herramienta matemática llamada un “hash”, que no es más que una función uni-direccional en donde un bloque de datos puede generar un código (piensen de ello como una clave, pero pública) pero de ese código no se puede volver atrás para obtener los datos desde donde surgió (no se preocupen si no entienden bien esto, no es necesario para entender el tema de hoy). Así que con un Blockchain por ejemplo sería posible decir algo como “Hoy lunes Fulanito de Tal compró US$10 dólares en bitcoins”, y al otro día decir “Y hoy martes transfirió US$2 de esos bitcoins a Fulanita de Tal”, y así sucesivamente en transacciones posteriores, con la gran salvedad que aunque Fulanito tenga acceso total a su base de datos de Blockchain y trate de engañar al sistema borrando la transacción del martes, que no podrá hacerlo por más que intente, debido a que por su naturaleza los Blockchains funcionan de forma distribuida por lo que miles (o millones) de otras personas tienen también una copia de esas transacciones, por lo que Fulanito tendría que no solo hackear la base de datos de todo el planeta Tierra que aloje ese Blockchain (o al menos, la mitad de ellas más una), sino además reconstruir matemáticamente todos los hashes de esas transacciones desde el momento que él quiere hacer trampa hasta el día de hoy (algo que les aseguro no es trivial hacer, y se los dice alguien que entiende bien este tema de los hash, criptografía, etc). Habiendo dicho todo eso, hagamos una aclaración final: En el mundo de los Blockchains hay dos grandes tipos de transacciones que pueden ocurrir, (1) transacciones monetarias o de criptomonedas como son los bitcoins, o (2) transacciones sobre evidencias de que algo ocurrió, o como se les llama en la jerga de la industria, criptotokes, o simplemente Tokens (que en el caso de los NFTs ocurren por ahora en la plataforma Ethereum). De esos Tokens es que estamos hablando cuando nos referimos a los NFTs, y ejemplos de estos son documentos notarizados, títulos de propiedad, actas de nacimiento, pasaportes, etc. En el contexto de los NFT, por Token nos referimos entonces explícitamente a una evidencia digital de que algo te pertenece a ti. Y aquí es bueno hacer una curiosa observación: Mientras que las criptomonedas se basan en algo que es fungible (pues estas se consumen con su uso) y de uso anónimo (en la red bitcoin por ejemplo, nadie en teoría sabe en qué gastas tu dinero ni en dónde ni con quien), en el mundo de los criptotokens es todo lo contrario, en donde la idea es saber quien es el dueño de qué (por lo que es no-anónimo) y de paso es no-fungible (ya que no puedes “gastar” un contrato por más que le des uso). Así que regresando del paréntesis, vamos ahora armados con esa información a describir qué es un NFT, y por qué alguien pagó US$69M por una pintura digital... Un NFT es esencialmente una evidencia digital de que tú eres el propietario de algo, pero ojo, un NFT no necesariamente te da derechos de propiedad de la obra intelectual original, aunque es una opción. Una analogía es una pintura de Salvador Dalí. Este en vida hizo varias serigrafías (copias de alta calidad) de sus obras que firmaba con su propia mano de forma individual. Así que por ejemplo Dalí pudo haber hecho 100 copias en serigrafía de su obra “La Persistencia de la Memoria”, y firmado cada una de ellas a mano con una numeración del 1 al 100. Aunque estas no eran la obra original, hoy día valdrían mucho dinero ya que estarían firmadas por el mismo Dalí. Es un producto escaso y limitado que naturalmente incrementa el valor del artículo en cuestión. Similarmente, puedes hacer un NFT de una novela que acabas de escribir, y hacer 10 copias “especiales” de ellas en formato NFT que creas y vendes a través de un portal como opensea.io. Los que compren esas 10 copias saben que tienen una versión exclusiva que nadie más tiene, y que de paso tiene el nombre de ellos asociados a la obra para la eternidad en el Blockchain. Y no solo eso, sino que si tienes una de esas 10 copias, esa copia tiene un valor volátil basado en el mercado, y puedes traspasar ese NFT a otra persona vendiéndosela, y al hacerlo, esa transacción queda registrada en el Blockchain de manera irrefutable, y se tiene un histórico en todo momento sobre quien es el propietario de ese NFT. Y claro está, que (siguiendo la analogía con Dalí), quizás quieras vender el cuadro original junto con los derechos de su explotación comercial, en cuyo caso también puedes hacerlo con un NFT creando una sola copia y dotando a su comprador de todos los derechos (que como podrán imaginar, tiene un valor mucho más alto). Eso fue lo que hizo el artista denominado “Beeple” al vender su obra titulada “Los Primeros 5,000 días” en donde hizo un compuesto de 5,000 obras que hizo durante 5,000 días consecutivos, y cuyo precio inició en subasta en US$100 dólares y terminó en US$69 Millones de dólares. Muchos dirán que esto es una estupidez, ya que si es una obra digital cualquiera puede copiarla y tener una copia exacta para admirar en su casa impresa y puesta en un cuadro en la pared, pero la idea es que el comprador de ese NFT ahora no solo tiene derechos sobre la obra original sino que de paso puede decir que aunque millones de otras personas tienen “copias” que él o ella es la única persona que tiene derecho sobre un “original” (y su explotación comercial, pues algo interesante de los NFTs es que opcionalmente puedes recibir comisiones por su posterior venta, en esencia continuando recibiendo un ingreso mientras más uso le den al NFT). Esto es medio chocante ya que tradicionalmente uno piensa de un “original” como algo tangible (como un cuadro de Dalí colgado en un museo), y no como un simple algoritmo que diga que entre mil trillones de copias solo al de Fulanito de Tal es la original y que solo Fulanito de Tal puede explotar los derechos de esa obra (para vender t-shirts, hacer murales, trabajos derivados, etc). O en otras palabras, e independientemente de lo que alocado o no que le parezca esto a algunos, la gran revolución de los NFTs es que por fin dota a obras que son netamente virtuales/digitales de un mecanismo por el cual sus creadores (o futuros propietarios) puedan alegar derecho sobre la obra y explotarla de forma fácil y segura. Noten que un problema actual (antes de llegar los NFTs) que tenían muchos artistas digitales es que sus obras eran fácilmente copiadas en Internet, y se hacía bastante difícil comprobar quién es el original autor y propietario de la obra, cosa que ahora se hará trivial hacer ya que en el momento de un artista hacer una nueva obra, lo primero que podría hacer es crear un NFT de esta para que exista una evidencia en el tiempo de que él o ella es el original autor de la obra, y de paso utilizar este mecanismo para hacer trivial el poder venderla en mercados en línea. Es bueno notar que ya se ha formado una industria millonaria alrededor de los NFTs, y no solo con arte visual, sino con todo tipo de creaciones que puedan imaginar, desde canciones y novelas, hasta fotos de memorabilia o videos deportivos de la NBA. Incluso, ya hay video-juegos en donde puedes obtener objetos virtuales dentro del juego que solo controlas tú al comprarlos como un NFT (es decir, ni los creadores del mismo juego tienen derecho al objeto después que lo adquieres). Habiendo dicho todo eso, la pregunta ahora es, ¿Es esto una moda pasajera o algo con perspectiva de largo plazo?, y mi respuesta a eso es que creo será la nueva norma hacia el futuro. Hace tiempo que hacía falta una solución al tema de la propiedad intelectual en el mundo virtual/digital, y los NFTs caen como anillo al dedo como solución a ese problema, y de paso esto es bueno notar que pone de cabeza abajo la tradición de que cuanto tenías un objeto valioso lo que lo hacía valioso es que tenías el original, mientras que ahora todos pueden tener una copia exacta del original y lo que lo hace valioso es el NFT que avala que tú y solo tú eres el propietario de esa creación. Quiero finalizar este artículo con una preocupación (y así vemos el otro lado de la moneda): Aunque los NFTs son una excelente idea, hay un tema con su implementación actual y es que consumen una gran cantidad de energía (fuente) para su creación y verificación (similar al problema que tienen los bitcoins con su uso de energía actual en el minado), lo que significa que si se popularizan los NFTs (y todo apunta a que así será) que estamos dirigiéndonos a un futuro en donde tendremos una carga significativa de energía que podría traer serios problemas al medio ambiente terrestre. Solo esperemos que antes de que esto sea un gran problema que ya tengamos fuentes de energía renovables que puedan lidiar con la carga adicional... Nota: Si les gustan estos temas les recomiendo seguir el canal oficial de eliax en Telegram, o si desean interactuar conmigo y la comunidad eliax en general, consideren también unirse al grupo oficial en Telegram Actualización: Por si se interesan, he aquí el primer NFT creado por mí, y a la venta por si alguien se interesa (esto fue un experimento más que otra cosa, pero si quisieran tener una pedacito de eliax, aquí está). autor: josé elías |

|

|

|

|

|

sábado, noviembre 14, 2020

|