Cámaras Digitales

|

miércoles, septiembre 4, 2024

|

Hola amig@s lectores, Hola amig@s lectores, Si les dijera que este artículo completo fue escrito por una Inteligencia Artificial (IA), ¿me lo crearían? Hace apenas dos años atrás quizás no, pero con la llegada de una nueva generación de IAs del tipo LLM (Large Language Model) como ChatGPT es posible que muchos de ustedes no sepan qué responderme. Y eso, es un problema. Aunque por un lado estamos adentrándonos en uno de los más emocionantes (sino, el más emocionante) momentos de la humanidad, a la misma vez esto trae consigo un nuevo tipo de problemas, problemas que aunque no son totalmente nuevos (me refiero a la capacidad de hacer creer que algo ficticio es real) sí podemos decir que amplifica de forma exponencial esos problemas anteriores. Como ejemplo, el año pasado se hizo viral una imagen del Papa Francisco aparentemente modelando un abrigo de nieve en una pasarela, y poco después se hizo viral otra imagen de Elon Musk aparentemente enamorado de una mujer cibernética, y recientemente hemos visto personas como Donald Trump utilizar tecnología deep fake e imágenes de famosos creadas enteramente por software para hacer aparentar que esas personalidades apoyan su segunda candidatura presidencial en los EEUU. Pero eso apenas es el comienzo… Nos estamos adentrando a un mundo en donde no vamos poder estar seguros de nada de lo que leemos, vemos o escuchamos, y esto tendrá graves repercusiones sociales de forma masiva, al menos que tomemos medidas al respecto (medidas que sugiero más adelante en este mismo artículo). Imaginen por ejemplo si llega un reclamo a una empresa de seguros, con no solo evidencia de audio de una llamada telefónica pidiendo auxilio, sino además fotografías desde múltiples ángulos del accidente reportado, y hasta video de una cámara de seguridad cercana a los hechos. Hasta hace par de años esta evidencia se hubiese considerado prueba contundente de que el supuesto accidente reclamado realmente sucedió, y la empresa aseguradora hubiese sido obligada a pagar potencialmente millones en daños. Pero, hoy día, ¿cómo podemos estar seguros de que esa llamada telefónica, esas fotos y ese video no fueron generados por las más recientes versiones de programas como Midjourney o Sora de OpenAI? Similarmente, si recibes una llamada de emergencia de un familiar cercano, y la voz es idéntica a esa persona, e incluye incluso el tipo de lenguaje que utilizaría, con las mismas expresiones que caracteriza a esa persona, ¿enviarías algo dinero de ayuda a esa persona para sacarla de un apuro? Si la pregunta anterior les intrigó, noten el caso de un ejecutivo de una empresa multinacional con sede en Corea del Sur, a quienes unos hackers estafaron US$25 Millones de dólares al convencer a alguien en la empresa para que transfiriera esa cantidad de dinero. ¿Y cómo lo lograron? Pues convocaron a una víctima en el departamento de finanzas (que teníala capacidad de hacer transferencias bancarias) a una reunión virtual con el supuesto General General de Finanzas y varios otros ejecutivos de alto nivel de la empresa para discutir un asunto urgente, y sucede que todos los “ejecutivos” de la reunión habían sido personificados con tecnología deep fake para crear avatars/clones de ellos que se veían, hablaban y comportaban como los seres humanos que reemplazaban. Es decir, en esa llamada de videoconferencia grupal, la única persona real era la víctima, y todos los demás integrantes que participaron en la videollamada eran clones digitales de sus otros compañeros de trabajo y superiores de la empresa. Estos avances en Inteligencia Artificial Generativa (IA que genera desde cero cualquier tipo de contenido que puedas imaginar) están proveyendo a una nueva generación de criminales digitales un nuevo conjunto de herramientas para engañar, estafar, atacar, sabotear, sobornar y robar a una escala hasta hace poco inimaginable. Estamos literalmente entrando a un umbral en donde se está haciendo extremadamente difícil (por no decir casi imposible) distinguir lo real de lo falso. Y el gran problema que eso trae es que la sociedad humana desde sus orígenes se mantiene estable en base a una sola cosa: La confianza. ¿Y cómo podrá funcionar una sociedad en donde no exista confianza a nivel personal, profesional, institucional o a cualquier otro nivel? Es decir, ¿cómo sabes que la tienda a la cual le estás comprando algo online es real? ¿Cómo sabes que el portal o app de tu banco no es uno falso? ¿Cómo sabes que con quien estés hablando en una videoconferencia es quien dice ser? ¿Cómo sabes que el video que viste de un ser querido supuestamente haciendo una fechoría es real? ¿Cómo sabes que los resultados de tus búsquedas en Internet son reales? ¿Cómo sabes que el video de tu hija haciendo pornografía no es real? ¿Cómo sabes que la empresa con la cual llevas semanas negociando es real? ¿Cómo sabes que las autoridades gubernamentales que te están demandando un pago de impuestos es real? ¿Cómo sabes que un documento científico que estás leyendo es real y cita fuentes reales y contiene datos reales? ¿Cómo sabes que las noticias que estás viendo es real? ¿Cómo sabes que lo que dice el próximo candidato presidencial es reall? Bajo este nuevo esquema social que estamos entrando gracias a la IA Generativa se hará casi imposible operar, creer o maniobrar, y podríamos fácilmente llegar a un estancamiento social de proporciones épicas. Sin embargo, hay soluciones que podemos implementar como sociedad. La primera es una recomendación que hago a nivel familiar y de amigos cercanos, y es la de crear una palabra o frase clave que solo ustedes conozcan, y que nunca hayan comunicado de forma digital en ningún momento, de modo que si algún día reciben una llamada de emergencia o de alguna otra índole dudosa, ustedes puedan preguntar la palabra o frase clave para verificar la identidad de la persona al otro extremo de la comunicación. Así que por ejemplo, si en una reunión familiar nos ponemos de acuerdo de que nuestra palabra de seguridad será “Segismundo”, y posteriormente recibes una llamada de un familiar aludiendo una emergencia y pidiendo una transferencia de dinero, lo primero que le preguntarías es la palabra clave secreta. Si la persona no pueda contestarla (o al menos decirte el lugar y otros datos del día en que acordaron la clave) eso significa entonces que esa persona está posiblemente siendo personificada por un hacker con tecnología deep fake. La segunda sugerencia es una sugerencia tecnológica que debemos exigir se integre a toda tecnología que capture o genere contenido en cualquier formato (sea texto, sonido, imágenes o videos), y tiene que ver en que desde su misma fuente debemos poder codificar una firma digital que podamos verificar contra alguna fuente. Así que por ejemplo, bajo este esquema toda cámara digital, todo celular, todo micrófono y toda IA que genere imágenes, texto, sonido o video debe poder incrustar información que permita comprobar que el cotenido o fue (1) generado por medios “orgánicos” (como por ejemplo, un video que capturaste en un cumpleaños) o (2) por medios sintéticos (como un video de un cumpleaños imaginario generado por una IA), así como proveer información de su fuente (como el autor, fecha de creación, etc). De esta manera, si vemos una noticia o leemos un libro o artículo, o recibimos una llamada de audio o participamos en una videoconferencia, podemos tener algún grado de certeza de que lo que percibimos es real o sintético y de su actual procedencia. Para esto es necesario desarrollar estándares tecnológicos en la industria para que la información capturada (por ejemplo) por una cámara digital esté cifrada desde el momento que es capturada por su sensor de imagen, y para que una firma digital sea parte de la imagen antes de que esta se almacene o esté disponible para distribuirse, y de paso que en cualquier momento se pueda detectar si el contenido fue alterado en lo más mínimo. Una buena noticia es que ya existe una iniciativa de parte de algunos fabricantes de cámaras y líderes de la industria para crear algo similar, e incluso ya existen algunas cámaras profesionales del mercado con tecnología similar a esto, y de paso ya existe investigación para crear sistemas que incluyan watermarks (“sellos de agua” digitales) en habla generada por IA Generativa, e incluso ya existe una propuesta de ley en el estado de California en EEUU para requerir que todo contenido sintético tenga que venir con un watermark, por lo que poco a poco veremos este tipo de tecnología esparcirse a todo sistema que genere contenido de alguna forma. Y esperemos que estas soluciones ocurran más temprano que tarde, ya que de no ser así nos arriesgamos a que la falta de confianza en nuestros sentidos nos lleven a un caos social con resultados posiblemente catastróficos para la humanidad. - p.d.: Para los curiosos sobre la pregunta que puse al inicio del artículo, no, este articulo no fue escrito por una IA. O al menos eso le digo a ustedes… Actualización: El lector Sergio Hernandez hizo una buena observación en los comentarios sobre el tema de firmas digitales, y respondí a su comentario para aclarar que cuando hablamos de una firma de agua digital hablamos de una firma criptográfica basada en el concepto de un Hash (y por extensión en cifrado de datos con llaves públicas y privadas), sin embargo esos son conceptos demasiados técnicos que extenderían demasiado este artículo, lo importante es el concepto de poder verificar la fuente de algo. Actualización 8 de abril 2025: Panasonic se une al Content Authenticity Initiative para poder autenticar que las fotos tomadas con sus cámaras que soportan el estándar no fueron modificadas posteriormente. autor: josé elías |

|

|

|

|

|

jueves, diciembre 23, 2021

|

Hola amig@s lectores, Hola amig@s lectores,Después de más de 14 años informándoles sobre el James Webb Space Telescope (JWST por sus siglas en inglés) en artículos como este del 2007, el tiempo por fin ha llegado, y si todo sale bien el próximo sábado 25 de Diciembre 2021 (entre las 7:20am y 7:55am horario de New York) por fin se lanza al espacio, y hoy quiero escribirles sobre su historia, importancia y futuro. Al final del artículo espero tengan una mejor apreciación sobre este monumental proyecto científico y sobre por qué nunca en la historia de la humanidad la comunidad científica estará tan nerviosa como el momento en que se lance este instrumento al espacio y sus posteriores meses de establecimiento en su hogar final. La historia del JWST La ideal del JWST originó en 1989, y entre ese año y el 1994 la comunidad científica empezó a idear, pre-diseñar y debatir sobre cómo podría construirse semejante instrumento. Es bueno destacar que varias de las tecnologías necesarias para su construcción todavía ni existían ni se habían inventado. Después de esa época (que compagina con el éxito y los problemas del Telescopio Espacial Hubble) se inició una etapa de planeamiento, culminando en que para el 2002 se acuñara el nombre James Webb (eh honor al Director de la NASA que estuvo a cargo de las misiones Apollo que llevaron a la humanidad a la Luna) y se otorgara el contrato de su construcción a la empresa Northrop Grumman, que para los que no la conozcan es uno de los más grandes contratistas militares de EEUU, y esencialmente es una empresa que vive de contratos del gobierno de los EEUU, por lo que pueden estar seguros que en la decisión de elegirlos a ellos existió todo tipo de maniobras políticas tras bastidores, y que de existir una empresa privada como SpaceX en ese entonces que la historia hubiese sido diferente (en términos de costos y tiempos), pero esa es una historia para otro artículo... Mientras tanto lo importante a saber es que en ese momento se le puso un presupuesto al proyecto de Mil Millones de dólares (US$1,000MM), con una fecha de lanzamiento del telescopio para el 2010. En ese entonces también ya se hablaba de que si se disparaban los costos por imprevistos que el costo pudiese aumentar a US$3,500MM. En el 2004 inició la construcción de los masivos espejos hexagonales que serían parte distintiva de su diseño. Estos espejos, chapeados en oro puro (para aumentar su sensibilidad a la luz infrarroja) se diseñaron como un conjunto de 18 piezas hexagonales por distintos motivos. El primero es que se hacía menos complejo y costoso fabricar los enormes espejos por separado, pero la razón principal es que no existe cohete en existencia capaz de subir un espejo tan grande, por lo que se hizo un diseño en donde el espejo en forma de colmena de abeja se dobla en 3 partes para que quepa en el cohete, y después se pueda abrir en el espacio a su tamaño de operación. Es bueno notar que la precisión necesaria para que esos espejos se unan en el espacio debe ser inimaginable precisa, con márgenes de error en las millonésimas de un metro, por lo que toda una nueva tecnología de alineamiento se debió de inventar para hacer eso posible. Por la misma razón, no solo el espejo principal, sino que el telescopio completo, fue diseñado de forma tal que este se doblara como una pieza de origami (literalmente), y de desdoble ya en el espacio. Esto de por sí ya representó una complejidad enorme para el diseño del JWST. Notemos que muchos de estos diseños fueron re-pensados en el 2005 cuando se notó que el grado de complejidad iba a ser mucho superior a lo pensado, y se terminó decidiendo utilizar ese año el diseño actual. Sin embargo los cambios de diseño más el entendimiento de la envergadura del trabajo adelante necesitaron de una revisión del presupuesto y la fecha de finalización, los cuales se corrigieron a US$4,500MM y una nueva fecha de lanzamiento del 2013. El trabajo progresó por unos años, de camino topándose con grandes retos tecnológicos por resolverse, culminando esa etapa en un estudio independiente ordenado por El Congreso (de legisladores) de los EEUU en el 2010, en donde se concluyó que no solo iba a ser imposible finalizar el telescopio a tiempo, sino que su precio iba a aumentar significativamente. Al final del día se estimó una nueva fecha de poner el JWST en el espacio del 2015, y esta vez con un precio de US$6,500MM. Sin embargo poco después se hizo evidente que incluso esos nuevos estimados no eran realistas, y la NASA corrigió la cifra a US$8,800MM con una nueva fecha de lanzamiento del 2018. Después de mucho esfuerzo, el JWST fue finalizado en el 2016, pero al realizarse pruebas extensas se descubrieron todo tipo de anomalías y problemas de diseño e ingeniería, culminando esto en que se retrasara nuevamente el lanzamiento al 2019. En medio de todo esto se descubrieron todo tipo de errores humanos (que según la NASA costaron 18 meses de retraso y US$600 Millones de dólares). Y en medio de todos estos retrasos, pruebas y rediseños de último minuto llegó el Coronavirus y la pandemia del COVID-19, poniéndose una fecha tentativa de lanzamiento para el 30 de Marzo del 2021. Estos nuevos retrasos aumentaron el costo en US$800M más, llevando el costo final de construcción del JWST a US$9,600MM y aportaron un nuevo retraso con la nueva fecha siendo Octubre 2021. Sin embargo, meses antes se descubrieron problemas con el cohete Ariane 5 que lanzaría el JWST, y se retrasó nuevamente el lanzamiento para el día 18 de diciembre 2021. Mientras tanto el JWST fue transportado por el canal de Panamá en secreto (debido a su valiosa carga) a su lugar de lanzamiento y pruebas finales en el complejo ELA-3 de la empresa Arianespace, cerca de Kourou, en Guayana Francesa. Sin embargo el JWST no se lanzaría el día 18, ya que días antes una correa que mantenía asegurado el telescopio en el laboratorio de pruebas se soltó inesperadamente lo que provocó una serie de vibraciones en todo el telescopio, y por tanto se tuvo que pausar para revisar que todo estuviese funcionando bien después de ese incidente. La nueva fecha fue Diciembre 22. Sin embargo el día 22 tampoco se iba a poder lanzar al descubrirse un fallo con uno de los cables del sistema de telecomunicaciones del telescopio. Y entonces se mudó la fecha al día 24. Y el día 24 se pospuso una vez más para el día 25 debido a que no se pronosticaban situaciones atmosféricas favorables para el despegue. Así que si todo sale bien, este sábado 25 de diciembre 2021 despega el JWST (si ocurre otro retraso o eventualidad actualizaré este artículo). Riesgos del JWST Y he aquí en donde entran los nervios. El JWST es un instrumento que ha sido soñado durante más de 3 décadas, y su lanzamiento se ha retraso ya por más de 2 décadas, y el tiempo, dinero, diseño, recursos humanos, carreras, investigación, tecnología, sudor y sueños que ha sido invertido en su construcción no puede subestimarse bajo ninguna posible variable de medida. Y dado su gran costo y complejidad no existe un respaldo. O todo sale bien con su despegue y puesto en funcionamiento o se perdió todo ese trabajo (y sueño); sería uno de los días más tristes de la humanidad. Y noten que a diferencia del Telescopio Espacial Hubble que orbita a apenas 547km sobre la Tierra, el JWST estará a 1.5 millones de km de distancia de nosotros, en un lugar en donde se haría imposible en la práctica ir a repararlo (como fue el caso con el Hubble que sufrió de problemas con su espejo principal así como otros problemas que científicos y astronautas pudieron solucionar). Y es bueno notar que el nivel de complejidad del JWST es muchísimo mayor que el Hubble, por lo que muchas cosas puedan salir mal hasta que este empiece a funcionar en ese punto lejano. Según la NASA, hay una lista de más de 1,000 (mil) cosas que tienen que funcionar a la perfección para que el JWST llegue a su destino y empiece a trabajar. Entre las cosas que pueden salir mal se destacan el lanzamiento mismo, la etapa de "descascaro" en donde el JWST será expuesto al espacio por primera vez, la etapa de descoplamiento de la nave Ariane 5, la etapa de impulso hacia su hogar (el llamado Punto Lagrange L2), le etapa de desplegar sus paneles solares, la etapa de despegarse de la base impulsora, la etapa de desplegar y acoplar los elementos de su espejo, la etapa de desplegar su protector solar (una inmensa tela super avanzada más fina que un cabello humano que le dará sombra ante el Sol, y que permitirá que el JWST funcione a una temperatura de unos 50 grados Kelvin que equivale a unos -223° C o -370° F, y notar que del otro lado de la tela la temperatura será de unos 383 grados Kelvin o unos 110° C o 230° F), sus antenas de comunicación (si no podemos hablar con el JWST no podremos darle instrucciones ni ver las imágenes que genere), etc etc etc. Eso sin mencionar sus sistemas de cómputos, almacenamiento, propulsión, guía astronómica, software, y las decenas de miles de piezas que componen todo eso. O en otras palabras, este despegue y subsecuente llegada a su destino final serán los primeros minutos y subsecuentes meses de mas nervios y ansiedad en toda la historia científica de la Tierra. Literalmente hay miles de cosas que pudiesen fallar, y todas deben funcionar a la perfección, y en el primer intento. No hay respaldos ni segundos intentos. Y por eso parte del costo del JWST, pues tenemos que asegurarnos que todo funcione sin margen de error. Si yo tuviese que decir cuáles son las posibilidades de que algo surja mal con el JWST en su lanzamiento y puesta en marcha, diría (preocupadamente) que no es un porcentaje bajo, rondando quizás en el 3 al 5% que es bastante alto para este tipo de misiones. Y si se preguntan, ¿por qué enviar el JWST tan lejos? Pues como siempre, hay una razón científica para ello. A donde enviaremos el JWST es lo que se llama el Lagrange Point L2, que es un lugar en el espacio en donde la fuerza gravitatoria de la Tierra y la del Sol se cancelan mutuamente, por lo que cualquier objeto en ese lugar podrá permanecer tranquilo sin necesidad (o muy poca necesidad) de utilizar combustible (aun así el JWST lleva un poco de combustible para pequeñas maniobras de calibración y ajustes), y es importante además ese lugar ya que al quedar a 1.5 millones de km de la Tierra (y la Luna) no tendrá interferencia de nuestras señales u objetos cercanos de gran tamaño, lo que es esencial para el tipo de astronomía que estará haciendo. ¿Cuándo empezaría a funcionar el JWST? Antes de que el JWST envíe su primera imagen, varias cosas deben suceder. Lo primero es que debe lanzarse y llegar a su destino final en el punto L2, sin embargo ese no es un viaje corto. Le tardará al JWST aproximadamente un mes de viaje llegar a su destino, y varias semanas para estar totalmente desplegado físicamente en su forma final. Después se iniciarán toda una serie de pruebas de todo tipo que incluyen pruebas mecánicas, de consistencia, de vibraciones, de telecomunicaciones, computación, almacenamiento, orientación, data, algoritmos, y sobre todo de sus instrumentos científicos. Esta es una etapa crucial y extensa, que contando todo desde el día de su lanzamiento tomará unos 6 meses. Y solo después de este tiempo y que se haya verificado que todo esté funcionando correctamente se le dará la instrucción del JWST de capturar su primera imagen oficial. El día que esa imagen llegue a la Tierra será un gran día para celebrar en la ciencia y para toda la humanidad. ¿Qué va a estudiar el JWST? Si todo sale bien, la misión principal inicial del JWST será nada más ni nada menos que observar directamente a nuestro universo en el pasado cuando este tenía apenas entre 100 y 250 millones de años (recordemos que el Big Bang se estima ocurrió hace unos 13800 millones de años), por lo que estaríamos observando nuestro universo cuando este era literalmente un bebé. Eso significa que veremos las primeras estrellas mientras se formaban y también veríamos las primeras galaxias y posibles agujeros negros. Esto nos dará información invaluable para confirmar varias teorías científicas y de paso sin duda contribuirá a una nueva serie de descubrimientos, algunos de los cuales cuya naturaleza aun quizás no podemos ni imaginar. En paralelo a esa misión principal, los instrumentos del JWST también nos darán invaluables nuevos datos sobre exoplanetas (planetas en otros sistemas solares), la evolución de las galaxias, información adicional sobre objetos exóticos como agujeros negros, estrellas de neutrones y cuásares, y quizás nos de pistas para resolver temas pendientes como el concepto de la Energía Oscura que aparenta ser responsable de la expansión del universo, así como la posibilidad de averiguar qué es la tal llamada Materia Oscura. Y (literalmente) miles de temas más en su lista. Como nota final noten un par de curiosidades sobre la capacidad del JWST (que compartí con ustedes en mis redes sociales recientemente): El espejo del JWST puede distinguir los detalles de una moneda colocada a 40km de distancia, así como puede ver estrellas 10 mil millones de veces más tenues que verlas a simple vista. - Para ver el lanzamiento en vivo sintonicen en NASA TV en este enlace en YouTube. - Los dejo ahora con un video oficial que les ilustra cuál será la travesía del JWST desde el momento del despegue a su inicio de funcionamiento. El video es en inglés pero la parte visual les dará una buena idea de todo lo que ocurrirá sin necesidad de palabras. Que lo disfruten. - Actualización 1: Si desean ver una versión doblada al español del video anterior, la pueden ver acá, cortesía de mi amigo Manuel Grullón (@manuelg296) quien una vez fue Presidente de Astrodom (la Sociedad Astronómica Dominicana) y es el actual Coordinador Nacional de divulgación astronómica para República Dominicana ante la UAI (Unión Astronómica Internacional) Actualización 2: ¡El lanzamiento fue todo un éxito! Ahora a seguir con las próximas etapas arriesgadas de la misión que incluye un mes de viaje hasta su destino final y todos los pasos enumerados en el artículo. Hoy fue un gran día para la humanidad. Actualización 3: ¡Hoy 8 de enero 2022 el JWST finalizó su etapa de ensamblaje final! Los próximos pasos son empezar a alinear los bloques del espejo principal para formar un solo espejo compuesto perfecto y empezar a calibrar y probar todos los instrumentos a bordo. Todo este proceso tomará unos 5 meses más, pero ya lo más peligroso de la misión ha pasado lo que es un minumental alivio. Actualización 4: Esta semana que inicia Marzo la NASA anunció que se acaba de finalizar exitosamente la alineación tanto de los espejos como de la cámara principal, y además anunció que las primeras imágenes de pruebas de calibración superan las expectativas. Todavía se estima que para Julio de este año 2022 entrará en operación oficialmente. Actualización 5: El 11 y 12 de Julio la NASA hizo públicas las primeras imágenes del JWST, y he acá una de las más preciosas de ellas.

autor: josé elías |

|

|

|

|

|

martes, diciembre 21, 2021

|

Hola amig@s lectores, Hola amig@s lectores,Antes de finalizar el año quiero hacer una breve reseña de las cosas tecnológicas más relevantes de este año 2021, desde sorpresas hasta cosas que cambiarán nuestras vidas en el futuro. Así que sin mucho más que decir, y sin ningún orden en particular, he aquí mi lista: 1. Iniciativa del Año: El Metaverso, por Meta (previamente llamada Facebook) El Metaverso no ha sido inventado por nadie en particular, pero Mark Zuckerberg se apropió del término y hasta renombró a su empresa Meta para demostrar lo serio que está con este tema. Y aunque falta ver si Meta será el principal o uno de los principales jugadores en todo esto del Metaverso (piensen de ello como el inicio a un mundo similar al de Matrix), lo cierto es que hay que darles crédito por no solo popularizar el término en la cultura popular, sino por animar al resto de a industria a tomar el concepto totalmente en serio. 2. Tendencia del año: NFT Si hay algo que junto con el Metaverso será parte fundamental de nuestro futuro tecnológico, es el concepto de los NFT (o Tókens No-Fungibles), que son el equivalente digital a tu ser propietario de cosas en el mundo fuera del ciberespacio. Lean más sobre NFTs aquí. 3. Palabra del año: NFT Y en segundo lugar "Metaverso". 4. Cripto-plataforma del año: Ethereum Aunque Bitcoin fue lo que indudablemente puso el tema de las criptomonedas en el mapa, en realidad ha sido Ethereum con su plataforma y su Ether que han estado revolucionando el espacio de las cripto-transacciones, permitiendo no solo pagar con monedas digitales sino proveyendo herramientas para crear toda una nueva generación de aplicaciones desentralizadas (como los NFTs). Y si les interesa el cripto-trading, acá un artículo al respecto. 5. Visor de Realidad Virtual del Año: Oculus Quest 2 Aunque este visor salió el año pasado, continúa al día de hoy siendo la mejor introducción al Metaverso que puedan comprar, y lo mejor de todo es que dependiendo dónde y cuándo compren su precio ronda entre los US$250 y US$300 dólares, que en mi opinión es una mejor compra que una consola tradicional de video-juegos que cuesta mucho más y no ofrece ni cerca del grado de inmersión que este equipo ofrece. Esta es una de las compras tecnológicas que más recomiendo a cualquiera. 6. Innovación Cinematográfica del Año: Empate entre (1) la cámara DJI Ronin 4D con tecnología flotante y LIDAR, y (2) la tecnología Cinema ProRes en el iPhone 13 Pro. La cámara DJI Ronin 4D es una cámara totalmente diferente a todas las que vinieron antes. No solo tiene un diseño en donde el sensor y el lente flotan delante de la cámara (para hacer imágenes super estables) sino que además incluye tecnología LIDAR para enfocar, lo que significa que la cámara crea una representación tridimensional de su entorno por medio de rayos láser para saber la distancia exacta entre el lente y el sujeto a grabar, permitiendo enfocar de manera super precisa no solo de día sino incluso en casi total oscuridad (la tecnología LIDAR es utilizada también por algunos fabricantes de automóviles robóticos para entender su entorno). Y en cuanto a la tecnología Cinema ProRes, de alguna manera Apple logró meter dentro del espacio de un celular (en este caso la versión Pro del iPhone 13) un encodificador del estándar de codificación de cine, ProRes, lo que le permite grabar video en crudo con una calidad que hasta ahora era solo posible en cámaras que costaban decenas de miles de dólares. Y de paso le agregaron un modo de desenfoque computacional a las imágenes para darle un "look" más cinemático a los videos. Si tienen un iPhone 13 Pro noten que esto deben activarlo en Configuración, y que si no saben lo que hacen no recomiendo lo utilicen ya que este tipo de videos genera archivos varias veces más grandes que videos normales. Esto está diseñado específicamente para profesionales que necesitan la más alta calidad posible (que tampoco será evidente hasta que sepan como manipular los parámetros del video generado para cambiar su exposición y otros factores). 7. Cámara Computacional del Año: Google Pixel 6 Hay dos maneras principales de crear imágenes fotográficas: De forma óptica (es decir, lo que sea que entre al sensor por el lente) y de forma computacional (es decir, se toman datos del lente y después se mejoran con computación), y un ejemplo de fotografía computación es la funcionalidad que popularizó Apple que permite desenfocar el fondo de una foto después de esta haber sido tomada. Sin embargo ha sido Google quien ha llevado esto a otro nivel con su nuevo celular Pixel 6, que en mi opinión es el mejor valor por tu dinero en el mundo Android en estos momentos. 8. Tecnología Revolucionaria del Año: Los procesadores M1 Pro/Max de Apple Cada cierta cantidad de años una tecnología surge que estremece los cimientos de su industria ocasionando grandes cambios, y la serie de procesadores M1 Pro/Max acaban de hacer eso. Estos procesadores no solo han creado un abismo en la relación precio/rendimiento entre Macs y las tradicionales PCs con Windows, sino que han creado toda una revolución que ahora están forzando a Microsoft y los demás participantes del mundo Windows a adoptar procesadores con tecnología ARM. Solo para que tengan una idea, una laptop MacBook Pro 2021 con el procesador M1 Max puede manipular en tiempo real hasta 7 fuentes de video 8K en crudo y HDR, lo que significa el manipular 56 veces más flujos de datos en tiempo real que un video 4K tradicional. Lograr eso en una PC tradicional requiere en la actualidad de comprar tarjetas de video especializadas que cuestan por sobre los US$5,000 dólares, y aun así no pueden manejar 7 flujos de 8K HDR simultáneos. Y todo eso lo hace un solo chip dentro de una MacBook Pro ahora. Y esto no es solo mercadeo. Todas las pruebas que ya se han hecho públicas por profesionales creativos han confirmado que una MacBook Pro M1 ya es entre 3 y 15 veces más rápida que una PC super potente costando varias veces más, utilizando el mismo programa en ambas máquinas (como Photoshop, Lightroom, etc). Y como si fuera poco, Apple logra todo eso con un super bajo consumo energético que permite que todo ese poder se pueda utilizar en una laptop corriendo en batería todo el día, sin conectar la corriente eléctrica a una pared, mientras que en el mundo Windows hacer lo mismo por lo general significa PCs de escritorio con power supplies halando al menos 250 vatios continuos como mínimo. Esto está provocando una ola de adopción y migración hacia Macs como nunca antes vista en la historia de Apple, y acelerando la llegada de una nueva generación de procesadores ARM para Windows en el 2022. Aprende más sobre la tecnología de chips propietarios de Apple aquí. 9. Sistema de Computación Personal del Año: Apple MacBookPro M1 Pro/Max Debido a las razones enumeradas en el punto anterior, en estos momentos no hay nada ni siquiera remotamente cercano a lo que puedes obtener en términos de rendimiento por tu dinero al comprar una MacBook Pro 2021 con procesador M1 Pro o M1 Max. 10. Innovación Cotidiana del Año: AirTags de Apple Los AirTags son objetos del tamaño de monedas grandes que dejas en tu automóvil, mochila, mascota, cartera o cualquier cosa que se te pueda perder o te puedan robar, y que te permite localizarlo rápidamente. Los AirTags es bueno notar que no tienen función de GPS con ellos, sino que dependen de que cerca de ellos existan personas con un iPhone, ya que Apple ha creado una red global en donde todos los iPhones del mundo se comunican de forma segura con los AirTags, y reportan su ubicación. Así que por ejemplo si te roban tu automóvil, y dejaste un AirTag adentro, es bastante posible que en algún momento algún desconocido que tenga un iPhone estará cerca de tu vehículo, en cuyo caso el AirTag se comunicará contigo y sabrás donde está tu auto (y claro está, que como todo en la vida, esto tiene sus usos buenos y malos como ya ha sido reportado de bandidos pegando AirTags a autos que desean robar para saber la ubicación de su propietario). 11. Sorpresa visual del año: La cámara Nikon Z9. Nikon salió literalmente de la nada con una cámara mirrorless (sin espejo) que ha no solo dejado atónitos a todos sino que dejado hasta mal parada a la competencia. Esta cámara aparte de poder disparar fotos a 20fps en RAW, 30fps en JPG, también tiene un modo especial para capturar 120 fotos por segundo en menor resolución. Esto la hace en una cámara ultra potente para deportes y acción. La cámara además tiene 45 Megapixeles con un impresionante rango dinámico lo que la hace también excelente para fotografía de bodas, retratos artísticos, y moda. Como si fuera poco graba video crudo con resolución 8K lo que de paso la hace una máquina ultra potente para el cine profesional. Una actualización gratuita próxima le permitirá grabar video12-bit 8K N-Raw y 4K ProRes RAW internamente, con 8K/60fps. Algo inaudito. Como si fuera poco, tiene un ultra-rápido sistema de enfoque automático 3D que se asegura que tus fotos salgan nítidas sin importar cuánto se mueva el sujeto que estás capturando en fotos o video. Y noten que aunque la cámara cuesta US$5,500 dólares, que eso es más barato que las cámaras de gama alta de Canon (la EOS R3) y Sony (la A1). 12. Renacimiento del año: Nikon Gracias a su cámara Z9, la empresa se acaba de levantar como el ave Fenix de sus cenizas. La empresa no ha podido fabricar suficientes para satisfacer la demanda. 13. Herramienta de Desarrollo de Software del Año: Microsoft Visual Studio Code No confundir con su otro producto llamado simplemente "Visual Studio", esta es la versión open-source que se ha tornado indispensable para toda una nueva generación de desarrolladores de software, gracias a su expandabilidad por medio de plug-ins que expanden su funcionalidad a esencialmente cualquier área imaginable de la computación. 14. Plataforma de Desarrollo Multi-Plataforma del Año: Google Flutter Si planean arrancar desde cero un App que deba compilar tanto para Android como iPhone, iPad, y ahora hasta Web, Windows, Linux y Mac, no creo exista mejor opción en el mercado que Flutter de Google. No solo genera Apps multi-plataforma sino que de muy alto rendimiento, y la más reciente versión ahora incluye librerías para video-juegos 2D de alto rendimiento. 15. Plataforma de Streaming del Año: Disney+ Disney+ no tiene ni cerca del contenido de Netflix, sin embargo se ha enfocado en algunos nichos que ha hecho que despegue más rápido que Speedy Gonzalez. Parte de su truco ha sido capitalizar sus franquicias de Marvel, creando series originales que solo se pueden ver por esa vía, como la excelente Loki. 16. Tecnología Científica del Año: El James Webb Space Telescope Si todo sale bien este telescopio se lanzará este próximo 25 de Diciembre 2021, y durará 1 mes para llegar a su destino a 1.5 millones de km de distance a un punto calmado y equilibrado grabitacionalmente, en donde desplegará una gran sombrilla espacial para bloquear la luz solar y poder observar el universo en tranquilidad como ningún otro instrumento en la historia de la humanidad. Su misión principal será la de observar los primeros 100 a 250 millones del años después del Big Bang (es decir, cuando nuestro universo era un bebé) para así entender mejor nuestros orígenes. Sin embargo la ciencia que hará será mucho más extensa que eso, tocando todos los campos de la astronomía y astrofísica a nuestro alcance, desde agujeros negros y posible materia oscura hasta la evolución de galaxias y el estudio de objetos exóticos como los cuásares. El lanzamiento de este instrumento es algo que hemos estado esperando desde el 1989 (a un costo de casi 10 mil millones de dólares) cuando se propuso por primera vez, por lo que esta será la misión con más nervios jamás lanzada al espacio por la humanidad. 17. Avance de Salud del Año: AlphaFold por DeepMind DeepMind es una inteligencia artificial de Google, y uno de los proyectos en que participó se llama AlphaFold, que ha permitido en tiempo record predecir como se doblan de forma tridimensional todo tipo de moléculas, específicamente proteínas de ADN. Esto es un paso monumental que en pocos años acelerará el descubrimiento de medicinas y tratamientos para todo tipo de enfermedades. 18. Viaje Espacial del Año: William Shatner (“Captain Kirk”) en la nave de Blue Origin Jeff Bezos (fundador de Amazon y Blue Origin) ganó muchos puntos de mercadeo este año al anunciar que enviaría al espacio a William Shatner, mejor conocido como el Capitán Kirk en la serie clásica de Star Trek ("Viaje a las Estrellas"), logrando con eso un sueño de muchos geeks de ver a este actor subir al espacio en la realidad. 19. Empresa Espacial del Año: SpaceX ¿Qué más podemos decir de esta empresa? Sencillamente no tiene igual. No solo hizo decenas de pruebas y lanzamientos (de cargo a naves espaciales exploratorias, de viajes a la Estación Espacial Internacional, y subiendo todo tipo de satélites), sino que está bien encaminada a cumplir su misión de llevar la humanidad al planeta Marte, como lo prometió su fundador Elon Musk. 20. Nave Espacial del Año: StarShip de SpaceX ¿Podrían imaginar un edificio rascacielos no solo despegando sino que volviendo a aterrizar de espalda nuevamente? Pues eso es exactamente lo que hace la nave StarShip que en el 2021 SpaceX logró demostrar que podrá cumplir su misión no solo de subir grandes cantidades de cargo al espacio, sino de llevarnos al planeta Marte. 21. Tecnología Espacial del Año: StarLink de SpaceX ¿Internet satelital de alta velocidad y baja latencia en cualquier parte del mundo y a un costo razonable? Envíenme el contrato rápidamente... Elon Musk es un genio certificado. 22. Empresa Automovilística del Año: Tesla Tesla casi por su propia cuenta ha sido la principal responsable a nivel mundial de popularizar los vehículos eléctricos, y no vemos fin a su buena racha. Cuando salga a la venta el Cybertruck será todo un fenómeno de ventas y de cultura popular. Una vez más, Elon Musk a la cabeza. 23. Personaje del Año: Elon Musk No hay sorpresas aquí. Este año ni siquiera hubo competencia remota para un segundo lugar a ponderar. Este hombre se está consagrando como el Leonardo DaVinci de nuestros tiempos, y todavía le falta mucho por vivir. autor: josé elías |

|

|

|

|

|

domingo, diciembre 9, 2018

|

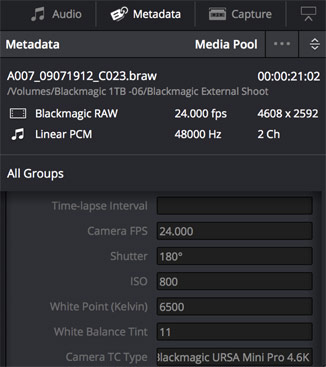

Hola amig@s lectores, Este año, solo para divertirnos un rato, decidí crear un premio #eliax para aquellas tecnologías, empresas y personas que creo se destacaron en el 2018. Les recuerdo que todos los ganadores son elecciones personales, y que quizás ustedes no estén de acuerdo con algunas de ellas. Sin embargo, en cada caso trato de justificar el por qué de mi elección. Y ojo, que cada año salen centenares de productos, y que estoy consciente de que hay muchos más fuera de esta lista que son productos increíbles, pero quise concentrarme solo en la "crema de la nata", en aquellos que sobresalen por innovación y/o ejecución presente, o por el potencial que representan hacia futuro. Si creen que me faltó algún producto, empresa, persona o categoría en la lista, comenten en los comentarios y consideraré incluirlo con una actualización, pues es obvio que algo se me pudo haber pasado por alto (esta lista me sentí a escribirla literalmente en unos 10 minutos, recuerden que hago esto por puro hobby). Finalmente, una aclaración para los conspiranóicos: Ninguna de las empresas aquí mencionadas me paga o favorece ni directa ni indirectamente (ni en dinero, bienes o favores) por hablar bien de sus productos. Así que sin más que decir, acá vamos... Producto Tecnológico del año (empate) Amazon Basics Microwave Oven with Alexa  ¿Un horno de microondas es el producto tecnológico del año? ¿en serio? ¿qué tiene de especial ese aparato? Eso de seguro es lo que le ha pasado por la mente a todo el que haya sido sorprendido por esta elección (y que no hayan asistido a una de mis charlas en donde menciono en detalle esta iniciativa de Amazon). ¿Un horno de microondas es el producto tecnológico del año? ¿en serio? ¿qué tiene de especial ese aparato? Eso de seguro es lo que le ha pasado por la mente a todo el que haya sido sorprendido por esta elección (y que no hayan asistido a una de mis charlas en donde menciono en detalle esta iniciativa de Amazon).Pero este no es un simple horno de microondas. Es un horno de microondas con Inteligencia Artificial al cual le puedes hablar con Alexa (toda la inteligencia del microondas reside en la nube, por lo que necesitas conectarlo a Internet por WiFi) para que te cocine, por fin liberándote de tener que descifrar esos interfaces extraños con los cuales vienen estos dispositivos. Ahora en vez de presionar botones solo pones la comida adentro y dices algo como "Alexa, calienta la sopa", o "Alexa, cocina esta lasaña", o "Alexa, descongela la pizza". De ahí el adelante el microondas se encarga. Esto a simple vista no aparenta gran cosa, pero aparte de eso este microondas tiene sensores que detectan si por ejemplo pones fundas de palomitas de maíz adentro, y desde que nota que se te van a agotar ordena más automágicamente tras bastidores con tu cuenta de Amazon Prime para que te lleguen a tu casa lo antes posible y siempre tengas palomitas disponibles (solo imaginen el potencial que tiene esto para Amazon en todo tipo de productos). En mi opinión, esto es apenas el inicio de toda una estrategia y serie de electrodomésticos inteligentes que Amazon está introduciendo bajo el radar, y explica además el por qué recientemente compró la cadena de supermercados de Whole Foods en EEUU por unos US$13,400 Millones de dólares. Imagínense ahora refrigeradores que automáticamente detecten cuando las comidas vayan a vencer y te sugiera recetas (con otros ingredientes que te recomendará Amazon para que compres), o lavadoras de ropa que automáticamente ordenen detergentes desde Amazon. Y eso es tan solo el inicio... Es bueno notar que de este tipo de dispositivos hogareños inteligentes se viene hablando desde hace literalmente décadas, e incluso han salido uno que otro producto al mercado, pero este es en mi opinión el primero que hace la mezcla mágica de un producto práctico, con una Inteligencia Artificial probada (Alexa), a un bajo costo, y con potencial de ser parte de toda una plataforma y ecosistema. Al menos que otro competidor se de cuenta de lo que está ocurriendo y actúe rápido, Amazon se convertirá en el centro de nuestra vida digital hogareña cotidiana... Lo pueden obtener en este enlace por US$59 dólares desde Amazon.com Google Duplex  Para los que tampoco hayan asistido a mis charlas, Google Duplex es una tecnología que permite que tu celular funcione como un asistente real para hacer llamadas por ti y hacerte la vida mucho más fácil. Para los que tampoco hayan asistido a mis charlas, Google Duplex es una tecnología que permite que tu celular funcione como un asistente real para hacer llamadas por ti y hacerte la vida mucho más fácil.En un ejemplo que mostró Google (enlace al video más abajo), una mujer le dice a su celular que le agende una cita en un salón de belleza para cierto día de la semana, y el celular arranca por su cuenta, hace la llamada, y habla como un ser humano (con todas las idiosincracias, incluyendo sonidos y ruidos que hacemos involuntariamente al hablar), y coordina con la persona al otro lado de la linea telefónica que en ningún momento se percata que con quien habla es con una Inteligencia Artificial. Durante la demostración, el sistema incluso negoció una hora en base a disponibilidad con la otra persona en la linea, y después de ahí obviamente de seguro puso en la agenda del celular un recordatorio, así como recordó el lugar para mostrar como llegar ese día con Google Maps, y quien sabe si hasta cobrar con Google Pay... Y para los que no han notado el patrón en #eliax a través de los años: Sí, nos acercamos a una titánica batalla entre los distintos servicios de Inteligencia Artificial, en donde estos poco a poco reemplazarán los típicos interfaces de usuarios con lo que yo llamo desde hace años en mis charlas "Desinterfaces de Usuario". Acá pueden ver la demostración de Google Duplex (la tecnología está disponible ya en algunas ciudades de EEUU en modo de pruebas con un grupo selecto de usuarios de los celulares Google Pixel 3, y se espera salga de forma global en el 2019). Innovación en industria médica del año Apple Watch Series 4 con ECG  Hasta hace poco el tan solo sugerir que se podría reducir todo el equipo de hacer un electrocardiograma (ECG) a algo más pequeño que un celular hubiese parecido ciencia ficción, y mucho menos que cabria dentro de un reloj inteligente, que fue precisamente lo que hizo Apple sorpresivamente con su Apple Watch Series 4 que salió en este 2018. Hasta hace poco el tan solo sugerir que se podría reducir todo el equipo de hacer un electrocardiograma (ECG) a algo más pequeño que un celular hubiese parecido ciencia ficción, y mucho menos que cabria dentro de un reloj inteligente, que fue precisamente lo que hizo Apple sorpresivamente con su Apple Watch Series 4 que salió en este 2018.Es cierto que quizás no sea tan versátil como un equipo dedicado que cueste decenas de miles de dólares, pero para el fin que fue creado es algo sencillamente asombroso y super útil con capacidad de salvar y mejorar vidas. Gracias a estos sensores en el nuevo Apple Watch tu reloj podrá monitorear en tiempo real (o en demanda, dependiendo de lo profundo que quieras hacer el estudio) tu ritmo cardíaco y compartir esa información (si así lo decidas y cuando lo decidas) con tu médico, ofreciendo así un mucho mejor diagnóstico de anomalías cardíacas, y en muchos casos hasta salvarte la vida (como ya se ha reportado ha sucedido entre los primeros usuarios en EEUU). Es importante destacar que en muchos casos cuando los pacientes van a hacerse un electrocardiograma, que muchas veces la anomalía no se presenta en ese instante, pero si el Apple Watch puede proveerle al doctor un ECG del momento anterior en que te sentiste mal (o del comportamiento de tu corazón en tu vida cotidiana), este puede hacer un mucho más acertado y rápido diagnóstico de tu condición. Ah, y como si fuera poco, el nuevo Apple Watch también detecta caídas (utilizando sus acelerómetros con unos algoritmos muy avanzados que evitan falsos positivos) y que automáticamente pueden alertar a un familiar o amigo cercano junto con la ubicación del accidente, lo que está genial para nuestros amados abuelos o padres. El Apple Watch representa apenas el inicio de una tendencia global que veremos en donde dispositivos como este vendrán con todo tipo de sensores para prevenir y diagnosticar decenas de males, mejorando nuestras expectativas y calidad de vida. Página oficial del Apple Watch Tecnología fotográfica del año Fotografía Computacional del Google Pixel 3 y Night Sight  Asombrosamente la gran innovación del año en el mundo fotográfico no vino de una cámara digital tradicional o incluso de las empresas líderes en ese mercado (como Canon, Nikon o Sony), sino de un celular de Google. Asombrosamente la gran innovación del año en el mundo fotográfico no vino de una cámara digital tradicional o incluso de las empresas líderes en ese mercado (como Canon, Nikon o Sony), sino de un celular de Google.El Google Pixel 3 lleva el concepto de "Fotografía Computacional" a todo un nuevo nivel. En vez de depender de lentes caros y grandes sensores, el Pixel 3 depende más de poder combinar muchas imágenes en tiempo real, analizarlas con algoritmos de Inteligencia Artificial, y deducir como la imagen debería verse, produciendo una imagen final que en cierta medida es sintética (o "computada", de ahí el término). Esto se hace efectivamente evidente en su modo Night Sight ("Visión Nocturna") en donde el Pixel 3 puede generar imágenes en ambientes de casi total oscuridad, con calidad comparable a cámaras y lentes que cuestan miles de dólares. Acá en mi cuenta @eliax en Instagram pueden ver varios ejemplos del modo Night Sight del Pixel 3 Innovación en cinema del año (triple empate) BlackMagic RAW  Casi todas la cámaras que graban video hoy día en ambientes de consumidores (o incluso "pro-sumidores") deben comprimir bastante la imagen y almacenarla en formatos como mp4 o Apple ProRes debido al tamaño inmenso de los archivos, pero eso tiene el problema de que ya temas como exposición y balance de color están "quemados" en la imagen, similar a como cuando una cámara fotográfica crea una imagen JPG (en vez de una imagen en crudo, o RAW, que retiene todas las características capturadas por el sensor de la cámara). Casi todas la cámaras que graban video hoy día en ambientes de consumidores (o incluso "pro-sumidores") deben comprimir bastante la imagen y almacenarla en formatos como mp4 o Apple ProRes debido al tamaño inmenso de los archivos, pero eso tiene el problema de que ya temas como exposición y balance de color están "quemados" en la imagen, similar a como cuando una cámara fotográfica crea una imagen JPG (en vez de una imagen en crudo, o RAW, que retiene todas las características capturadas por el sensor de la cámara).En el mundo profesional del video sin embargo es normal capturar en formatos de video RAW (como CinemaDNG RAW), pero esto produce unos archivos inmensos, y por tanto es bastante costoso grabar video en estos formatos, ya que incluso con un disco duro de 1TB podrás grabar apenas unos pocos minutos de video. Y es ahí donde entra el nuevo formato BRAW de la empresa BlackMagic. Acá no tengo espacio para explicarles las increíbles facultades técnicas de este formato (pero incluyo un enlace a un video explicativo de BlackMagic más abajo que recomiendo ver si son usuarios técnicos), pero su gran innovación es que es un formato que genera archivos de tamaño comparables a los de formatos de imágenes comprimidas, y de paso es un formato super ligero para editar, lo que significa que se hace posible editar video 4K (o incluso 8K) en equipos de actualidad sin inversiones adicionales. ¿Y qué significa eso? Que esto permitirá toda una nueva generación de contenido generado con equipos de bajo costo cuya calidad de imagen no distará mucho de equipos que hasta hace poco costaban un riñón y algo más, en esencia democratizando la calidad del cinema a toda una nueva generación de cineastas. La primera cámara que soporta este formato es la URSA Mini de BlackMagic, pero el formato es abierto (para los que son programadores, ya tienen un SDK público) y se espera que pronto otros fabricantes lo adopten. La próxima cámara que adoptará este formato será la BMPCC 4K (leer el próximo punto). Este video les explica en más detalle cómo funciona BRAW BackMagic Pocket Cinema Camera 4K (BMPCC 4K)  Si siempre han deseado hacer cine, y tienen un presupuesto relativamente humilde, no tienen que ir lejos para hacer sus sueños realidad, esta es la cámara que necesitan (a finales del 2018). Punto. Si siempre han deseado hacer cine, y tienen un presupuesto relativamente humilde, no tienen que ir lejos para hacer sus sueños realidad, esta es la cámara que necesitan (a finales del 2018). Punto.De alguna manera BlackMagic puso un sensor equivalente a Super-35mm (y montura MFT), con salida de video RAW de 10-bit, 13-stops de Rango Dinámico, entrada de micrófonos XLR, resolución 4K a 60fps, más una pantalla de 5" detrás, por menos de US$1,300 dólares. Como si fuera poco viene con un puerto USB-C por lo que podrás conectarle SSDs como los micro SSD de Samsung que son geniales (y certificados por BlackMagic para 4K60fps) para estos usos intensos. Y lo mejor de todo es que soportará BRAW en las próximas semanas/meses según BlackMagic. En cuanto a las pocas cosas negativas de esta cámara está su funcionalidad de enfoque automático (que no está a la par de la competencia, pero en cine por lo general se enfoca manualmente), y que no tiene IBIS (estabilización de imágenes interno, pero para resolver este tema lean sobre el próximo ganar más abajo). Sin embargo dada sus otras prestaciones y a este precio esas son cosas que se dejan pasar para esta cámara. Ah, y como si fuera poco, BlackMagic incluye con la BMPCC 4K una copia completa de DaVinci Resolve, que es un super-editor de video que de paso es el estándar hoy día para hacer grading (corrección de color) en Hollywood. La página oficial de la BMPCC 4K DJI Ronin-S Handheld 3-Axis Gimbal Stabilizer  Han existido muchos dispositivos para estabilizar el video en cámaras (una habilidad que es lo que más fácilmente separa el video de un profesional al video de un amateur), pero nunca uno como este y a este precio. Han existido muchos dispositivos para estabilizar el video en cámaras (una habilidad que es lo que más fácilmente separa el video de un profesional al video de un amateur), pero nunca uno como este y a este precio.Por unos US$700 dólares ya puedes deshacerte (o tener que comprar) equipos que cuestan entre 5 y 50 veces más. Y lo mejor de todo es que funciona bastante bien con la BMPCC4K. Este dispositivo (junto a un buen micrófono y sistema de iluminación) es una de las cosas que más fácilmente harán que tu producción se sienta como un producto realmente profesional. Y ojo, es bueno notar que ya existen varios dispositivos similares en el mercado (incluso antes de salir este modelo), pero este es el que funciona de manera fluida mejor que todos, y el que por fin te da un resultado profesional en la palma de la mano (literalmente). Página oficial del DJI RONIN-S Cámara Digital del año (empate) Sony α7 III  La Sony A7 III rompió terreno en muchos aspectos, desde su precio (unos US$2,000 dólares) hasta su excepcional calidad de imagen en un sensor full-frame de 35mm mirrorless, así como video 4K de excelente calidad, y como si fuera poco estabilización de imagen interna (IBIS) y posiblemente la mejor implementación de enfoque automático a los ojos del mercado. La Sony A7 III rompió terreno en muchos aspectos, desde su precio (unos US$2,000 dólares) hasta su excepcional calidad de imagen en un sensor full-frame de 35mm mirrorless, así como video 4K de excelente calidad, y como si fuera poco estabilización de imagen interna (IBIS) y posiblemente la mejor implementación de enfoque automático a los ojos del mercado.Si Sony continúa innovando como va, Canon va a tener mucho de qué preocuparse en par de años, particularmente después de su anémica EOS-R. Página oficial de la Sony A7 III Fujifilm X-T3  Si el presupuesto solo les llega a US$1,500, no creo que exista una mejor cámara en el mercado que la X-T3. La gran diferencia con la Sony A7 III es que esta tiene un sensor APS-C de menor tamaño, pero super optimizado para fotos y video (el video 4K de esta cámara es sencillamente espectacular). Si el presupuesto solo les llega a US$1,500, no creo que exista una mejor cámara en el mercado que la X-T3. La gran diferencia con la Sony A7 III es que esta tiene un sensor APS-C de menor tamaño, pero super optimizado para fotos y video (el video 4K de esta cámara es sencillamente espectacular).Y reitero que no se dejen llevar por el precio de esta cámara, muchos alegarían que salvo el tamaño del sensor, que la X-T3 en muchos aspectos se siente no solo mejor que la Sony A7 III, sino que cámaras que cuestan 2 o 3 mil dólares más. Esta cámara junto con la A7 III ha sido la gran ganadora de este año en casi todas las listas de fotógrafos como cámaras del año, y en mi opinión ambas han ganado de forma bien justificada. Pocos años hemos visto tanto favoritismo unánime hacia un par de cámaras como en este 2018. Página oficial de la Fujifilm X-T3 Teléfono Inteligente del Año (empate) Apple iPhone XR  El iPhone XR se lleva el premio (por sobre el iPhone XS o XS Mas) porque cuesta muchísimo menos (unos US$300 menos) pero contiene exactamente el mismo procesador (CPU) y chip de gráficos (GPU) interno que sus hermanos, así como exactamente la misma cámara principal (siendo la única diferencia que el XS y XS Max tienen una cámara adicional secundaria para mejorar el tema de zoom y de fondo difuso o bokeh). De paso también contiene el excepcional sistema de reconocimiento facial tridimensional FaceID, con el cual ya no tienes que volver a entrar o recordar claves, o incluso tener que poner el dedo en un sensor biométrico (y de paso, es super-seguro, no permitiendo que una simple fotografía o incluso estatua de tu cara acceda a tus datos). El iPhone XR se lleva el premio (por sobre el iPhone XS o XS Mas) porque cuesta muchísimo menos (unos US$300 menos) pero contiene exactamente el mismo procesador (CPU) y chip de gráficos (GPU) interno que sus hermanos, así como exactamente la misma cámara principal (siendo la única diferencia que el XS y XS Max tienen una cámara adicional secundaria para mejorar el tema de zoom y de fondo difuso o bokeh). De paso también contiene el excepcional sistema de reconocimiento facial tridimensional FaceID, con el cual ya no tienes que volver a entrar o recordar claves, o incluso tener que poner el dedo en un sensor biométrico (y de paso, es super-seguro, no permitiendo que una simple fotografía o incluso estatua de tu cara acceda a tus datos).¿Pero por qué la diferencia en precio entre el XR y los XS/XS Max? Pues porque el XR viene con una pantalla tipo LCD en vez de una OLED. Muchos les dirán que es una gran diferencia, pero en la práctica la pantalla del XR se ve extraordinariamente bien, y solo si se ponen a revisar el contraste de forma minuciosa se percatarán de las diferencias (la excelente pantalla del iPhone 8 por ejemplo es LCD y se ven super, y es de inferior calidad a la del XR, para que tengan una idea). Y si creen que el XR no puede hacer efectos de fotografía de retratos de fondo difuso (con "bokeh") porque tiene una sola cámara, se equivocan, ya que con la tecnología de dual-pixel que incluye e Inteligencia Artificial el XR puede lograr un efecto similar (aunque quizás no tan preciso), de forma parecida como el Google Pixel 3 logra fondos difusos con una sola cámara. Google Pixel 3 Y a propósito, es importante notar que Google se ha dado cuenta de que tiene un reto con respecto al interfaz de usuario de Android, razón por la cual ha decidido diferenciarse por medio de otras cosas, como fotografía computacional y un asistente digital más inteligente. Me gusta por donde va Google en estos aspectos... Página oficial del Google Pixel 3 Juguete del Año Nintendo LABO  Nintendo este año lanzó uno de los juguetes más sorpresivos, divertidos y originales con su sistema LABO. Estos juguetes que vienen en kits en esencia son extensiones a la consola Nintendo Switch fabricadas con cartón y otros componentes, que los niños tienen que literalmente armar, para después conectar el Switch (en una de varias maneras) y "crear" un nuevo tipo de juguete, que puede ser desde un traje de robot hasta un piano (totalmente funcional), o desde una casa interactiva hasta una caña de pescar (con juego incluido para darle uso). Para ver esto en acción, vean este video. Nintendo este año lanzó uno de los juguetes más sorpresivos, divertidos y originales con su sistema LABO. Estos juguetes que vienen en kits en esencia son extensiones a la consola Nintendo Switch fabricadas con cartón y otros componentes, que los niños tienen que literalmente armar, para después conectar el Switch (en una de varias maneras) y "crear" un nuevo tipo de juguete, que puede ser desde un traje de robot hasta un piano (totalmente funcional), o desde una casa interactiva hasta una caña de pescar (con juego incluido para darle uso). Para ver esto en acción, vean este video.Personaje del Año Elon Musk  Este hombre por su cuenta ha decidido reinventar el negocio de las baterías hogareñas, el de los autos eléctricos, el de los vehículos autónomos, el de la Inteligencia Artificial, el de los viajes al espacio, el del transporte bajo tierra, y el de llevarnos a Marte. ¿Realmente necesito decir algo más? Tony Stark le está quedando pequeño (vamos a tener que iniciar una campaña con Marvel para que reemplace los cameos de Stan Lee ahora que ya no está con nosotros). Este hombre por su cuenta ha decidido reinventar el negocio de las baterías hogareñas, el de los autos eléctricos, el de los vehículos autónomos, el de la Inteligencia Artificial, el de los viajes al espacio, el del transporte bajo tierra, y el de llevarnos a Marte. ¿Realmente necesito decir algo más? Tony Stark le está quedando pequeño (vamos a tener que iniciar una campaña con Marvel para que reemplace los cameos de Stan Lee ahora que ya no está con nosotros).Ah, y no dejen de ver un video que hice hace par de años sobre Elon Musk. Lo encontrarán más abajo en el premio que le otorgo a Tesla. Empresa del Año (triple empate) Amazon Esta es en mi opinión la empresa más peligrosa del mundo para competidores que no se adapten e innoven tan rápidamente como este titán en el espacio tecnológico. Tesla  Ante todas las predicciones, Tesla ha cumplido y revolucionado el mercado de vehículos eléctricos. Ante todas las predicciones, Tesla ha cumplido y revolucionado el mercado de vehículos eléctricos.Así como el original iPhone aceleró la llegada de toda una nueva industria, así Elon Musk está acelerando la llegada de toda una nueva generación de vehículos limpios e inteligentes. Y lo ha logrado en contra de innumerables obstáculos legales y logísticos que en buena medida le han creado sus competidores, quienes en vez de estar obstruyendo el progreso sobornando a legisladores deberían mejor ponerse a innovar antes de que Tesla los haga a todos obsoletos. Acá los dejo con un video que hice hace un par de años en donde les explico por qué siempre he confiado en Tesla (tiene mucho que ver con Elon Musk). Netflix Su influencia ha sido tal que ya es el modelo a seguir por competidores como Amazon, Google y Apple, así como el próximo servicios de Disney+ con contenido clásico de Disney, Marvel, Star Wars y PIXAR. Regreso Meritorio del Año Microsoft  Lo mejor que le ocurrió a Microsoft en sus inicios fue Bill Gates (independientemente de sus tácticas un tanto cuestionables), pero lo peor que le ocurrió fue su sucesor Steve Ballmer, quien en vez de adaptar la empresa a los nuevos tiempos lo que hizo fue tratar de defender el duopolio de Windows y Office. Durante su cargo Microsoft obvió por completo tendencias como móviles inteligentes (Ballmer dijo en video que nadie compraría jamás un iPhone por ser tan caro, e incluso organizó un funeral para Apple y el iPhone transmitido por TV nacional), también hizo caso omiso al crecimiento empresarial en la Nube (cediendo el mercado a Amazon), y un sinnúmero de tecnologías que cada día más hacían más obsoleto a Microsoft. Lo mejor que le ocurrió a Microsoft en sus inicios fue Bill Gates (independientemente de sus tácticas un tanto cuestionables), pero lo peor que le ocurrió fue su sucesor Steve Ballmer, quien en vez de adaptar la empresa a los nuevos tiempos lo que hizo fue tratar de defender el duopolio de Windows y Office. Durante su cargo Microsoft obvió por completo tendencias como móviles inteligentes (Ballmer dijo en video que nadie compraría jamás un iPhone por ser tan caro, e incluso organizó un funeral para Apple y el iPhone transmitido por TV nacional), también hizo caso omiso al crecimiento empresarial en la Nube (cediendo el mercado a Amazon), y un sinnúmero de tecnologías que cada día más hacían más obsoleto a Microsoft.Sin embargo el 4 Febrero del 2014 Microsoft eligió un nuevo CEO, a Satya Nadella (acá mis impresiones de ese evento en ese día junto a un poco más de historia y predicciones que al final se hicieron realidad, particularmente este año), y poco a poco todo cambió. Nadella es bueno destacar tenía (o tiene) una tarea muy cuesta arriba, pues Microsoft es un gigante en muchos aspectos con mucha burocracia, pero poco a poco Nadella a conseguido remaniobrar el barco de Microsoft para dejar el énfasis en Windows (que cada vez se hace menos relevante en un mundo móvil dominado por Apple y Google) y enfocarse más en servicios. Bajo Nadella por ejemplo Microsoft ha revivido el mercado de Office ofreciendo versiones por subscripción y versiones especiales de Office en la Nube que han empezado a rendir grandes frutos. Nadella además entró con ambos pies para expandir su estrategia de Azure, que también está creciendo vigorosamente, siendo ahora posiblemente el mayor competidor al Amazon AWS. De paso Nadella decidió ser pragmático y ha acogido a Linux y la comunidad del software libre, haciéndolo aliados y de paso hasta beneficiándose de sus frutos. De forma similar ha forjado todo tipo de pactos y acuerdos con co-petidores como Apple y Google, para traer versiones por subscripción de Office a sus plataformas. ¿El resultado actual? Hace par de semanas (aunque solo durante un par de días) Microsoft superó en valor del mercado a Apple, y ya ha vuelto a competir fuertemente en muchos aspectos con los titanes de la industria. Bajo Nadella Microsoft ha vuelto a despertar, y se ha transformado en un titán de los servicios para consumidores y empresariales, literalmente salvando la empresa para los años venideros, y por eso es para mi el mayor comeback (regreso) que hemos visto en años recientes desde aquella vez cuando Steve Jobs regresó a Apple para sacarla de bancarrota y convertirla en la empresa mas valorada del mundo en tan solo una década. Mis aplausos y respetos a Nadella y al gran talento que yacía oculto en Microsoft. El éxito es totalmente merecido. - Pues ahí tienen mi lista. Y ustedes, ¿qué opinan? Me encantaría leer sus impresiones en los comentarios así como sugerencias para incluir en la lista. Actualización 26 de Dic. 2018: Ingresé a la lista a Nintendo LABO, el cual en el momento que fue anunciado alabé en las redes sociales, y ahora al verlo funcionar me convenzo aun más de su increíble originalidad y visión. autor: josé elías |

|

|

|

|

|

domingo, septiembre 17, 2017

|