|

viernes, enero 20, 2012

|

Cuenta una anécdota que dos personas que naufragaron en una isla se mataron mutuamente por tratar de comerse lo poco que encontraron al llegar a la costa. Asombrosamente, si hubieran caminado apenas 2km en cualquiera de las dos direcciones de la isla hubieran notado que no era una isla desierta y que en realidad estaban salvados en la civilización. Cuenta una anécdota que dos personas que naufragaron en una isla se mataron mutuamente por tratar de comerse lo poco que encontraron al llegar a la costa. Asombrosamente, si hubieran caminado apenas 2km en cualquiera de las dos direcciones de la isla hubieran notado que no era una isla desierta y que en realidad estaban salvados en la civilización.Esa historia no es real (que yo sepa, pues me la acabo de inventar), pero la escribí porque creo que ilustra bastante bien lo que está ocurriendo en la actualidad en el ciberespacio concerniendo los temas de derechos de autor, piratería, derechos de expresión, etc. Creo que nos estamos matando todos innecesariamente, y los culpables son las grandes empresas tradicionales que producen media para el consumo masivo (en particular películas, canciones, libros y aplicaciones), y los legisladores que por lo general no tienen la más remota idea de cómo funciona el Internet y de como los tiempos han cambiado en apenas una década. Pero antes de continuar, veamos el contexto bajo el cual escribo esto... Desde el año pasado (aunque para ser más preciso, pude haber dicho desde hace una década, con el juicio contra Napster) se han venido cocinando una serie de propuestas de leyes con nombres como ACTA, PIPA y SOPA (aprende aquí y aquí sobre estas leyes), las cuales superficialmente planean combatir la piratería, pero que como les expliqué en artículos pasados en eliax, lamentablemente lo que estas leyes lograrán es censurar la libre expresión por Internet. Todo esto ocurre en momentos en la humanidad en que los pueblos se están revelando digitalmente, derrocando gobiernos gracias a redes sociales y organización por Internet, desenmascarando a grandes entidades, despertando a algunos cuantos con respecto a que quizás es hora de cambiar los modelos tradicionales de negocios, y justo ayer el cierre por el FBI de populares portales de compartir archivos (y horas después los hackers de Anonymous cerrando los portales del Departamento de Justicia de los EEUU, la RIAA, la MPAA, y Universal Music). Pero, ¿por qué esta lucha? ¿por qué es que estamos en realidad peleando? En mi humilde opinión, esta guerra tiene tanto sentido como el ejemplo que di al comienzo, en donde si los dos náufragos se hubiesen aventurado a sacrificar un poco y caminar un par de kilómetros, el final fuera feliz para todos. Esto es lo que ocurre... A la fecha, el modelo tradicional de vender media ha sido bastante estable: Una gran empresa obtiene algún talento (digamos, un cantante o un equipo para hacer una película, o el escritor de un libro), paga dinero para que produzcan algo, lo producido se convierte en propiedad intelectual, la empresa vende a intermediarios el producto creado (digamos, las tiendas que venden CDs o las librerías que venden libros), y le pagan unas comisiones a los creadores. Ese más o menos ha sido el modelo de negocio de los medios en los últimos 100 años. Sin embargo, ese modelo tiene graves problemas hoy día, e incluso trae consigo graves problemas que no han podido ser resueltos debido al gran tamaño de estas empresas (que implica muy poco poder para los artistas/creadores, y una gran influencia monetaria para hacer lobbying de leyes). Como ejemplo, ¿sabían que en este modelo tradicional un CD de música que se venda en 16 dólares genera apenas 1 dólar con sesenta centavos para el autor de la obra? Y si creen que eso es asombroso, noten lo que reveló la artista Courtney Love a los medios: Si un CD vende 1 millón de copias, las disqueras se quedan con US$6 Millones de dólares, mientras que cada uno de 4 integrantes de una banda recibe apenas US$30,000 dólares. Y hoy sabemos que existe una salida a ese control de las disqueras: Vender directamente por tiendas como iTunes y hacer promociones por redes sociales y otros medios. Otro ejemplo: ¿Nunca se han preguntado cómo es que un libro digital, cuyo costo de distribución es prácticamente cero, cueste lo mismo que un libro impreso (con todos los costos que eso conlleva)? Por suerte que ya se investiga este caso, pero eso solo ilustra otro de los grandes problemas de estos modelos tradicionales: Quieren seguir cobrando lo mismo que antes, aun sus costos de desarrollo, mercadeo y distribución son mucho menores que antes. Y eso nos lleva a una observación importante: Uno de los grandes problemas es que estas empresas, aun obteniendo más ganancias (debido a costos reducidos de distribución) no quieren compartir esos ahorros con los consumidores finales ofreciéndoles menores precios. Es decir, la balanza la quieren totalmente a favor de ellos, en vez de equilibrarla con el mercado. Así que llegamos a uno de los puntos claves de esta batalla: Precios altos y el querer aferrarse a los mismos (o mayores márgenes que antes). Resultado: Piratería por personas que no están dispuestas a pagar los altos precios. El otro gran problema: Control. Demasiado control. Las empresas que producen media de consumo masivo se han lanzado a una de las estupideces (honestamente, no tengo otra palabra para describirlo) auto-destructivas más ambiciosas que he visto en mi vida: Restringir la distribución de media por "regiones". Me refiero al hecho de que en EEUU lanzan una película, y todos en el resto del mundo sabemos (debido a algo llamado "Internet", que parece que esas empresas desconocen existe) que esa película ha salido y queremos verla. Resultado: Piratería, incluso por personas que estarían totalmente dispuestas a pagar por ver la película. Pero el control no termina ahí: No hay forma de compartir una película, canción o libro con mis familiares (salvo pocas excepciones), al menos que ellos paguen también, y aunque entiendo perfectamente el hecho de pagar por lo que uno consuma, estas empresas deberían tambien entender que compartir es algo intrínseco de la sociedad humana, y que de paso es publicidad gratuita para sus obras. Y no pido mucho: Con el hecho de que me permitan que preste "digitalmente" una película y que yo no la pueda volver a ver hasta que no me la regresen digitalmente, estoy feliz. De esa manera no se abusa el sistema y todos podemos prestar la misma obra tantas veces queramos (y estoy seguro que muchos pagarán por verla si les gusta, o se las recomienda un amigo o familiar). Entonces, ¿cómo salimos de este enrollo? Pues, caminos por la costa en nuestra isla aparentemente deshabitada, y nos daremos cuenta que existe una solución civilizada esperándonos... La solución la escribí hace 5 años, y la generalicé el año pasado, y es bastante sencilla: Simplemente: 1. Bajen los precios a niveles irresistibles a los consumidores. 2. Lancen la obra en todas partes del mundo simultáneamente. 3. Reduzcan el nivel de control para que podamos compartir fácilmente. Eso es todo lo que se necesita para salir de este problema. Implementen eso y la piratería se reducirá a solo aquellos que verdaderamente no puedan pagar nada, o a aquellos sin escrúpulos (que creo son muchísimo menos que los que estas grandes empresas asumen que son), pero sea como sea creo que esto eliminaría el 95% de la piratería, así como aumentaría grandemente el grado de satisfacción de los consumidores. Imaginen por ejemplo comprar canciones a 10 centavos de dólar, o ver una película por Internet por 50 centavos de dólar, o quizás ver un estreno mundial como AVATAR 2 por $2 dólares. Creo que lo que las grandes empresas perderían en ganancia por consumidor, lo equilibrarían por volumen de consumidores, aunque ciertamente las ganancias finales no serán como en los tiempos de antes, esos tiempos ya pasaron (al menos para las grandes empresas, no para los creadores). Y ustedes mis amig@s lectores, ¿qué opinan? autor: josé elías |

|

|

|

|

|

jueves, enero 19, 2012

|

El año pasado les presenté una página que les permitía simular una cámara digital en sus navegadores web para jugar con los parámetros de ISO, Apertura y Velocidad (entre otros). El año pasado les presenté una página que les permitía simular una cámara digital en sus navegadores web para jugar con los parámetros de ISO, Apertura y Velocidad (entre otros).Hoy (y continuando con lo que inadvertidamente de mi parte se ha convertido en una "semana fotográfica" en eliax) les presento esta otra página que a diferencia de esa otra (que requería Adobe Flash), les permite ahora (y con HTML 5) simular algo extremadamente importante: La interrelación entre Apertura, Distancia y Longitud Focal. ¿Cómo nos ayuda esto? Pues una cosa curiosa a la hora de tomar una foto (asumamos, la foto de la cara de un perrito), es que una forma de tomar la foto es acercándonos físicamente al perrito con la cámara y tomar la foto. Pero otra forma de tomar la foto es sentarnos lejos del perrito y con un lente "zoon" acercar la cara del perrito a través del lente (en esencia, "ampliar" la imagen). Pero en ambos de esos casos, aunque la cara del perrito ocupe todo el cuadro de la foto, las imágenes serán bastante diferentes desde el punto de vista geométrico. En el primer caso, la nariz del perro se verá más pronunciada ya que la vemos verdaderamente "de cerquita", mientras que en el segundo caso su cara se verá menos tridimensional. Pues ese tipo de cosas es precisamente lo que este simulador desea demostrar y permitirles experimentar desde la comodidad de sus pantallas... enlace a la página autor: josé elías |

|

|

|

|

|

miércoles, enero 18, 2012

|

|

Hola amig@s lectores, es tiempo para una breve dosis de BREVES en eliax...

1. La repudiada propuesta de ley SOPA, que recientemente aparentaba iba a ser detenida, aparenta que no lo será, ya que se acaba de revelar oficialmente que será resucitada en febrero en el Congreso de los EEUU... Que continúen las protestas... 1. La repudiada propuesta de ley SOPA, que recientemente aparentaba iba a ser detenida, aparenta que no lo será, ya que se acaba de revelar oficialmente que será resucitada en febrero en el Congreso de los EEUU... Que continúen las protestas...2. Se ha revelado que los dispositivos que corran Wndows 8 con procesadores ARM (es decir, tabletas móviles) vendrán con su UEFI (el nuevo BIOS) bloqueado para usuarios finales. ¿Qué significa eso? Que no podremos instalar Linux en tales dispositivos... (este es un buen momento para re-leer este artículo previo en eliax) 3. Acaba de hacerse pública una nueva patente de Apple que indica que la empresa está contemplando una nueva serie de accesorios inteligentes que utilizaríamos con nuestra ropa, en esencia dando una paso más hacia mi predicción #10 para este año 2012... autor: josé elías |

|

|

|

|

|

|

Después de mi muestra fotográfica de ayer los lectores del blog me bombardearon con preguntas que iban desde cuál cámara utilicé hasta cómo empezar desde cero en el mundo de la fotografía. Así que aprovecho la ocasión para darle algunos consejos que me hubieran sido útiles a mi cuando inicié con este hobby... Después de mi muestra fotográfica de ayer los lectores del blog me bombardearon con preguntas que iban desde cuál cámara utilicé hasta cómo empezar desde cero en el mundo de la fotografía. Así que aprovecho la ocasión para darle algunos consejos que me hubieran sido útiles a mi cuando inicié con este hobby...Una buena noticia sobre estas inquietudes es que en eliax ya había escrito un artículo de 3 partes respondiendo la pregunta "Pregunta a eliax: ¿Cómo me inicio en el mundo de la fotografía digital?" en profundidad, por lo que sugiero no dejen de leer ese artículo, ya que les hablo de todo lo concerniente a los aspectos técnicos de cámaras D-SLR, lentes, recomendaciones, etc. Además recomiendo leer este otro artículo técnico que les explica todo sobre ISO, Apertura, Velocidad y f-stops. Así que hoy me quiero concentrar en cosas un poco más prácticas a la hora de tomar una decisión de compra. Inicio con el más importante de todos los consejos que yo o cualquier persona les pueda dar a la hora de ustedes decidirse entrar al hobby de la fotografía (y no se imaginan lo importante que es este consejo): Inviertan su dinero en buenos lentes, y pongan la cámara en segundo plano. Hago esa sugerencia ya que la mayoría de los iniciados a este arte no tienen la menor idea de lo importante que es un lente de buena calidad, y lo poco importante que es una cámara con muchos megapixeles (recomiendo lean sobre el mito de los megapixeles). Para que tengan una idea a lo que me refiero, si en la práctica me dan a elegir entre una cámara de US$1,000 dólares con un lente de US$400, o una cámara de US$400 con un lente de US$1,000, tomaría la segunda oferta sin pensarlo dos veces. ¿Por qué? Pues por un par de razones importantes: 1. Hoy día prácticamente cualquier cámara que compres te ofrecerá una calidad de imagen excelente. Un sensor de cámara básica hoy día es mucho mejor que una cámara profesional de hace 5 años atrás. Para un principiante, la diferencia entre una cámara de US$500 dólares y una de US$5,000 no justifica la diferencia en precio. Una cámara "Pro" por lo general tiene cosas que el principiante rara vez utilizará en su etapa de aprendizaje (como capacidad de tomar muchas fotos por segundo, o fotos en casos de luz pobre extrema). Además, soy de la creencia que si aprendes con una cámara limitada al final serás un mejor fotógrafo, ya que aprenderás a tomar mejor ventaja de cualquier cámara en el futuro. 2. No importante que tan asombrosa sea la cámara que compres, si esta recibe una mala imagen debido a un lente barato entonces terminarás con una mala imagen. Esto no es evidente inicialmente, pero en el momento que compares un lente de US$1000 con uno de US$100, y veas las imágenes lado a lado, entenderás inmediatamente lo que quiero decir. La diferencia en precios en lentes no es arbitraria, un lente más caro por lo general (pero no siempre) ofrece características ópticas que sencillamente no pueden ser replicadas en lentes comunes. Entre esas características están menor distorsión de imagen, colores más reales, mejor contraste, más claridad, y por lo general un mejor rendimiento en condiciones de baja luz. Habiendo dicho esos dos puntos, notemos que hoy día la mayoría de las cámaras que se venden en "kit" (es decir, cámara + lente) vienen con lentes bastante buenos para iniciar, por lo que mi recomendación es iniciar con uno de esos lentes, los cuales te enseñarán no solo lo básico, sino que además la diferencia de imagen entre distintos alcances en mm (el "zoom"). Y hablando de "zoom" el segundo gran consejo que les doy es el siguiente: Si quieren la mejor imagen posible, aprendan a utilizar lentes tipo prime. Un lente prime no es más que un lente "fijo" con el cual no puedes hacer zoom. Es decir, que si quieres abarcar más de la imagen tienes que caminar hacia atrás con la cámara, y si quieres hacer zoom tienes que caminar hacia el objetivo. Eso suena bastante tedioso, pero tiene sus recompensas. Lo primero es que estos lentes por lo general sin más baratos que los zooms, ya que contienen menos elementos ópticos. De paso, y debido a que contienen menos elementos ópticos, eso significa que ofrecen una imagen superior a un lente equivalente con zoom, ya que mientras menos componentes ópticos internos existen en el lente, menos las distorsiones introducidas a la luz que entra a la cámara. Y como bono, estos lentes son también por lo general más ligeros, y auto-enfocan más rápidamente. En otras palabras, si tienen un lente de US$1000 que abarca entre 18mm y 200mm, y lo programan para captar una imagen de 50mm, y tomas una foto y la comparas a la foto tomada con un lente de US$400 de 50mm, es casi seguro que la imagen del segundo lente será mejor en muchos sentidos. Noten antes de continuar que obviamente existen ventajas a los lentes zoom, y que existen lentes zoon con asombrosas características ópticas, pero por lo general a un precio bastante alto. Así mismo es obvio que una cámara de US$5,000 te permitirá hacer cosas que una de US$500 no podrá hacer, pero para el 90% de las cosas que desean hacer con sus cámaras, y para iniciar, recomiendo una cámara básica y un buen lente. Habiendo dicho eso, estas son mis recomendaciones: Como cámara, recomiendo una Canon o Nikon (ambas son excelentes y he comprado y utilizado ambas marcas a través de los años). Hoy día la gran diferencia entre ambas marcas es que Canon es un poco mejor para los que deseen también grabar video, mientras que Nikon en mi opinión se siente mejor como cámara fotográfica en las manos. Una muy buena razón para comprar una de estas dos marcas es que todo el mundo las conoce (y por tanto te pueden ayudar cuando tengas alguna duda), existe una extensa variedad de lentes, y se pueden comprar modelos usados de cámaras a un muy buen precio. Si planean comprar una cámara nueva, estas son buenas opciones (les pongo como referencia el precio de Amazon.com en la actualidad): Canon T2i en "kit" con lente 18-55mm. US$609. (la 2Ti también se vende como la Canon 550D) Canon T3i en "kit" con lente 18-55mm. US$712. (la 3Ti también se vende como la Canon 600D) Nikon D3100 en "kit" con lente 18-55mm. US$600. Nikon D5100 en "kit" con lente 18-55mm. US$800. Desde el punto de vista de usabilidad, la gran diferencia entre los modelos que tondan los US$600 y los que pasan de los US$700 es que los más caros vienen con una pantalla desplegable que hace más fácil componer fotos, pero aparte de eso la calidad es relativamente comparable entre ambos. Si prefieren una usada (que no es mala idea para empezar) pueden buscar en eBay, en páginas de ventas locales en sus países, o en grupos locales de fotógrafos por cámaras de estas marcas, que aunque no sean de estos modelos recientes, muy posiblemente obtendrán algo bueno por alrededor de US$300 a US$400 dólares. En cuanto a lentes, mi recomendación como el primer lente es uno de estos dos (dependiendo de la marca que elijan): Canon 50mm f1.8 II (US$105) Nikon 50mm f1.8D (US$125) Estos lentes de 50mm le permitirán tomar fotos con esos efectos de fondo borrosos que a muchos les gusta (para lograr el efecto, pongan la cámara en modo "Av", es decir "Aperture Priority", y elijan la opción de 1.8 o superior). Además, 50mm es por casualidad la forma en que vemos los humanos con los ojos, por lo que si miras a través del visor de tu cámara con un lente de 50mm, y a la misma vez abres tu otro ojo, notarás que por ambos ojos ves la misma imagen sin zoom ni distorsión). Noten que ambos de esos lentes también vienen en versiones más caras de 50mm y f1.4, y que ofrecen un poco de mejor calidad, y un mejor rendimiento en baja luz, así como son construídos de mejor calidad, pero para empezar los 1.8 son más que suficientes (fue como empecé yo después de pasarme literalmente semanas aprendiendo sobre todos estos temas). Es importante notar que estos lentes que recomiendo son lo mejor que pueden obtener a ese precio, y se venden a ese precio ya que son utilizados como "carnada" por Canon y Nikon para que te entusiasme con este tipos de lentes prime y termines comprando más. Lamentablemente, todos caemos en la trampa y terminamos comprando más lentes... :) Entre los otros lentes que recomiendo están estos... Lentes para tomar fotos en grupos o en lugares relativamente amplios (estos son utilizados mucho por foto-reporteros): Canon 35mm f2 (US$400) Nikon 35mm f1.8G (US$200) Lentes para tomar retratos (como en bodas, modelaje, etc): Canon 85mm f1.8 (US$400) Nikon 85mm f1.8D (US$385) Después de esos, todo dependerá de en qué te quieras especializar. Si deseas fotografiar aves y otros animales, entonces necesitarás un lente zoom de cuando menos 200mm. Si deseas fotografiar insectos entonces necesitarás un lente "macro". Si deseas fotografiar paisajes entonces requerirás de lentes "ultra-wide" ("ultra-anchos") que bajen hasta los 16mm más o menos. Si quieres fotografias eventos deportivos entonces requerirás lentes que recorran desde un "wide" hasta un "zoom" y que además ofrezcan una gran apertura (mínimo f2. pero mejor si es f1.8 o incluso f1.4, y si tienes el dinero f1.2), ya que así podrás fotografiar movimientos bien rápidos y con baja luz. En otras palabras, existen lentes para todo tipo de cosas que desees hacer, y les aseguro que estos lentes son adictivos, pues mientras mejor el lente que compren, más calidad desean (mi más reciente adquisición por ejemplo fue un Canon 35mm f1.4L en US$1,255 dólares - a estos lentes le llaman "rompe-relaciones" y "rompe-presupuestos" por los Así que ahí lo tienen, y los dejo una vez más con el extracto de todo esto: Inviertan en una cámara sencilla, y todo el resto del dinero para uno o dos buenos lentes. Y finalmente dedo repetir una mantra de la fotografía: Un buen equipo fotográfico ayuda, pero la calidad final de las fotos dependerán de tu imaginación y talento... autor: josé elías |

|

|

|

|

|

martes, enero 17, 2012

|

||

Hola amig@s lectores, Hola amig@s lectores,Hoy quiero compartir con ustedes una galería de 24 fotos que tomé hace unos días, cuando por primera vez en mi vida sali solo, con el fin de tomar fotografías (anterior a esto salí una sola vez a tomar fotos, con el grupo fotográfico FOCUS en Santiago, República Dominicana, y agradezco a Emmanuel Bretón por la invitación esa vez). Así que siendo esta mi primera vez, "tómenlo con calma" como dicen por estos rumbos, y se aceptan (y agradecen) todas las críticas constructivas. Por si no lo sabían (para los lectores nuevos), aparte de este blog que es un hobby mio, tengo otros intereses, entre ellos el dibujo, la fotografía (en donde por fin como ven hoy pude sacar un par de días para dedicarle tiempo), y el cine (espero hacer mi primer corto este año que compartiré con ustedes por este mismo medio). Pueden ver las fotos en uno de estos dos lugares: Foto-Experimento 1, en Facebook Foto-Experimento 1, en Google+ Nota: Eventualmente alojaré las fotos en un lugar en donde no se requiera tener una cuenta para verlas (se aceptan recomendaciones sobre cual servicio utilizar, opciones que tengo son Flickr y quizás Picasa). Actualización: Adjunto el album en Picasa/Google+ para el disfrute de todos a continuación (noté que mis álbumes de Google+ son automáticamente compartidos en PicasaWeb - genial)...

autor: josé elías |

||

|

|

||

|

|

||

|

|

Hoy quiero escribir un breve artículo para aquellos que se inician en el mundo de la informática (o incluso para aquellos ya con algunos años de experiencia pero que quizás no sabían del tema), pues es algo que toma mucha importancia a la hora de confeccionarse aplicaciones web para que escalen a miles o millones de usuarios. Hoy quiero escribir un breve artículo para aquellos que se inician en el mundo de la informática (o incluso para aquellos ya con algunos años de experiencia pero que quizás no sabían del tema), pues es algo que toma mucha importancia a la hora de confeccionarse aplicaciones web para que escalen a miles o millones de usuarios.El tema es qué es un Connection Pool en relación a bases de datos. Antes de iniciar debo decir que la técnica de Connection Pools es algo que antes de la Era Web por lo general era conocido solo por unos cuantos expertos en bases de datos que desarrollaban aplicaciones que debían escalar con miles de transacciones por segundo (como por ejemplo, sistemas para manejar Bolsas de Valores, Reservaciones Aéreas, etc). Recordemos que antes de la web la mayoría de los sistemas eran del tipo Cliente-Servidor (y algunos cuantos multi-tier), y por lo general para una cantidad limitada de usuarios en una LAN en donde se tenía un buen control sobre el acceso a dichas aplicaciones, y el tema de demasiadas conexiones a bases de datos no era muy problemático. Sin embargo, con la llegada de la web, cualquier página en Internet está expuesta potencialmente a decenas o cientos de miles de pedidos de usuarios simultáneos, por lo que el tema de Connection Pools toma mucha relevancia. Pero, ¿qué es Connection Pooling y cuál es el problema que resuelve, y cómo lo resuelve? Pues veamos primero el problema... Imaginen que tienen una base de datos a la cual han conectado una página web de ventas de productos, y que de repente la página se vuelve popular y los usuarios empiezan a hacer pedidos en masa. Al inicio todo estará color de rosa, pero eventualmente, conforme aumenta la demanda en la base de datos, llegaremos a un punto bastante conocido por aquellos que programan sistemas web sin conocer este tema: El famoso error de "demasiadas conexiones a la base de datos". El problema es que las bases de datos tiene un gran Talón de Aquiles del cual asombrosamente una gran cantidad de desarrolladores parece desconocer: Crear una conexión es un proceso extremadamente caro (en términos de recursos de hardware) en comparación a hacer simples queries. Ese problema no se hace evidente en la etapa de desarrollo de un sistema ya que por lo general el sistema lo desarrollan un puñado de personas, por lo que el impacto en la base de datos es mínimo. Sin embargo, en el momento que le pedimos a una base de datos (cualquier base de datos) que abra y cierre 1000 conexiones por segundo (o incluso por minuto), nos metemos en graves problemas... Pero existe una solución bastante conocida entre expertos, y es bastante simple y sumamente efectiva, y como podrán adivinar es el tema de Connection Pools, que no es ni una tecnología ni un producto, sino que más bien una técnica, que se implementa en casi cualquier entorno de programación. La idea es la siguiente: En vez de crear y destruir una conexión cada vez que un usuario la solicite, hagamos algo diferente. Vamos a mantener un grupo (o "pool") de conexiones (de ahí el nombre "Connection Pool"), con un número fijo de conexiones siempre abiertas y conectadas a la base de datos. Esas conexiones jamás se cerrarán. Eso de inicio resuelve el problema de uno tener que abrir y cerrar conexiones constantemente y aumenta el rendimiento de la base de datos tremendamente. Pero, ¿y qué pasa si se conectan más personas a la base de datos que el número de conexiones que poseemos? Pues acá entra la segunda parte de la solución que ofrece esta técnica... A simple vista aparentaría que la solución es crear más conexiones, pero eso no resuelve el problema, y al contrario, nos regresa eventualmente al mismo problema de antes, e incluso al largo plazo lo empeoraría ya que utilizaríamos tantos recursos fijos que el CPU, la memoria y el bus del servidor estarían constantemente bajo tensión hasta que la máquina se arrodille y pida piedad. Entonces, lo que se hace en realidad es que ese grupo de conexiones (que por lo general es bajo, pero depende del hardware y software de la aplicación, pero asumamos que son 20 conexiones) se recicla constantemente. Y ese reciclaje es el gran truco de esta técnica, y funciona de esta manera: Cada vez que un usuario entra en sesión con la aplicación, y desea hacer una operación que requiera de un query a la base de datos, lo que ocurre es que un Database Connection Manager (en esencia, un intermediario entre tu código y la base de datos) te presta una conexión. Cuando obtienes tu conexión prestada (en esencia, obtienes una referencia a la conexión), puedes hacer todos los queries que deseas para ese pedido en particular del cliente, pero (y esta es una parte muy importante) en el momento que termines de hacer los queries tu devuelves la conexión al Manager. El Manager en ese momento etiqueta la conexión que le devolviste como "disponible para ser prestada a alguien más", y repite el proceso. En esencia, el Manager vive en un loop infinito prestando conexiones y recibiendo conexiones devueltas, pero (y no olviden esta parte) el Manager nunca cierra esas conexiones o abre nuevas (salvo la excepción de que por diseño del Manager se creen nuevas conexiones dinámicamente para ponerlas en el pool, pero ese ya es otro tema concerniente al diseño de este tipo de objetos). Pero, ¿y por qué funciona esto de tener solo 20 conexiones recicladas mejor que el tener por ejemplo 200 conexiones constantemente abriendo y cerrando? Pues por la sencilla razón de que como les mencioné anteriormente, el abrir y cerrar conexiones es un proceso muy costoso, por lo que en la práctica es mejor reciclar 20 conexiones que abrir y cerrar 200. Sin embargo, esa no es la única razón por la cual este tipo de soluciones se utiliza mucho para escalar. Otra gran ventaja de esta técnica es que no hace que la aplicación se caiga (o que se haga mucho más difícil que caiga). Me explico a continuación... En el modelo tradicional de abrir y cerrar conexiones, en el momento que no existen más conexiones lo que sucede es que si se llega a un límite, la aplicación se tranca ya que no puede seguir más, y vemos los famosos errores de límites de conexiones, pero en el modelo de Connection Pooling, los pedidos se ponen en una cola (en esencia, un Queue tipo FIFO - el primero que entra, sale), lo que significa que si las 20 conexiones están prestadas actualmente que un nuevo pedido de un usuario por la web no causará un error, sino que simplemente una pequeña espera de unos cuantos milisegundos (o quizás algunos segundos) mientras el Manager espera que alguien más le devuelva una conexión para prestártela a ti. Esa espera se puede medir en promedio, y es a propósito una manera para en sistemas en producción uno poder afinar el valor de la cantidad de conexiones en el pool. Algo que es importante también que sepan es que hoy día la mayoría de los entornos modernos de programación (como Java Enterprise Edition, Adobe ColdFusion, el Microsoft .Net, etc) ya hacen esto tras bastidores por ti (hasta cierto punto, siendo ColdFusion quizás el mejor ejemplo en donde uno literalmente no hace nada y todo ocurre transparentemente para el programador), y es esta transparencia la razón por la cual quizás muchos desconozcan el tema, pero es bueno saber siempre lo que ocurre "tras bastidores" pues armados con este conocimiento de hoy ustedes podrán posiblemente diagnosticar en un futuro que el problema de escalabilidad sea tan sencillo como implementar un Connection Pool, o si existe uno el de disminuir o incrementar la cantidad de conexiones fijas. En nota relacionada, este artículo lo escribí debido a mi decepción de que aun con todos estos años, PHP no soporta todavía esta técnica, razón por la cual no es factible utilizarlo "de caja" para aplicaciones que necesiten escalar masivamente. Pero antes de que comenten y digan lo contrario sobre PHP, noten que la modalidad de conexión por pconnection en realidad no es lo mismo que esto, ya que no soporta transacciones ACID debido a una limitación de PHP mismo, por lo que en la práctica solo es útil para hacer lecturas a bases de datos y no escrituras. Así mismo Oracle tiene una manera de implementar Connection Pools con su base de datos, pero es propietaria y requiere modificar el código estándar de PHP para que funcione. Y si preguntan de empresas como Facebook, Google, Yahoo y Amazon que utilizan PHP de alguna forma u otra, estas empresas también debieron romper con la estandarización de PHP para crear sus propias soluciones de Connection Pools y poder hacer escalar a PHP. En cuanto a soluciones NoSQL, lamentablemente aun no existe estandarización, por lo que por ese lado también estamos en el aire con PHP. Mientras tanto sin embargo, prácticamente toda otra plataforma moderna de programación web soporta esta metodología, por lo que no olviden leer al respecto en sus plataformas de programación favoritas y de cómo tomar ventaja de ellas... Actualización: Quiero agregar que esta técnica de reutilizar una conexión en realidad es un patrón de programación más generalizado que el ejemplo de Connection Pools. En términos generales, un Connection Pool sería un sub-conjunto de un "Object Pool". En un Object Pool, uno pre-instancia un grupo de objetos y después con un Object Manager (por lo general, siguiendo el patrón del Singleton) uno toma prestado y devuelve objetos al pool. Esto es tan útil en cualquier dominio como lo es con bases de datos, ya que el instanciar objetos en cualquier lenguaje de programación es también un proceso costoso en términos de recursos de la máquina, mientras que tomar prestado un objeto no es más que pasar un objeto por referencia, que ocurre prácticamente de forma instantánea. Esto es de especial utilidad para desarrolladores de video-juegos, que por lo general tiene código muy compacto y optimizado, y requieren del mayor rendimiento posible. autor: josé elías |

|

|

|

|

|

lunes, enero 16, 2012

|

En lo que sin duda es un gran hito en el espacio de almacenamiento masivo, IBM acaba de lograr almacenar de forma magnética 1 bit de información con tan solo 12 átomos, lo que no solo es un nuevo récord, sino que un salto monumental en la cantidad de espacio que podemos almacenar en una determinada superficie. En lo que sin duda es un gran hito en el espacio de almacenamiento masivo, IBM acaba de lograr almacenar de forma magnética 1 bit de información con tan solo 12 átomos, lo que no solo es un nuevo récord, sino que un salto monumental en la cantidad de espacio que podemos almacenar en una determinada superficie.Noten que en eliax ya le había informado en años pasados sobre técnicas para almacenar información en un solo átomo, incluso de forma cuántica, pero esta es la primera vez que por medios magnéticos (es decir, como se almacena información en discos duros en la actualidad) se puede almacenar información en tan poco espacio. La importancia de este desarrollo es que a diferencia de otras técnicas, esta tiene la posibilidad de hacerse realidad en la práctica en un futuro cercano. Es importante destacar que IBM logró no solo almacenar 1 bit de información (en donde 1 bit contiene o un cero (0) o un uno (1)), sino que incluso pudo juntar varios de ellos para formar no solo un Byte (un conjunto de 8 bits), sino que varios Bytes. En total, IBM demostró como se pudo codificar la palabra "THINK" ("PIENSA") con esta técnica. El gran reto ahora es poder reducir la maquinaria necesaria para lograr esta hazaña, ya que actualmente se utiliza un microscopio de barrido de electrones que ocupa todo un escritorio, y obviamente lo que deseamos es poder tener esto en algo tan pequeño como un celular o menor. Pero les aseguro que los científicos buscarán incesantemente la forma de reducir este tipo de aparatos, pues para que tengan una idea, y según mis cálculos (tomando como base que en 1Kg de átomos de hierro existen 1.08 x 1025 átomos), en un 1Kg (2.2 libras) de hierro se podrían almacenar 900000000000000000000000 bits, que es equivalente a unos 112.5 ZettaBytes (unos 112,500 millones de TeraBytes). 112.5 ZettaBytes, para que tengan una idea, es como tomar todo el contenido jamás creado por la humanidad, incluyendo todo el contenido jamás publicado en Internet, incluyendo todas las películas jamás creadas (y en alta definición), más todas las fotos y todas las canciones y programas de televisión, y ponerlos todos varias veces en la palma de tu mano. Este es un buen momento para que los incrédulos refresquen su mente sobre lo que es La Singularidad Tecnológica... fuente Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, enero 15, 2012

|

Buenas noticias para los ciudadano del mundo. Buenas noticias para los ciudadano del mundo.Este fin de semana la administración del Presidente Barack Obama de los EEUU anunció que vetará la Ley SOPA en su formato actual, por lo que aun si esta pasa en el Congreso la ley no tomará efecto. Según la Administración, la razón principal de vetar la ley es que esta promueve el uso de DNS alternativos que podrían ser peligrosos para la ciudadanía en general, lo que de paso retrasaría la implementación global de DNSSEC (la versión "segura" de DNS). Para los que no sepan, DNS es el protocolo utilizado en el Internet y que traduce las direcciones que escribimos (como "google.com") a las direcciones reales del Internet (por ejemplo, "google.com" tiene la dirección de "74.125.91.147"). En esencia, DNS es el equivalente a un directorio telefónico para el Internet, y es lo que permite que una máquina se comunique con otra cuando un humano escribe un nombre en Internet. Sin embargo, la Administración también indicó que no puede estar de acuerdo con ninguna ley que viole los pilares de los EEUU: Libre Expresión, Privacidad, Seguridad e Innovación. Es importante notar que este anuncio de la Casa Blanca viene poco después de que Lamar Smith, el principal promotor de la ley, anunciara que estaría dispuesto a flexibilizar la ley, removiendo el requerimiento de que se bloqueen páginas web por medio de DNS (es decir, el equivalente a remover el el teléfono de una persona de un directorio telefónico para que nadie los encuentre). Sea como sea, entre ese anuncio de Lamar y el de la Casa Blanca, el Congreso de los EEUU decidió independientemente (sin duda bajo presión de grandes portales como Google, Facebook, Twitter y Amazon, más miles de otros más pequeños como eliax) retrasar su voto sobre la ley SOPA (y su ley prima, PIPA) "hasta que haya consenso sobre dicha ley". Sin embargo, aunque esto es motivo de celebración noten que no podemos todavía bajar los guantes en el cuadrilátero. Pueden estar seguros que si no con una versión modificada de SOPA y PIPA, que será con alguna otra ley que veremos otro intento de pasar leyes similares. Pero por el momento podemos decir el marcador marca lo siguiente: Ciudadanos: 1 Empresarios aferrados a modelos de negocios obsoletos: 0 fuente otra fuente autor: josé elías |

|

|

|

|

|

sábado, enero 14, 2012

|

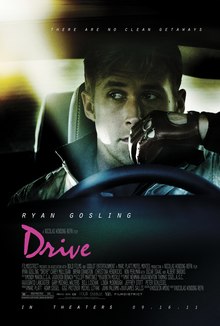

Hay películas o que te las encuentras aburridas o que te fascinan, con poco espacio de por medio. Esta es una de ellas... Hay películas o que te las encuentras aburridas o que te fascinan, con poco espacio de por medio. Esta es una de ellas...Drive es una película no solo para los que aman el cine, sino asemás para los que estudian el cine o hacen cine. Es una película de cineastas para cineastas, y gran ejemplo de película a estudiar en escuelas de cine. La película goza de una ambientación única y muy original, y me trajo recuerdos de películas como Taxi Driver con Robert DeNiro, El Prefesional con Jean Reno, o incluso hasta Scarface con Al Pacino. Es una película con personalidad, y todo aquel que ame películas de directores como Martin Scorcese y Stanley Kubrick quedará fascinado con esta obra. El actor principal, Ryan Gosling, que recientemente vimos en la comedia romántica "Crazy, Stupid, Love", fue elegido perfectamente para el rol, y es difícil imaginarme a otra persona haciendo el papel (solo el James Dean de antaño se me ocurre como posible reemplazo). Este es un actor joven que creo fue elegido para el papel de su vida. Hay que felicitar al director Nicolas Winding Refn por el "look" audio-visual de la película, la cual fue extraordinaria. La ambientación es una de las mejores que he visto en mi vida, y este hombre creo que domina como muy pocos el arte de decir mucho en pocas palabras. Y hablando de pocas palabras, el guión de esta película posiblemente no pasó de 5 o 6 páginas, pues el director nos sorprende con escenas en donde sencillas acciones, gestos y miradas nos dicen más que mil palabras. Como dije, una película digna de estudiarse en cualquier instituto de cine. Otra cosa notable de la película fue la banda sonora. Solo puedo decir que es una de las mejores bandas sonoras que he escuchado en mucho tiempo, recordándome las bandas sonoras de las películas de Quentin Tarantino. Testamento a la brillantés de la banda sonora es el hecho de que estoy seguro que la vasta mayoría de las audiencias de esta película nunca compraría la mayoría de las canciones que aparecen en ella, pero sin embargo estas tienen una manera de encajar tan bien con lo que vemos en pantalla que no podemos hacer más que maravillarnos. La última vez que me gustó tanto una banda sonora fue en Tron Legacy, con las extraordinarias composiciones de Daft Punk. Ley doy 9.5 de 10, aunque les advierto que a muchos no les gustará esta película debido a largas escenas contemplativas que adornan la obra (pero que en mi caso, me parecieron geniales). Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, enero 13, 2012

|

Un problema que nadie niega de la plataforma de celulares inteligentes (y tabletas) Android es la falta de rígida estandarización a la hora de diseñarse los interfaces de usuario (algo en lo que Apple excede), y para contrarrestar esa deficiencia Google recientemente lanzó un nuevo portal al que llama "Android Design". Un problema que nadie niega de la plataforma de celulares inteligentes (y tabletas) Android es la falta de rígida estandarización a la hora de diseñarse los interfaces de usuario (algo en lo que Apple excede), y para contrarrestar esa deficiencia Google recientemente lanzó un nuevo portal al que llama "Android Design".Android Design es un intento de Google de crear algo análogo a los User Interface Guidelines de Apple, pero para la plataforma Android. El portal, el cual creo es una visita totalmente obligatoria para todo desarrollador de Android, expresa reglas y patrones visuales sobre cómo se deben crear aplicaciones visuales en esa plataforma, con el fin de que se vean no solo estéticamente placenteras sino que sobre todo uniformes entre distintas aplicaciones, con la finalidad de hacer más amigable el interfaz Android en relación al iOS de Apple. enlace a Android Design autor: josé elías |

|

|

|

|

|

|

Hola amigo@s lectores de eliax, Hola amigo@s lectores de eliax,El próximo 23 de de este mes en curso este blog cerrará como protesta antes la propuesta de Ley SOPA que se planea pasar en el congreso de los EEUU el día 24. Esta es una ley disfrazada como protección de derechos de autores, pero que en realidad es una arma para quitarnos nuestros derechos de expresión y violar nuestra privacidad a un nivel sin precedentes, y sus implicaciones irán mucho más allá de las fronteras estadounidenses, afectando directamente a prácticamente todos los países del mundo. Para aprender más sobre esta ley por favor leer este artículo y este otro en eliax. Además, aliento a los otros miembros de la comunidad de blogueros del planeta a cerrar sus blogs, páginas y demás portales ese día como señal de que no estamos de acuerdo con tal ley. Recuerden, los derechos humanos no se otorgan. Se ganan. Nota: Es posible que Google, Facebook, Twitter, Amazon y otros también cierren ese día por 24 horas (a confirmarse por cada uno de ellos). autor: josé elías |

|

|

|

|

|

jueves, enero 12, 2012

|

Hoy en Pregunta a eliax respondo la pregunta sobre qué es video en formato "4K", uno de los conceptos quizás más malentendidos en el mundo del video. Hoy en Pregunta a eliax respondo la pregunta sobre qué es video en formato "4K", uno de los conceptos quizás más malentendidos en el mundo del video.Todos estamos familiarizados con el formato DVD, y más recientemente con el formato Blu-ray, los cuales ofrecen resoluciones con nombres que van como "480p", "720p" y "1080p", refiriéndose a la cantidad de lineas horizontales presentes en la imagen. Esta forma de medir resoluciones en número de lineas horizontales (lo que se traduce a la resolución vertical del monitor, pues todas las lineas horizontales cuando se colocan una encima de otras forman un número determinado de puntos verticales) es un vestigio de los antiguos sistemas de televisión NTSC, PAL y SECAM en donde las imágenes se formaban de forma analógica a través de un "cañón" de electrones, que disparaba electrones a la pantalla de izquierda a derecha y de arriba hacia abajo. Sucede que en esos sistemas, y contrario a lo que muchos (incluso expertos) creen, no existía una resolución vertical fija (es decir, no existía un número determinado de "pixeles" de derecha a izquierda en la pantalla), ya que cada linea era formada por el equivalente a un voltaje eléctrico analógico, y no una cantidad cuantizada de puntos. Es por eso que aunque la resolución NTSC podría por ejemplo desplegar 480 lineas horizontales (o más con el modo overscan), lo cierto es que la resolución de izquierda a derecha era variable, en donde mientras más clara era la señal original, mejora la calidad. En teoría con los mejores equipos era incluso posible obtener imágenes con el equivalente a más de 1,000 "puntos" de resolución en esos sistemas analógicos, pero por lo general cuando se "cuantizaban" para mostrar en ciertos monitores o cuando se digitalizaban en PCs, se reducían a 640 pixeles de ancho (o hasta 756 con overscan). Por otro lado, lo que sí estaba fijo era la cantidad de lineas horizontales a desplegar, de modo que el cañón de electrones de dibujaba la imagen lo hacía dibujando lineas de izquierda a derecha, y después bajando a la próxima linea para dibujarla de derecha a izquierda otra vez, y así sucesivamente (en este proceso también había un proceso de video interlazado/entrelazado, pero dejaremos ese detalle fuera pues no importa en este artículo de hoy). Es por eso que desde ese entonces en el mundo de video industrial por lo general se hablan de lineas horizontales. Solo fue con la llegada de imágenes digitales de PCs que se inició a utilizar la media horizontal x vertical (como por ejemplo, 640x480 pixeles en una imagen "VGA" de antaño). Pero, ¿por qué mencionar todo esto? Pues para que entiendan de donde viene la confusión sobre lo que es video "4K"... Sucede que la definición oficial de video 4K es video que tiene al menos 4,000 lineas horizontales, independientemente de la resolución de posibles pixeles por cada linea horizontal. Asó que por ejemplo, un verdadero video 4K tendría una posible resolución de 8000x4000 pixeles. Pero sin embargo, un video de 4000x2000 pixeles no sería video 4K ya que el número de lineas horizontales sería de 2000 lineas y no 4,000. Entran ahora en escena los mercadólogos... Sucede que sin duda por motivos de mercadotecnia (o quizás extrema ignorancia en estos temas, cosa que dudo), algunos fabricantes empezaron a llamar video 4K a video que contuviera al menos el equivalente a 4,000 pixeles por lineas horizontal. En otras palabras, bajo este esquema, una resolución de 4000x2000 pixeles sería "video 4K". Pero los mercadólogos nunca descansan en buscar la manera de confundir al público, e idearon una forma más reciente (y más engañosa) de "video 4K". Sucede que como sabemos, video de HDTV (Alta Definición) es de 1920x1080 pixeles. Pues a algunos genios de la mercadotecnia se les ocurrió llamar "4K" a video que fuera "4 veces" la resolución de HDTV. En otras palabras, si multiplicamos por 2 la resolución HDTV de 1920x1080 pixeles, obtendríamos 3840x2160, y a eso empresas como JVC ya lo están llamando "4K", aun no llegue a las 4,000 lineas ni 4,000 pixeles. Así que en resumen, tenemos 3 formas diferentes de interpretar video 4K: 1. 4K es la cantidad de lineas horizontales en video (es decir, la resolución vertical). 2. 4K es la cantidad de pixeles en una linea horizontal de video. 3. 4K es multiplicar por 4 el formato HDTV. Lamentablemente, cada vez que lean "4K" van a tener que recurrir a las especificaciones técnicas para saber de qué están hablando. Por lo general, cuando se escanean películas al formato digital, se utiliza la primera de estas 3 definiciones, y para proyectarlas la segunda, y aparenta que próximamente en el formato casero se utilizará la tercera definición (hasta que lleguemos a Ultra-HDTV), Así que espero este despeje un poco de misticismo sobre este tema, y de paso sirva como una explicación didáctica sobre un tema del cual les aseguro vamos a oir muchísimo más en los próximos meses/años, pues estamos ya en los inicios de crear el sucesor de HDTV). autor: josé elías |

|

|

|

|

|

miércoles, enero 11, 2012

|

Hoy quiero hablarles de algo que a primera vista aparenta totalmente trivial, pero que como verán, es todo lo contrario y extremadamente interesante. De paso esto les dará un pequeño sabor de lo intrigante que es el mundo al nivel cuántico (es decir, cuando nos adentramos a las millonésimas de un metro y medidas inimaginablemente menores que esas). Hoy quiero hablarles de algo que a primera vista aparenta totalmente trivial, pero que como verán, es todo lo contrario y extremadamente interesante. De paso esto les dará un pequeño sabor de lo intrigante que es el mundo al nivel cuántico (es decir, cuando nos adentramos a las millonésimas de un metro y medidas inimaginablemente menores que esas).Se trata del acto de hacer una medición, como por ejemplo medir la distancia de un objeto de cabeza a pie (aunque todo esto aplica además a medir temperaturas, velocidades, etc). Iniciemos con un ejemplo: Si les preguntara que midieran un lápiz, ¿cómo lo harían? Pues lo más lógico es que tomarían una regla, colocarían el lápiz encima de esta, y notarían en cual raya sobre la regla cae la punta del lápiz. Digamos que midió 10.5cm. Sin embargo, eso no nos daría una medición exacta. Pero como eres inteligente, decides hacer un poco mejor: Buscas un microscopio, y con la ayuda de este puedes notar ahora que el lápiz en realidad aparenta medir 10.525cm. Pero no contento aun, llevas el lápiz a un laboratorio especializado con un microscopio más potentes, y vuelves a medir. Esta vez el lápiz mide 10.525755345cm. Ahora te sientes satisfecho, pero algo que dice que si tuvieras un microscopio aun más potente que pudieras quizás ser más exacto en tu medición. Pero al buscar el microscopio óptico más potente del mundo, notas que aun al obtener la cifra 10.52575534537485958736373849404cm que algo parece estar fuera de lugar... Es en este momento cuando llamas al departamento de ciencias de tu universidad local para que con ayuda de su microscopio de barrido de electrones poder "por fin" medir con exactitud cuánto mide el bendito lápiz. Pero al llevar el lápiz y explicar lo que quieres hacer solo obtienes una sonrisa en retorno de parte del científico a cargo, pues este te dirá simplemente que es imposible saber con exactitud la longitud del lápiz. ¿Por qué? Pues por la sencilla razón de que cuando lleguemos al nivel de los átomos, es imposible saber con exactitud donde empieza un átomo y donde termina otro. Incluso, el largo del lápiz varía constantemente trillones de veces por segundo, por lo que lo mejor que podrás hacer jamás es obtener un resultado promedio. Eso se debe a que los átomos no son objetos "sólidos" como lamentablemente nos enseñan en la escuela secundaria e incluso en muchas universidades. Un átomo es una entidad "nebulosa" en donde sobre el 99.9999999999% de su interior es espacio vacío, y en donde alrededor de su núcleo de protones y neutrones existe una nube de electrones en órbita nebulosa. Pero, vayamos a algo igual de curioso... Ayer por ejemplo les hablé de que hace posiblemente unos 450 millones de años una Hipernova pudo haber sido la causa de la extinción del 60% de la vida marina terrestre en ese entonces, y un lector preguntó en los comentarios si en un futuro no será posible detectar otro posible evento como ese para nosotros poder hacer algo al respecto antes de que las partículas originadas de esa explosión lleguen a la Tierra. Pues sucede que eso es imposible, y una vez más, debido a una curiosa observación sobre medición... Sucede que aunque estamos acostumbrados a por ejemplo ver la luz de un tren a lo lejos, antes de que el tren mismo llegue, que eso no aplica en entornos galácticos con fenómenos relativistas, en donde por "relativistas" me refiero a aquellos que según Einstein son sumamente rápidos (cercanos a la velocidad de la luz) o sumamente masivos (como los Agujeros Negros). En el caso de que una supernova explote en nuestra vecindad, y la explosión apunte directamente hacia nosotros, es imposible nosotros "ver" esa explosión antes de que nos lleguen las partículas de la explosión ya que el acto de "ver" precisamente depende de captar luz con nuestros ojos (o instrumentos especializados). Para ver por qué ese es el caso, noten este ejemplo: Digamos que estás viendo una estrella que sabemos va a explotar próximamente, y digamos que esa estrella está a 1 año luz de distancia (eso significa, la distancia recorrida por un rayo de luz durante todo un año, mientras viaja a unos 300,000 kilómetros por segundo). Si esa estrella explotara en este preciso momento, nosotros no notaríamos absolutamente nada, hasta 1 año después (nota a los que saben de estos temas: estoy consciente que he vuelto el tiempo absoluto momentaneamente, pero lo hago con fines didácticos para explicar el concepto). Eso se debe a que en el momento de la explosión, las partículas emanadas por esa estrella deben viajar por todo un año para alcanzar nuestros ojos en la Tierra, por lo que durante todo un año nosotros solo veremos la estrella como siempre la habíamos visto, pero al cabo de ese año de repente veremos una tremenda explosión en el cielo. Sin embargo, para cuando "vemos" la explosión ya es demasiado tarde para hacer algo al respecto, ya que lo que estamos captando con nuestros ojos es precisamente la radiación que queríamos evitar en primer lugar. En otras palabras, solo detectaríamos la radiación letal de esa explosión justo en el momento que nos llegue a la Tierra... Habiendo dado ese ejemplo, queda otro tema curioso por explicar con respecto a mediciones, y para lo cual regresaremos al tema del lápiz y la medición que hacemos con nuestros ojos. Sucede que nuestro instinto nos engaña al hacernos creer (dada toda la experiencia acumulada haciendo mediciones inexactas durante nuestra vida), que podemos mágicamente "medir" algo con solo verlo. Sin embargo, eso es lo más lejos de la realidad que se pudieran imaginar. Es sencillamente imposible uno poder medir algo con solo verlo, pues si eso fuera posible entonces estuviésemos rompiendo todas las leyes de la física. Lo que sucede en realidad, es que debemos interactuar (y por ende, perturbar) con lo que estamos midiendo. En el caso de medir el lápiz, lo que sucede en realidad es que si tenemos una lámpara en la habitación, esta dispara fotones de luz en todas direcciones (que rebotan por todas partes), algunos de esos fotones chocan contra el lápiz, y rebotan eventualmente entrando a nuestros ojos. En esencia, estamos perturbando el lápiz con fotones para poder saber su posición. Esa es la sencilla razón por la cual si está totalmente oscuro no podemos ver un lápiz, porque obviamente no existen fotones que interactúen con el lápiz. Pero, si son listos me dirán: "Muy bien, está oscuro y no puedo ver el lápiz, pero puedo sentirlo con mis dedos y estimar su tamaño." Una vez más, debieron literalmente tocar el lápiz para medirlo, y la perturbación ocurrió esta vez no con fotones, sino que con los átomos de sus dedos tocando los átomos del lápiz. Esta situación por el momento aunque quizás curiosa, no aparenta tener ningún sentido "profundo", pero veamos qué ocurre cuando nos vamos al extremo: Digamos que tenemos una pared con dos rejillas por las cuales puede pasar exactamente un electrón. Tenemos una pistola de electrones y lo que queremos saber cuando disparamos varios electrones es por cuál de las dos ranuras estos electrones pasan. Sucede que es imposible determinarlo, y la razón tiene que ver con observar y medir. Para ver el problema, imaginemos que mágicamente tu te reduces de tamaño, al tamaño de un átomo, y te colocas al lado de las rejillas para "observar" los electrones que pasan y poder decir con mucha certeza si un electrón determinado pasó por la rejilla A o la B. Pues sucede que la única forma de tu poder "ver" el electrón pasar, es si la imagen del electrón llega a tus ojos, pero esa imagen no llegará a tu ojos al menos que un fotón choque contra el electrón y después ese fotón lleve la información visual a tus ojos. Pero el problema es que en el momento que un fotón (digamos, de una linterna que llevas a mano) choca contra el electrón, que estás ahora interactuando con este, de paso perturbando su trayectoria, por lo que la medición que harás será (1) inexacta y (2) no será la dirección hacia donde posiblemente el electrón se dirigía. Sin embargo, esto se pone más extraño aun... Ese ejemplo que acabo de describir es en realidad quizás el experimento más famoso de la física (llamado en inglés el "Double-Slit Experiment"), y hace 4 años les puse un video acá en eliax que quiero vean ahora mismo, pues podrán entender de manera visual lo asombroso y extraordinario que se pone todo esto... autor: josé elías |

|

|

|

|

|

martes, enero 10, 2012

|

El año pasado escribí un artículo (que recomiendo lean) explicando los problemas de la propuesta de Ley SOPA que posiblemente sea aprobada próximamente en los EEUU y que afectará a todo el mundo, y hoy los dejo con este video que está haciendo las rondas por Internet, y que recomiendo vean. El año pasado escribí un artículo (que recomiendo lean) explicando los problemas de la propuesta de Ley SOPA que posiblemente sea aprobada próximamente en los EEUU y que afectará a todo el mundo, y hoy los dejo con este video que está haciendo las rondas por Internet, y que recomiendo vean.Quiero aclarar antes de que vean el video que independientemente de que no me guste la Ley SOPA, que sí estoy a favor de que las obras intelectuales creadas por autores no sean copiadas sin la autorización de sus creadores. Un ejemplo que doy al respecto es hacer la pregunta: ¿Cómo te sentirías si inviertes 2 años mas los ahorros de tu vida, para hacer una película con la cual deseas hacer dinero (para alimentar tu familia y hacer más películas), para poco después darte cuenta que te la han copiado gratuitamente por todo el Internet antes de que esta pueda ser legalmente comprada por los interesados? Es unas de esas cosas en donde creo hay que estar en los zapatos del otro para entender por qué el copiar no siempre es bueno. Sin embargo, esta ley va demasiado lejos, pues más allá de proteger lo que hará es funcionar como un dictador que censurará prácticamente cualquier tipo de información, dándole demasiado poder a los gobiernos y grandes empresas productoras de contenido, y en esencia quitando todo poder (salvo el poder de compra) de los ciudadanos. Y eso sin mencionar las violaciones de privacidad y libertad de expresión que esto representará... La buena noticia es que pase lo que pase con esta ley, creo que esto abrirá el debate a que los modelos actuales de negocio de distribución de información (sean películas, canciones, libros, programas, ideas, etc) deben ser replanteados. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

|

Gracias a películas como Parque Jurásico, muchas personas conocen la teoría que dice que hace unos 65 millones de años un meteorito de tamaño considerable chocó contra la Tierra y extinguió no solo a los dinosaurios, sino que a gran parte de los grandes mamíferos sobre el planeta. Gracias a películas como Parque Jurásico, muchas personas conocen la teoría que dice que hace unos 65 millones de años un meteorito de tamaño considerable chocó contra la Tierra y extinguió no solo a los dinosaurios, sino que a gran parte de los grandes mamíferos sobre el planeta.Lo que muchos desconocen sin embargo es que hace unos 450 millones de años ocurrió otro evento de similar importancia, cuando "algo" borró de la faz del planeta el 60% de la vida marina, en un momento en nuestra historia en donde la mayoría de los animales complejos vivían bajo el agua. Han incluso habido varias otras destrucciones a gran escala en la historia terrestre, pero esa en particular hasta ahora desafía explicación. Pero ahora, científicos del Instituto Max Plank en Alemania creen poder obtener un poco de evidencia hacia una teoría que explicaría tal catástrofe... El responsable de tal destrucción se cree pudo haber sido una Hipernova, una explosión estelar al menos 100 veces más potente que la de una Supernova. Sin embargo, las probabilidades de que una Hipernova apuntara su explosión justo hacia nuestra vecindad son bastante bajas, pero este grupo de científicos cree poder hacer mediciones con los instrumentos de una sonda europea a ser enviada al espacio en el 2013 llamada la Gaia Star-Mapper, que entre otras cosas medirá los movimientos de cúmulos de estrellas. Sucede, según la teoría, que si se puede calcular las posiciones de cúmulos de estrellas en los últimos mil millones de años, que sería posible entonces encontrar candidatos que en el momento de la extinción masiva acá en la Tierra se encontraban justos en posición como para que una explosión de Hipernova nos llegara. Se cree que la explosión de originó a unos mil años luz, por lo que el trabajo consistirá en buscar cúmulos que se encontraban a más o menos esa distancia hace unos 450 millones de años. Es importante destacar que estas explosiones de Hipernovas son tan potentes, que si una nos alcanzara, bastaría con apenas unos 10 segundos de exposión a nuestra atmósfera para acabar con la mitad de toda nuestra capa de ozono, con efectos devastadores. Sin embargo, más allá de una simple curiosidad, esta noticia en realidad se las comunico para aprovechar que estamos en el 2012, en donde se habla tanto del fin del mundo. Sucede que el mundo no se va a acabar dada una profecía Maya (o de cualquier otra entidad que no haga sus observaciones basadas en evidencia científica), pero de lo que sí tenemos evidencia es que cada cierto tiempo algo proveniente "del cielo" aniquila gran parte de la vida de la Tierra. En unos casos pueden ser grandes meteoritos, en otros casos quizás Supernovas, pero sea lo que sea sabemos que ocurren, y que volverán a ocurrir. O en otras palabras, estamos jugando una ruleta rusa, en donde en cualquier momento, quizás incluso sin previo aviso, toda la vida como la conocemos, desaparezca, y por tanto, quizás en vez de preocuparnos tanto por cosas mundanas como guerras territoriales, chismes y profecías, quizás deberíamos preocuparnos más sobre cómo prevenir catástrofes de esta magnitud, o al menos como sobrevivir a ellas. A tal fin, los invito hoy a leer este artículo previo en eliax, y este otro. autor: josé elías |

|

|

|

|

|

lunes, enero 9, 2012

|

Broadcom, uno de los grandes jugadores en el espacio de chips inalámbricos, acaba de anunciar que tiene listo para fabricantes de equipos de redes inalámbricos una familia de chips que provee WiFi a velocidades de 1Gbps. Broadcom, uno de los grandes jugadores en el espacio de chips inalámbricos, acaba de anunciar que tiene listo para fabricantes de equipos de redes inalámbricos una familia de chips que provee WiFi a velocidades de 1Gbps.El nombre oficial del estándar que soporta estas velocidades es 802.11ac, pero muchos ya lo llaman "WiFi 5G". O en otras palabras, este año posiblemente ya tendremos routers inalámbricos para nuestros hogares con velocidades comparables a las más rápidas redes alambradas disponibles para consumidores (Gigabit Ethernet). Para que tengan una idea, 1Gbps (o 1 Gigabit por segundo) significa 128 MegaBytes por segundo, lo que implica que con esta tecnologia será posible transferir entre una máquina y otra un CD completo de 700MB en unos 6 segundos aproximadamente. nota de prensa oficial autor: josé elías |

|

|

|

|

"[...] Perdona si soy un poco critico, pero creo que es lo que tu quieres realmente, no solo que te demos "coba" sino que realmente seamos sinceros y "criticos constructivamente". Tu blog es tan bueno que muy poco puede mejorar, pero si hay algo en lo que pueda mejorar, yo sere uno de los que te lo pienso decir desde mi humilde opinion claro. Y de nuevo lo digo, Sigue asi Elias porque antes de conocer tu blog tenia otro favorito y desde que conoci el tuyo, Eliax.com es mi blog favorito y JAMAS lo cierro en mi navegador! :) animo!!!"

en camino a la singularidad...

©2005-2024 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax