Internet

|

miércoles, mayo 11, 2011

|

En unas horas es mi charla sobre "La Singularidad Tecnológica y su Futuro Impacto en la Sociedad" por lo que no tengo tiempo de escribir como quisiera hoy sobre los anuncios de hoy en el evento Google IO, pero algo que no puedo dejar pasar es el anuncio sobre Chrome OS hace unos minutos... En unas horas es mi charla sobre "La Singularidad Tecnológica y su Futuro Impacto en la Sociedad" por lo que no tengo tiempo de escribir como quisiera hoy sobre los anuncios de hoy en el evento Google IO, pero algo que no puedo dejar pasar es el anuncio sobre Chrome OS hace unos minutos...Google ha revelado las primeras netbooks con su nuevo sistema operativo Chrome OS, al que llama "Chromebooks". Para más detalles sobre Chrome OS y su evolución hasta salir oficialmente al mercado hoy, los refiero a una serie de artículos que he escrito al respecto y que comparto al final de este artículo en la sección de "Previamente en eliax". Mientras tanto, noten que con estas Chromebooks Google está tratando de abrir un mercado similar a como las netbooks abrieron uno hace uno o dos años, y a como el iPad abrió otro recientemente. La filosofía del Chrome OS es tener un sistema operativo en donde casi todo esté en "la nube de Internet" (en particular, en los servidores de Google), de modo que tus datos los puedas acceder desde cualquier lugar, incluso desde una chromebook prestada en otro lugar. Todas tendrán conectividad WiFi o 3G, y las aplicaciones serán estilo web con HTML5. Los precios de estas chromebooks rondarán entre los US$350 y US$500 dólares (precios bastante razonables en mi opinión), pero habrá que ver cómo afecta esto al mercado actual de las laptops, netboooks y tabletas. Creo que actualmente tablets como el iPad han acaparado toda la atención del público en general, pero sin embargo cuando menos en el sector empresarial puedo verle unos muy buenos usos a estas chromebooks. Eventualmente sin embargo, y como he escrito varias veces en eliax, el futuro será una combinación de ambos: Dispositivos móviles como el iPad y la conveniencia de la nube, en cuyo caso, por el momento el iPad está mejor posicionado para ser exitoso al corto plazo. Pero ya veremos que sucede en los próximos meses... Las primeras dos chrombooks serán de Samsung y Acer, y estarán disponibles en Best Buy y Amazon a partir del 15 de Junio próximo. Ambas tendrán al menos 8 horas de autonomía en la batería, y similar al iPad empezarán a trabajar tan pronto uno las toque (salvo la primera vez que uno las encienda que tomará unos pocos segundos). página oficial de la Chromebook autor: josé elías |

|

|

|

|

|

|

Quizás no sean 100 Terabits por segundo, pero el hecho de que Virgin Media vaya a probar con consumidores Internet a 1.5Gbps, es una buena noticia de todas maneras... Quizás no sean 100 Terabits por segundo, pero el hecho de que Virgin Media vaya a probar con consumidores Internet a 1.5Gbps, es una buena noticia de todas maneras...La empresa, del mismo conglomerado de la linea aérea Virgin, de Virgin Galactic y Virgin Oceanic, planea ofrecer el servicio en modo de pruebas en la parte Este de la ciudad de Londres en Inglaterra, y no solo será la velocidad de bajada de datos a 1.5 Gigabits por segundo, sino que además la subida será a 150Mbps (150 Megabits por segundo), por lo que con esto sería posible que cualquier persona alojara un portal de Internet de alto tráfico en su propia casa. Para que tengan una idea, 1.5Gbps es lo mismo que 1,536Mbps, o 192MBps (lean por qué), lo que es suficiente como para en teoría descargar una película entera de 1GB codificada en DivX en mucho menos de 10 segundos... Y si esta noticia los sorprendió, recordemos que Verizon ya ha realizado pruebas de 10Gbps (10Gbps en subida y 10Gbps en bajada) en los EEUU. fuente oficial autor: josé elías |

|

|

|

|

|

martes, mayo 10, 2011

|

Los rumores se disiparon, las fases de pruebas (betas) se terminaron. Hoy (coincidiendo con el evento Google I|O 2011), Google ya tiene en vivo su servicio de renta de películas a través de YouTube. Los rumores se disiparon, las fases de pruebas (betas) se terminaron. Hoy (coincidiendo con el evento Google I|O 2011), Google ya tiene en vivo su servicio de renta de películas a través de YouTube.El servicio, YouTube Movies arranca con un modesto catálogo de 3,000 películas y el apoyo de NBC Warner Bros, Universal y Sony Pictures, complementando el servicio de YouTube Live recién lanzado. Por el momento hay un par de cosas que gustan y otras que no. Primero, el precio es más o menos aceptable, con películas rentadas por US$2 a US$4 dólares, y todo con la simpleza de YouTube. Así mismo los "extras" que por lo general vienen en los discos DVD y Blu-ray estarán también disponibles en la página de la película dentro de YouTube, lo que es algo verdaderamente bueno. Sin embargo, lo malo por ahora es que algunas películas están restringidas a solo los EEUU inicialmente, y solo se puede acceder o desde una PC o desde una de las cajas de Google TV (de las cuales se han vendido muy pocas hasta el momento). Algo intrigante es que la empresa dice que soportará videos con resoluciones de hasta 4K (un formato que en el caso de YouTube significa videos con resoluciones de 4096 x 2304 pixeles (en el formato ancho de pantalla con proporción de 16:9) o de 4096 x 3072 (en el formato "cudrado" de 4:3), lo que es unas 4 veces más resolución que un disco Blu-ray en 1080p. Sin embargo, por el momento no tienen contenido 4K (y dudo que la vasta mayoría de PCs pueda reproducir video en esa resolución apropiadamente), y al contrario, la mayoría de los videos actuales aparentan ser en resolución SD (Definición Estándar), y no HD (Alta Definición). Pero recuerden, este es apenas un primer paso... Noten además que para demostrar las capacidades de su plataforma, que Google ha hecho disponible varias películas gratuitas, para de esa forma ustedes juzgar la calidad del servicio. Vean esta por ejemplo que funciona fuera de EEUU. Mientras tanto, recuerden que hace poco escribí una trilogía de artículos en donde analizaba la estrategia de Google a largo plazo en el mundo del video, y como está (junto con el resto de la industria) apuntando al futuro de la TV. Esos 3 artículos son bastante recomendados y los pueden leer iniciando con el primero aquí. página oficial de YouTube Movies anuncio oficial de Google autor: josé elías |

|

|

|

|

|

|

Esta sí que es una sorpresa que nadie se esperaba... Esta sí que es una sorpresa que nadie se esperaba...Después de varios meses de rumores que decían que tanto Google como Facebook estaban en una fiera batalla tras bastidores para adquirir a Skype, de repente aparece Microsoft (según el Wall Street Journal), y según fuentes, ofrece nada más ni nada menos que US$8,500 millones de dólares. Según el rumor, el trato ya está hecho, y veremos el anuncio oficial dentro de unas horas. Estén atentos a mi análisis al respecto acá mismo en eliax... ¡Gracias al lector Alejandro Magno por la alerta! Actualización 1: Como reporta CNN, ¡ya es oficial! Actualización 2: Nota de Prensa oficial de Microsoft Actualización 3: Asombrosamente, esta fue mi predicción #18 para este año. Actualización 4: Ya pueden leer mi análisis al respecto aquí. autor: josé elías |

|

|

|

|

|

miércoles, mayo 4, 2011

|

Muchos están bastante contentos hoy día cuando tienen una conexión de 1Mbps, y unos cuantos que tienen 10Mbps dicen estar cerca del paraíso. Así mismo unos muy pocos afortunados pueden disfrutar de hasta 20, 50 o incluso 100Mbps. Pero, que lento es incluso 100Mbps cuando lo comparamos con 100Tbps, que es un millón de veces más rápido y un nuevo récord de velocidad de datos. Muchos están bastante contentos hoy día cuando tienen una conexión de 1Mbps, y unos cuantos que tienen 10Mbps dicen estar cerca del paraíso. Así mismo unos muy pocos afortunados pueden disfrutar de hasta 20, 50 o incluso 100Mbps. Pero, que lento es incluso 100Mbps cuando lo comparamos con 100Tbps, que es un millón de veces más rápido y un nuevo récord de velocidad de datos.El récord, impuesto por dos grupos distintos, ha llegado a romper la barrera de los 100 Terabits por segundo, una cifra que hace incluso apenas 10 años era impensable (muchos en ese entonces creían casi imposible que incluso llegáramos a 1Tbps hoy día). El primer récord, de 101.7Tbps impuesto por científicos de la empresa NEC en Jpaón, fue logrado en una distancia de 165Km, y fue logrado combinando el poder de 370 rayos láser en una sola fibra óptica. El segundo récord, por el Instituto Nacional de Información y Tecnología de las Comunicaciones de Japón, logró 109Tbps. Para que tengan una idea de qué tan rápido es esto, un DVD típico de hoy día contiene unos 5GB de información a groso modo. Con esta tecnología, será posible transferir 2,500 DVDs en un solo segundo. Noten que el tipo de fibra óptica requerido para estos experimentos es todavía bastante difícil de fabricar, por lo que se espera que el primer uso será no en el Internet público, sino que en Intranets de grandes granjas de servidores como las de Google y Facebook. Los consumidores mientras tanto tendremos que conformarnos con Thunderbolt... :) fuente autor: josé elías |

|

|

|

|

|

lunes, abril 25, 2011

|

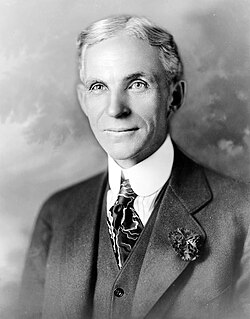

Henry Ford, el mismo fundador de la empresa automotriz Ford, y la mente detrás del automóvil que más influenció el futuro de la industria (el Ford Model T), así como quizás la persona que más popularizó el modelo de planta de ensamblaje en serie (que de paso, fue uno de los grandes propulsores de la industrialización del último siglo), era no solo un brillante pensador, sino que además un genio de los negocios hoy admirado por muchos, y hoy quiero compartir con ustedes una de sus frases célebres que aplica tanto hoy como entonces, y seguirá aplicando en el futuro. Henry Ford, el mismo fundador de la empresa automotriz Ford, y la mente detrás del automóvil que más influenció el futuro de la industria (el Ford Model T), así como quizás la persona que más popularizó el modelo de planta de ensamblaje en serie (que de paso, fue uno de los grandes propulsores de la industrialización del último siglo), era no solo un brillante pensador, sino que además un genio de los negocios hoy admirado por muchos, y hoy quiero compartir con ustedes una de sus frases célebres que aplica tanto hoy como entonces, y seguirá aplicando en el futuro.La frase dice así: "Si le hubiese preguntado a la gente qué deseaba, me hubiesen respondido 'caballos más rápidos'"  Y el contexto de esta frase es en relación a que cuando Ford creó el primer automóvil de fabricación masiva, el medio principal de transporte era el caballo, y la sabiduría detrás de esta frase es que a veces uno no debe hacer lo que los clientes creen que quieren, sino que es necesario tratar de sorprenderlos con cosas que ni siquiera saben que desearían o necesitarían. Y el contexto de esta frase es en relación a que cuando Ford creó el primer automóvil de fabricación masiva, el medio principal de transporte era el caballo, y la sabiduría detrás de esta frase es que a veces uno no debe hacer lo que los clientes creen que quieren, sino que es necesario tratar de sorprenderlos con cosas que ni siquiera saben que desearían o necesitarían.En otras palabras, los verdaderos innovadores son aquellos que van más allá de los deseos de los clientes, y entienden mejor que incluso ellos mismos lo que eventualmente estos desearán. A eso se le llama "innovar". Esto tiene un gran paralelo con uno de los hombres de negocios de la actualidad que más admiro, Steve Jobs, el co-fundador y Gerente General de Apple, quien ha sido una de las muy pocas personas en la historia de la humanidad que ha revolucionado, influenciado y/o reinventado más de una industria en más de una ocasión, y en el caso de Steve Jobs lo ha hecho varias veces.  Inició con la computadora Apple II, que a diferencia de lo que se esperaba en ese entonces (una caja de madera con circuitos expuestos, y a un muy alto costo), era una máquina que venía en un sexy (para ese entonces) contenedor, con un teclado integrado relativamente cómodo, así como con acceso a almacenamiento externo por medio de discos floppy. Para muchos esa fue la primera computadora de bajo costo y fabricación masiva que podía costearse por una familia de clase media en ese entonces. Inició con la computadora Apple II, que a diferencia de lo que se esperaba en ese entonces (una caja de madera con circuitos expuestos, y a un muy alto costo), era una máquina que venía en un sexy (para ese entonces) contenedor, con un teclado integrado relativamente cómodo, así como con acceso a almacenamiento externo por medio de discos floppy. Para muchos esa fue la primera computadora de bajo costo y fabricación masiva que podía costearse por una familia de clase media en ese entonces.Con la Apple II, Apple revolucionó lo que se esperaba de una computadora en esa época.  Poco tiempo después, sin descansar en sus laureles, el mismo Steve Jobs lideró el proyecto que crearía la primera computadora hogareña con un interfaz gráfico, la Macintosh (eso poco después de crear la Apple Lisa, con un sistema similar pero demasiada cara para el mercado). Ese interfaz (el cual era basado en trabajo hecho en Xerox, que a su vez fue inspirado por esta espectacular demostración), fue eventualmente emulado por Microsoft en Windows, y como dicen, el resto es historia. Poco tiempo después, sin descansar en sus laureles, el mismo Steve Jobs lideró el proyecto que crearía la primera computadora hogareña con un interfaz gráfico, la Macintosh (eso poco después de crear la Apple Lisa, con un sistema similar pero demasiada cara para el mercado). Ese interfaz (el cual era basado en trabajo hecho en Xerox, que a su vez fue inspirado por esta espectacular demostración), fue eventualmente emulado por Microsoft en Windows, y como dicen, el resto es historia. Años después, al haber sido despedido de Apple por el mismo Gerente General de Apple que él mismo contrató, Jobs fundó la empresa NeXT, en donde él mismo lideró la creación del sistema de visualización de pantallas orientado a objetos y vectoriales que eventualmente serían la base de muchos sistemas modernos (como el mismo sistema basado en PostScript y PDF de OS X), así como fue quien personalmente impulsó el desarrollo de los sistemas modernos de fuentes ("letras") modernas a computadoras. Antes de esto, texto en pantallas era casi universalmente mono-espaciado, es decir, todas las letras eran del mismo tamaño, pero con este desarrollo se hizo común el traer la versatilidad del texto impreso a pantallas de computadoras. Años después, al haber sido despedido de Apple por el mismo Gerente General de Apple que él mismo contrató, Jobs fundó la empresa NeXT, en donde él mismo lideró la creación del sistema de visualización de pantallas orientado a objetos y vectoriales que eventualmente serían la base de muchos sistemas modernos (como el mismo sistema basado en PostScript y PDF de OS X), así como fue quien personalmente impulsó el desarrollo de los sistemas modernos de fuentes ("letras") modernas a computadoras. Antes de esto, texto en pantallas era casi universalmente mono-espaciado, es decir, todas las letras eran del mismo tamaño, pero con este desarrollo se hizo común el traer la versatilidad del texto impreso a pantallas de computadoras. De paso, el desarrollo del entorno de desarrollo de NeXT-step fue tan avanzado para su tiempo (y noten que la Web y el primer servidor y navegador web fueron desarrollados en un equipo NeXT por Tim Berners Lee), que no solo continuó viviendo en lo que hoy es el entorno de desarrollo para Mac OS X y iOS en iPhone, iPod Touch y iPad, sino que además fue eventualmente emulado en casi todos los entornos de desarrollo de software modernos. De paso, el desarrollo del entorno de desarrollo de NeXT-step fue tan avanzado para su tiempo (y noten que la Web y el primer servidor y navegador web fueron desarrollados en un equipo NeXT por Tim Berners Lee), que no solo continuó viviendo en lo que hoy es el entorno de desarrollo para Mac OS X y iOS en iPhone, iPod Touch y iPad, sino que además fue eventualmente emulado en casi todos los entornos de desarrollo de software modernos. Pero para entonces, Steve Jobs estaba apenas empezando a influenciar el mundo. Poco después de regresar a Apple y simplificar la linea de productos de la empresa con las coloridas iMacs, su próxima gran movida fue la creación el iPod, el cual no solo revolucionó la industria de la música portátil, sino que desterró al popular Walkman de Sony del escenario, conviertiéndose en el reproductor de música #1 de todo el mundo. Pero para entonces, Steve Jobs estaba apenas empezando a influenciar el mundo. Poco después de regresar a Apple y simplificar la linea de productos de la empresa con las coloridas iMacs, su próxima gran movida fue la creación el iPod, el cual no solo revolucionó la industria de la música portátil, sino que desterró al popular Walkman de Sony del escenario, conviertiéndose en el reproductor de música #1 de todo el mundo. Como si fuera poco, poco después lanzó su tienda de música iTunes, lo cual, una vez más, revolucionó el mercado completo de la distribución y venta de música, hoy día siendo la tienda iTunes la tienda de música más grande del mundo, y siendo el modelo a seguir por toda la competencia. Como si fuera poco, poco después lanzó su tienda de música iTunes, lo cual, una vez más, revolucionó el mercado completo de la distribución y venta de música, hoy día siendo la tienda iTunes la tienda de música más grande del mundo, y siendo el modelo a seguir por toda la competencia.Para entonces, muchos dirían que las contribuciones de este hombre ya era casi sobrehumanas, pero una vez, Steve Jobs tenía otra carta bajo la manga: El iPhone.  El iPhone fue un hito en la historia de la comunicación personal, dejando detrás todo un paradigma de "celulares" y popularizando el género de "celulares inteligentes". El iPhone impactó a un nivel tal, que posteriormente casi el 100% de todos los celulares de nueva generación que surgieron (como Android, el Palm Pre con Web OS, el reciente Blackberry Torch, o incluso el Windows Phone 7) son copias casi directas del modelo iPhone. El impacto fue tan profundo, que la única empresa que no siguió los pasos de Apple, Nokia, quien en ese entones era el líder en telefonía celular, hoy día está en estado moribundo tratando de mejorar sus fortunas arrodillándose ante Microsoft y su nueva plataforma móvil. El iPhone fue un hito en la historia de la comunicación personal, dejando detrás todo un paradigma de "celulares" y popularizando el género de "celulares inteligentes". El iPhone impactó a un nivel tal, que posteriormente casi el 100% de todos los celulares de nueva generación que surgieron (como Android, el Palm Pre con Web OS, el reciente Blackberry Torch, o incluso el Windows Phone 7) son copias casi directas del modelo iPhone. El impacto fue tan profundo, que la única empresa que no siguió los pasos de Apple, Nokia, quien en ese entones era el líder en telefonía celular, hoy día está en estado moribundo tratando de mejorar sus fortunas arrodillándose ante Microsoft y su nueva plataforma móvil.Asombrosamente sin embargo, Steve Jobs tenía aun otra movida más... El App Store.  El App Store ha redefinido una vez más lo que los consumidores esperan de sus equipos. Con el App Store (o Tienda de Aplicaciones), desaparece por completo el modelo de uno tener que buscar en tiendas físicas o en distintas páginas de Internet las aplicaciones que uno deseaba. Ahora con el concepto de un App Store se tiene un lugar centralizado para la búsqueda, investigación, compra, descarga, instalación y actualización de aplicaciones, y de una forma segura. Este modelo ha sido tan exitoso, que una vez más, ha sido copiado por Google, Microsoft, Nokia, RIM/Blackberry, HP/Palm, y otros. El App Store ha redefinido una vez más lo que los consumidores esperan de sus equipos. Con el App Store (o Tienda de Aplicaciones), desaparece por completo el modelo de uno tener que buscar en tiendas físicas o en distintas páginas de Internet las aplicaciones que uno deseaba. Ahora con el concepto de un App Store se tiene un lugar centralizado para la búsqueda, investigación, compra, descarga, instalación y actualización de aplicaciones, y de una forma segura. Este modelo ha sido tan exitoso, que una vez más, ha sido copiado por Google, Microsoft, Nokia, RIM/Blackberry, HP/Palm, y otros. Y en la actualidad el iPad (leer mi editorial al respecto) está redefiniendo lo que conocemos como "Computadora Personal", comiendo mercado de las tradicionales PCs, Laptops y Netbooks, e introduciendo a toda una nueva generación de personas a dispositivos electrónicos de fácil acceso y uso. Y en la actualidad el iPad (leer mi editorial al respecto) está redefiniendo lo que conocemos como "Computadora Personal", comiendo mercado de las tradicionales PCs, Laptops y Netbooks, e introduciendo a toda una nueva generación de personas a dispositivos electrónicos de fácil acceso y uso.Pero, ¿seguirá Steve Jobs innovando? ¿hasta dónde puede una empresa innovar antes de que otras continúen su legado? Pues en mi opinión, aun nos faltan cosas por ver de este hombre... Ya existen rumores de que Apple lanzará quizás para finales de este año una plataforma super sencilla de pagos por medio de la tecnología NFC y el iPhone 5, con el propósito de eliminar el papel moneda y la mayoría de las tarjetas de membrecía/afiliciación que cargamos todos en nuestras carteras (razón por la cual sugiero a Apple el nombre de "Apple Wallet" o "Cartera Apple"). Así mismo con tecnologías como AirPlay, Apple se está posicionando en convertir su infraestructura en el centro del entretenimiento hogareño o incluso en nuestros automóviles, por lo que también prestemos atención a ese tema. Y sobre el Apple TV, aun no despega como lo desea la empresa, pero algo me dice que quizás renazca como el ave Fénix, de una forma que explicaré en un artículo futuro en eliax. Mientras tanto, me quito el sombrero simbólicamente ante estas dos mentes. Obviamente no fueron/son seres perfectos, cada uno con sus fallas, pero al final, su legado es indudablemente innegable y han mejorado nuestras vidas en formas que muchos no se pueden ni empezar a imaginar...  Actualización: Quiero agregar, como bien señala el lector GETB en los comentarios, que otra industria que revolucionó Steva Jobs fue la de animación en el cine, al crear la empresa Pixar y llevar los dibujos animados generador en computador a un nuevo nivel, que hoy día han desplazado casi por completo a los dibujos animados tradicionales dibujados a mano. Noten que en el 2006 Disney compró a Pixar, haciendo a Steve Jobs el accionista mayoritario del imperio de Disney, y de sus propiedades como la cadena de televisión ABC. Actualización: Quiero agregar, como bien señala el lector GETB en los comentarios, que otra industria que revolucionó Steva Jobs fue la de animación en el cine, al crear la empresa Pixar y llevar los dibujos animados generador en computador a un nuevo nivel, que hoy día han desplazado casi por completo a los dibujos animados tradicionales dibujados a mano. Noten que en el 2006 Disney compró a Pixar, haciendo a Steve Jobs el accionista mayoritario del imperio de Disney, y de sus propiedades como la cadena de televisión ABC.

autor: josé elías |

|

|

|

|

|

viernes, abril 15, 2011

|

En lo que pueden estar seguros será una tendencia global, el Departamento de Seguridad Nacional (DHS) de los EEUU se está preparando para utilizar a Twitter y Facebook como canales de información de emergencia durante alarmas a nivel nacional o regional, como pueden ser ataques terroristas o catástrofes naturales. En lo que pueden estar seguros será una tendencia global, el Departamento de Seguridad Nacional (DHS) de los EEUU se está preparando para utilizar a Twitter y Facebook como canales de información de emergencia durante alarmas a nivel nacional o regional, como pueden ser ataques terroristas o catástrofes naturales.Esto es un paso más hacia mi idea expuesta en un editorial de hace 2 años llamada el Protocolo_X, en donde expresé que las naciones de todo el mundo deben crear protocolos de todo tipo para lidiar con desastres a gran escala. Algo interesante que muchos desconocen es que poco después del Tsunami que azotó drásticamente a Japón este año, Facebook modificó la versión japonesa de su portal para mantener informados (al tope de su página) a todos los japoneses sobre la situación en el país, los lugares de socorro, informes sobre la situación energética, y otras informaciones críticas en esos momentos, y eso sin duda que encendió una bombilla en la cabeza de muchos legisladores e instituciones encargadas de la seguridad nacional de que herramientas como Facebook y Twitter pueden ser incluso más efectiva que la radio o la TV a la hora de informar a la ciudadanía de eventos como este. Esperen en los próximos años a que gobiernos de otras naciones tomen medidas similares. Yo recientemente propuse a legisladores de al menos el gobierno de República Dominicana que hagan lo mismo, y aliento a ciudadanos y residentes de otros países a hacer propuestas similares con sus naciones (y aclaren que el objetivo de esto es que sea utilizado no como propaganda política, sino que para verdaderas emergencias). fuente autor: josé elías |

|

|

|

|

|

jueves, abril 14, 2011

|

Este es el último de una trilogía de artículos que inició con este artículo en donde opino sobre los US$100 Millones que Google está invirtiendo para crear programas originales que se distribuirán por YouTube, y este otro (que es el corazón del asunto) en donde explico el poder que tiene Google gracias a lo que una vez fue Fibra Oscura. Este es el último de una trilogía de artículos que inició con este artículo en donde opino sobre los US$100 Millones que Google está invirtiendo para crear programas originales que se distribuirán por YouTube, y este otro (que es el corazón del asunto) en donde explico el poder que tiene Google gracias a lo que una vez fue Fibra Oscura.Hoy quiero finalizar con una noticia que después de ustedes haber leído los dos artículos anteriores, podrán entender mejor en todas sus dimensiones. Se trata de que Google oficialmente ha dejado su fase de "experimentos" con video en tiempo real y en vivo por YouTube, y ha entrado a una nueva fase en donde estas transmisiones en tiempo real serán una parte permanente de YouTube (que pueden acceder en YouTube Live). Esta es una movida bastante significativa puesto que uno de los argumentos que las empresas de televisión tradicional utilizan para justifica que sobrevivirán al Internet es siempre mencionar el tema de los "programas en vivo". Pues ahora Google clava otro clavo al ataúd de este mercado, permitiendo de ahora en adelante la transmisión en vivo y las 24 horas de todo tipo de eventos por YouTube (fuente). Pero tan importante como eso es que similar a uStream TV, Google ha dejado claro (por medio de herramientas en estado "beta" o de pruebas) que además ofrecerá la capacidad de que cualquiera grabe lo que desee y lo difunda en vivo por todo el Internet a través de YouTube y del inmenso ancho de banda disponible a Google del cual les hablé ayer. Esto a propósito fue una de mis predicciones para el 2010 (lean la #4), la cual aunque no se hizo 100% realidad el año pasado ciertamente se está haciendo completa realidad en este 2011. Así que si estás en el negocio de la TV esta noticia la puedes ver de dos maneras diferentes: 1. Con mucho miedo y preocupación (o con poca visión y descartando esta noticia), y siguiendo defendiendo el modelo de negocio tradicional de tu empresa, y cruzando los dedos y esperando que tu canal de TV esté vivo dentro de 10 años más. 2. Con emoción y viendo una gran oportunidad, para reinventar tu empresa en una cuyo contenido gire a programas de alta calidad, y abiertos a un público muchísimo más amplio que el tradicional. Lamentablemente, y como generalmente sucede con estas olas tecnológicas, el 80 al 90% de los empresarios caerán en el primer renglón, y solo unos pocos visionarios verán las oportunidades que presenta el nuevo modelo del Futuro de la TV... Actualización: He aquí la primera y segunda parte de esta trilogía de artículos. autor: josé elías |

|

|

|

|

|

miércoles, abril 13, 2011

|

Ayer les ofrecí mi opinión sobre el significado de que Google esté invirtiendo US$100 Millones de dólares en contenido original para YouTube, y finalicé el artículo dejándolos con una incógnita: ¿Qué tiene Google que otras empresas no tienen que permitirá que tenga una muy buena oportunidad de ser uno de los titanes del futuro de la TV? Ayer les ofrecí mi opinión sobre el significado de que Google esté invirtiendo US$100 Millones de dólares en contenido original para YouTube, y finalicé el artículo dejándolos con una incógnita: ¿Qué tiene Google que otras empresas no tienen que permitirá que tenga una muy buena oportunidad de ser uno de los titanes del futuro de la TV?La respuesta se las ofrezco hoy: Ancho de banda. Y noten que no hablo de simple ancho de banda como lo conocemos tradicionalmente, en donde una empresa conpra ancho de banda de otra. hablo de una estrategia que gracias a su CEO de entonces, Eric Schmidt, ha hecho que Google hoy valga muchísimo más de lo que aparente a simple vista... Específicamente, hablo de algo de lo cual les hablé hace 4 años, en este sencillo artículo, en una noticia que en ese entonces prácticamente nadie le hizo caso, pero que a mi me llamó muchísimo la atención: Google se ha convertido, bajo las narices de todo el mundo, en uno de los más grandes propietarios de fibra óptica del mundo (sino el más grande de todos). Pero, ¿y cómo sucedió eso? Pues como expliqué en ese artículo del 2007, Google vio una tremenda oportunidad en medio de la adversidad (como hubiera dicho Einstein) en el momento que explotó la burbuja de Internet a finales de los 1990s, en donde decenas de miles de empresas quebraron de la noche a la mañana por estar sobrevaloradas. Sucede que muchas de esas empresas eran empresas de telecomunicaciones, y por tanto cuando se fueron en picada Google inteligentemente decidió comprar su infraestructura a precios casi por el suelo. Específicamente lo que compraron fue lo denominado "dark fiber" o "fibras oscuras", cables de fibras ópticas sin uso (de ahí el nombre de "fibras oscuras", ya que estaban "apagadas, sin luz"), que conectaban a centenares de estas empresas con otras, así como a través de los principales backbones (autopistas principales de Internet) de la red. En otras palabras, como les expliqué en ese entonces, Google es para sorpresa de muchos (incluso para expertos en esta área de redes) uno de los principales dueños de la infraestructura del Internet, principalmente (pero no exclusivo) en los EEUU que es precisamente el principal mercado del video por Internet en estos momentos. Y eso, le trae a Google unos beneficios interesantes... Para empezar, esta es la razón primaria por la cual solo una empresa como Google podría haber comprado a YouTube en el 2006, pues aunque el precio pareciera alto (US$1,600 millones de dólares), lo cierto es que todo el mundo sabía que el verdadero costo vendría en costos posteriores de ancho de banda. Para que tengan una idea, 3 años después de la compra, en el 2009, YouTube ya servía 1,000 millones de videos diariamente, y hoy en el 2011 es posible que esa cifra sea una orden de magnitud superior. La única manera de una empresa poder llegar a ese nivel de escalabilidad es con su propia infraestructura, pues un servicio gratuito como YouTube no se iba a sostener por varios años con los inmensos costos que eso hubiera significado para cualquier otra empresa (y noten que apenas en meses recientes YouTube ha empezado a generar dinero para Google de forma significativa). Y toda esa introducción nos lleva al artículo de hoy... Alguien como Facebook ciertamente podría utilizar el poder de su red social para combinar exactamente los gustos de sus usuarios (los cuales felizmente le dicen a Facebook las películas que les gustan, el tipo de comida que prefieren, la música que escuchan, sus lugares favoritos, etc), con la de sus anunciantes, pero esto funciona solo hasta un límite. Llega un límite en donde cuando Facebook llegue a videos, se enfrentará con la realidad que toda otra empresa, salvo Google, deberá enfrentarse: ¿cómo pagar por todo el ancho de banda requerido por video en Internet? Para que tengan una idea de lo que hablamos, una página web típica como la de Facebook con varias fotografías ocupa alrededor de 1MB de espacio. Pero un solo video de YouTube puede fácilmente ocupar entre 10 y 100MB, lo que significa que le costaría a Facebook unas 10 a 100 veces más caro implementar una estrategia con videos, en relación a Google (quien ya tiene acuerdos con varios de los proveedores principales de Internet del mundo para compartir su fibra óptica). Y la única manera de competir contra Google sería entonces incrementando los precios de los anuncios, o cobrándole a los usuarios, y he ahí la ventaja de Google: Google puede ofrecer un servicio similar de videos a cualquier otro competidor a un precio al menos una orden de magnitud menor, simplemente por el hecho de que su ancho de banda en gran medida es un costo marginal. Es por eso que empresas como Netflix son las que han podido competir efectivamente contra YouTube, ya que (1) Netflix tiene un mercado nicho en el negocio de rentas de películas por Internet y (2) Netflix puede pagar ese ancho de banda ya que debido al servicio que ofrece sus usuarios son los que pagan por el ancho de banda (pagando a Netflix unos US$8 dólares mensuales, en el plan básico). Sin embargo, en el momento que Google empiece a crear contenido original, y ofrecerlo a un costo sumamente bajo, o incluso gratis, los anunciantes se alinearán en fila india para apoyar el servicio de Google. Noten que esto no significa que competidores como Facebook o Apple no podrán competir efectivamente contra Google, sino que tendrán que recurrir a otros modelos más dramáticos para poder competir mejor. Y lo mismo aplica no solo para video, sino que para cualquier servicio de cualquier tipo que cualquier empresa desee proveer por Internet. Como dijo alguien una vez en, es difícil competir contra "gratis"... Nota: Y mañana les tengo otra noticia más sobre este tema, en lo que será el final de esta trilogía de artículos sobre Google y videos por Internet... Actualización: He aquí la primera y tercera parte de esta trilogía de artículos. autor: josé elías |

|

|

|

|

|

lunes, abril 4, 2011

|

En un artículo reciente en eliax escribí un comentario en donde explicaba que no nos engañemos pensando que dispositivos móviles como el iPad o celulares iPhone/Android no serán capaces de manejar la dura carga de programas de procesos intensos que programas como Photoshop requieren, ya que existe una solución justo en el horizonte, y de eso se trata este artículo de hoy... En un artículo reciente en eliax escribí un comentario en donde explicaba que no nos engañemos pensando que dispositivos móviles como el iPad o celulares iPhone/Android no serán capaces de manejar la dura carga de programas de procesos intensos que programas como Photoshop requieren, ya que existe una solución justo en el horizonte, y de eso se trata este artículo de hoy...Desde los inicios de la computación ha existido un concepto de "procesamiento distribuído", lo cual en palabras sencillas no es más que tomar una tarea de trabajo de algún software, y distribuir su carga entre dos o más entidades. Sin embargo, salvo ciertas excepciones bastante particulares, ese tema nunca ha sentado pie en el mercado de consumidores, y mi propuesta de hoy es decir que no falta mucho para que eso suceda, y en grande... Algunos técnicos tratarán de corregirme diciendo que procesamiento distribuído ya existe, dentro de los CPUs y GPUs de nuestras PCs (e incluso celulares y el mismo iPad), en donde un procesador tiene ya varios núcleos y la carga es distribuída entre estos. Incluso está el caso en servidores más potentes y en super-computadoras en donde se utilizan no solo núcleos, sino que decenas, centenares o miles de procesadores para entre todos atacar un problema en particular. Pero no estoy hablando de eso. Estoy hablando a un nuevo paradigma de lo cual o nadie aun sea ha percatado que ya prácticamente poseemos la tecnología para hacerlo, o simplemente lo mantienen en secreto hasta tanto lo perfeccionen, y la mejor manera de explicarlo es con un escenario... Imaginen que tenemos un futuro descendiente del iPad en nuestras manos, y que arrancamos la aplicación Photoshop en esta. Imaginen además que estamos cómodamente sentados en nuestra oficina en casa. Imaginen ahora que abrimos una imagen inmensa dentro de Photoshop, y que deseamos aplicar un filtro que requiere bastante procesamiento bruto. En este punto, tenemos dos opciones: 1. Opción 1, la manera tradicional: El usuario debe esperar hasta tanto el filtro complete su trabajo, sea un par de segundos o incluso minutos. 2. Opción 2, de lo que se trata este artículo: Distribuir la carga a dispositivos cercanos vía conexiones inalámbricas (o alambradas de ultra-alta velocidad). Con la opción #2, el iPad (o cualquier otro dispositivo de otra empresa) detectaría que en tu casa tienes un Apple TV, un iPod Touch, un iPhone y una MacBook Air, a los cuáles previamente habías autorizado para que interactúen con tu iPad, por lo que el iPad decide que necesita más ciclos de CPU para terminar la tarea más rápidamente, así que toma el software de Photoshop y distribuye la carga automáticamente de forma paralela en todos esos dispositivos, de modo que ahora no es solo el iPad el que ejecuta el filtro de Photoshop, sino que todos los dispositivos en tu hogar, terminando el filtro su trabajo en 1 segundo en vez de 1 minuto, de paso ofreciendo muchísima más velocidad que la versión de Photoshop que utilizamos hoy día en el hardware más potente que podamos imaginar. Pero, ¿y cómo funciona esto y cuál es la magia o ingrediente secreto necesario para que esto funcione? Pues lo primero, es que se necesita una plataforma estandarizada que permita que código se pueda enviar entre un nodo y otro de la red, y que sea ejecutable de forma transparente y sin problemas de compatibilidad, y da la casualidad que una empresa ha estado forjando una estrategia para hacer exactamente esto desde hace un par de años: Apple (aunque ya veremos más adelante quien más podría ofrecer algo similar). Noten que hoy día un Apple TV, un iPod Touch, un iPhone y un iPad tienen todos el mismo hardware en su núcleo, y el mismo sistema operativo, tal cual predije hace 4 años sucedería, con la diferencia de que en ese entonces yo lo llamaba "OS X Mini" y ahora Apple lo llama "iOS". Con iOS, y su primo OS X (los cuales se fusionarán en algo que llamo "iOS X", como predije el año pasado), Apple está en la envidiable posición de tener un sistema operativo escalable desde un mini reproductor de audio como el iPod Nano, hasta una super-computadora, utilizando el mismo hardware y software de base en todos estos. Hablamos de un "enjambre" de iOS, en donde cualquiera de ellos podría tomar ventaja del poder de computación de todos los demás en la cercanía. Incluso me puedo imaginar a Apple vendiendo cajitas similares al AppleTV para este fin, a US$99 dólares, que se venderían por millones a una población de consumidores hogareños y profesionales que desean más velocidad cada vez más. El otro ingrediente necesario es un arquitectura de intercomunicación de alta velocidad, sea inalámbrica o alambrada. La versión alambrada ya no tiene que esperar, pues está aquí y se llama Thunderbolt, y curiosamente fue ideada por Apple y desarrollada por Intel, que ofrece velocidades (en su implementación actual en la MacBook Pro) de 20Gbps de ancho de banda agregado, lo que es mucho más que suficiente para implementar el escenario que propongo. Por otro lado, ya existe un estándar en proceso para el 2012 de WiFi a 1Gbps, así como ya se está experimentando con otras tecnologías inalámbricas de más corto alcance y con velocidades de hasta 15Gbps, por lo que lo mismo que podremos hacer de forma alambrada se podrá de forma inalámbrica próximamente (aunque recuerden que incluso 1Gbps es suficiente para este escenario). Y el tercer ingrediente es una plataforma de software sobre la cual los programadores escribirían sus aplicaciones para que estas escalen natural y automáticamente para tomar ventaja de periféricos cercanos (o incluso lejanos con lineas de Internet de alta velocidad y de baja latencia) y distribuir sus cargas de trabajo. Una vez más, Apple ha estado desarrollando esa tecnología bajo las narices de todo el mundo, y se llama Grand Central Dispatch (GCD), una tecnología que ha sido parte de OS X desde hace un par de años, y que en la superficie aparenta ser una herramienta para el uso de multi-núcleos, pero algo me dice que Apple tiene planes muchos más extensos para GCD, posiblemente alineados a mis predicciones en este artículo. Ahora, algunas personas no-técnicas es posible que estén incrédulos ante la posibilidad de que esto se haga realidad a corto plazo, pero lo cierto es que desde hace años en el sector profesional existen decenas de herramientas que hacen esto, solo que de forma propietaria a un software en particular. Por ejemplo, existe un concepto llamado un "render farm" (o "granja de renderizadores") que se utiliza muchísimo en software de renderización de 3D, en donde uno instala varias copias de un software especializado en varios servidores, y la carga de renderización se distribuye entre todos los nodos. Esto incluso existe en programas de edición de video no-lineal (como Final Cut Pro), así como para programas de edición de imágenes, arquitectura, etc. Sin embargo, esos son casos aislados, y cada uno de esos render farms son especializados a un software en particular, en vez de ser soluciones genéricas. Noten que eso no significa que no existan soluciones genéricas, sino que las genéricas no han tomado tracción por varias limitaciones (como la falta de plataformas estandarizadas, etc). Sin embargo, más allá de Apple hay una empresa que puede hacer algo similar, y esa es Google. Sucede que una de mis tecnologías favoritas de todos los tiempos, llamada Jini, fue creada para resolver específicamente este escenario del cual hablo hoy, pero Jini lamentablemente fue un caso más de una solución en busca a un problema demasiado temprano. Jini estuvo al menos una década adelantada a su tiempo (y a propósito, si eres un arquitecto de software, recomiendo no solo que aprendas sobre Jini, sino que sobre su tecnología hermana, JavaSpaces, que quizás sea una de las piezas de software más elegantes y sencillas que he visto en mi vida). Pero he aquí lo interesante: Jini tiene sus raíces en el mismo corazón de los desarrolladores originales de Java, y hace apenas unos días (como reporté por Twitter) que "El Padre de Java", James Gosling, dejó a Oracle/Sun para irse a Google, cosa que muchos se preguntaban para qué. Pues como podrán ver ahora, yo ya tengo una muy buena idea... La plataforma Android OS de Google es en realidad una plataforma mayoritariamente Java (Linux solo ofrece servicios de bajo nivel y es en teoría incluso reemplazable sin afectar la funcionalidad de los niveles superiores del Android OS), y ya me puedo imaginar algo similar a Jini en una futura versión del Android OS, el cual de forma similar al iOS de Apple, fue diseñado para al menos en su núcleo funcionar desde en celulares hasta en televisores y servidores. Así que imaginen a Google ofreciendo un estándar abierto en donde cualquier empresa pueda fabricar y/o ofertar una "caja de computación" similar al Apple TV pero para estos fines. Sería fenomenal... Así que en mi opinión, tras bastidores, lo sepan o no estas dos empresas, ambas se encaminan rápidamente hacia lo que será una nueva batalla titánica por nuestros dispositivos en el hogar y en nuestros negocios. Y no puedo hablar por ustedes, pero esto me emociona muchísimo y no puedo esperar a ver el día en que veamos anuncios de estas dos (u otras) empresas sobre estos escenarios. No lo duden, estamos viviendo los tiempos más emocionantes de la humanidad... Nota a técnicos: Jini a evolucionado a convertirse en Apache River. También visiten la página oficial de Jini, y la especificación oficial de JavaSpaces. autor: josé elías |

|

|

|

|

|

miércoles, marzo 30, 2011

|

Desde mediados del año pasado les he reportado rumores de algo llamado "Google +1" (o "Google Me", que quizás resulte ser otra cosa eventualmente) y que muchos asumimos sería el competidor de Facebook por parte de Google, sin embargo, Google acaba de anunciar hoy a Google +1 y por el momento es algo muchísimo más modesto. Desde mediados del año pasado les he reportado rumores de algo llamado "Google +1" (o "Google Me", que quizás resulte ser otra cosa eventualmente) y que muchos asumimos sería el competidor de Facebook por parte de Google, sin embargo, Google acaba de anunciar hoy a Google +1 y por el momento es algo muchísimo más modesto.Google +1, independientemente de como Google lo describa, no es más que un clon del botón de "Like" (o "Me gusta") que vemos dentro y fuera de Facebook en todo el Internet (incluso al pie de cada noticia de eliax), en donde el objetivo es marcar algo como que "te gusta" de modo que tus amigos/contactos estén al tanto de "las cosas buenas" de la web. Sin embargo, inicialmente estos botones de +1 solo los veremos en los resultados de búsquedas del buscador Google, y no lo veremos todavía en páginas de terceros (lo que significa que por el momento aun no lo verán al pie de las noticias de eliax). En otras palabras, Google planea tomarse su tiempo con Google +1, posiblemente sentando las bases para un asalto más grande en el futuro en el área de redes sociales, en donde el gran titán hoy día es Facebook, con Twitter siendo el segundo portal más importante. Según Google, veremos próximamente los botones de +1 no solo en los resultados de búsquedas, sino que también en los anuncios de Google, y aunque inicialmente Google alega que esto no afectará los algoritmos actuales de su buscador y de su sistema de anuncios AdSense, es obvio que ese es parte del propósito de esto al largo plazo. El Google +1 será público para todos en unos meses, pero pueden activarlo desde ya de forma "experimental" yendo a este enlace especial en Google y haciendo clic en el botón que dice "Join this experiment" ("Unirme a este experimento"). Notarán que amigos de sus contactos de Google es posible que aparezcan en algunas páginas que visiten, si ellos las marcaron como +1. Por el momento para probar únanse al experimento, vayan al buscador Google, y busquen por "eliax", y después hagan clic en el botón de +1 que aparece junto a los resultados... ;) Página oficial de Google +1 fuente oficial Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, marzo 29, 2011

|

Amazon acaba de lanzar (y he estado probando) un par de nuevos servicios llamados Amazon Cloud Drive y Amazon Cloud Player, y les aseguro que querrán leer sobre lo que son, pues este es parte de nuestro futuro en la red... Amazon acaba de lanzar (y he estado probando) un par de nuevos servicios llamados Amazon Cloud Drive y Amazon Cloud Player, y les aseguro que querrán leer sobre lo que son, pues este es parte de nuestro futuro en la red...Es posible que en al menos en los últimos 12 a 18 meses han estado escuchando mucho frases como "la nube de Internet", una tendencia tecnológica que tras bastidores se ha estado cocinando por años entre los grandes titanes del mercado, y la tecnología ya está a un nivel que este año hará realidad muchas de sus promesas. En forma sencilla, Almacenamiento en la Nube se refiere al acto de uno almacenar sus datos en servidores remotos (como en este caso, de Amazon) para acceder a esos datos en casi-tiempo-real por Internet desde cualquier terminal (sea un navegador web o un dispositivo móvil). También existe Computación en la Nube que es un concepto más fácilmente reconocible como lo que hace Google Docs. Esto no es algo nuevo, y muchas empresas lo han intentado antes (un buen ejemplo es el Microsoft Live SkyDrive), sin embargo apenas el ancho de banda se esta haciendo universalmente asequible en el mundo, y las plataformas se están tornando cada vez más móviles, así como cada vez estamos más tiempo conectados a Internet, para que se den las condiciones de que esta tecnología por fin reluzca. Amazon sin duda que apresuró esto al mercado (ya les mencionaré en un momento los pequeños problemas que he encontrado), pero creo que hizo lo correcto en salir "con algo" al mercado para captar tanta atención y mercado como le sea posible al corto plazo, puesto que según rumores este mismo año, en cualquier momento, tanto Apple (a través de su servicio MobileMe) como Google (inicialmente con Google Music) sacarán algo similar. Amazon a delineado claramente dos tipos de servicios en su estrategia de nube, uno llamado Cloud Drive (para almacenamiento en la nube) y otro Cloud Player (para reproducir media, por el momento solo canciones mp3). Amazon ofrece ambos servicios completamente gratis, con la única limitante de que el Cloud Drive ofrece un límite de 5GB de información (básicamente el equivalente a la cantidad de datos que cabe en un DVD de datos sencillo), pero tienen ahora una oferta en donde si compras un album de canciones digitales mp3 obtienes por un año una cuenta de 20GB de espacio (después de ese año tendrás que subscribirte a un plan anual si deseas continuar con los 20GB). Para los que necesiten más espacio, Amazon ofrece planes con estos precios: 20GB por US$20 dólares al año, 50GB/US$50/año, 100GB/US$100/año, 200GB/US$200/año, 500GB/US$500/año, 1000GB/US$1000/año. O en otras palabras, Amazon ha puesto un precio de US$1 dólar por GB de información almacenada (lo que me encuentro un poco caro cuando se desea mucho más de 20GB, pero esos precios seguro que disminuirán eventualmente). El otro componente es el Cloud Player, que es el reproductor mp3, y el que permite que desde cualquier PC que tenga una navegador web, o incluso desde un celular con tecnología Android (que probaré próximamente) puedas escuchar tus canciones por Internet. Es decir, con el Amazon Cloud Player simplemente entras a tu cuenta de Amazon con tu PC o Android, y ves inmediatamente los nombres de las canciones que hayas subido a la nube de Amazon, en donde puedes elegir cualquier canción para escuchar, y esta inicia a reproducir en aproximadamente un par de segundos, lo que es sencillamente genial, ya que ahora utilizas tu conexión de Internet en vez de tu almacenamiento local para acceder a tu media. Noten sin embargo que siendo este un servicio más o menos apresurado al mercado, que algunas cosas aun no me funcionaron bien. Por ejemplo, una de las canciones sencillamente se negaba a subir a la nube, pero eventualmente (después de 5 intentos) subió, lo que me dice que Amazon tiene algunos problemas de escalabilidad aun por resolver. Así mismo otro archivo cuyo nombre noté empezaba con un espacio sencillamente se negó a subir hasta que le cambié el nombre removiendo el espacio. Noten además que solo pueden subir canciones libres de DRM (tecnología anti-copia), por lo que si tienen canciones que hayan comprado de Apple por medio de iTunes, tienen que ser las del tipo "Plus" que no contienen DRM. Otra cosa extraña es que tenía dos ventanas abiertas, una con el Cloud Drive y otra con el Cloud Player, y noté que si subía las canciones por el Cloud Drive que estas no se reflejaban en el Cloud Player inmediatamente (o al menos, al cabo de unos segundos), sino que tenía que recargar la página para que el Cloud Player se diera cuenta que habían canciones nuevas. Sin embargo, esos son pequeños inconvenientes de un producto que apenas sale al mercado, y lo cierto es que en mi agenda los descarto como algo que estoy seguro Amazon corregirá al corto tiempo. Así como está, este es un servicio que será bastante exitoso, y ya me puedo imaginar las caras de los ejecutivos de Apple y Google quienes fueron tomados por total sorpresa por esta movida relámpago de Amazon. Una cosa más interesante que no he dicho, y esto es algo que contribuirá al éxito de esta plataforma de Amazon, es que si compras canciones mp3 de la tienda de Amazon, el espacio que estas ocupan en tu Cloud Drive no se contabiliza, lo que significa que Amazon está alentando a usuarios a comprar canciones (y no duden que próximamente, películas) de su tienda, ya que si haces esto el espacio para estas es literalmente ilimitado en la práctica y no tendrás la limitación de los 5GB. Finalmente, recuerden que aunque he utilizado música como ejemplo, que el Cloud Drive acepta cualquier tipo de archivos (y todos son almacenados y accedidos de forma cifrada con todos los correspondientes niveles de seguridad a lugar), similar a Google Docs, por lo que esa es otra utilidad adicional de la plataforma. ¡Que inicie la guerra de las nubes de Internet! Nota: Para los curiosos y técnicos que deseen saber más sobre temas de la Nube de Internet, recomiendo leer al menos estos dos artículos del año pasado en eliax: artículo 1, artículo 2. página oficial del Amazon Cloud Drive página oficial del Amazon Cloud Player autor: josé elías |

|

|

|

|

|

lunes, marzo 28, 2011

|

Muchos de ustedes ya están al tanto de mi episodio con la empresa Wind Telecom, en donde al final tuvieron que responder después que la noticia de sus problemas se esparciera por todo el Internet vía este mismo blog, Twitter y Facebook, forzando a la empresa a finalmente comunicarse y al menos arreglar uno de sus problemas (con promesas de arreglar los otros próximamente), y eso me hizo pensar en este artículo... Muchos de ustedes ya están al tanto de mi episodio con la empresa Wind Telecom, en donde al final tuvieron que responder después que la noticia de sus problemas se esparciera por todo el Internet vía este mismo blog, Twitter y Facebook, forzando a la empresa a finalmente comunicarse y al menos arreglar uno de sus problemas (con promesas de arreglar los otros próximamente), y eso me hizo pensar en este artículo...Como le dije a algunos lectores y amigos fuera del blog, lo que sucedió con Wind Telecom en este país es bastante similar a lo que sucedió en Túnez y Egipto recientemente, en donde gracias a la redes sociales la sociedad pudo no solo organizarse, sino que correr la voz, salir a las calles y armar una revolución digital que se extendió más allá de los teclados y pantallas hasta las mismas puertas de los gobiernos. Pues creo que ya podemos decir que oficialmente hemos llegado al momento en la humanidad en donde no será fácil no solo para los gobiernos, sino que para las empresas y cualquier otra entidad, no solo mantenernos callados, sino que tratarnos como tontos. Hoy día gracias a herramientas como blogs, y en particular a redes sociales como Twitter y Facebook, se ha hecho evidente que cualquier empresa que pretenda prometer un servicio y al final entregar otro, lo que hace es arriesgarse a ser sometida a ser juzgada públicamente por centenares, miles o millones de sus clientes, quienes no solo se desahogarán sobre sus penurias, sino que además correrán la voz para que otros no consuman los servicios de esa empresa. Y eso nos trae a las empresas a un punto bastante interesante, a una intersección en donde tendrán que decidir entre una de dos cosas: 1. Adoptar las redes sociales pero arriesgarse a que sus clientes se organicen y se informen para protegerse contra el abuso de la empresa. 2. No adoptar las redes sociales pero arriesgarse a perder lo que sin duda es la próxima ola en los negocios: Negocios a través de portales sociales. En mi opinión, quien elija la segunda opción es alguien o que no entiende lo que es el Internet y las redes sociales, o alguien que entiende pero que simplemente no tiene visión para el futuro de los negocios, y esas empresas al largo plazo perecerán, ya que las decisiones de compras de miles de millones de personas en los años venideros se originarán en redes sociales. Así que asumamos el primer caso, y sus consecuencias... Lo que el primer caso logrará es una simbiosis entre empresas y consumidores, pero una tal en donde uno de los ingredientes fundamentales de esta es la honestidad. Esto se debe a que las redes sociales son un arma de doble filo. Por un lado, es una tremenda herramienta para expandir tu negocio, pero por el otro es una tremenda herramienta para destruir tu negocio, por lo que la única opción que tendrán las empresas que adopten las redes sociales en años venideros es sencillamente ser honestos. Dejen de ser honestos y ya verán como un gran porcentaje de sus clientes dejarán de consumir sus productos, migrarán a otros proveedores, y de paso dañarán su imagen de forma posiblemente irremediable, y en cuestión de días, o quizás incluso horas. O en otras palabras, las redes sociales son un paso más a un mundo mejor, más honesto, y definitivamente en donde se le da más poder a los consumidores... autor: josé elías |

|

|

|

|

|

viernes, marzo 18, 2011

|

Hace apenas un par de años quien dijera que veríamos a unos de los grandes estudios de Hollywood (en este caso, Paramount Pictures) trabajar en un proyecto en conjunto con BitTorrent, hubiera pasado como lunático por muchos... Hace apenas un par de años quien dijera que veríamos a unos de los grandes estudios de Hollywood (en este caso, Paramount Pictures) trabajar en un proyecto en conjunto con BitTorrent, hubiera pasado como lunático por muchos...Verán (para los que desconocen sobre el tema), BitTorrent es la empresa creadora del protocolo bitTorrent, que es el que primariamente se utiliza para descargar películas de forma no autorizadas por Internet. En otras palabras, por años bitTorrent ha sido sinónimo de piratería en Hollywood, y no han sido pocas las demandas causadas debido a este protocolo (el caso de The Pirate Bay viene a la mente). Por tanto, es sorprendente el hecho de que este estudio accediera a trabajar en un proyecto (una película de terror llamada The Tunnel) con BitTorrent. Sin embargo, aquí creo que hay que ver más allá de los conflictos pasados, y ver hacia el futuro. Lo que tenemos ante nosotros es uno de los primeros y verdaderos experimentos de modernizar el cine con un modelo de negocio totalmente distinto al tradicional. Sucede que los creadores de esta película no recibieron fondos de empresas productoras de cine o del mismo Paramount Pictures para hacer su película, sino que lo hicieron vendiendo "cuadros" (o fotogramas) de la película, la cual es conformada por unos 135,000 cuadros, y que han vendido a US$1 dólar cada uno a fans del cine de todo el mundo. Es decir, el pagar US$1 es un gesto simbólico más que otra cosa, con la finalidad de que se cree la película pero que posteriormente esta se haga disponible al mundo entero de forma gratuita a través de las redes bitTorrent. Con este modelo ganan los realizadores de la película quienes no solo obtienen el presupuesto necesario para hacer su película, sino que incluso quizás un dinerito aparte como recompensa por su esfuerzo. Y por otro lado ganan los fans del cine, quienes con donar tan solo US$1 podrán disfrutar de la película, así como compartirla con quienes lo deseen gratuitamente. Por su parte, Paramount Pictures hará dinero ya que tendrá los derechos de vender un DVD con prestaciones adicionales, como final alternativo, video tras bastidores, y un total de 2 horas de contenido adicional. En otras palabras, hablamos de un nuevo modelo que deja atrás la forma tradicional de hacer cine. Esto no significa que se dejará de hacer cine de la forma tradicional (ciertamente no al corto plazo), pero sí significa que estamos entrando a una nueva era en donde los realizadores de cine tendrán más independencia financiera y creativa para llevar a cabo sus proyectos, lo que podría convertirse en toda una revolución en el cine tal cual lo conocemos. Yo particularmente estoy bastante emocionado por este tipo de iniciativas, pues al final, mientras más cine, más ganamos todos... fuente de la noticia En noticia relacionada: Después de un estudio de 3 años, la SSRC (The Social Science Research Council) llegó a la conclusión que la forma de terminar con la piratería es bajando los precios de las películas, canciones y otros tipo de media (fuente, y reporte oficial). Mi opinión al respecto es ¿de verdad necesitaron de 3 años y quien sabe cuántos millones de dólares para llegar a esa conclusión? Se hubieran ahorrado esos años de trabajo y dinero con solo leer mi editorial de hace 5 años atrás: "Razones por la cual la gente piratea fuera de los EEUU" (eso, o simplemente escuchar a cientos de millones de personas que sin tener títulos universitarios, sin ser magnates de los medios y sin ser genios del mercadeo y los negocios llegaron a la misma conclusión hace años). autor: josé elías |

|

|

|

|

|

miércoles, marzo 16, 2011

|

Hace 4 años escribí un artículo acá en eliax titulado "El futuro de la TV". Hoy, Netflix está haciendo el mensaje de ese artículo una realidad... Hace 4 años escribí un artículo acá en eliax titulado "El futuro de la TV". Hoy, Netflix está haciendo el mensaje de ese artículo una realidad...Según rumores (rumores que de paso parecen ser bastante substanciados, por lo que me arriesgué a escribir este artículo), la empresa Netflix por primera vez dará un paso que la pondrá en competencia totalmente directa contra las empresas de TV y Cable tradicional, al ofrecer al menos US$100 millones de dólares por la exclusividad a una nueva serie de TV. La serie de TV, titulada "House of Cards" ("Casa de Cartas/Barajas/Naipes") tiene detrás como productor ejecutivo y director a David Fincher, y como co-productor ejecutivo y actor al reconocido Kevin Spacey. Para el que no recuerde, David Fincher es al talentoso director de The Social Network ("La Red Social", la película sobre Facebook) y The Curious Case of Benjamin Button con Brad Pitt. Pero lo importante de esta noticia es el hecho de que esta es la primera vez que una empresa que ofrece renta de videos por Internet puja en contra del establecido negocio de la TV. Para que tengan una idea, según el reporte Netflix ha estado compitiendo por obtener los derechos exclusivos de esta serie contra AMC y HBO, dos titanes de los medios estadounidenses e internacionales del cable. Y esto, mis amig@s lectores, es una tendencia de la cual estamos viendo apenas el inicio... Como he escrito varias veces en el blog por años (y como creo se hace evidente cada día más para toda la población que vea los últimos avances en Internet en años recientes), el futuro de la TV es el uno poder disfrutar de lo que uno quiera, cuando uno quiera, donde uno quiera y desde el dispositivo que uno quiera, y esa modalidad a su vez transformará la forma en que se crean y distribuyen programas de TV. Hoy día empresas como las mismas AMC y HBO se están durmiendo en sus laureles pensando que sobrevivirán eternamente cabalgando sobre los hombros de las estaciones de cable tradicionales, cuando se ha hecho bastante evidente que la tendencia global es la de disfrutar videos directamente desde Internet. Lo que sucederá entonces es que veremos una nueva generación de empresas (como Netflix y otras independientes e incluso ajenas al negocio actual de la TV y el Cable) que invertirán en la creación no de cadenas de cable o canales de cable o TV por el aire, sino que como escribí hace ya varios años, en programas. Al final del día, así como ha desaparecido casi por completo el concepto de un "Disco LP" o "CD" a favor de canciones individuales, así mismo veremos desaparecer casi en su totalidad el concepto de un "Canal" y veremos un futuro dominado casi exclusivamente por "Programas". Así que sea cierto o no el rumor sobre Netflix, el solo hecho de que este rumor ande en los medios es señal de que esos tiempos están ya llegando... fuente del rumor En noticia relacionada: Las últimas estadísticas indican que Netflix ya tiene un 61% del mercado de videos por Internet en los EEUU (fuente), y como les informé previamente, la empresa ya planea expandir sus alas más allá del territorio estadounidense (yo sería uno de los primeros en subscribirme). Y en otra noticia relacionada: La empresa de cable Time Warner inicia esta semana un servicio a sus 12.4 millones de usuarios en los EEUU en donde estos podrán acceder a programación en vivo de 30 canales directamente desde sus iPads (fuente). De esto a un paso en donde estos usuarios puedan ver los videos de su preferencia (como ya lo pueden hacer con Netflix en el iPad o Apple TV) es solo un pequeño paso... autor: josé elías |

|

|

|

|

|

martes, marzo 15, 2011

|

Voy a iniciar este artículo con lo que será la conclusión al final: No todo lo que brilla es oro, y rara vez he visto un ejemplo tan espectacularmente cierto como lo que me ha sucedido (junto a varios amigos) con el servicio de Wind Telecom en la República Dominicana... Voy a iniciar este artículo con lo que será la conclusión al final: No todo lo que brilla es oro, y rara vez he visto un ejemplo tan espectacularmente cierto como lo que me ha sucedido (junto a varios amigos) con el servicio de Wind Telecom en la República Dominicana...Hoy pienso darles mis impresiones de los servicios de Internet, TV por Cable y Telefonía de la empresa, a los cuales estoy actualmente subscrito. Pero iniciemos desde el principio... A finales del año pasado, la empresa Wind Telecom me invitó, junto a otros blogueros locales, a una rueda de prensa oficial en donde presentaron sus ofertas de "Internet 4G", así como telefonía VoIP y Televisión inalámbrica, todo utilizando servicios de WiMax. La empresa estaba tan confiada de sus ofertas que nos prestó por un mes un dispositivo portátil de Internet 4G, para que le diésemos uso (y de paso sin duda alguna esperar que escribiésemos buenas palabras al respecto en nuestros blogs, cosa que yo mismo ya tenía planeado hacer a su debido tiempo). Algunos de mis colegas se apresuraron a escribir sus artículos, reportando en sus blogs las asombrosas caracteríasticas del servicio "4G" de la empresa. Yo me negué a escribir artículo alguno tan apresuradamente, pues como le mencioné a un buen amigo que escribió uno de esos artículos, aun estábamos en una etapa con pocos usuarios, y no quería reportar hasta ver cómo funcionaría el sistema con más usuarios y en un ambiente más real. Pues este artículo de hoy, es ese artículo que tanto la gente de Wind, como lectores locales, esperaban... Debo iniciar admitiendo que al inicio quedé muy impresionado. Tanto así que le conseguí a Wind al menos unos 20 clientes de mis familiares cercanos y amigos, pero no solo eso, yo mismo cancelé mi servicio de TV por cable tradicional, mi servicio de telefonía tradicional, y mi servicio de Internet, y adopté a Wind. Tremendo error. O al menos tremendo error parcial... Digo "parcial" porque por ejemplo, asumí que todo se veía demasiado bueno, por lo que decidí no cancelar inmediatamente mis otros servicios para utilizarlos como modo de comparación, y por si la impecable "Ley de Murphy" surgía efecto. Los primeros problemas iniciaron con el sistema de portabilidad numérica. Cuando solicité el servicio (el año pasado), me prometieron que el cambio se hacía en 7 días laborables. Pues lo cierto es que apenas hace una semana, en Marzo, más de 3 meses después, es que terminaron la transición de mi número telefónico. Duraron tanto en el proceso que tuve que pagar varias veces la factura con mi proveedor anterior para que los técnicos de Wind pudieran proceder a re-hacer la transición. En cuanto al servicio telefónico, antes de escribir este artículo tenía dos días sin servicio, pues por razones no explicadas el teléfono simplemente dejó de funcionar, y reiniciar el router no ayudó en nada. Necesitó de una llamada de exactamente 24 minutos medidos de mi preciado tiempo para que por fin resolvieran el problema. En cuanto al servicio de cable. Apenas un par de días de la instalación, la mayoría de los canales no se veían. Otra llamada más y enviaron una brigada técnica que concluyó que había que cambiar la antena que habían instalado previamente. Posteriormente a eso, en algunos días la imagen se degrada con un insoportable efecto de pixelado (común en compresiones MPEG que asumo es lo que utilizan), y en al menos un par de ocasiones no tuve servicio de cable en lo absoluto durante la noche (ni avisaron previamente por si era programada la pérdida de señal). Similarmente, a veces durante el día el servicio desaparece sin dar señales de por qué, a veces en solo algunos canales, y a veces completamente. Sin embargo, debo admitir que al menos la imagen es muchísimo más sólida que mi proveedor anterior (Aster), con el cual mi imagen se desvanecía cada 2 semanas y solo veía ruido constante (al igual que todos mis vecinos). Una observación sin embargo es que la imagen es de menor resolución que la que envía Aster. Es una imagen digital, pero el sampling rate es obviamente bajo, y esto se nota en letras pequeñas y en pixelización de la imagen. Noten sin embargo que esto es casi imperceptible en televisores tradicionales CRT, pero en televisores LCD/LED/Plasma de gran tamaño (como los míos) se nota claramente. Admito sin embargo que aun así prefiero la imagen de Wind a los problemas constantes con Aster. Otra cosa es que el sistema de cable de Wind viene con una "Guía de Programación Electrónica", pero tanto yo como mis amigos nos hemos dado cuenta que su utilidad se va a la nada rápidamente debido a que los ingenieros de Wind (o el proveedor de su infraestructura) no compensa por la diferencia horaria de los programas, por lo que en el 99% de los casos ya no confío en la guía porque sencillamente no se si lo que dice es cierto. Esto, a propósito, es una pena, ya que es una de las cosas que más esperaba poder darle uso. Otra cosa que me decepcionó es que no entiendo como un servicio al que mercadean como "Digital" viene con una caja de cable que solo puede enviar una señal o por el viejo método de cable coaxial para televisores de antaño, o por el super-atrasadísimo conector amarillo de señal tipo Composite (¡ni siquiere Component!). Al menos debieron ofrecer una opción de caja más cara con salida digital HDMI (y no vendría mal una opción con PVR como ya lo ofrece la competencia)... Para agregar insulto al problema, la empresa tiene además una política de interrumpir el flujo natural de los programas y anuncios, interfiriendo la señal para pasar anuncios de su propiedad a un nivel de volumen tan alto, que se hace prácticamente imposible ver algunos canales de noche sin despertar a todo el mundo en casa, lo que es insoportablemente molestoso y nada profesional (y que de paso hace que aparente que los mismos ejecutivos que nos venden el servicio de cable no utilizan sus propios servicios de cable). Pero la joya de mi experiencia con Wind fue mi experiencia con su sistema de Internet". Sucede que Wind ofrece varios paquetes de Internet, en donde el más caro de todos ofrece (según ellos) velocidad "Ilimitada". En la rueda de prensa a la que me invitaron pregunté varias veces que aclararan cuál era la velocidad máxima y mínima de tal plan, pero esquivaron la respuesta una y otra vez, pero sin embargo cometieron el error (ante todos los otros presentes) de explicarnos el concepto. Según los representantes de Wind: "El plan ilimitado es similar a una llave de agua abierta, en donde la abrimos por completo a los usuarios que elijan ese plan sin imponer ningún tipo de restricciones en la velocidad máxima teórica de nuestra red WiMax". Con ese discurso, muchos decidimos subscribirnos al plan "Ilimitado", y los primeros días fueron espectaculares, con algunos de mis amigos reportando velocidades de descarga de alrededor de 20Mbps (en mi caso, cerca de 12Mbps) y de subida de varios Megabits por segundo. Estábamos en el paraíso. Por fin podía hacer video-conferencia de alta definición con mis clientes en otros países, subir mis trabajos de altas cantidades de datos a tales clientes en minutos en vez de horas, y acceder a YouTube sin tener que esperar. Lamentablemente, la diversión no duró mucho... De repente, hace algunas semanas el servicio prácticamente colapsó. Pasamos de descargar sobre los 10Mbps a apenas 1 o 2 Mbps (y algunos afortunados, a hasta 4Mbps). De paso empecé a notar algunos problemas adicionales: Cuando traté de entrar al router WiMax que compré de la empresa, lo primero que noto es que lo dejaron con la clave por defecto (entré en el primer intento con usuario "admin" y clave "admin"), lo que significa que cualquier hacker malicioso tiene acceso a casi cualquier cliente de Wind Telecom en el país, con tal de poder llegar al router. Pero he aquí lo curioso: Un día, de la noche a la mañana la empresa cambió el mensaje de su página web con una estrellita* para indicar que "Ilimitado significa de 2 a 4Mbps" (enlace a la página). No se ustedes, pero esto no solo fue publicidad engañosa, sino que incluso después de especificar "2 a 4Mbps" esas no son velocidades que cualquier técnico esperaría de una conexión "ilimitada". Esto es incluso mucho inferior a planes "limitados" de la competencia (como Claro), pero la historia no se acaba ahí... Cuando noté esta caída de velocidad (que fue notada por el resto de la blogosfera local), lo primero que hice fue publicar en el grupo oficial de Wind Telecom en Facebook una queja (que pueden leer aquí), la cual fue respondida inmediatamente por un representante de forma pública, aclarando que la bajada de velocidad era algo "temporario" que sería resuelto para finales del mes pasado, pero dos semanas después de esa fecha el servicio de Internet ha empeorado considerablemente. Para empezar, ahora de vez en cuando, el Internet simplemente deja de funcionar. Noten que soy lo que muchos considerarían un experto en estos temas sencillos de redes, y que a diferencia de un usuario promedio se de lo que hablo. Cuando se cae el Internet, me puedo conectar a la pantalla de administración del router (lo que indica que no es un problema de mi máquina ni de red interna en mi oficina), y este claramente indica que todo debe estar bien. Incluso reiniciando el router no resuelve el problema, lo que indica que algo está afectando la señal en la torres WiMax o en la central de datos o el resto de la infraestructura de Wind. Pero peor aun, la velocidad ha disminuído a niveles sencillamente inaceptables. Para que tengan una idea, hace unos minutos (Marzo 14, 1:45pm, mientras escribía este artículo) hice dos pruebas con SpeedTest, una conectándome al servidor de Wind en Santo Domingo, y otra a un servidor fuera del control de ellos en Miami. Los resultados fueron los siguientes: Servidor Wind en Santo Domingo 4.55Mbps bajada 0.18Mbps subida Servidor en Miami 1.24Mbps bajada 0.12Mbps subida Para los que no son técnicos, déjenme analizarles el significado de esos resultados... Lo primero es que hay una gran discrepancia entre el servidor local de Wind, y el internacional en Miami, lo que indica que Wind tiene sus lineas sobrevendidas, y que necesitan más capacidad. En otras palabras, alguien que navegue una página promedio (que por lo general no es una página local), en realidad se verá limitado a una velocidad que ronda los 1Mbps, que es equivalente al plan más barato de Internet de la competencia (mientras pagamos unas 3 a 4 veces más). Lo otro preocupante es la extremadamente baja velocidad de subida de 0.12Mbps, o en otras palabras hablamos de menos de 128Kbps (sí, Kilobits por segundo). En otras palabras, una velocidad que hace imposible incluso la forma más precaria de video-conferencia con Skype, y que apenas es suficiente para el tráfico de telefonía por Internet (VoIP). No solo eso, sino que esa ultra-limitada velocidad de subida pone fuertes restricciones en el protocolo TCP/IP, ya que los paquetes de datos que se descargan deben ser confirmados de regreso a la fuente, pero a esta velocidad eso significa que incluso si exista la capacidad de descargar a buena velocidad, que en la práctica esa velocidad nunca la veremos debido a la gran restricción de velocidad en los datos de regreso. Al final, estoy ahora con un servicio de Internet mediocre, un servicio de televisión "digital" que apenas es una mejora por lo que tenía antes, y un servicio de telefonía del cual desconfío. Sin embargo, aun tengo esperanzas (tengo una mente positiva), así que vamos a más-o-menos asumir que estos son tropiezos de una empresa nueva en el mercado, por lo que estoy dispuesto a darles una oportunidad para que: 1. Expliquen honestamente cuál es el problema que tienen. 2. Expliquen la solución que planean implementar. 3. Ofrezcan plazos realistas para resolver estos problemas. 4. Mientras tanto, dejen la avaricia y detengan el firmar más clientes (pónganlos en lista de espera), pues eso solo empeorará la situación para ustedes y nosotros con redes sobrecargadas. 5. Olviden las excusas o de llamarme personalmente para resolver mi problema. Este es nuestro problema. Todos mis familiares y amigos están sufriendo igual que yo con este pésimo servicio. Por mi parte, si todos estos problemas se resuelven, espero escribir un artículo posterior rectificando todo lo dicho en este. Mientras tanto, eviten los servicios de Wind Telecom a toda costa, no caigan en la trampa como lo hemos hecho los primeros adoptantes de sus servicios... Actualización: Al día siguiente de este artículo, escribí esta continuación exponiendo los serios problemas de seguridad de la empresa. Actualización Mayo 2012: Wind Telecom ahora está llamando a los clientes con planes ilimitados, y "para un mejor servicio" les dice que los van a poner en un plan de 3Mbps/1Mbps, de manera forzada. A eso llamo yo un "excelente servicio" (los que sufrieron esto en mi familia están ahora mismo cancelando todos sus servicios de Wind Telecom). autor: josé elías |

|

|

|

|

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax