Educación

|

martes, mayo 19, 2009

|

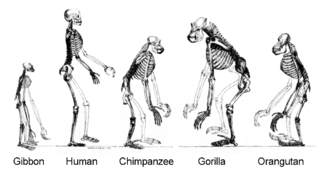

Según reporta el prestigioso Wall Street Journal, científicos descubrieron en Alemania por fin el ancestro común entre los monos, gorilas y humanos, dando una prueba mas innegable por la ciencia de nuestros orígenes evolutivos. Según reporta el prestigioso Wall Street Journal, científicos descubrieron en Alemania por fin el ancestro común entre los monos, gorilas y humanos, dando una prueba mas innegable por la ciencia de nuestros orígenes evolutivos.El hallazgo fue hecho hace 2 años, y desde entonces se ha venido estudiando al espécimen (femenino), el cual para fortuna de la ciencia esta preservado en su totalidad (a diferencia de solo haber encontrados algunos fragmentos de huesos). El esqueleto será demostrado hoy al mundo en el American Museum of Natural History en New York por el alcalde de esa ciudad Michael Bloomberg y el equipo internacional responsable del hallazgo. Y a propósito, no dejen de ojear aquí abajo los enlaces de noticias relacionadas a esta, que creo muchos encontrarán bastante interesantes. Sobre la imagen que acompaña la noticia a donde los envío hoy: En la imagen verán al Lémur, que según el hallazgo es el animal viviente hoy día que mas se parece a ese ancestro común de nosotros. Fuente de la noticia Actualización: Mas detalles de fósil "Ida" (como lo han bautizado, es un espécimen hembra) en este enlace.  Foto actualizada. Foto actualizada.

autor: josé elías |

|

|

|

|

|

miércoles, mayo 13, 2009

|

Antes de leer este artículo de hoy, es posible que quieran leer primero este otro artículo que les explica en términos sencillos lo que es una Máquina Virtual en este contexto... Antes de leer este artículo de hoy, es posible que quieran leer primero este otro artículo que les explica en términos sencillos lo que es una Máquina Virtual en este contexto...Por lo general, por Máquina Virtual (o "VM" por sus siglas en inglés) uno asume que hablamos de virtualizar un sistema operativo dentro de otro, como por ejemplo utilizar a VMWare en Linux para ejecutar a Windows dentro de Linux, o Paralles en OS X para ejecutar a Linux, etc. Un detalle que no todo el mundo conoce es que este tipo de virtualización es el llamado "Tipo 2", ya que hablamos de un sistema operativo dentro de otro. Esto implica que existe un "Tipo 1", que es del cual hablaremos hoy. Cuando se habla de una VM Tipo 1 o 2 en realidad se está hablando de un "HyperVisor". Un HyperVisor es como un micro-sistema operativo que extrae el hardware y lo expone a un sistema operativo. El Tipo 2 permite que uno o mas sistemas operativos secundarios compartan los recursos de uno principal (como por ejemplo, Windows dentro de Linux). Esto obviamente requiere de muchos recursos en el sistema operativo principal, ya que este debe ejecutar no solo sus propios procesos, sino que los del sistema operativo secundario también, llevando esto al típico caso de pérdida en rendimiento. Sin embargo, con un HyperVisor Tipo 1 la historia es otra. Un Tipo 1 es un compacto y eficiente sistema operativo que se sienta entre el mismo hardware (justo encima del BIOS o Firmware), y hace que uno o varios sistemas operativos se instalen directamente sobre tu PC (o Servidor), de tal manera que estos sistemas operativos no estarían ejecutando uno dentro de otro, sino que uno al lado de otro, y siendo los recursos de la PC coordinados (o supervisados) por el HyperVisor. Noten que esto no es nada nuevo. IBM inventó esta tecnología para sus Mainframes en la década de los 1960s, y desde entonces todas sus Mainframes poseen esta capacidad, así como casi todos los procesadores y sistemas operativos en el mundo de UNIX (como Solaris en SPARC), pero recientemente se está haciendo factible implementar Hypervisors Tipo 1 en hardware típico de PC. Las ventajas de un Tipo 1 son varias, pero las mas importantes quizás sean estas: 1. Mejor rendimiento que un Tipo 2. 2. Mejor manejo de recursos, permite incluso aceleración 3D sin problemas. 3. Mucho mas estable. Sin un sistema operativo cae, no tiene que "tumbar" a uno secundario. Por otro las desventajas son estas: 1. Requiere de soporte en hardware a nivel del CPU. 2. El sistema operativo debe ser modificado para que funcione sobre un HyperVisor (para que no haga llamadas directas al hardware, sino que a través del HyperVisor). La buena noticia es que prácticamente todo CPU de Intel y AMD en los últimos 2 años ya posee extensiones para ayudar a los HyperVisors de hoy día. Así mismo casi todas las versiones recientes de Linux, así como OS X y las versiones de Windows Vista en adelante también soportan HyperVisors. La experiencia de un usuario ejecutando dos o mas sistemas operativos bajo esta modalidad es idéntica a como si tuvieran dos o mas máquinas totalmente por separado, y por tanto se requiere de una combinación de teclas para cambiar entre una máquinas y otra, ya que estas no están conectadas entre sí. Sin embargo, empresas como Citrix están permitiendo un alto nivel de integración entre las VM, permitiendo incluso abrir un archivo de un sistema operativo con un programa de otro, y hacer que ese programa surja en el escritorio del primer sistema operativo. Y hablando de HyperVisors Tipo 1, los quiero invitar a ver un video de Citrix demostrando alguna de estas cosas con su software XenClient. Es un producto que pronto sacarán para las Macs y MacBooks, que permitirá este tipo de integración entre OS X y al menos Windows (y sin duda Linux en el futuro). El video está en este enlace, pero adelanten casi al final a los 41 minutos del video que es cuando sucede el demo interesante. Y como siempre, pueden acceder a mas artículos similares en la sección de "Pregunta a eliax", y enviar sus preguntas por este medio. autor: josé elías |

|

|

|

|

|

lunes, mayo 4, 2009

|

Tomando en cuenta que en estos momentos muchos países están celebrando el Día del Trabajador (por estos rumbos el día festivo se mudó al día de hoy), me acordé de un documento titulado "La Declaración Universal de los Derechos Humanos" confeccionado por la Organización de las Naciones Unidas (ONU), y que irónicamente es introducido de esta manera en la página a donde los envío hoy: Tomando en cuenta que en estos momentos muchos países están celebrando el Día del Trabajador (por estos rumbos el día festivo se mudó al día de hoy), me acordé de un documento titulado "La Declaración Universal de los Derechos Humanos" confeccionado por la Organización de las Naciones Unidas (ONU), y que irónicamente es introducido de esta manera en la página a donde los envío hoy:"El 10 de diciembre de 1948, la Asamblea General de las Naciones Unidas aprobó y proclamó la Declaración Universal de Derechos Humanos, cuyo texto completo figura en las páginas siguientes. Tras este acto histórico, la Asamblea pidió a todos los Países Miembros que publicaran el texto de la Declaración y dispusieran que fuera 'distribuido, expuesto, leído y comentado en las escuelas y otros establecimientos de enseñanza, sin distinción fundada en la condición política de los países o de los territorios'." Digo "irónicamente" porque es obvio que hoy día prácticamente ningún país miembro de la ONU ni obedece estas normas, ni hace el mas mínimo esfuerzo por diseminar esta declaración. Si no recuerdo mal (y temo que el escenario es igual en casi todos los países del mundo) en ningún momento en mi educación primaria, secundaria o universitaria se me mencionó siquiera la existencia de este documento. Además, esto me hace cuestionar si la ONU verdaderamente está cumpliendo su rol, y si no es tiempo de crear una verdadera "Naciones Unidas" mucho mas fuerte, con mas influencia sobre las naciones, para hacer que declaraciones como estas no solo se conozcan, sino que se cumplan... Sin embargo, para toda persona que crea en la igualdad de los derechos humanos, esta no es solo una buena lectura, sino que además un buen pedazo de papel para tirar a la cara de algunos políticos y dictadores que se creen dueños y amos del mundo... Y como siempre, pueden leer mas de mis opiniones y análisis en la sección bajo ese nombre a la derecha de la página principal de eliax. La Declaración Universal de los Derechos Humanos de la ONU (en español) autor: josé elías |

|

|

|

|

|

miércoles, abril 29, 2009

|

Debido a mi experiencia en la industria, y muchos de los artículos que publico acá en eliax, por lo general recibo unos cuantos emails semanales de personas jóvenes en ambiente universitario quienes me preguntan básicamente "¿Qué debería yo estudiar para mantenerme competitivo en el mercado de la informática? Debido a mi experiencia en la industria, y muchos de los artículos que publico acá en eliax, por lo general recibo unos cuantos emails semanales de personas jóvenes en ambiente universitario quienes me preguntan básicamente "¿Qué debería yo estudiar para mantenerme competitivo en el mercado de la informática?La respuesta no es una, pero responderé de tal manera que espero pueda ayudar al menos a unos cuantos. Lo primero a entender es que "informática" cubre muchísimas cosas, pero voy a asumir que hablamos sobre todo de "programación". Sin embargo, aun en programación hay dos grandes vertientes que puedes seguir (o ambas si así lo prefieres): Software de Aplicaciones, y Software de Sistema. Por Software de Aplicaciones me refiero a poder crear (por ejemplo) programas para el mundo de los negocios, desde una simple agenda hasta portales de Internet, o desde un sistema de mensajería hasta una aplicación web para dar servicio al cliente. Por Software de Sistema me refiero mas a programas de bajo nivel, que están mas cerca del hardware, y que incluye desde crear un simple driver para un puerto serial, hasta crear módulos para un sistema operativo (como Linux). Así que voy a dar recomendaciones para ambos entornos por separado. Software de Aplicaciones Aquí creo que ante todas las cosas, se concentren en tecnologías web, y opcionalmente también en tecnologías móviles (aunque pronto será una necesidad ya que todo será móvil). Si lo que les enseñan en la Universidad es todavía como programar en Pascal o C, y no a como desarrollar aplicaciones web, no es que estén perdiendo el tiempo pero ciertamente están jugando en la cancha equivocada. Si donde estudias no te ofrecen las siguientes tecnologías que nombro a continuación, recomiendo que utilices la web (y en particular a Google) para aprender por tu cuenta. Hoy día no es esencial comprar libros, ya que hay muchísimos recursos gratuitos en Internet para casi cualquier cosa que te puedas imaginar. Así que para Software de Aplicaciones, recomiendo lo siguiente como mínimo: 1. Lo básico de páginas web estáticas. Es decir, HTML y CSS. 2. Lo básico de páginas web dinámicas con Javascript. 3. Alguna tecnología de generación dinámica de páginas web, como puede ser PHP, JSP, ASP o Coldfusion. 4. Integración de páginas web dinámicas con generación dinámica de páginas web, es decir, el concepto llamado "AJAX", que implica Javascript, HTML, preferiblemente CSS, y lo básico de XML y/o JSON (desde el punto de vista estructural, no tanto en detalle). Aquí también es bueno aprender de herramientas como JQuery y Prototype. 5. Saber Adobe Flash ayuda, pero personalmente trato de mantenerme alejado ya que rompe el esquema de aplicaciones web, aunque tiene sus usos prácticos. Sin embargo hoy día AJAX y HTML 5 están poco a poco reemplazando a Flash en muchas aplicaciones. 6. SQL, así como al menos una base de datos como MySQL o Postgress. 7. No está de mas saber Java, pues puede ser mucha ayuda para resolver ciertos tipos de problemas. Además con Java aprendes técnicas de programación mucho mas sofisticadas que con simple PHP o Javascript. 8. Dominar al menos una herramienta de desarrollo. Para desarrollo web recomiendo Dreamweaver. Para Java utilizo Netbeans pero Eclipse es igual de potente (sino mas, pero también requiere de mas esfuerzo configurarlo). 9. Saber un poco de Photoshop te puede sacar de muchos aprietos. 10. No está demás aprender técnicas de MVC para separar la lógica y el interfáz de usuario de tu aplicación (y de paso el mismo almacenamiento de los datos). 11. Algo útil también es Servicios Web (Web Services), lo que implica saber al menos los conceptos de WSDL y SOAP. 12. Otra cosa que puede venir útil es poder integrar con portales y servicios en la web, como Google Maps, Twitter, RSS, FedEx, Paypal, etc. 13. Es bueno conocer el concepto de un Contenedor de Aplicaciones, como lo hace J2EE o Coldfusion. Software de Sistema Crear Software de Sistema por lo general requiere de mayor experiencia por parte del programador, así como ser muy cuidadoso en el diseño, y poder saber técnicas avanzadas de optimización de bajo nivel (a veces hasta el nivel binario, haciendo trucos como un shift a la izquierda o derecha de los dígitos binarios para multiplicar o dividir). Aquí es muy importante conocer técnicas de código bien estructurado y documentado, así como tener un arsenal de todo tipo de utilidades y trucos para comparar archivos, diagnosticar tu código, medir el rendimiento, etc. A tal fin recomiendo como mínimo lo siguiente: 1. Conocimiento del lenguaje C y C++. Si piensas programar en Mac OS X, también debes mojarte las manos con Objective C. El lenguaje C y sus variantes por lo general serán tus herramientas principales. 2. Java. Aunque no puede hacer todo lo que hace C, sí se acerca mucho, y es bastante útil para crear aplicaciones de redes o de interconexión. En muchos casos a este nivel hay programadores que pasan mas tiempo en Java que en el mismo C. 3. Saber moverte en la linea de comando, sea el DOS/CMD de Windows, o el Shell de Unix/Linux/OS X. 4. A veces ayuda poder hacer Shell Scripts, sea en DOS, sh, Perl, etc. 5. Saber depurar tu código tanto en tiempo real como paso-a-paso. 6. Entender técnicas de optimización de código (profiling), utilizando la regla del 80/20 (concéntrate en optimizar esa pequeña parte del código que te da el 80% del beneficio, pues optimizar el resto es posible que no te incremente mucho el rendimiento). 7. Ayuda bastante conocer varios lenguajes y entornos de programación, como Pascal/Delphi, Visual Basic, PL1, COBOL, etc. No porque los vayas a utilizar, sino porque en este campo es posible que te topes algún día con código que debas entender y que no estará escrito en C. Además, notarás que cuando vayas por el cuarto o quinto lenguaje, que la mayoría se parecen unos con otros, y que los mismos patrones se repiten en casi todos. Por ejemplo, si estoy aprendiendo un lenguaje nuevo, y necesito hacer algo como buscar una palabra dentro de una frase, lo último que trato de hacer es escribir yo mismo el código, sino que trato de adivinar si existe una función que ya haga eso similar a como se hace con otros lenguajes. 8. Entender bastante bien lo que es un API, y como leer documentación sobre ellos, así como proveer tu propio API a otros programadores. 9. Dependiendo de tu campo, es importantísimo aprender sobre al menos Sockets y HTTP para programar aplicaciones de redes, así como entender la diferencia entre TCP y UDP, y cuando utilizar cada protocolo. 10. Haber programado al menos unas cuantas veces al mas bajo nivel posible (cuando menos con Assembly Language en un micro-controlador) es de una utilidad que no se pueden imaginar hasta el día que les haga falta. Por ejemplo, programar en C tiene muchas repercusiones a bajo nivel que se entienden mejor cuando uno sabe Assembly/Machine Language, ya que entienden mejor los conceptos de punteros, registros, etc. En mi caso, por mas alto nivel que sea el lenguaje de programación (como Coldfusion, Javascript o Java), siempre estoy consciente de lo que ocurre "tras bastidores" a bajo nivel, lo que me ayuda a diagnosticar problemas que de otra forma hubiera sido casi imposible o tomado muchísimo tiempo de investigación. Técnicas Avanzadas Como dije, esas son las cosas básicas que como mínimo recomiendo aprendan. Sin embargo, cuando entren al mundo laboral, en particular si terminan haciendo trabajos para grandes empresas o multi-nacionales, notarán que les hacen falta mas conocimientos específicos, y algunos de esos que me vienen a la mente ahora son: 1. Cómo integrar sistemas construidos bajo diferentes plataformas. Hay decenas de formas, que van desde integración a nivel de base de datos, hasta screen-scraping, o integración a través de archivos planos (bastante feo) hasta integración por servicios web. En este tema herramientas como Java y XML ayudan mucho en algunos casos. 2. Entender el concepto de un JIT (Just-In-Time Compiler) y entender cómo funciona. Esto es muy importante con temas de Java, .Net y mas recientemente con Javascript, y de paso les permitirá escribir código mucho mas eficiente. 3. Entender temas de Máquinas Virtuales (como la JVM - Java Virtual Machine), pues muchas veces no podrás corregir errores en tus aplicaciones si no tienes una intuición sobre lo ocurre tras bastidores (como por ejemplo, con el uso de la memoria). Así mismo, y relacionado a esto, entender los temas de Garbage Collection (Recolectores de Basura) en relación a las VM. 4. Es importante saber algunos temas básicos de seguridad, como Certificados Digitales, lo que es un Hash, cifrado simétrico vs asimétrico, SSL, etc. 5. Entender el concepto de un Connection Pool, que es un tema crítico para escalar aplicaciones a grandes cantidades de usuarios, en particular cuando se aplica a base de datos, aunque también aplica a objetos en memoria, y es muy utilizado en conexiones de redes. 6. Entender el concepto de Connection Polling (no confundir con Connection Pool) que en muchos casos nos ayuda a crear protocolos bi-direccionales cuando uno de dos extremos no puede iniciar una conexión al otro lado. Esta es la manera principal como funciona GMail y programas de chateo por páginas web. 7. Entender el concepto de un Message Queue, así como cuándo utilizar un Buffer en su mas amplia definición. 8. Entender conceptos de replicación de datos, servidores redundantes, etc. 9. Entender conceptos como DNS, DNS dinámico, etc. 10. Tu arma mas poderosa será la de copy-paste. No reinventes la rueda. Si alguien ya resolvió el mismo problema que tratas de resolver y ofrece su código o algún componente, utilízalo. Aquí Google y la documentación de tu entorno de desarrollo son tus mejores amigos. Para que tengan idea, yo diría que entre el 40 y el 80% del código que yo escribo hoy día (dependiendo del proyecto) lo copio de proyectos anteriores que he realizado, y el resto es código muy específico al proyecto que estoy trabajando. 11. Saber Linux te podría abrir muchas puertas y resolverte muchos problemas, sí como permitirte aprender de conceptos de bajo nivel en sistemas operativos. 12. Recuerden que algunos de estos temas ya los he tratado en eliax, por lo que pueden hacer búsquedas dentro del blog a ver si encuentran un punto de partida para aprender algunos de estos temas. Además es posible que quieran visitar la sección de Software en eliax. - Pues eso es lo que se me ocurre en estos momentos. Si se me ocurre otra cosa (o alguien pone algo interesante en los comentarios) quizás actualice la lista para agregar unas cuantas cosas mas. Por ahora, espero que esto sea de utilidad para algunos de ustedes... Y como siempre, pueden acceder a mas artículos similares en la sección de "Pregunta a eliax", y enviar sus preguntas por este medio. autor: josé elías |

|

|

|

|

|

lunes, abril 27, 2009

|

El Presidente de los EEUU, Barack Obama, acaba de dar una charla hoy ante la National Academy of Sciences de esa nación, y acaba de prometer que los EEUU dedicará el 3% de su Producto Interno Bruto (PIB) al avance de la ciencia y la tecnología e investigaciones de punta en ambos. El Presidente de los EEUU, Barack Obama, acaba de dar una charla hoy ante la National Academy of Sciences de esa nación, y acaba de prometer que los EEUU dedicará el 3% de su Producto Interno Bruto (PIB) al avance de la ciencia y la tecnología e investigaciones de punta en ambos.Hablamos de una cifra anual actual de unos US$420,000 Millones de dólares. Como dijo él en su discurso, los EEUU se han destacado en ser líderes y no en seguidores, y es hora de afianzar ese sentimiento e invertir en grande para mantener el liderazgo durante los próximos 50 años. Obama incluso mencionó explícitamente la importancia de un programa espacial mas avanzado que el actual. Agregó que aunque muchos estén en desacuerdo en invertir dinero en la ciencia en estos momentos de crisis financiera, que él "está fundamentalmente en desacuerdo" con eso, ya que "La Ciencia hoy mas que nunca es lo mas esencial para nuestra prosperidad, seguridad, salud, medio ambiente y calidad de vida." Solo me pregunto, ¿cuándo llegarán Presidentes con esta mentalidad visionaria a Ibero-América? Fuente de la noticia Previamente en eliax: 10 lecciones sobre la vida, por Albert Einstein (Enero 2008) Barack Obama da un discurso que será recordado en la historia (Marzo 2008) autor: josé elías |

|

|

|

|

|

lunes, abril 6, 2009

|

Esta pregunta de hoy la pueden considerar una continuación a lo que escribí ayer en este artículo que les mostraba un video de lo que verían ustedes con sus ojos si un Agujero Negro se los tragara, por lo que recomiendo lean ese artículo primero (es bastante breve) antes de continuar leyendo aquí, ya que explica brevemente lo que es un Agujero Negro, y de cómo este distorsiona el espacio con su masa. Esta pregunta de hoy la pueden considerar una continuación a lo que escribí ayer en este artículo que les mostraba un video de lo que verían ustedes con sus ojos si un Agujero Negro se los tragara, por lo que recomiendo lean ese artículo primero (es bastante breve) antes de continuar leyendo aquí, ya que explica brevemente lo que es un Agujero Negro, y de cómo este distorsiona el espacio con su masa.Regresando a la pregunta de hoy, ¿pero, y qué es la gravedad? A simple vista la definición de la gravedad es "lo que hace que las cosas caigan", como si tiráramos una manzana hacia el aire, esta eventualmente regresa al piso. Para entender lo que es la gravedad hay que entender que según Einstein y su Teoría de la Relatividad, el Universo en realidad es como una gelatina, la cual puede moldearse y "pincharse" y "apretarse" y "expandirse" según las fuerzas que hagan estas acciones. Lo que crea estas distorsiones es la masa de los objetos. Mientras mas masivo es un objeto, mas distorsiona el espacio-tiempo del Universo a su alrededor. Es como si tuviésemos una gelatina del tamaño de una cama, y encima de ellos pudiéramos una bola de boliche. Esta ejercería una gran distorsión en su centro, "hundiéndose" en el medio de la gelatina. Similarmente, si ponemos una bola de futbol, aun esta tiene un tamaño muy similar a la de boliche, esta no se hundiría tanto como la bola de boliche, ya que pesa mucho menos. En otras palabras, lo que importa es cuan masivo es un objeto, no su tamaño. Y siguiendo el ejemplo, si cerca de la bola de boliche, ponemos un bola de ping pong, y empujamos esta bola de ping pong alrededor del embudo creado por la bola de boliche, esta empezaría a dar vueltas alrededor de la bola de boliche, similar a como lo hace un bola en la ruleta de un casino. Pues estas distorsiones del espacio-tiempo, es lo que es la gravedad. Cuando Newton derivó sus "Leyes Universales", este asumió que el espacio era absoluto, y teorizó que la gravedad era en realidad un efecto de partículas llamadas "gravitones" que interactuaban entre un objeto y otro. Sin embargo, hoy sabemos que la gravedad en realidad es una distorsión en el espacio-tiempo relativo de Einstein, por lo que la razón por la cual estamos parados sobre la Tierra, y no nos vamos "flotando" hacia el espacio exterior, es porque la Tierra tiene tanta masa en comparación a nosotros, que esta ha literalmente curvado el espacio a su alrededor (como lo hace la bola de boliche en relación a la bola de ping pong), y nosotros estamos constantemente "cayendo" hacia su centro, como lo haría la bolita de ping long alrededor del embudo creado por la bola de boliche, y lo único que detiene esa caída es el suelo mismo en donde pisamos. Algo curioso es que todo en el Universo crea estas distorsiones, pero estas no las notamos porque solo nos son aparentes en grandes campos gravitacionales. Por ejemplo, nuestro Sol también "curva" las luces de las estrellas antes de que estas lleguen a nosotros (cosa que predijo Einstein y que fue verificado posteriormente con un eclipse total de Sol). Inclusive, nuestros mismos cuerpos curvan el espacio-tiempo, así como lo hace cualquier otro objeto que tenga masa, pero nosotros lo hacemos de una manera tan sutil que es para todos los fines prácticos imperceptible. Ahora, algunos se preguntarán, ¿pero por qué no "caen" los planetas hacia el Sol y se destruyen contra él? Pues la realidad es que eso es precisamente lo que está sucediendo, aunque no es tan sencillo entenderlo a simple vista. Lo que ocurre es que en cierto punto cuando se creó el Sol, este surgió de unos grandes estallidos, que por la naturaleza de la explosión hizo que "las cosas giraran". Alrededor del Sol terminó una gran nube de polvo. Estos pedazos de polvo cósmico (noten que literalmente "polvo cósmico", pues provino de las estrellas) se empezaron a unir unos con otros debido a su atracción gravitacional, formando pedazos cada vez mas grandes hasta formar planetas, y continuar "girando" en torno al Sol. Sin embargo, hay que entender también que la masa de estos planetas le da una inercia (o energía cinética) bastante grande, por lo que ni es fácil detenerlos, ni es fácil cambiarles el curso. Es decir, si se imaginan el ejemplo de una bolita en una ruleta de casino, es intuitivo que esta pronto caerá al centro. Pero si nos imaginamos ahora una rueda de ruleta de 1 kilómetro de ancho, con una bola de 10 metros de ancho, girando a cierta velocidad, es fácil también imaginarnos que esa gran bola no se detendrá fácilmente, y que podría tardar varios minutos, o incluso horas y días antes de que su energía se agote y esta reduzca su velocidad y caiga al centro de la ruleta. Pero aquí hay otro componente: No solo todo depende de la masa, sino que de la "velocidad de escape" también. Así que por ejemplo, si volvemos a la pequeña bolita en una ruleta de casino, y en vez de tirar la bolita con las manos para que empiece a girar la tiramos con una escopeta, es también fácil de imaginarnos que esta en vez de eventualmente llegar al centro de la ruleta, es mas lógico que esta salga expulsada de la ruleta para nunca regresar debido a la velocidad con la cual fue lanzada. Pues similarmente, hay que entender que nuestro Sistema Solar surgió hace miles de millones de años, y en esos inicios hubieron planetas que se escaparon del Sol debido a su velocidad, así como hubieron otros que fueron tragados por el Sol debido a que tenían poca energía cinética. Inclusive existen pruebas de colisiones anteriores entre algunos de los planetas que han quedado hoy día con otros ya desaparecidos. Habiendo dicho eso, los planetas que tenemos son los que han quedado mas o menos en "equilibrio". Es decir, no van tan lentos como para ser tragador por el Sol, ni tan rápidos como para ser expulsados, lo que significa que tardarán centenares o miles de millones de años para que estos pierdan tanta energía como para no poder resistir mas los efectos del Sol. Nota adicional: Habrán notado que utilizo la palabra "espacio-tiempo" y no solo "espacio". Eso se debe a que la gravedad también distorsiona el tiempo junto al espacio, de modo que los objetos que sienten una gran atracción gravitacional experimental el tiempo a un ritmo diferente en relación a objetos fuera de estos campos. Inclusive, sabemos por las ecuaciones de Einstein que la aceleración y estos campos gravitacionales son equivalentes en cuanto a sus efectos en el tiempo, por lo que viajar cerca de la velocidad de la luz produce los mismos efectos de dilatación de tiempo que producen campos gravitacionales en torno a un Agujero Negro. Y como siempre, pueden acceder a mas artículos similares en la sección de "Pregunta a eliax", y enviar sus preguntas por este medio. autor: josé elías |

|

|

|

|

|

sábado, abril 4, 2009

|

|

Un Agujero Negro es uno de los objetos mas fascinantes y extremos del Universo. Este no es nada mas que una estrella que colapsó sobre sí misma debido a sus propios efectos gravitacionales (es como si el suelo debajo de nuestros pies empezara a "caer" hacia el centro de la Tierra debido a la atracción de su centro), creando una masa tan compacta y masiva, que esta termina "doblando" el espacio-tiempo a su alrededor.

Lo curioso de estos objetos sin embargo es que tienen unos campos gravitacionales tan intensos, que nada que se les acerque escapa a su "horizonte de eventos" (o para decirlo en términos mas entendibles, a su "atmósfera"). Esto incluye inclusive la luz, la cual es desviada a su interior sin poder salir, lo que hace que estos objetos no emitan luz y por tanto se les denomine "agujeros negros", ya que a simple vista aparentan invisibles. Así que hoy los dejo con este asombroso video que se creó en base a una simulación de las ecuaciones de Einstein, que muestra qué vería un ser humano mientras este es "tragado" por un Agujero Negro. Obviamente un ser humano fallecería (sería estirado como una tira de hule) antes de ver todo lo que vemos en el video, pero eso es lo bueno de la simulación, que nos permite ver cosas que de otra manera no pudiésemos ver. El video fue creado por Andrew Hamilton y Gavin Polhemus de la Universidad de Colorado en Boulder, EEUU. Este es un video tan interesante como otro que les puse aquí en eliax hace 4 años que les muestra lo que veríamos al viajar a la velocidad de la luz. Nota sobre lo que ven en el video: Notarán que en el video las imágenes aparecen como si fueran "curvadas", similar a lo que vemos por un "ojo de pescado" en una puerta de seguridad. Esa distorsión no es un error o una forma de "conceptualizar" lo que veríamos, sino que es verdaderamente la manera en como veríamos el Universo, ya que el campo gravitacional del Agujero Negro distorsiona el espacio (y el tiempo) a su alrededor. Esto es similar a que si pusiéramos una pesada bola de boliche en el medio de tu cama, y esta creara un curvatura (o agujero) en el medio de la sábana. No dejen de visitar mañana para un artículo que tiene que ver mucho con este, en donde contestaré en detalle la pregunta "¿Qué es la Gravedad?". Video a continuación... autor: josé elías |

|

|

|

|

|

martes, marzo 31, 2009

|

Si tienes una gran idea, o ya tienes desarrollado un producto o servicio revolucionario, y necesitas capital y otros recursos para lanzarla al mundo, Google quiere ayudarte. Si tienes una gran idea, o ya tienes desarrollado un producto o servicio revolucionario, y necesitas capital y otros recursos para lanzarla al mundo, Google quiere ayudarte.La empresa acaba de hacer público a Google Ventures, una división de Google encargada de financiar proyectos novedosos en todos los renglones (desde software hasta robótica, desde bio-ingeniería hasta nano-tecnología). Obviamente la idea es que Google obtenga algún beneficio de esto a largo plazo, pero si de paso tu también obtienes lo que quieres, y el mundo se mejora por tu idea, entonces todos ganamos... Enlace a Google Ventures autor: josé elías |

|

|

|

|

|

viernes, marzo 27, 2009

|

|

Si eres educador o estudiante es muy posible que quieras visitar una sub-sección dentro de YouTube llamada "YouTube EDU" en donde Google ha combinado dentro de un solo lugar de YouTube todos los recursos visuales de entidades educacionales tan prestigiosas como StandFord, MIT, Harvard, UCLA y Berkley, para el consumo gratuito de todos.

Y como dicen en la fuente, esta es una buena manera de complementar además el esfuerzo de Apple con su "iTunes U" (es decir, Universidad iTunes), en donde puedes descargar varios videos de cursos de todo tipo directamente a iTunes en tu PC, o mejor aun, a tu iPod o iPhone para aprender en cualquier lugar que tengas tiempo de hacerlo. Una cosa importante es darle gracias a MIT por haber sido la institución pionera en este tipo de esfuerzos con su MIT OpenCourseWare. ¡Gracias a Manuel Bretón por este útil enlace! Enlace a YouTube EDU Enlace a iTunes U MIT OpenCourseWare (cursos del Instituto de Tecnología de Massachussetts disponibles gratuitamente por Internet) Fuente autor: josé elías |

|

|

|

|

|

miércoles, marzo 25, 2009

|

A inicios del mes en curso, para la Semana Experimental escribí un artículo titulado "Pregunta a eliax: ¿Qué se sentirá vivir como un ser artificial?", y después de leer algunos comentarios noté que esta era una excelente oportunidad para hablar de algo que siempre quise hablar, y que creo iluminará (y sorprenderá) a muchos sobre las sutilezas de la naturaleza. A inicios del mes en curso, para la Semana Experimental escribí un artículo titulado "Pregunta a eliax: ¿Qué se sentirá vivir como un ser artificial?", y después de leer algunos comentarios noté que esta era una excelente oportunidad para hablar de algo que siempre quise hablar, y que creo iluminará (y sorprenderá) a muchos sobre las sutilezas de la naturaleza.Lo que me inspiró escribir esto fue un comentario que decía algo similar a esto: "No confundir capacidad de procesamiento con inteligencia e innovación, uno por procesar 3,000 Trillones de operaciones por segundo no es mas inteligente que el que solo procese 3,000 por segundo, únicamente tardara menos en procesar la información." A simple vista para alguien que no tenga conocimientos detallados de matemáticas y computación, esto aparenta tener mucho sentido y ser un argumento bastante contundente, pero al igual que la Mecánica Cuántica, la realidad de las cosas a veces es bastante diferente de lo que nuestros instintos nos llevan a creer... Sucede, que esa aserción es errónea. Si habláramos de una diferencia mínima, digamos, de procesar 1,000,000 de operaciones por segundo (OPS), y procesar 1,050,790 OPS, la aserción estaría mayoritariamente correcta, pero el problema (o el "momento ¡Eureka!") viene cuando uno trata de poner eso en práctica. Es decir, cuando uno trata de implementar un sistema que procese 1,000 OPS, y otro que procese 1 Trillón de OPS. Es similar a lo que sucede con la Teoría de la Relatividad. Uno asumiría que si voy manejando en un auto a 100kph, y hay otro auto que viaja en dirección contraria y acercándose a mi a 30kph, que la velocidad de acercamiento es de 130kph. Pero también uno asumiría que si voy en una nave espacial a 100,000 km por segundo (km/s), y un rayo de luz viaja en dirección opuesta a mi a 300,000 km/s, que la velocidad con la que "le pasaré de lado" al rayo será de 400,000 Km/s, cuando eso no es cierto (seguiríamos viendo el rayo de luz a 300,000 km/s, y sería el tiempo lo que se dilataría). Inclusive, en el primer ejemplo, la respuesta no es realmente 130kph, sino que varía por una fracción casi imperceptible, pero asumimos que 130km/s es "una aproximación suficiente para la vida práctica". Sin embargo, es en estas pequeñas diferencias que empezamos a ver los estragos de la Teoría del Caos. Similar a lo que ocurre con la Teoría de la Relatividad con grandes velocidades que se aproximan a la de la luz, lo mismo vemos en cualquier sistema de computación que sobrepase de una cierta escala. Esto se debe a que mientras más grande y extenso es un sistema, más son las posibilidades de fluctuaciones cuánticas, mas complejo debe ser el sistema que coordine todo, y mas "caos" es introducido al sistema. Es decir, y para poner un ejemplo práctico, no es el mismo circuito que tú diseñarías para implementar un simple "sumador" de 2 bits en un chip, que el circuito necesario para crear un sumador de 1 trillón de bits. El de 1 trillón de bits necesitará de lógica adicional que incluye posiblemente un sistema de almacenamiento temporal, reconocedores de patrones para acelerar la suma, predicciones de salto de ejecución, etc. Es decir, con el incremento de escalas numéricas se incrementa necesariamente la complejidad de un sistema, y mientras más complejo es un sistema más propenso es a ser no-determinístico, y mientras menos determinístico es un sistema, más caótico es este. Noten que esto no es nada nuevo ni reciente. Esto se sabía muchísimo antes de la computación moderna, solo que en tiempos modernos el concepto fue popularizado por científicos como Benoît Mandelbrot (famoso por esas imágenes fractales que muchos han visto), y Stephen Wolfram (por su trabajo en Cellular Automata). Es por eso que es incorrecto pensar que si tomamos un sistema simple, y lo escalamos a gran tamaño, que este se comportará igual. Un buen ejemplo que no tiene que ver con matemáticas es un ladrillo. Podemos hacer una casa poniendo un ladrillo sobre otro, y eso funcionaría bastante bien, pero si tratamos de construir un rascacielos ya nos podemos imaginar que estos colapsarán. La única manera de construir un rascacielos con ladrillos es si introducimos mas complejidad en el sistema, es decir, vigas de acero, concreto armado, etc. Otro ejemplo concreto y más relacionado a nosotros es el mismo cerebro. Muchas personas se sorprenden al saber que de todos los animales de la Tierra, el cerebro humano no solo es el mas inteligente, sino que el más grande en volumen y masa (actualización: bueno, el chacalote tiene un cerebro mas grande como dice el lector Geek :), pero eso no quita que por lo general mientras mas grande es el cerebro, en particual en relación a su masa corporal, más inteligente es la criatura - en el caso de humanos somos la criatura con las interconexiones más compleja de su cerebro en el planeta). Es decir, nuestro cerebro es mayor incluso que los más grandes dinosaurios que jamás rondaron la Tierra. Sin embargo, alguien posiblemente dirá "¡Ah, pero lo que nos hace inteligentes no es solo el tamaño del cerebro, sino que su estructura!", y precisamente, ese es un argumento a favor de todo esto que estoy diciendo, pues así como necesitamos de vigas de acero y concreto para poder escalar de una casa a un rascacielos, así mismo el proceso inherente que hizo que incrementara el tamaño de nuestro cerebro necesitó de crear nuevas estructuras que soportaran este mayor tamaño. Esa es una de las razones de por qué el cerebro de un perro es más inteligente que el de un mosquito (el del perro es más grande y complejo), y el de un hombre es más inteligente que el de un perro. Habiendo dicho todo eso, es por eso que es erróneo también el decir que por tan solo porque se están construyendo super computadoras que serán cuatrillones de veces más rápida que una calculadora de bolsillo, que esta no vaya a ser más inteligente, y que ambas son equivalentes, y que dado suficiente tiempo la de bolsillo puede hacer cualquier cosa que la super-computadora haría. Simplemente ese no es el caso. Y es esa la razón también por la cual (como veremos en una noticia que saldrá mañana en eliax) verán como la nueva generación de super-chips que planean emular el cerebro humano tanto en capacidad "bruta" como en inteligencia, están haciéndose cada vez mas complejos, combinando elementos del mundo analógico con el digital. Y es de esta complejidad inherente en el sistema que eventualmente obtendremos un sistema no-determinístico al igual que el cerebro humano. Un cerebro artificial. autor: josé elías |

|

|

|

|

|

miércoles, marzo 18, 2009

|

Cuando menos alguna vez en la vida la mayoría de nosotros hemos realizado el siguiente ejercicio mental: ¿Qué pasaría si tomamos un segundo y lo dividimos en la mitad (es decir, en medio segundo), y después hacemos lo mismo para obtener un cuarto de segundo, y lo seguimos dividiendo más y mas, llegando hasta posiblemente el infinito? Cuando menos alguna vez en la vida la mayoría de nosotros hemos realizado el siguiente ejercicio mental: ¿Qué pasaría si tomamos un segundo y lo dividimos en la mitad (es decir, en medio segundo), y después hacemos lo mismo para obtener un cuarto de segundo, y lo seguimos dividiendo más y mas, llegando hasta posiblemente el infinito?Ese es uno de esos ejercicios que sin duda ponen a prueba no solo nuestra imaginación, sino que los límites de nuestra capacidad mental. A simple vista el ejercicio aparenta tener una solución sencilla, pues si alguien pregunta ¿y donde termina esto? la respuesta más obvia es decir que "nunca" ya que el tiempo simplemente se volvería más corto. Sin embargo, hay un límite conocido, y lo llamamos el Planck Time o Tiempo Planck, y es la unidad de tiempo más corta que puede "existir", o más específicamente, que pueda tener sentido. Para entender el Tiempo Planck, hay que entender primero un concepto relacionado, la Longitud Planck. Similar al tiempo, podemos hacer un ejercicio mental en donde tomamos un metro y lo dividimos en dos, y después en dos mas, y así sucesivamente, preguntándonos una vez más hasta donde llegaremos, si hay un final o no, o si todo continúa hasta el infinito. Pues similar al Tiempo Planck, existe un límite de distancias al que llamamos el Planck Length o la Longitud Planck, que según los cálculos en la Mecánica Cuántica es la distancia más pequeña que "tiene sentido" en el mundo cuántico o "clásico". Habiendo dicho eso, el Tiempo Planck es entonces el tiempo que le tomaría a un fotón de luz viajando a la velocidad de la luz viajar una distancia igual a la Longitud Planck (es decir, la longitud más corta que un fotón puede viajar en este Universo). Este lapso de tiempo se conoce con mucha precisión y es exactamente igual a 10-43 segundos, o en términos más familiares un 0.0000000000000000000000000000000000000000001 segundo. Noten que esto no significa que no existan otras cosas que compongan las cosas más pequeñas que podamos medir, sino que estas son las más pequeñas que conocemos en el Universo tal cual lo percibimos y lo podemos medir. Esto último es un tema bastante profundo del cual les pienso hablar en un futuro, pues es sumamente interesante (es decir, el tema de cómo percibimos el mundo y las distintas teorías de lo que podría componer "la realidad" que nuestras mentes perciben). Y como siempre, pueden acceder a más artículos similares en la sección de "Pregunta a eliax", y enviar sus preguntas por este medio. autor: josé elías |

|

|

|

|

|

lunes, marzo 9, 2009

|

Stephen Wolfram, el mismo Wolfram detrás del popular programa Mathematica utilizado por cientos de miles de matemáticos y científicos de todo el mundo, y el escritor de uno de mis libros favoritos (A New Kind of Science) acaba de anunciar que en Mayo del 2009 lanzará el primer buscador de Internet que literalmente responderá de manera decisiva las preguntas que les hagas. Es decir, si le preguntas algo, recibes una respuesta directa, en vez de una lista de páginas con las respuestas. Stephen Wolfram, el mismo Wolfram detrás del popular programa Mathematica utilizado por cientos de miles de matemáticos y científicos de todo el mundo, y el escritor de uno de mis libros favoritos (A New Kind of Science) acaba de anunciar que en Mayo del 2009 lanzará el primer buscador de Internet que literalmente responderá de manera decisiva las preguntas que les hagas. Es decir, si le preguntas algo, recibes una respuesta directa, en vez de una lista de páginas con las respuestas.No confundan esto con lo que hacen buscadores como Google que a sencillas preguntas responde de una vez (como este ejemplo), sino que esta buscador (o mas bien "contestador") en realidad responderá a tus preguntas, muy similar a la computadora HAL-9000 de la película 2001 Odisea del Espacio, utilizando los últimos avances de la ciencia de computación del momento, en este caso desarrollados por los científicos que colaboran con el mismo Wolfram. En este caso, Wolfram|Alpha funcionará computando la respuesta, y no buscando la respuesta en una base de datos de preguntas y respuestas predefinidas como hacen Google, Ask y otras herramientas. Wolfram|Alpha litealmente entenderá la pregunta y buscará la respuesta para dártela, en tu caso en particular. Como todo lo que hace Wolfram, ya pueden esperar que las expectativas estarán bastante altas con este buscador, al cual han bautizado "Wolfram|Alpha", y el cual saldrá públicamente en Mayo del 2009... Página oficial de Wolfram|Alpha autor: josé elías |

|

|

|

|

|

miércoles, febrero 4, 2009

|

Un tema recurrente en eliax, es de La Singularidad, que es el momento en que la tecnología avance tan rápidamente, que inevitablemente surja una Inteligencia Artificial (IA) capaz de crear mas IAs aun mas avanzadas, y eso hasta el donde el horizonte nos lleve. Un tema recurrente en eliax, es de La Singularidad, que es el momento en que la tecnología avance tan rápidamente, que inevitablemente surja una Inteligencia Artificial (IA) capaz de crear mas IAs aun mas avanzadas, y eso hasta el donde el horizonte nos lleve.Cuando ese momento llegue, ocurrirá la transformación mas grande que toda civilización pueda dar en el Universo, y se estima que en menos de un siglo (muchos estiman que en menos de 50 años) ese momento ocurrirá en la Tierra, dado en la etapa en que estamos con avances tecnológicos y científicos ocurriendo a un ritmo sin precedentes. Ahora, Google y la NASA se han aliado para crear la "Singularity University", un centro educacional creado explícitamente para enseñar temas que tienen que ver con la Singularidad. Uno de los pioneros detrás de esta inicitativa es Ray Kurzweil (a quien referencio en mi libro Máquinas en el Paraíso en donde explico también estos temas de la Singularidad), que es la persona mas conocida en el mundo con este tema, y que será sin duda uno de los exponentes en tal universidad. La idea es que esta institución ofrezca un programa de 9 semanas a 120 estudiantes, los cuales tendrán que pagar la suma de US$25,000 dólares cada uno. Además la universidad patrocinará cursos de 3 y 10 días a altos ejecutivos. Entre los docentes se encontrarán personalidades como Vint Cerf (la persona mas directamente llamada como "el padre del Internet"), Will Right (el creador de simuladores como Los Sims y Spore), y además varios ganadores de Premios Nobel. La misión de la universidad será acelerar las tecnologías actuales con el propósito de llegar mas rápidamente a la Singularidad, por lo que me imagino habrá mucha discusión sobre tecnologías para IA. Los planes son construir la universidad en el Bay Area de San Francisco, EEUU. Fuente de la noticia Máquinas en el Paraíso Actualización: Enlace a la página oficial de la Singularity University autor: josé elías |

|

|

|

|

|

jueves, enero 29, 2009

|

Hoy pienso responder a algunas incógnitas que algunos de ustedes tienen sobre la relación y diferencia entre los parámetros de ISO, Apertura y Velocidad en cámaras digitales. Aunque este artículo es en especial para aquellos que quieran aprender mas sobre los modos manuales de sus cámaras, en particular las del tipo SLR/D-SLR (es decir, las que por lo general son de lentes intercambiables), lo cierto es que todo aquel que tenga una cámara digital, por mas sencilla que esta sea, es posible que aprenda algo de este "mini curso en un artículo". Hoy pienso responder a algunas incógnitas que algunos de ustedes tienen sobre la relación y diferencia entre los parámetros de ISO, Apertura y Velocidad en cámaras digitales. Aunque este artículo es en especial para aquellos que quieran aprender mas sobre los modos manuales de sus cámaras, en particular las del tipo SLR/D-SLR (es decir, las que por lo general son de lentes intercambiables), lo cierto es que todo aquel que tenga una cámara digital, por mas sencilla que esta sea, es posible que aprenda algo de este "mini curso en un artículo".Empezaré contándoles que en los días que me compré mi primera cámara (no era digital), también me compré un libro de fotografía ya que justamente quería aprender sobre los temas que comparto hoy con ustedes, y la verdad es que aunque aprendí lo que cada uno de los distintos elementos de la fotografía significaban (ISO, Apertura, Velocidad, f-stop, exposición, etc), aun me quedé con esa sensación en ese entonces de que todavía no entendía la relación entre todos ellos, y en este artículo espero poder enseñarles en unos párrafos lo que he aprendido en el tiempo con la experiencia. Hablaremos de cada uno de los conceptos importantes, no desde el punto de vista de un fotógrafo, sino desde el punto de vista de alguien que no sabe absolutamente nada al respecto y quiere aprender. Antes de empezar notemos que las cámaras analógicas (de "royos" o "de película") y las digitales son bastante similares entre sí. La única gran diferencia es que en una cámara digital la foto es captada por un sensor electrónico, mientras que en una cámara clásica la foto es captada sobre una cinta de película por un proceso químico. Aparte de eso casi todos los controles electrónicos de hoy día en las cámaras digitales modernas se venían utilizando por años (sino décadas) en cámaras analógicas, como enfoque automático, exposición automática, etc. Por tanto, casi todo lo que hablaremos hoy aplicará a cualquier tipo de cámara, salvo las excepciones que citaré. VELOCIDAD El primero concepto del cual vamos a hablar es Velocidad. En la fotografía, la Velocidad no es nada mas que por cuanto tiempo la cámara permitirá que pase luz por el lente de la cámara hasta su sensor. Para permitir que pase luz, la cámara tiene un sistema de "compuerta circular" que se cierra y abre. Cuanto mas tiempo esta compuerta esté abierta, mas tiempo durará la cámara "captando la foto", y cuanto más tiempo dure la cámara captando la foto, mas luz llegará al sensor. ¿Qué significa eso? Que si estás en un lugar oscuro, y quieres captar mejor la imagen, puedes decirle a tu cámara que dure mas tiempo captando la foto. En casi todas las cámaras puedes decirle que capte la imagen desde centésimas o milésimas de segundo, hasta varios segundos, y en algunas cámaras hasta varios minutos o indefinidamente. Así que por ejemplo, si quieres tomar una fotografía de las estrellas de noche, dile a tu cámara que dure varios segundos tomando la foto, y verás lo brillante que salen las estrellas. Inclusive es posible que tu cámara capte estrellas que no disciernes con tus propios ojos. Es importante notar que si utilizas una velocidad lenta para que entre luz por mucho tiempo a tu cámara (a esto se le llama "larga exposición", ya que la cámara está expuesta por mucho tiempo a la luz), que debes colocar la cámara en un trípode o en un lugar en donde esta no se mueva, ya que si mueves la cámara durante el proceso de tomar la foto, los movimientos de la cámara serán reflejados en la fotografía (aunque nota que para "efectos especiales", es interesante experimentar moviendo la cámara). Si haz visto fotografías en donde se ven automóviles en una autopista, con las luces de ellos "flotando" hacia el horizonte como si de un cometa se tratara, esa fue una foto de larga exposición. Inversamente, si tomas la foto bien rápido, es decir, con una rápida velocidad o "corta exposición" (ya que el sensor de la cámara está expuesto por corto tiempo a la luz), solo captarás una pequeñísima parte del tiempo, lo que es ideal para captar personas "congeladas" en el tiempo. Así que si por ejemplo quieres captar una gota de agua en el momento que esta hace contacto con el agua, lo que harías sería poner la cámara a que tome la fotografía a la velocidad más rápida que pueda la cámara. Ahora, aparte de la velocidad, ¿hay diferencia visual entre los dos modos? Pues ciertamente. Cuanto más rápido tomes la foto (es decir, mientras por menos tiempo esté la cámara captando luz), menos luz entrará al sensor, por lo que la escena que estés fotografiando es mejor que esté bien iluminada. Similarmente, en tomas de larga exposición, si la escena ya está bien iluminada antes de empezar a tomar la foto, entrará tanta luz al sensor (debido a que el sensor estará abierto por tanto tiempo captando luz) que es posible que la imagen se torne totalmente blanca. Así mismo, aun captes una imagen de larga exposición en un lugar que no esté muy iluminado, otro problema al que te enfrentarás es que cuanto más larga es la exposición, menos se puede mover lo que estás fotografiando. Un ejemplo clásico de este es tratar de fotografiar a un bebé en constante movimiento, el cual si tratas de fotografiar con esta técnica obtendrás una imagen borrosa del bebé, ya que durante toda la toma este se estuvo moviendo frente a la cámara conforme esta estuvo captando su imagen. APERTURA El segundo parámetro del cual vamos a hablar hoy es Apertura. ¿Recuerdan que les hablé de que la cámara tiene una "compuerta circular" que es la que se abre y cierra para permitir pasar o bloquear la luz a la cámara? Pues la razón que es circular es para que esta pueda cambiar de tamaño, creando o un "agujero grande" o un "agujero pequeño", mas todos los otros posibles tamaños de agujeros intermedios. En otras palabras, la cámara no simplemente abre y cierra esta compuerta, sino que además también la puede abrir a cualquier tamaño específico. Eso significa que hasta ahora hay dos parámetros a los cuales prestarle atención, la Velocidad (o cuanto tiempo mantener la compuerta abierta), y Apertura, que indica que tan abierta estará esta compuerta. Pero, ¿y por qué cambiarle el tamaño a esta compuerta? Es decir, ¿qué ganamos con poder cambiar el diámetro de la apertura entre el lente y el sensor? Hay mas de una respuesta a esta pregunta. Para empezar, ahora tenemos una nueva manera de restringir cuánta luz entra a la cámara (o lo equivalente, cuanta luz permitir entrar). Es decir, si por alguna razón nuestra cámara tiene una velocidad bien rápida y que capta poca luz, pero necesitamos que se capte menos luz aun, lo que podemos hacer es que aparte de poner la cámara en un modo de corta exposición, podemos también hacer que el agujero de la apertura sea lo mas pequeño posible, para que pase la menos cantidad de luz posible. Sin embargo, la Apertura en su uso del día a día tiene un uso mas útil, y es que nos permite controlar la "profundidad de campo" de la cámara. Esto significa, el poder hacer que una parte de la fotografía esté "enfocada claramente", y el resto que quede "fuera de enfoque". Esto es muy útil cuando por ejemplo queremos tomar una fotografía a una persona en un parque, y queremos que esa persona quede bastante bien definida, pero además queremos hacer que el fondo del parque se vea totalmente "borroso" para que así la atención se centre en la persona y no en el fondo de la imagen. La regla para lograr este efecto es esta: Cuanto más abierta está la Apertura, mas grande el "efecto borroso" será. Así que por ejemplo, si quieres lograr el efecto contrario, es decir, de que nada esté borroso y todo desde lo mas cercano a la cámara hasta lo mas lejano en el horizonte aparezca enfocado, en ese caso lo que harías sería cerrar la Apertura lo mas posible. Noten que por motivos que no voy a explicar aquí, los valores de Apertura vienen similar a estos (dependiendo de tu cámara): f1.4, f1.8, f2.4, ...... f8, f16, etc. Esto lo menciono ya que estos números no son intuitivos en el sentido de que cuanto mas grande es el número, menor es la Apertura, y similarmente, mientras mas pequeño el número, mayor la Apertura, por lo que el efecto mas "borroso" lo conseguirás (en este ejemplo) con una f1.4. Una nota final sobre Apertura y "efectos borrosos". El tamaño del sensor en sí también juega un papel importante para lograr el "efecto borroso" que a veces uno tanto busca. Mientras mas grande es el sensor, más fácil es lograr este efecto. Es por eso que se le dificulta a una cámara compacta lograr un efecto borroso, aun en una configuración de f1.8, mientras que una cámara DSLR con un gran sensor puede lograr un efecto borroso fácilmente hasta con 2.4 o superior. Esta es también la razón de por qué con cámaras de celulares por lo general todo está bien enfocado, ya que el sensor es tan pequeño que no permite desenfocar la imagen (que es lo que en realidad logra el efecto borroso). ISO El tercer concepto a entender es el de ISO. Esta no es nada mas que una manera sofisticada de decir "Sensibilidad". Cuando decimos Sensibilidad nos referimos a cuán sensible programamos el sensor para que capte la imagen, o mas bien dicho, cuánta luz puede captar el sensor en determinado tiempo. Cuanto más alta es la sensibilidad, mas sensible a la luz es el sensor. Una diferencia fundamental entre una cámara digital y una analógica, es que en la cámara digital el sensor está fijo en la cámara, y cuando cambias la sensibilidad lo que estás haciendo es "programando" al sensor para que pueda captar mas o menos luz. En el caso de una cámara analógica, no existe un sensor, sino que la imagen es plasmada en una película, por lo que es la película que compras con un valor de sensibilidad determinada. Así por ejemplo es posible que te acuerdes de los viejos tiempos en donde comprabas un royo de película con "ISO 200" (o 400, 800 o 1,600). También se le decía "ASA", como en "ASA 100" o "ASA 200". Pero, ¿y cómo se refleja en una fotografía distintos valores de ISO? Pues cuanto más alta programes la sensibilidad, mejor será el sensor captando luz, y cuanto más baja la sensibilidad, menos luz será captada. Y ahora a la próxima pregunta, ¿por qué cambiaría yo esta sensibilidad? Por dos razones fundamentales. Digamos por ejemplo que quieres captar una imagen en un ambiente oscuro, pero la Velocidad de la cámara llega solo a cierto límite para captar luz, y la Apertura solo abre hasta cierto límite para captar luz, y necesitas mas luz. La solución en este caso es incrementar el ISO de tu cámara para que esta sea mas "sensible" a la luz. Algunos ahora mismo se estarán preguntando, pero si esto de cambiar el ISO es tan fenomenal, y en la mayoría de los casos lo que quiero es captar mucha luz, ¿por qué cambiaría yo el valor de ISO? Y la respuesta es que al aumentar la Sensibilidad/ISO de la cámara, al mismo tiempo incrementas el "ruido visual" que se introduce en la fotografía. Este "ruido visual" se manifiesta como un efecto "arenoso" con muchos puntos que distraen un poco de la imagen, pero que conforme aumenta el ISO, deteriora la calidad de la imagen (aunque hay veces que uno intencionalmente ocasiona este ruido visual por motivos estéticos). Similarmente, un bajo ISO tiene el efecto adverso de producir imágenes bien "limpias" y perfectas, las cuales si les hace "zoom" en tu PC parecen mantener su fidelidad de colores sólidos y bien definidos. Una cosa a tener en cuenta es que similar a lo que puedes lograr con la Velocidad y Apertura para tomar fotos de objetos congelados en el aire a alta velocidad, que con el ISO también puedes hacer algo similar. Por ejemplo, si quieres una foto de un deportista pateando un balón, pero está oscuro por el atardecer, y por tanto no puedes incrementar la velocidad de la cámara ya que de lo contrario entraría muy poca luz, lo que puedes hacer es incrementar el ISO, para que el sensor sea mas sensible a la poca luz del lugar, y de esa manera puedes o (1) tomar la foto como antes y esta saldrá mas clara, o (2) aumentar la Velocidad ya que el ISO te acaba de dar un poco mas de luz que no tenías antes. En el día a día, el uso típico que uno le da al sensor es precisamente ese: Cuando necesitamos mas luz para lograr lo que queremos hacer con la foto, y ya no podemos obtener mas luz cambiando la Velocidad o la Apertura sin afectar la foto, lo que hacemos es incrementar el ISO, siendo el precio a pagar que la calidad de la imagen en sí es posible que se vea afectada un poco por ruido visual o "ruido digital". F-STOP ¿Ahora se preguntarán, y cómo cambio yo esos valores de Velocidad, Apertura e ISO? Pues por lo general si utilizas la cámara siempre en modo automático esta decide todos los valores por ti de manera automática, produciendo las tradicionales fotos familiares que todos poseemos. Sin embargo, si deseas tomar ventaja de lo que puede hacer tu cámara, y tomar fotos con efectos como fondos borrosos, personas congeladas en el aire, luces que se mueven en la foto, etc, entonces tendrás que dejar el modo automático y empezar a experimentar con los modos semi-manuales o puramente manuales. Los modos semi-manuales son los que por lo general se denominan "Aperture Priority" (AP) o "Speed Priority" (SP). No importa como lo llamen en tu cámara, lo que esto significa es que dependiendo del modo, la cámara te permite a ti ajustar un valor manualmente, y la cámara ajustará el otro de manera automática para que to foto salga "bien expuesta". Por ejemplo, en el modo de prioridad de velocidad, lo que haces es decirle a la cámara qué tan rápido o lento debe tomar la foto (es decir, la Velocidad), y la cámara se encarga de programar la Apertura (es decir, que tanto abrir o cerrar la compuerta circular de luz). Dependiendo de tu cámara, es estos modos semi-manuales también puedes ajustar un valor de ISO antes de tomar la foto, o dejar que la cámara elija el valor de ISO que crea apropiado, o una combinación de ambas, en donde la cámara elije un valor, pero sin pasarse de un valor máximo y/o mínimo predeterminado por ti. Cada vez que cambias uno de estos valores, lo que haces en el lenguaje de los fotógrafos profesionales es cambiando a lo que llaman el f-stop, por lo que si oyes hablar de f-stops ya saben a lo que se refieren. Noten que aunque el término de f-stop se utilizó originalmente para el valor de la Apertura de un lente, que actualmente tiene la connotación mas global que les doy acá. Lo interesante del concepto del f-stop es que es una medida útil para comparar cámaras y lentes en términos relativos. Por ejemplo, las cámaras baratas tienen mucho menos f-stops (o al menos f-stop utilizables que produzcan buenas fotografías) en comparación con cámaras de mucho mayor precio. Una cámara profesional te permite específicamente un mucho mayor rango de posibilidades de Velocidades, un mucho mayor rango de posibles Aperturas, y un mucho mejor rango de posibles valores de ISO que una cámara barata. Es preciso mencionar que aunque una cámara barata te diga que soporta un ISO de hasta 3200, que muy posiblemente una foto tomada con esa cámara sea de una calidad muy inferior que una tomada con ISO 800 en una cámara con un buen sensor. Para referencia, por lo general las cámaras toman buenas fotografías entre ISO 100 (o menor) hasta ISO 400 u 800. Las cámaras profesionales pueden tomar fotos decentes aun con ISO 1600 o incluso mayor. Pero volviendo a los f-stops, esto es algo que juega un papel fundamental en el momento de elegir equipos, y de prepararse uno a tomar una fotografía. Por lo general, lo que uno desea es poder poseer la mayor cantidad de f-stops posible (y de buena calidad), ya que esto te ofrece mas versatilidad a la hora de tomar fotografías. Por ejemplo, si con una cámara barata quieres fotografiar a un artista en un concierto de rock, es posible que con las combinaciones posibles de Velocidad, Apertura e ISO de tu cámara no puedas captar al artista claramente sin que este se vea "movido" o la calidad de la imagen sufra mucho, pero con otra cámara es posible que tengas uno o dos f-stop mas de Velocidad, lo que significa que puedes aumentar la velocidad de la cámara sin sacrificar la cantidad de luz que entra al sensor en relación a la otra cámara. Similarmente es posible que con otra cámara "ganes un f-stop" en Apertura (es decir, que el lente abra mas que la otra cámara en relación al sensor de cada cámara), lo que logra el mismo efecto de permitir mas luz con la misma velocidad. Este tema del f-stop es extremadamente importante a la hora de uno elegir un lente. Cuanto más caro es el lente por lo general es porque soporta mas f-stops, o mas bien dicho, que su Apertura es mas grande, y que el tipo de cristal utilizado es de una calidad tal que permite pasar mucho mas luz que un lente ordinario. Así que cuando alguien te dice que con tal lente ganas un f-stop en relación a otro lente, ya sabes de qué están hablando. Una nota sobre lentes: No importa que tan potente sea tu cámara, si no tienes un buen lente, estarás desperdiciando el potencial de tu cámara. Esto es fácil notar al tomar una fotografía con un lente de una cámara barata de esas portátiles y una de las profesionales con uno de esos lentes grandes. Aunque ambos tengan valores similares de acercamiento, a la hora de uno ver la calidad de las fotos la diferencia se hará bastante obvia. Cuanto mejor es el lente, mejor la calidad de la imagen ya que mejor se capta la luz, y al fin y al cabo todos los controles de una cámara lo único que hacen es manipular luz, por lo que cuanto mejor manipules la luz con buenos lentes, mejor la definición, claridad y distorsión de las fotos. Noten que existen lentes que son mucho mas caros que las cámaras mismas en donde se montan, esto debido a lo caro y preciso que es el proceso de fabricación de tales lentes (aunque honestamente, a veces me parecen abusivos los precios). Finalmente, sobre lentes es importante que sepan lo que los profesionales quieren decir cuando dice que un lente es "rápido" (o un "fast lens" en inglés). Con eso quieren decir que capta mucha luz, lo que permite que estos lentes sean óptimos no solo para una excelente calidad de imagen, sino que para captar movimientos "rápidos" como en eventos deportivos. De ahí el término. EXPOSICIÓN Por lo general en los libros y cursos de fotografías, empiezan con este concepto, pero he decidido dejarlo de último, ya que ahora con todo lo que han visto entenderán más rápidamente a lo que esto se refiere. Exposición no es nada mas que los valores de f-stop que hemos elegido para una foto en particular. Es decir, con qué Velocidad, Apertura e ISO captaremos la imagen. Cuando lean que alguien dice que tiene una "buena exposición" se refiere a que ha elegido los parámetros de f-stop adecuados para que la imagen se vea como uno desea que se vea (que no necesariamente tiene que ser una imagen clara, porque es posible que por motivos estéticos uno decida oscurecer o aclarar una imagen). Noten además que por "buena exposición" también uno se refiere por lo general a una foto en donde todos los posibles valores (desde el mas oscuro hasta el mas claro) de una imagen se representan adecuadamente. Es decir, es posible que si le tomas una foto a la cara de una mujer en medio de una playa que el sol le de tan fuertemente de un lado de la cara que en la foto el lado que recibió la luz del sol aparezca todo totalmente blanco, en vez de diferentes tonalidades de piel. En esto caso se dice que uno obtuvo una "mala exposición". Similarmente en el lado que no le da el sol es posible que la cara muestre la piel de color negro puro en todos lados, en vez de notarse los diferentes matices de la piel. En este ejemplo en particular uno puede compensar (hacer correcciones) subiendo o bajando la velocidad de la cámara, o abriendo o cerrando la apertura, o cambiando el ISO, pero mas comúnmente es este caso específico lo que se hace es que del lado oscuro de la cara uno coloca un reflector para que le de un poco de luz a esa parte oscura, y por otro lado poner una malla que cubra un poco el sol. Estos pequeños trucos son la diferencia entre una foto "casera" y una profesional, y aunque la persona común no capta inmediatamente la diferencia específica entre los dos casos, sí puede decir fácilmente cual fue tomada por un principiante y cual fue tomada por un experto. Un par de términos mas a saber cuando se hable de exposición son "overexposed" y "underexposed" (en español creo que son "sobre-exposición" y "sub-exposición", aunque alguien me corrija en los comentarios si estoy equivocado). Sea como sea que se llamen, lo importante es que estos son dos conceptos fáciles de entender. En el caso del ejemplo que dí en donde el sol hacía que toda la cara de la persona aparentara de un solo color blanco, a eso se le llama sobre-exposición, ya que "nos pasamos de exposición". En el caso de que las sombras aparentan todas con una tonalidad totalmente negra, eso es una "sub-exposición" ya que "no nos dio la exposición". Habiendo dicho todo esto, hay un par de trucos que los "Pro" utilizan que son muy útiles saber, y que tienen que ver con exposición. Por ejemplo, ¿han visto esas imágenes en donde alguien toma una foto de una cascada/catarata, o de un río, y el agua parece angelical como si fuera un "flujo de nube contínua"? Lo primero que viene a la mente es que esa fotografía debió haberse tomado con una larga exposición, ya que de esa manera se capta todo el movimiento del agua durante una exposición al sensor que dure algunos segundos. El problema es que en el momento que llevas tu equipo al río para fotografiar tu obra de arte, y pones la velocidad lenta, te das cuenta que lo que obtienes es una imagen totalmente en blanco, ya que hay demasiada luz en el ambiente, por lo que no puedes utilizar una velocidad lenta para lograr el efecto. En este caso hay dos soluciones. La mas obvia es tomar la fotografía cuando haya poca luz, sea al amanecer o atardecer, lo que te permitirá mantener el lente abierto por mas tiempo. Pero la otra manera de lograr este efecto, inclusive en un día altamente soleado, es comprar un filtro oscuro que se coloca frente al lente. Esto tiene como efecto que la imagen cuando la vez por el visor de la cámara se vea bastante oscura, pero en el momento que tomes una larga exposición la acumulación de luz en el tiempo recreará una vez mas la luz perdida por el filtro, mientras que a la misma vez logras el efecto que buscabas. En cuanto a si quieres hacer lo contrario, es decir, tomar una foto de poca duración, pero de algo que se mueve mucho y quieres congelarlo en el tiempo, la primera opción es aumentar considerablemente el ISO para que captes mas luz, pero la otra opción (y bastante cara) es comprar un "lente rápido" como descrito anteriormente. Por lo general esos lentes tienen la denomicación de "f2", "f1.8" o mejor aun "f1.4". Cuanto menor el número, mas la cantidad de luz que acepta, y mayor el precio del lente. Así que ahí lo tienen, un curso de los conceptos técnicos básicos de la fotografía condensado todo en un solo artículo. Un consejo final que les digo es que tomen sus cámaras y empiecen a tomar fotos, pues con la práctica continua es cuando se aprende mas sobre fotografía... Actualización de Mayo 2011: Dos años y medio después de escribir este artículo, alguien se ingenió una página en donde puedes simular dentro de tu navegador web el efecto de cambiar estos valores en una cámara. Pueden visitar la página en este enlace (requiere Adobe Flash para verse - esperemos que alguien se anime y cree una versión en HTML5 en un futuro) autor: josé elías |

|

|

|

|

|

viernes, enero 2, 2009

|

Si eres amante de la música, es posible que también seas amante del sonido de alta fidelidad. Tristemente sin embargo, son muy pocas las personas que en toda su vida han escuchado alguna vez un sistema de sonido de verdadera alta fidelidad. Si eres amante de la música, es posible que también seas amante del sonido de alta fidelidad. Tristemente sin embargo, son muy pocas las personas que en toda su vida han escuchado alguna vez un sistema de sonido de verdadera alta fidelidad.Cuando hablo de alta fidelidad no hablo de esos equipos de "Home Theater in a box" ("Teatro en casa en una caja"), o de parlantes/bocinas de US$500 dólares el juego. Ni siquiera hablo de equipos del tipo BOSE (del cual tengo el equipo mas avanzado que ellos venden en una de mis TVs), sino que hablo literalmente de "alta fidelidad", como estos parlantes. Muchas personas creen al escuchar un equipo que reproduce sonidos a altos decibelios (volumen alto), o con fuertes sonidos graves (o "bajos") que están escuchando a un equipo de alta fidelidad, cuando en realidad lo que escuchan es el equivalente a un bicicleta en comparación con un Ferrari. Sin embargo, es preciso decir que aunque por lo general un buen equipo de sonido para tu hogar puede costar unos miles largos de dólares (en el rango de entre US$5,000 a US$150,000 dólares), lo cierto es que puedes obtener algo que suene bastante bien por mucho menos de US$2,000 dólares. Algo que notarán es que la vasta mayoría de marcas que venden estos equipos especializados nunca la han oído mencionar en sus vidas, pero por eso no se asusten, ya que hoy les presentaré unos cuantos recursos que les ayudarán a obtener la suficiente información que necesiten como para hacer una elección educada (aunque todos los enlaces son en Inglés). Unas cuantas sugerencias que tengo son las siguientes: 1. Eviten las críticas de usuarios comunes cuando estén de compra por equipos de sonido. En lugares como Amazon, Best Buy y otros leerán excelentes comentarios de equipos que en realidad son mediocres, los que les dará una falsa indicación de la calidad real del equipo que desean comprar. Esto se debe a que el 99% de los equipos de sonido vendidos son equipos de baja fidelidad (y altos decibelios), que al usuario común le suena fenomenal, por la sencilla razón que nunca en sus vidas han escuchado algo que verdaderamente se oiga bien. Por lo que lo recomendado en este caso es leer las críticas de los profesionales, los editores de revistas de sonido, y los fanáticos del sonido de alta fidelidad. 2. De poder, lo ideal es que vayan en persona a una tienda que ofrezca el producto y lo comparen con otros auditivamente. Esto lamentablemente solo es posible en países que tengan una gran selección, o en grandes urbes que tengan representantes de las marcas exóticas que generalmente venden estos productos, pero si es una opción no dejen de tomarla. Si viajas a los EEUU, en toda grande ciudad (como New York, Boston, Los Angeles, San Francisco, etc) hay decenas de tiendas especializadas de sonido de alta fidelidad. 3. Si visitan un lugar en donde puedan probar la música en vivo, lleven su propio CD de música con pistas de alta calidad y de tipo variado. Por ejemplo, lleven algunas operas con voces que contengan notas altas y bajas. Así mismo lleven música del tipo "tecno" que contenga muchos sonidos bajos y "apretados", así como varios tipos de canciones del tipo que a ustedes les gusta escuchar. También es recomendable llevar un par de DVDs que contengan buenas pistas en sonido envolvente (buenos ejemplos son King Kong, The Dark Knight, El Día de la Independencia, etc). 4. Antes de decidir comprar cualquier cosa, asegúrense de tener un presupuesto listo, tomando en cuenta impuestos, costos de envíos, costos en cables, etc. Esto es importante porque hay demasiada variedad, y saber que gastarás entres US$1,500 y US$2,000 te ayudará mucho a acortar la selección. 5. Asegúrate de conectar los parlantes con cables de la mas alta calidad. A diferencia de la imagen digital de una TV, todos los cables de parlantes hoy día son análogos, por lo que mientras mejor conduzcan las señales eléctricas, mejor el sonido resultante. 6. Calcula bien el equipo para el tamaño de donde piensas colocar los parlantes. Si tienes una sala pequeña entonces no es necesario comprar un equipo muy potente, ni un subwoofer (caja de sonidos bajos) de mucha potencia. Toma eso en consideración y menciónalo al experto en sonido que te esté ayudando. 7. Tan importante como los parlantes es el Receiver (Amplificador). Hoy día asegúrate que lo que sea que compres cuando menos tenga entradas ópticas (para tu reproductor de DVD/Blu-ray/PS3), la suficiente potencia para manejar tus parlantes, baja distorsión, y al menos reproducción de sonido Dolby Digital 5.1 y DTS 6.1. 8. Sobre los términos "5.1", "6.1" y "7.1" (hay otros, pero estos son los mas populares), estos simplemente significan que soportan 5, 6 o 7 parlantes simultáneos simultáneamente. El "punto uno" significa que soporta 1 subwoofer. 5.1 significa un parlante frontal, dos al frente en los lados y dos atrás en los lados. 6.1 significa lo mismo que 5.1, pero con un parlante adicional directamente detrás de ti. 7.1 significa lo mismo que 5.1, pero con dos parlantes directamente detrás de ti. En la mayoría de los casos, 5.1 es mas que suficiente, y 6.1 es ideal. 7.1 es solo "algo bueno que tener". 9. Es importante calibrar los parlantes con el amplificador cuando instales todo. Hoy día todo buen amplificador tiene un menú de opciones (muchas veces hasta uno visual que se conecta a tu TV) que te permite especificarle el tamaño de tu habitación, la potencia de tus parlantes, el número de parlantes que tienes, y otros parámetros mas. Muchos amplificadores inclusive vienen con un micrófono que lo colocas en el centro de tu sala y este calibra casi todo automáticamente por ti. 10. Al final del día, lo importante es que estés feliz, y "calidad de sonido" es algo bastante subjetivo y dependiente de cada persona, por lo que no te vuelvas loco comprando un equipo carísimo si tus oídos no disciernen la diferencia entre ese y uno mas barato. Ahora, si notas la diferencia, te recomiendo que esperes, ahorres, y te compres algo que te guste de verdad. Notarás que con el tiempo, poco a poco, querrás hacerle una actualización cada 3 o 4 años a tu equipo, ya que tus oídos se adaptaránn al sonido de alta fidelidad y no querrán volver atrás a equipos de baja fidelidad. Ahora, aquí comparto con ustedes algunos enlaces que son bastante conocidos entre los verdaderos fanáticos del sonido de alta fidelidad. Hay muchos otros enlaces, pero estos son ideales para iniciar. AVS Forum (Audio Video Science Forum), este es el punto de encuentro del 99% de los profesionales, ingenieros y fanáticos del video y sonido de alta fidelidad de todo el mundo. El énfasis es en video, pero el sonido lo tienen bien cubierto. Audio Review, aquí podrás ver algunas de las mejores críticas objetivas de todo tipo de equipos de sonido Audio Asylum, otro portal en forma de foro. Este está dividido en las cosas mas técnicas que te puedas imaginar, desde equipos con los clásicos "tubos", pasando por Vinyl, software, masterización, etc. AudiogoN, esta no es solo una gran comunidad, sino que además un punto de encuentro en donde puedes comprar y vender equipos nuevos y usados. Stereophile, esta es una revista bastante popular entre los fanáticos de la alta fidelidad. Finalmente, noten que muchas veces los propietarios de estos equipos los cuidan bastante bien al ser fanáticos de la música, por lo que puedes ahorrar mucho dinero comprando estos equipos usados, no solo en AudiogoN, sino que además en lugares como eBay. Espero esto le haya sido útil a unos cuantos, y si tienen sus propias sugerencias y enlaces adicionales, no dejen de compartirlos con todos en los comentarios. Nota adicional: De seguro que algunos querrán que les de recomendaciones de parlantes, amplificadores, etc, pero lo cierto es que deseo que exploren los enlaces que les proveo y aprendan por ustedes mismos, ya que verán que se entretendrán mucho leyendo sobre estos equipos. Como diría un monje budista, yo les puede mostrar la puerta, pero al final son ustedes los que deben de atravesarla... :) autor: josé elías |

|

|

|

|

|

domingo, noviembre 2, 2008

|

|